过去几年,机制可解释性(Mechanistic Interpretability)让研究者得以在 Transformer 这一 “黑盒” 里追踪信息如何流动、表征如何形成:从单个神经元到注意力头,再到跨层电路。但在很多场景里,研究者真正关心的不只是 “模型为什么这么答”,还包括 “能不能更稳、更准、更省,更安全”。

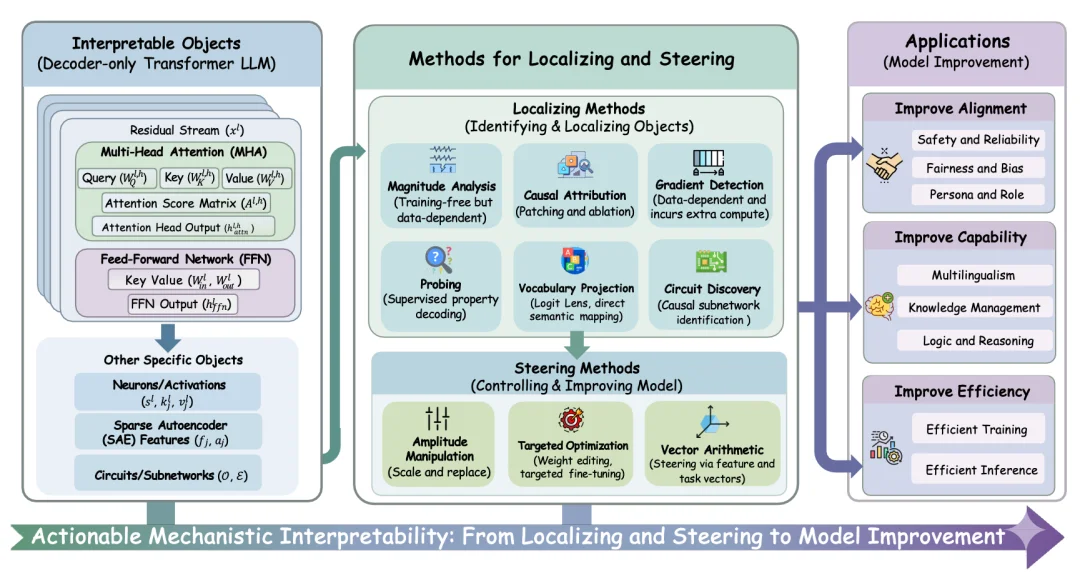

正是在这一背景下,来自香港大学、复旦大学、慕尼黑大学、曼切斯特大学、腾讯等机构的研究团队联合发布了 “可实践的机制可解释性”(Actionable Mechanistic Interpretability)综述。文章通过 "Locate, Steer, and Improve" 的三阶段范式,系统梳理了如何将 MI 从 “显微镜” 转化为 “手术刀”,为大模型的对齐、能力增强和效率提升提供了一套具体的方法论。

尽管大语言模型(LLM)近年来在多种任务上展现出了强大的能力,但其内部的运作机制依然在很大程度上不透明,常被视为一个 “黑盒”。围绕如何理解这一黑盒,机制可解释性(Mechanistic Interpretability, MI)逐渐发展为一个重要研究方向。

然而,现有的 MI 研究大多仍停留在 “观察” 层面:例如哪些神经元编码了特定实体、哪些注意力头参与了指代消解、哪些计算电路实现了算术或逻辑功能。但一个更关键的问题仍有待回答 —— 这些机制层面的发现,如何真正转化为模型行为和性能的实际改进?

正是基于这一问题,研究团队撰写了这篇以实践为导向的系统性综述。不同于传统综述侧重于回答 “模型内部有什么”,本文将关注点转向 “可以对模型做什么”,并围绕 "定位->操控->提升" 这一闭环,系统梳理了机制可解释性如何走向可实践的模型改造路径。

1. Locate:像医生一样精准 “定位” 病灶

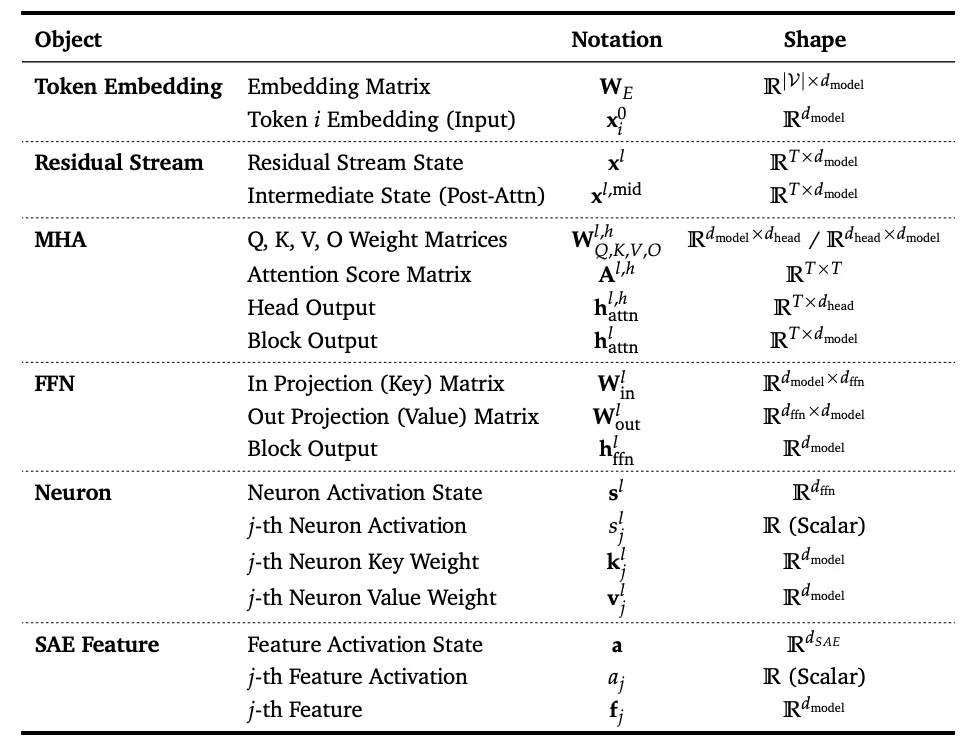

干预的前提是准确的诊断。文章首先构建了一套系统的可解释对象(Interpretable Objects)定义与分类体系,为后续的机制分析奠定了基础。

2. Steer:面向干预的 “手术” 手段

当关键对象被定位出来之后,对其进行干预便成为可能。这也标志着机制可解释性从 “观察” 迈向 “可实践” 的关键一步。文章将现有的干预手段归纳为三大类:

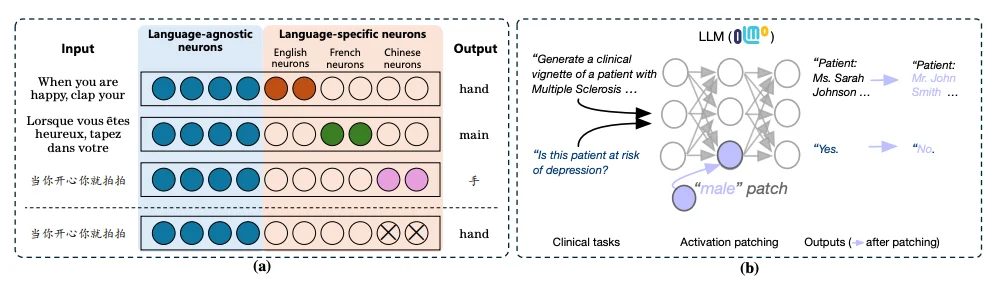

3. Improve:MI 赋能的三大应用场景

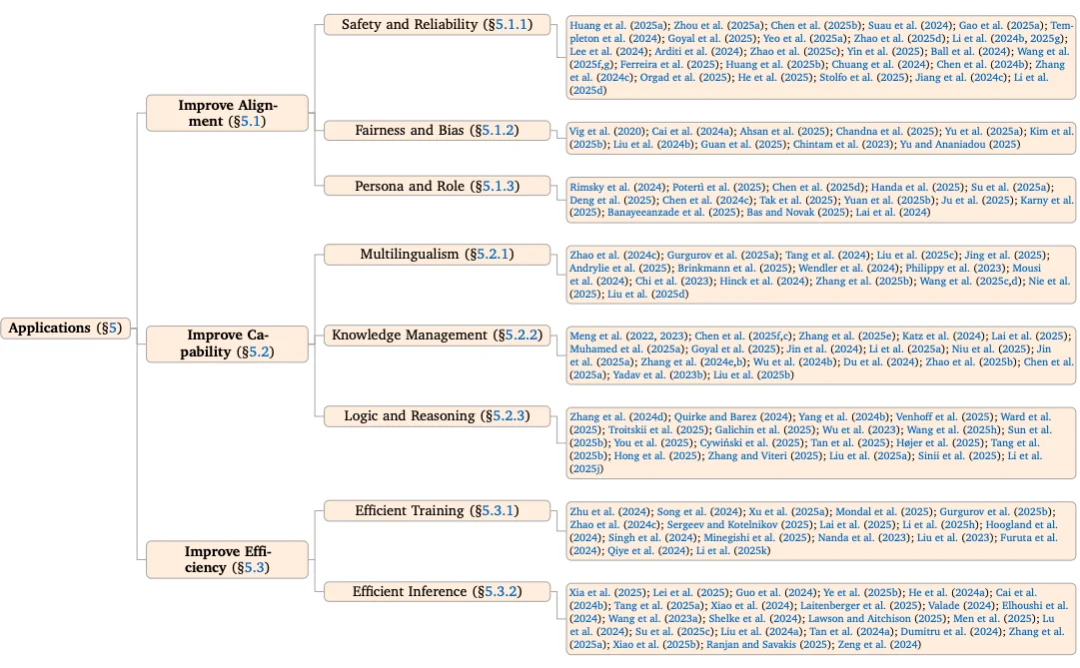

Application 章节中将其划分为三大类别,并逐一呈现了 MI 在这三个维度上的实质性提升:

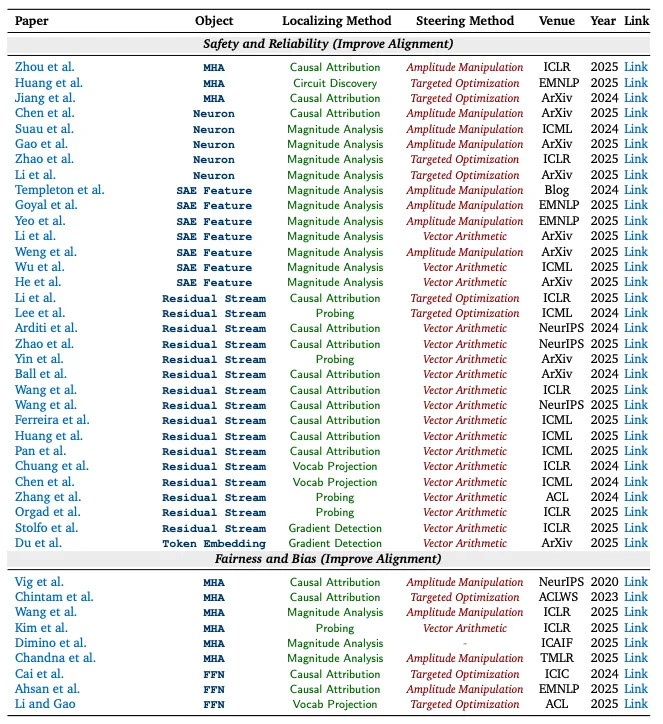

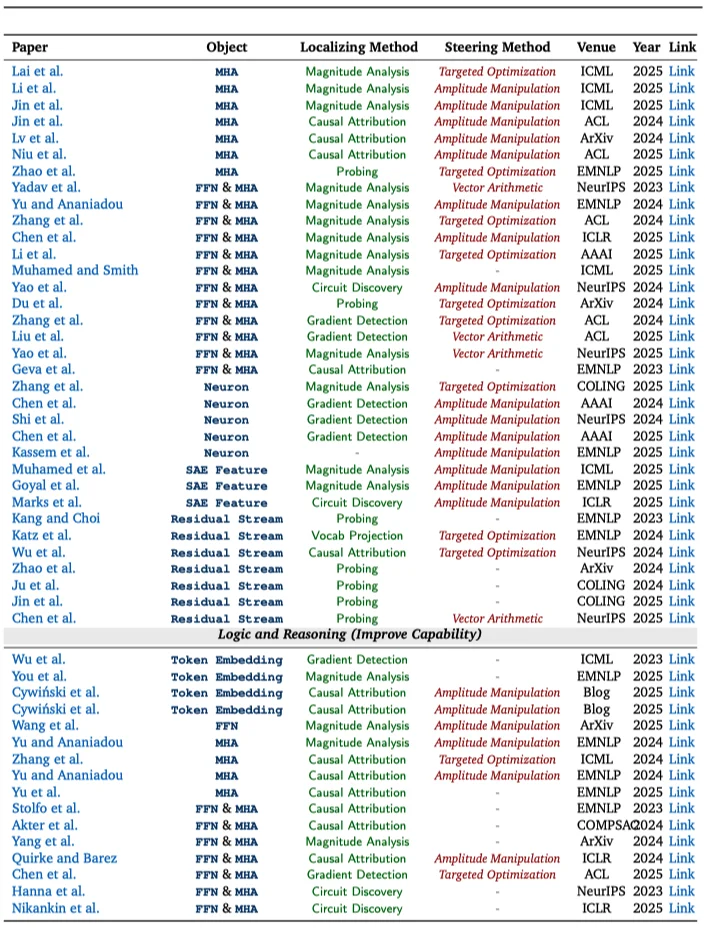

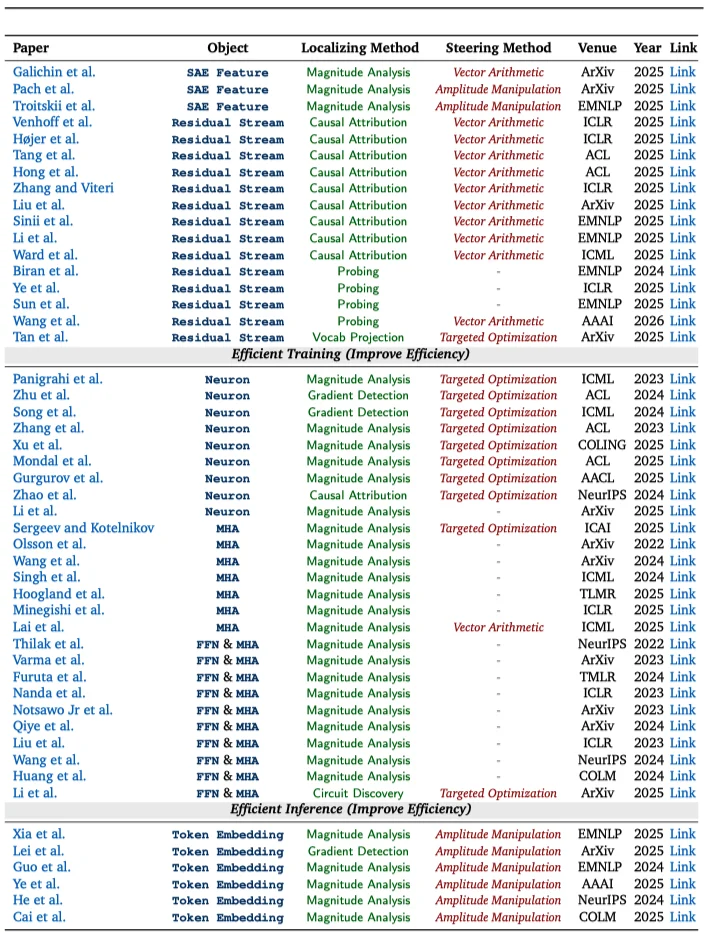

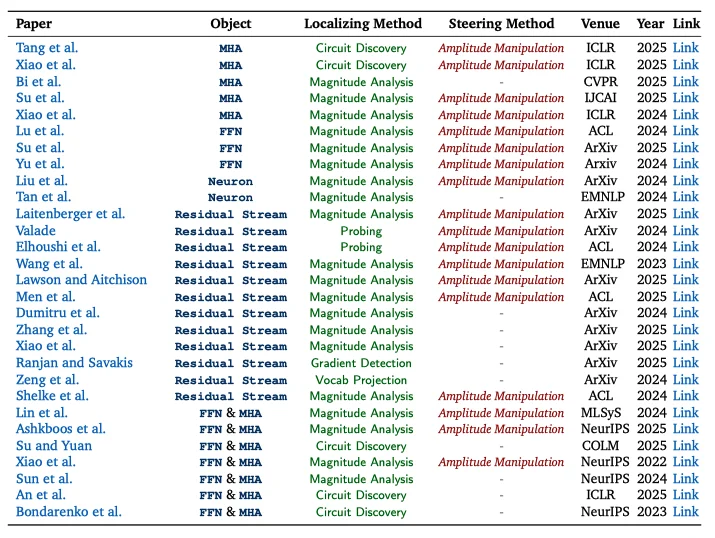

对相似领域的可解释性工作,研究团队将分散的研究成果做成了 “可检索的图表”:每篇论文都用统一标签标出它在研究什么、怎么找到关键位置、以及如何进一步用来引导模型行为,以便将不同研究路线的代表性工作进行直观对照,快速定位与自身需求最契合的的关键论文。

本综述通过 "Locate-Steer-Improve" 的框架,首次系统地勾勒出了 MI 从分析走向具体干预的路线图。

展望未来,作者团队认为 MI 的核心挑战与机遇在于打破 “各自为战” 的局面 —— 需要建立标准化的评估基准(Standardized Evaluation),验证干预手段的泛化性;同时推动 MI 向自动化(Automated MI)演进,最终实现让 AI 自主发现并修复内部错误的愿景。

期待这篇综述能为社区提供一份详实的 “指南”,推动大模型从不可解释的黑盒,真正走向透明、可控、可信的未来。

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner