近年来,视频生成(Video Generation)与世界模型(World Models)已跃升为人工智能领域最炙手可热的焦点。从 Sora 到可灵(Kling),视频生成模型在运动连续性、物体交互与部分物理先验上逐渐表现出更强的「世界一致性」,让人们开始认真讨论:能否把视频生成从「逼真短片」推进到可用于推理、规划与控制的「通用世界模拟器」。

与此同时,这一研究方向正快速与具身智能(Embodied AI)、自动驾驶(Autonomous Driving)等前沿场景深度交织,被视为通往通用人工智能(AGI)的重要路径。

然而,在研究热潮之下,「何为真正的世界模型」以及「如何评判视频模型的世界模拟能力」等核心议题却陷入了多维争论。当前,世界模型的定义与分类层出不穷,理论维度的交叉重叠往往令研究者感到困惑,也限制了技术的标准化发展。

为建立更系统、清晰的审视视角,快手可灵团队与香港科技大学(广州)陈颖聪教授团队(共同一作:博士生王罗州、博士生陈知非)联合发表了从全新视角深度剖析视频世界模型的系统综述。

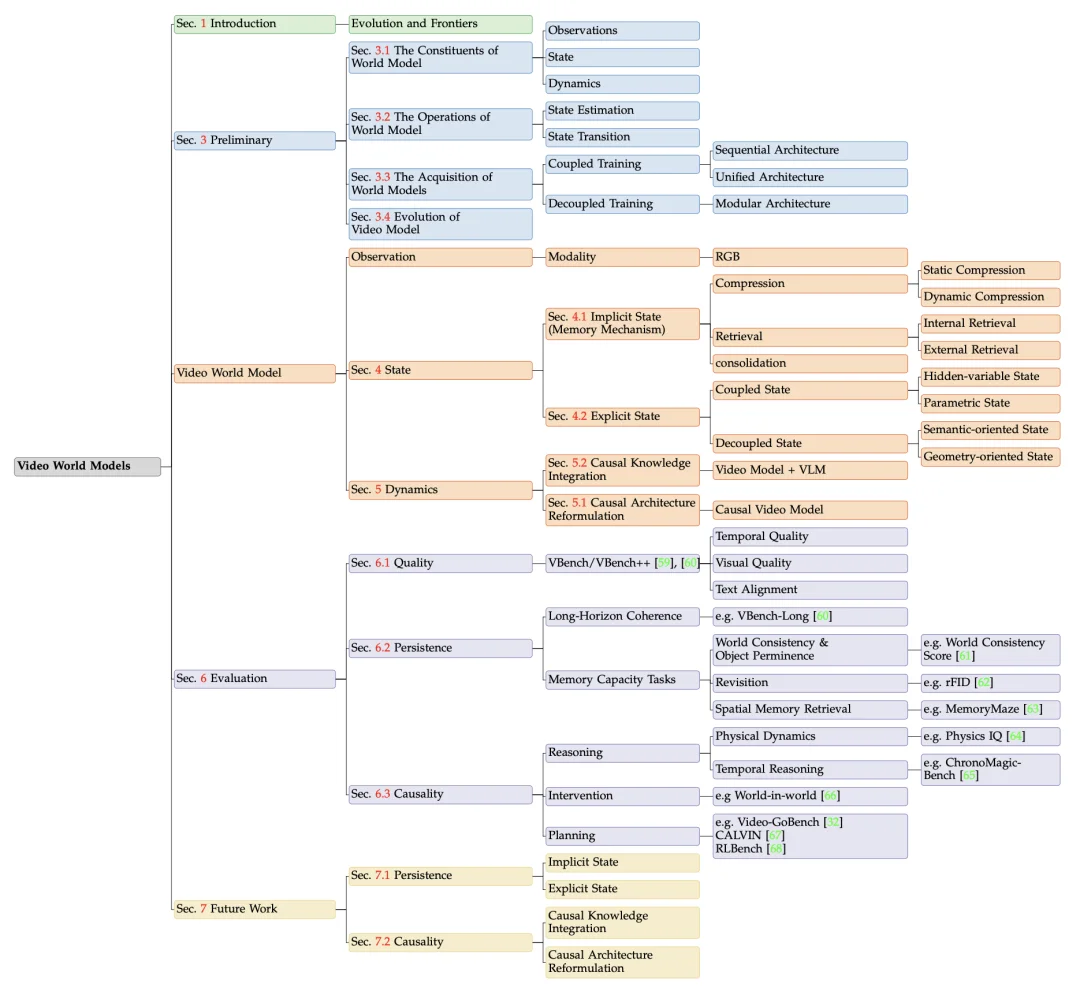

本文旨在弥合当代「无状态」视频架构与经典「以状态为中心」的世界模型理论之间的鸿沟,首次提出以「状态构建(State Construction)」与「动态建模(Dynamics Modeling)」为双支柱的全新分类体系。

此外,本文力倡将评估标准从单纯的「视觉保真度」转向「功能性基准」,并前瞻性地指出了两个关键技术前沿,为视频生成演进至鲁棒的通用世界模拟器提供了清晰的路线图。

论文标题:A Mechanistic View on Video Generation as World Models: State and Dynamics

论文链接:https://arxiv.org/pdf/2601.17067

github 链接:https://github.com/hit-perfect/Awesome-Video-World-Models

相比于过往侧重于视觉效果的视频生成研究,本篇综述在多个维度具有代际优势:

1.全链路视角(Full-Stack Perspective):彻底打破单一的「渲染」视角,涵盖了从底层理论定义、中层架构设计(状态构建与动态建模)到上层功能性评估的全生命周期分析,确保对视频世界模型全方位的理解。

2.弥合理论鸿沟(Bridging the Gap):首次将当代「无状态」(state-less)的视频扩散架构与经典的基于模型强化学习(MBRL)、控制理论进行深度映射,为世界模型找到了坚实的理论根基。

3.前瞻性指南(Forward-Looking Guide):明确了「持久性」与「因果性」 是迈向通用世界模拟器的两大核心关隘。本研究为业界从被动的「像素预测」转向具备闭环交互与因果干预能力的模拟器提供了清晰的路径参考。

4.最新研究覆盖:深度梳理了 2024 至 2025 年间涌现的视频生成的最新工作,反映了当前技术从视觉保真度向物理一致性转化的前沿趋势。

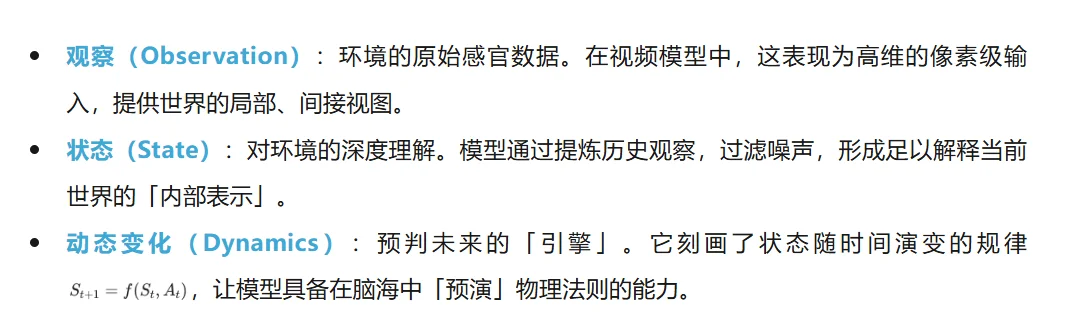

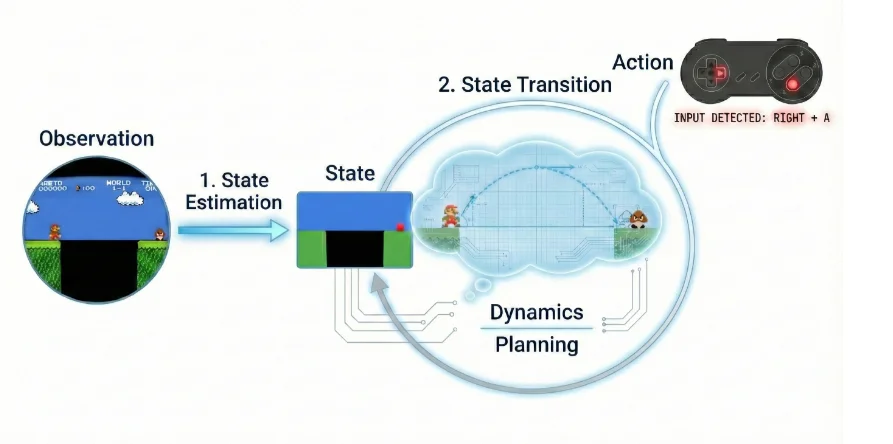

本文首先回归经典,将世界模型的运作提炼为三个耦合的核心组件,构建了从感知到推理的完整链路:

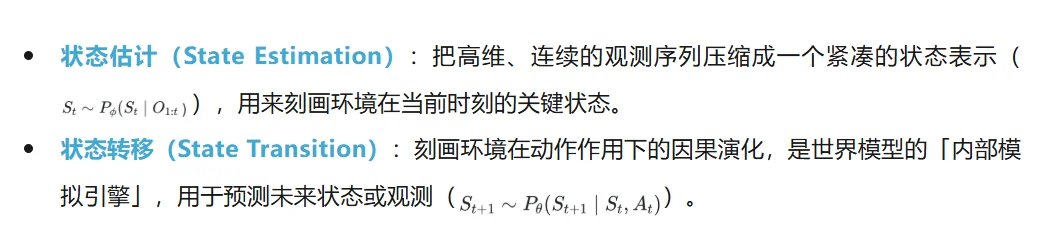

基于前文提出的「三大基石」,本文将世界模型的运行机制归纳为两项核心操作:

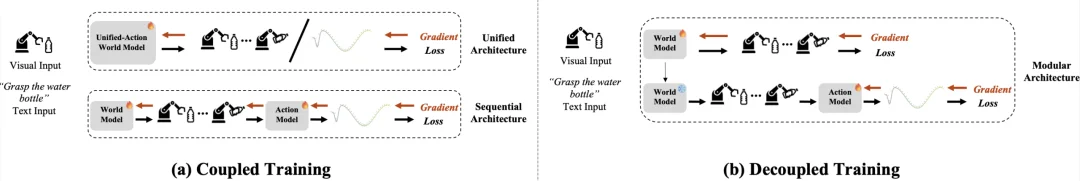

鉴于世界模型主要服务于下游决策,本文将其获取(训练)范式按与策略模型(Policy Model)的耦合程度归纳为两类:

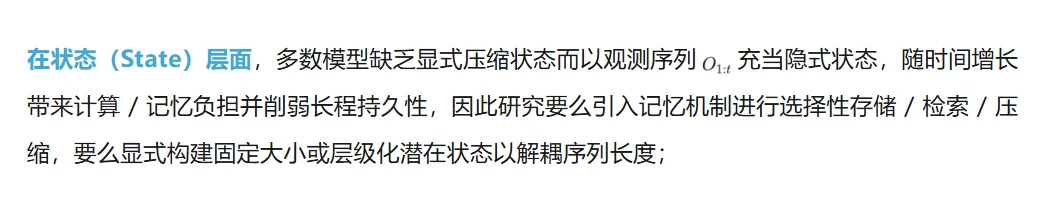

现代视频生成模型虽已具备很强的视觉保真度并被视为潜在的世界模型载体,但与上面分析的经典世界模型相比仍存在两大关键差距:

在动态(Dynamics)层面,标准模型常以双向注意力「一次性渲染」固定时长片段,缺少显式时间因果推进,近期工作则通过因果架构重构(自回归、因果掩码、滚动预测等)或因果知识集成(借助 LMM 做规划约束或统一耦合优化)来注入因果性(causality)。

为了刻画视频生成模型迈向稳健世界模型的演进路径,本文首先从其内部表示入手,重点审视状态(state)的构建:将「状态」视为对环境当前配置的充分统计量,并以此为核心把历史信息有机融入统一表示中。通过将长期背景提炼并沉淀到这种状态表示里,模型才能在更长时程下维持一致的记忆与连贯的模拟。

随后,本文进一步分析视频生成模型中动态(dynamics)行为的来源,强调模型需要内化潜在的因果规律,使得随时间推进的演化既符合物理可行性,也在逻辑层面保持自洽与一致。

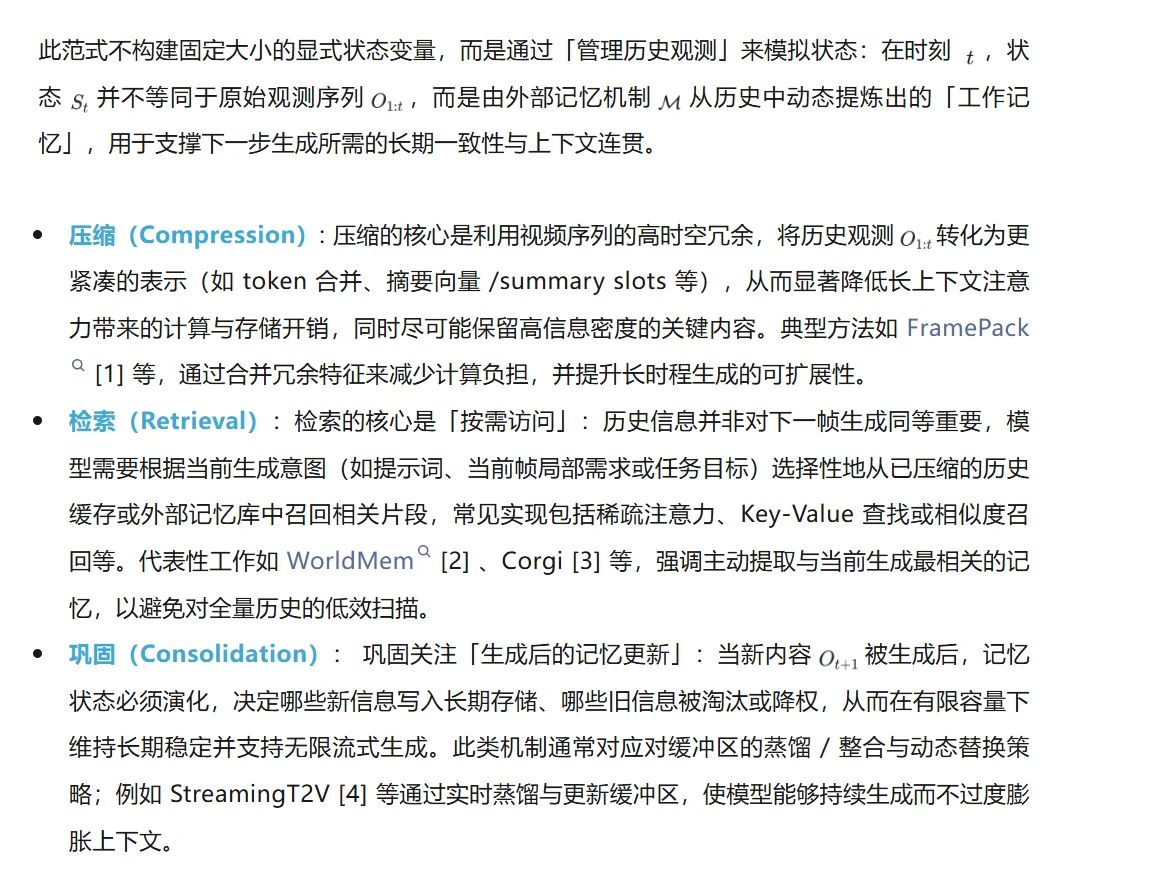

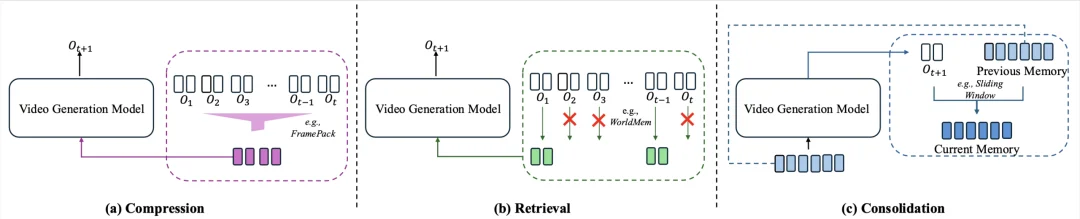

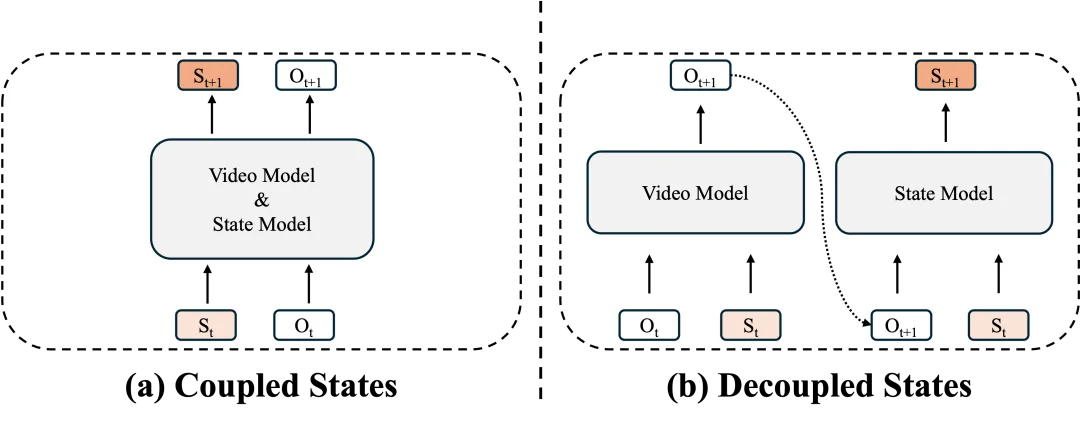

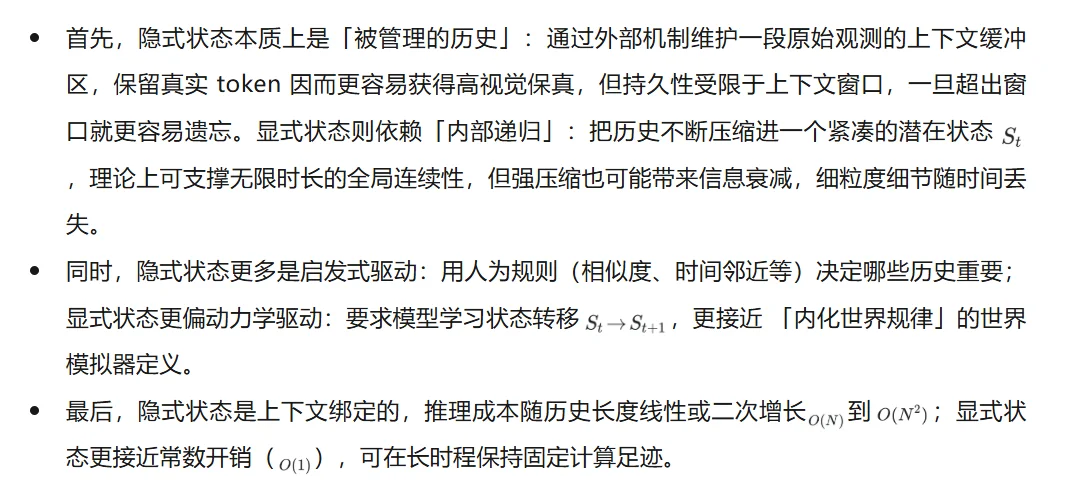

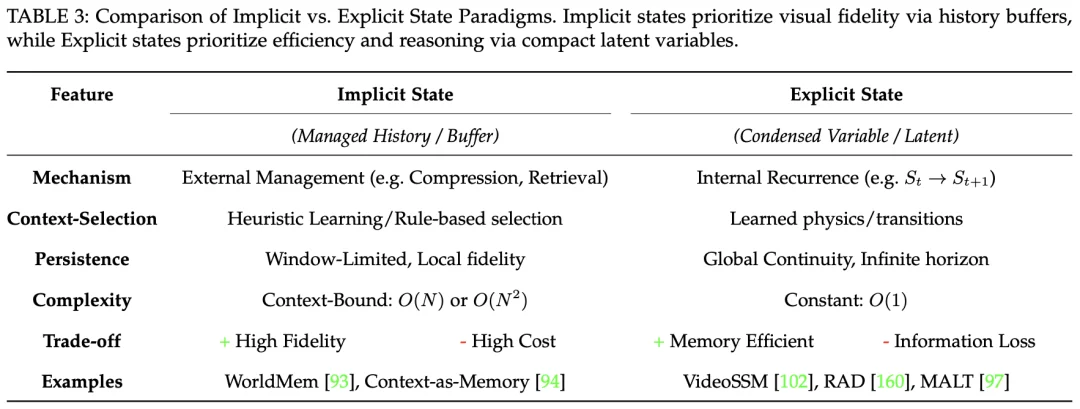

视频模型如何「记住」过去?如何处理历史信息?本文将现有的状态处理机制划分为隐式(Implicit State)与显式(Explicit State)两大范式,并对其优劣进行了深度解构:

这一范式将状态构建内化为模型自身的压缩过程:它不再维护不断增长的历史帧缓冲区,而是把历史上下文持续蒸馏进一个全局更新的潜在变量(State)中,使其成为对视频演化过程的固定维度、可递推的数学摘要。

总体取舍是:隐式状态目前更稳妥地支持高保真视频生成,而显式状态更像通往高效、可长期推理的自主智能体与世界模拟的前沿方向。

'

'

如何让生成的视频不只是「看起来像」,而是真正符合物理规律与时间逻辑?本文归纳了两条增强因果推理能力的主要路径:

如果说视频生成更关心「好不好看」,那么世界模拟还需要更关心「好不好用」。传统的 IS/FVD 等指标主要衡量短片段的视觉真实感,已难以回答模型是否具备可持续推演、可交互、可用于决策的「世界模型」能力。因此,本文主张将评估从 「视觉美感」进一步推进到「功能基准」,并提出三条核心评价轴:

视频生成迈向世界模拟的关键,在于补齐两项核心能力:持久性(persistence)与因果性(causality)。

前者要求模型在长时程生成中保持稳定一致的状态:隐式状态需要从固定窗口等启发式记忆升级为可学习、可动态筛选的信息管理机制;显式状态则要在压缩效率与细节保真之间找到更好的平衡。

后者要求模型从统计相关走向因果机制:一条路线是通过架构与数据设计提升因果推断能力(更好地解耦潜在因果因素),另一条路线是引入理解模型的推理先验来约束生成,但如何有效对齐生成与理解仍是核心挑战。

综上所述,随着视频生成技术在各领域的爆发式增长,如何使其具备真实世界的模拟能力已成为不可回避的挑战。通过全链路的技术剖析,本综述不仅弥合了视频架构与经典理论之间的裂痕,还揭示了从「隐 / 显式状态构建」到「因果动态建模」的关键路径。

这篇综述为学术界和工业界提供了一个重要的参考框架,帮助研究者在通往通用世界模拟器的征途中精准定位。

团队相信,通过应对综述中列出的挑战,该领域可以从生成视觉上逼真的视频发展到构建稳健的通用世界模拟器,为自动驾驶、具身智能等领域的长足发展奠定坚实基石。

参考文献

[1] L. Zhang and M. Agrawala. Packing input frame context in next-frame prediction models for video generation. arXiv preprint arXiv:2504.12626, 2025.

[2] Z. Xiao et al. Worldmem: Long-term consistent world simulation with memory. arXiv preprint arXiv:2504.12369, 2025.

[3] X. Wu et al. Corgi: Cached memory guided video generation. arXiv preprint arXiv:2508.16078, 2025.

[4] R. Henschel et al. Streamingt2v: Consistent, dynamic, and extendable long video generation from text. In Proceedings of the Computer Vision and Pattern Recognition Conference, pp. 2568–2577, 2025.

[5] K. Dalal et al. One-minute video generation with test-time training. In Proceedings of the Computer Vision and Pattern Recognition Conference, pp. 17702–17711, 2025.

[6] J. Chen et al. Sana-video: Efficient video generation with block linear diffusion transformer. arXiv preprint arXiv:2509.24695, 2025.

[7] X. Huang et al. Self forcing: Bridging the train-test gap in autoregressive video diffusion. arXiv preprint arXiv:2506.08009, 2025.

[8] Y. Huang et al. Owl-1: Omni world model for consistent long video generation. arXiv preprint arXiv:2412.09600, 2024.

[9] Z. Huang et al. Vbench: Comprehensive benchmark suite for video generative models, 2023.

[10] Z. Huang et al. Vbench++: Comprehensive and versatile benchmark suite for video generative models, 2024.

[11] A. Rakheja et al. World consistency score: A unified metric for video generation quality, 2025.

[12] M. Heusel et al. Gans trained by a two time-scale update rule converge to a local nash equilibrium, 2018.

[13] S. Yuan et al. Chronomagic-bench: A benchmark for metamor-phic evaluation of text-to-time-lapse video generation, 2024.

[14] S. Motamed et al. Do generative video models understand physical principles?, 2025.

[15] J. Zhang et al. World-in-world: World models in a closed-loop world, 2025.

文章来自于微信公众号 “机器之心”,作者: “机器之心”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md