单向VLM变双向!人大斯坦福等提出MoCa框架:双向多模态编码器

单向VLM变双向!人大斯坦福等提出MoCa框架:双向多模态编码器MoCa框架把单向视觉语言模型转化为双向多模态嵌入模型,通过持续预训练和异构对比微调,提升模型性能和泛化能力,在多模态基准测试中表现优异,尤其小规模模型性能突出。

MoCa框架把单向视觉语言模型转化为双向多模态嵌入模型,通过持续预训练和异构对比微调,提升模型性能和泛化能力,在多模态基准测试中表现优异,尤其小规模模型性能突出。

「Tokenization(分词)是 Transformer 模型为弥补自身缺陷不得不戴上的枷锁。」

LLM用得越久,速度越快!Emory大学提出SpeedupLLM框架,利用动态计算资源分配和记忆机制,使LLM在处理相似任务时推理成本降低56%,准确率提升,为AI模型发展提供新思路。

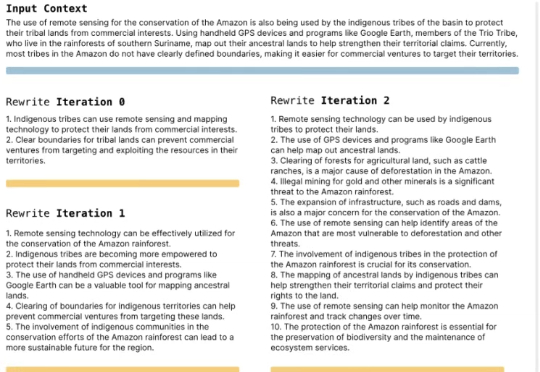

自适应语言模型框架SEAL,让大模型通过生成自己的微调数据和更新指令来适应新任务。SEAL在少样本学习和知识整合任务上表现优异,显著提升了模型的适应性和性能,为大模型的自主学习和优化提供了新的思路。

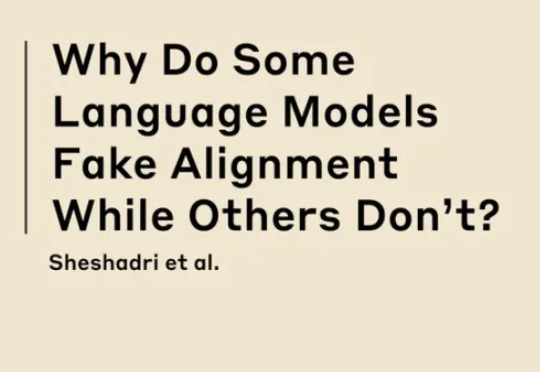

大模型“当面一套背后一套”的背后原因,正在进一步被解开。 Claude团队最新研究结果显示:对齐伪装并非通病,只是有些模型的“顺从性”会更高。

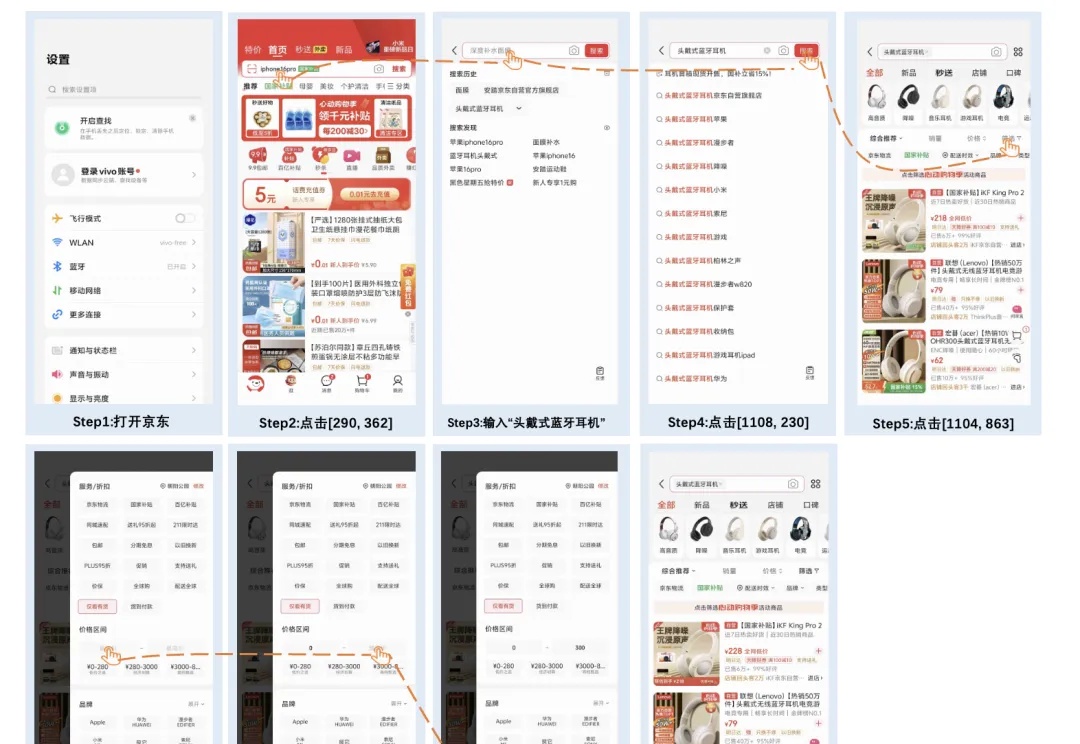

vivo AI Lab发布AI多模态新模型了,专门面向端侧设计,紧凑高效~

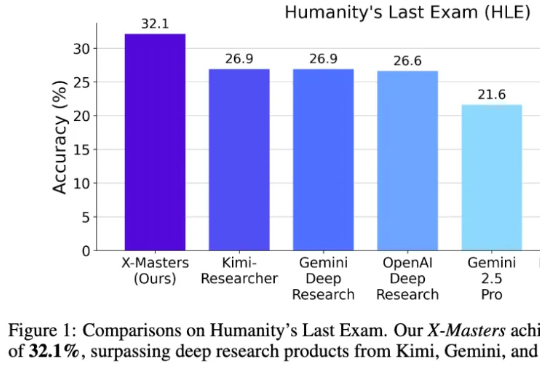

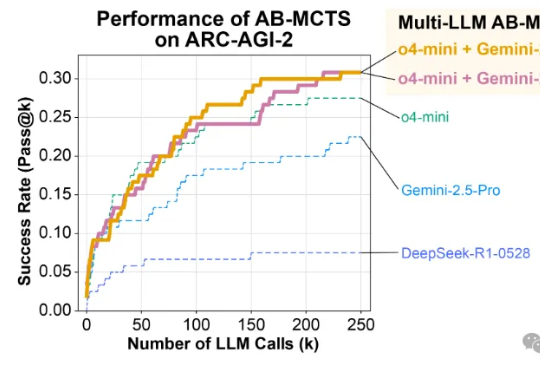

“人类最后的考试”首次突破30分,还是咱国内团队干的! 该测试集是出了名的超难,刚推出时无模型得分能超过10分。

编者按:vibe coding不是编程的终点,而是Context Engineering驱动的协作智能的起点。那些能够最早理解并应用这种整合视角的人,将在下一轮技术变革中获得决定性优势。

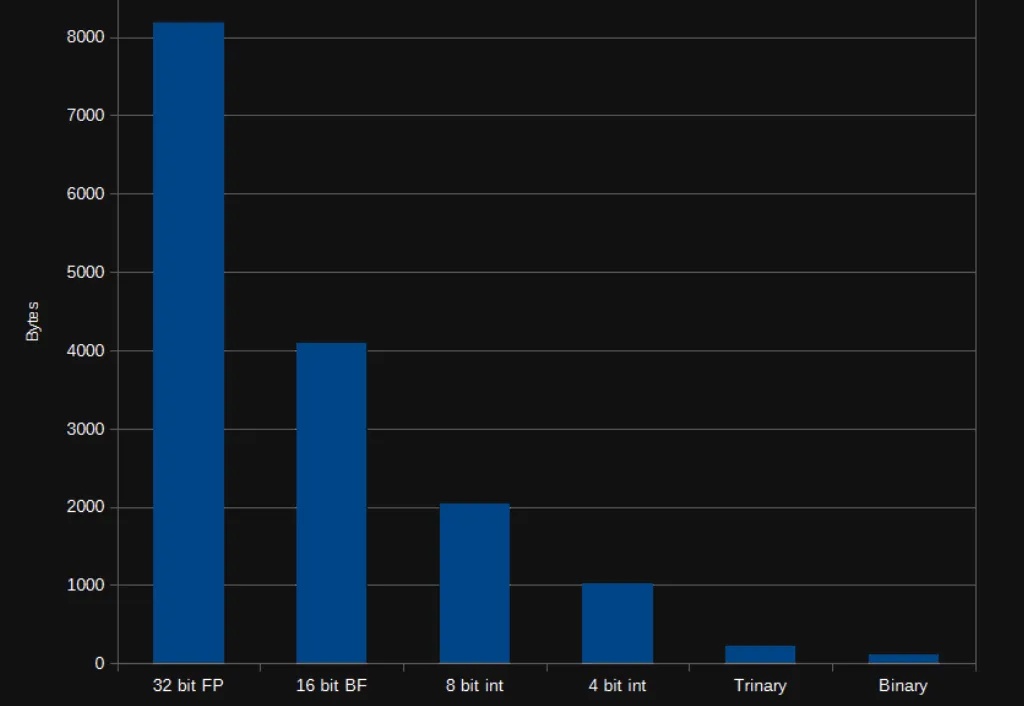

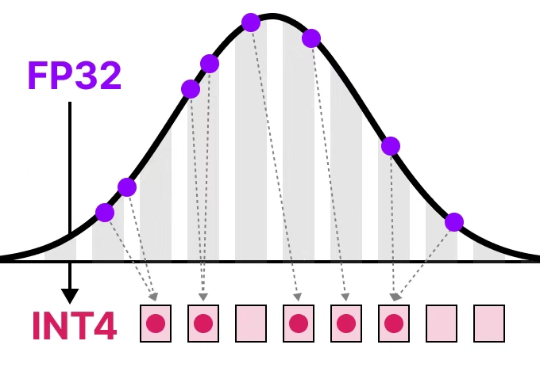

在 AI 领域,我们对模型的期待总是既要、又要、还要:模型要强,速度要快,成本还要低。但实际应用时,高质量的向量表征往往意味着庞大的数据体积,既拖慢检索速度,也推高存储和内存消耗。

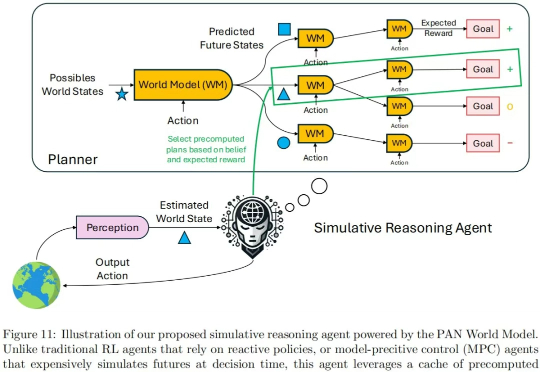

现在的世界模型,值得批判。 我们知道,大语言模型(LLM)是通过预测对话的下一个单词的形式产生输出的。由此产生的对话、推理甚至创作能力已经接近人类智力水平。

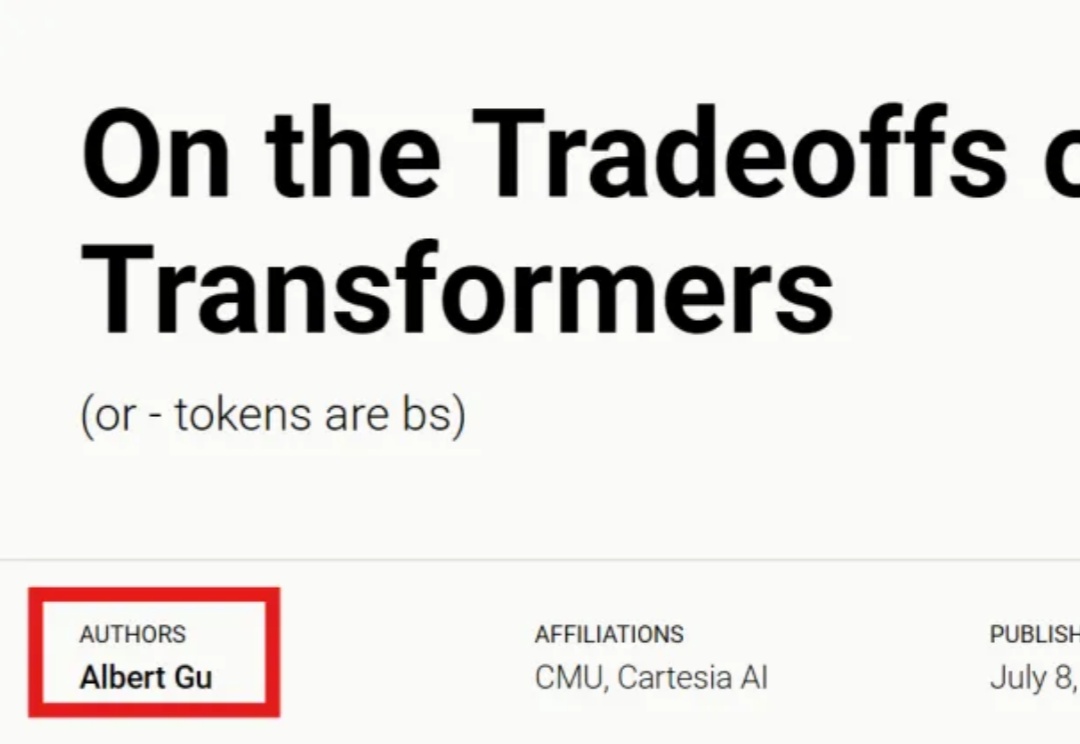

Mamba一作最新大发长文! 主题只有一个,即探讨两种主流序列模型——状态空间模型(SSMs)和Transformer模型的权衡之术。

来自加州大学河滨分校(UC Riverside)、密歇根大学(University of Michigan)、威斯康星大学麦迪逊分校(University of Wisconsin–Madison)、德州农工大学(Texas A&M University)的团队在 ICCV 2025 发表首个面向自动驾驶语义占用栅格构造或预测任务的统一基准框架 UniOcc。

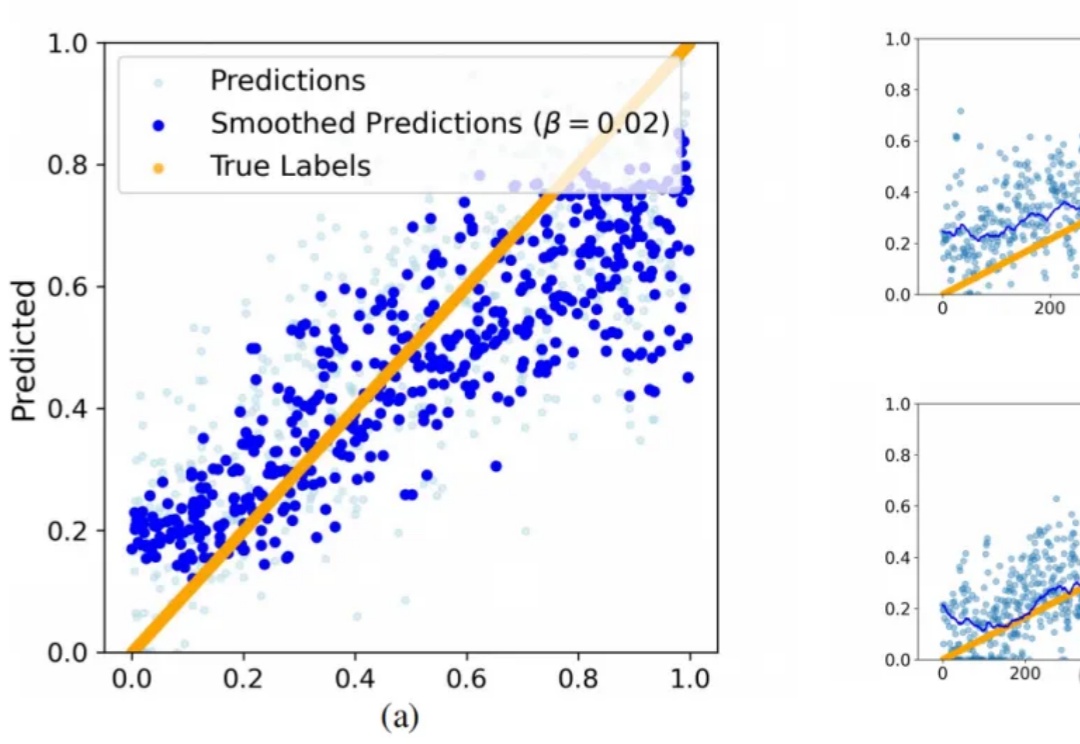

论文提出一种AI自我反思方法:通过反思错误原因、重试任务、奖励成功反思来优化训练。

ChatGPT的对话流畅性、Gemini的多模态能力、DeepSeek的长上下文分析……

NCAL是一种新的个性化学习方法,它通过优化文本嵌入的分布来解决教育数据中常见的长尾分布问题,从而提高模型对少数类别的处理能力。

学好数理化,走遍天下都不怕! 这一点这在大语言模型身上也不例外。

2025年,全球具身智能赛道爆火,VLA模型成为了绝对的C位。从美国RT-2的开创性突破,到中国最新FiS-VLA「快慢双系统」,VLA正以光速硬核进化。

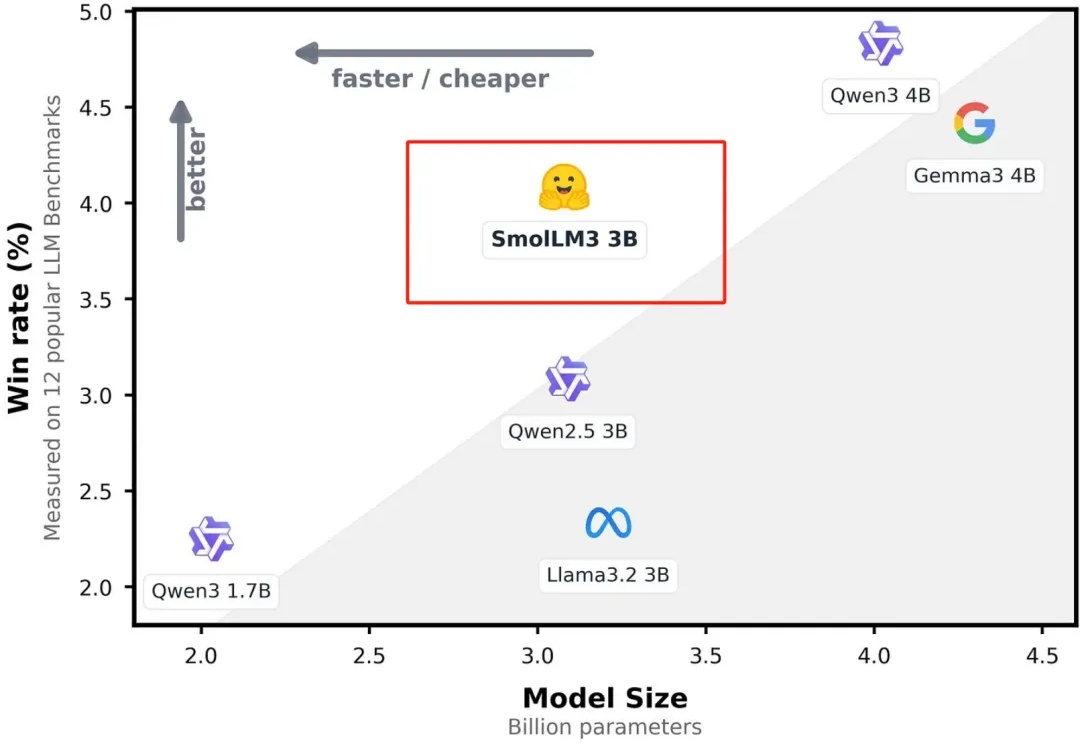

今天凌晨,全球著名大模型开放平台Hugging Face开源了,顶级小参数模型SmolLM3。

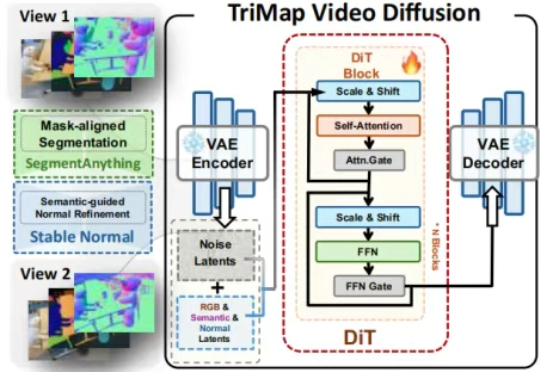

最少只用2张图,AI就能像人类一样理解3D空间了。ICCV 2025最新中稿的LangScene-X:以全新的生成式框架,仅用稀疏视图(最少只用2张图像)就能构建可泛化的3D语言嵌入场景,对比传统方法如NeRF,通常需要20个视角。

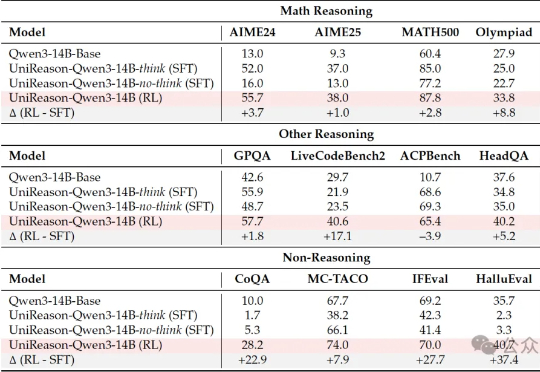

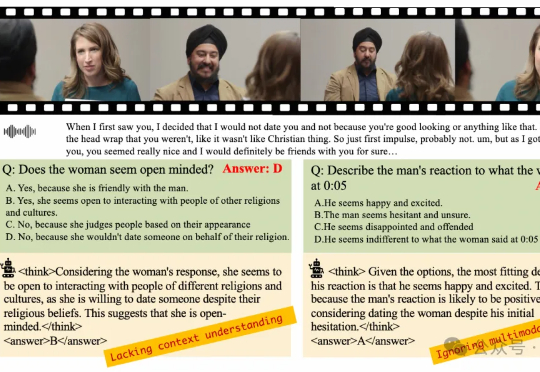

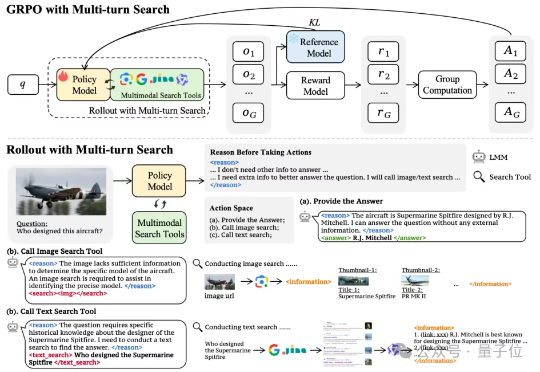

在多模态大语言模型(MLLMs)应用日益多元化的今天,对模型深度理解和分析人类意图的需求愈发迫切。尽管强化学习(RL)在增强大语言模型(LLMs)的推理能力方面已展现出巨大潜力,但将其有效应用于复杂的多模态数据和格式仍面临诸多挑战。

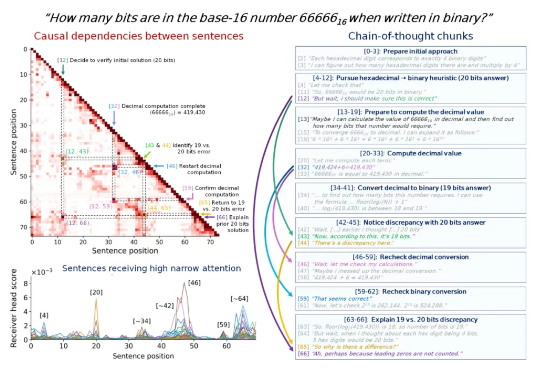

思维链里的步骤很重要,但有些步骤比其他步骤更重要,尤其是在一些比较长的思维链中。 找出这些步骤,我们就可以更深入地理解 LLM 的内部推理机制,从而提高模型的可解释性、可调试性和安全性。

AI无需监督就能学习思考?

DeepSeek推理要详细还是要迅速,现在可以自己选了?

多模态模型学会“按需搜索”!字节&NTU最新研究,优化多模态模型搜索策略——通过搭建网络搜索工具、构建多模态搜索数据集以及涉及简单有效的奖励机制,首次尝试基于端到端强化学习的多模态模型自主搜索训练。

在信息爆炸的时代,传统关键词搜索已难以满足复杂知识需求。最新研究提出Agentic Deep Research

AI现在真能救命!传统的心脏MRI(磁共振成像)检查可能遗漏的关键风险信号,现在能够被AI捕捉了。

清华大学朱军教授团队提出SageAttention3,利用FP4量化实现推理加速,比FlashAttention快5倍,同时探索了8比特注意力用于训练任务的可行性,在微调中实现了无损性能。

当LangChain在6月23日发布那篇著名的Context Engineering博客时,IBM Research的研究者们早在10天前就已经用严格的学术实验证明了这套方法的有效性。

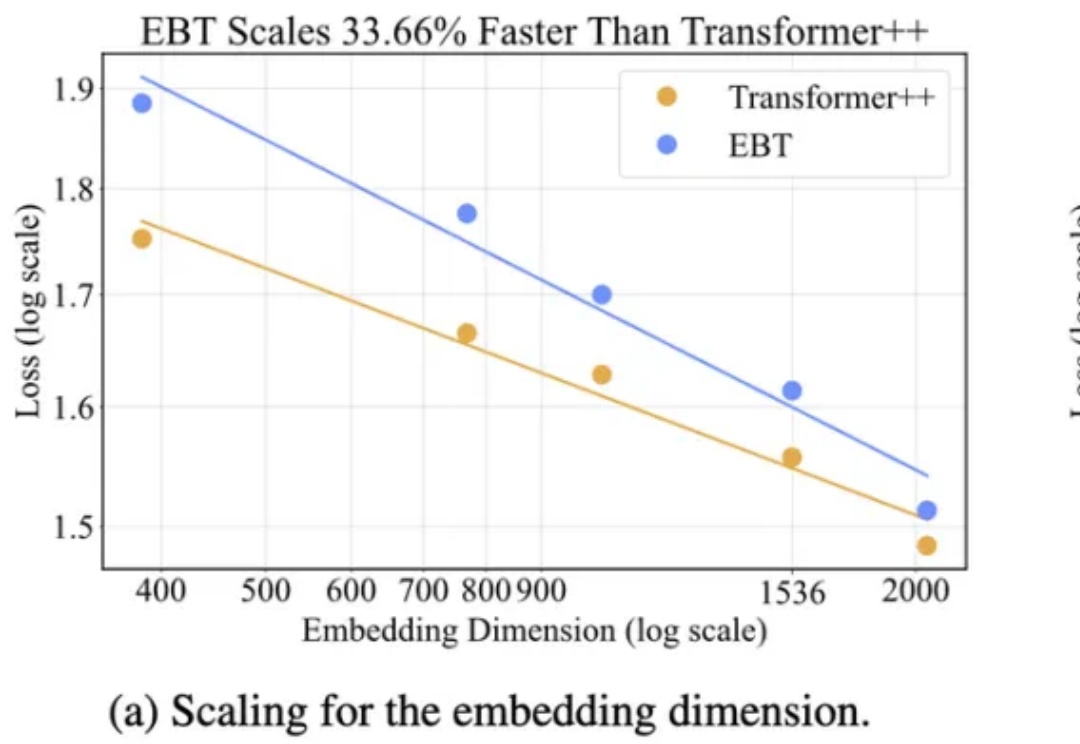

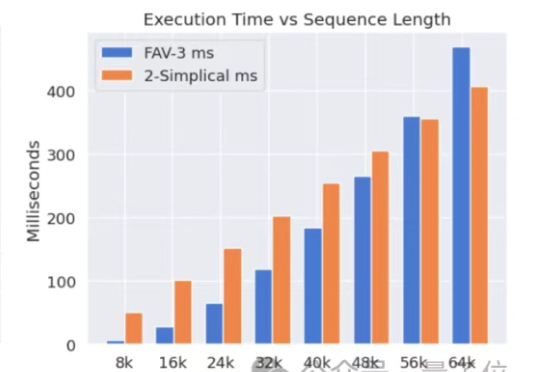

Meta挖走OpenAI大批员工后,又用OpenAI的技术搞出新突破。新架构名为2-Simplicial Transformer,重点是通过修改标准注意力,让Transformer能更高效地利用训练数据,以突破当前大模型发展的数据瓶颈。

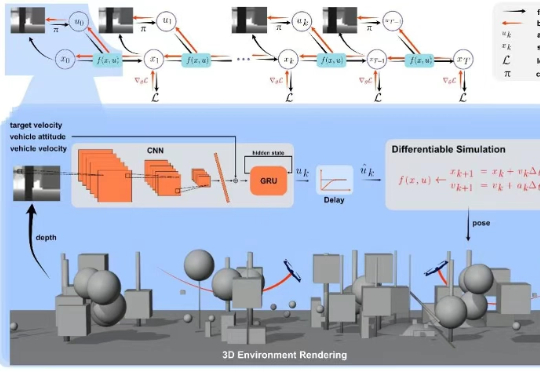

上海交通大学研究团队提出了一种融合无人机物理建模与深度学习的端到端方法,该研究首次将可微分物理训练的策略成功部署到现实机器人中,实现了无人机集群自主导航,并在鲁棒性、机动性上大幅领先现有的方案。