200美金,人人可手搓QwQ,清华、蚂蚁开源极速RL框架AReaL-boba

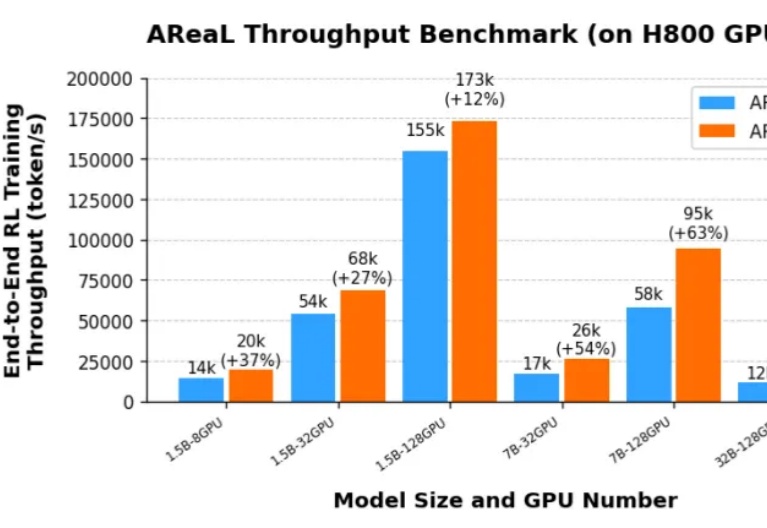

200美金,人人可手搓QwQ,清华、蚂蚁开源极速RL框架AReaL-boba由于 DeepSeek R1 和 OpenAI o1 等推理模型(LRM,Large Reasoning Model)带来了新的 post-training scaling law,强化学习(RL,Reinforcement Learning)成为了大语言模型能力提升的新引擎。然而,针对大语言模型的大规模强化学习训练门槛一直很高:

由于 DeepSeek R1 和 OpenAI o1 等推理模型(LRM,Large Reasoning Model)带来了新的 post-training scaling law,强化学习(RL,Reinforcement Learning)成为了大语言模型能力提升的新引擎。然而,针对大语言模型的大规模强化学习训练门槛一直很高:

你是否曾对着一个繁复的AI框架,无奈地想:"真有必要搞得这么复杂吗?"在与臃肿框架斗争一年后,Zachary Huang博士决定大刀阔斧地革新,剔除所有花里胡哨的部分。于是Pocket Flow诞生了——一个仅有100行代码的超轻量级大语言模型框架!

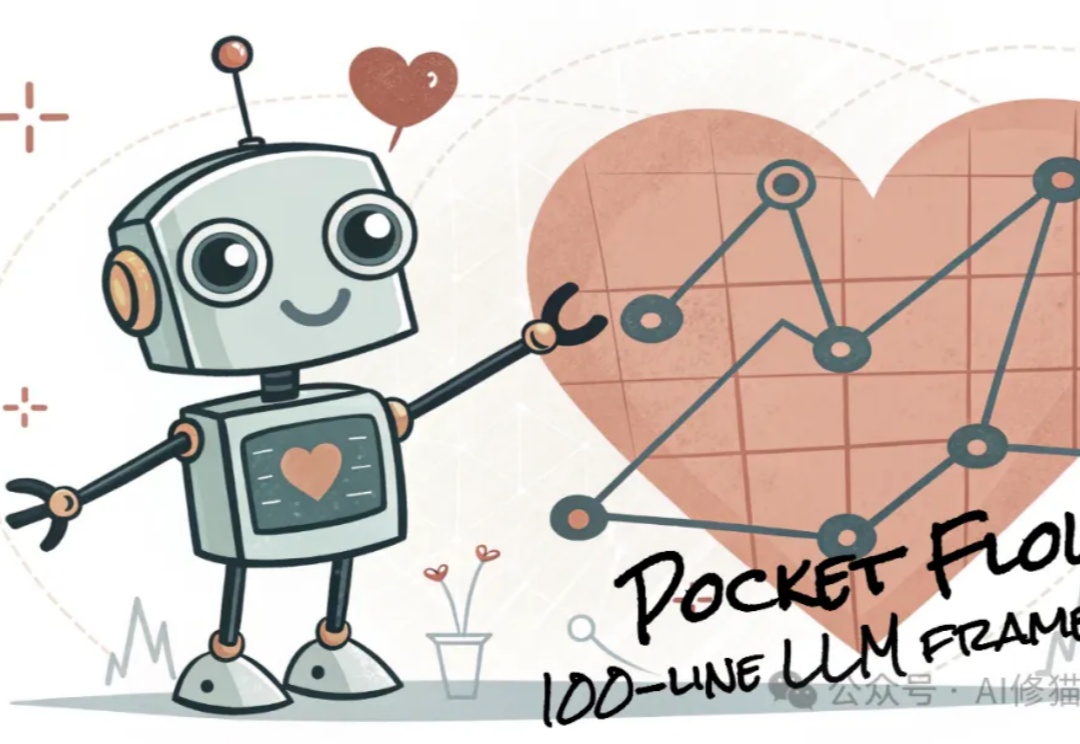

当你翻开相册,看到一张平淡无奇的风景照,是否希望它能更温暖、更浪漫,甚至更忧郁?现在,EmoEdit 让这一切成为可能 —— 只需输入一个简单的情感词,EmoEdit 便能巧妙调整画面,使观众感知你想传递的情感。

你是否注意过人类观察世界的独特方式?

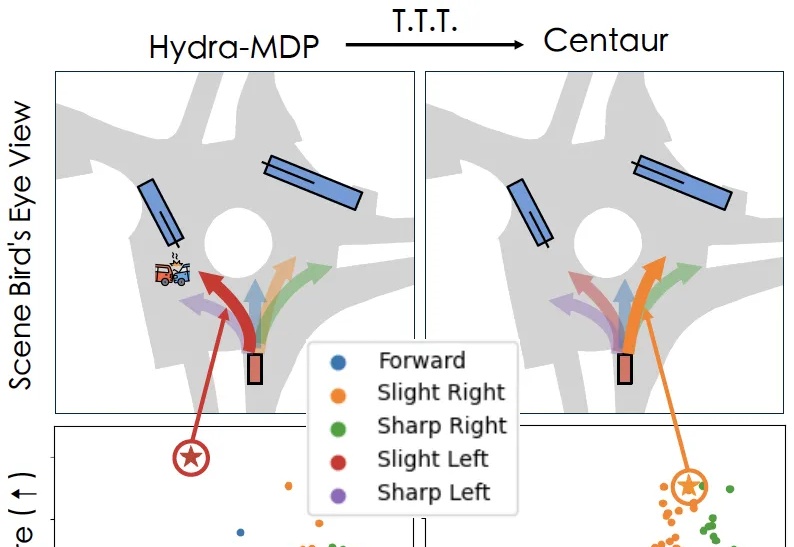

当开车遇到变道、加塞等场景时,驾驶员往往会下意识地激活自己的“安全驾驶思维”,从而做出激进的规避行为。

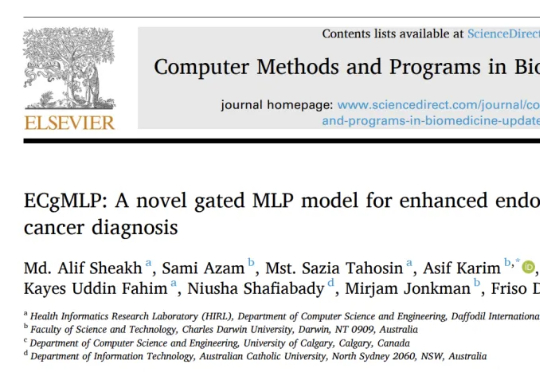

医学变革风暴来袭!ECgMPL模型如同医学领域的超级侦探,从细胞和组织微观图像里精准揪出癌症踪迹,诊断子宫内膜癌准确率近100%,远超医生平均水平。

最近,AI 公司 Databricks 推出了一种新的调优方法 TAO,只需要输入数据,无需标注数据即可完成。更令人惊喜的是,TAO 在性能上甚至超过了基于标注数据的监督微调。

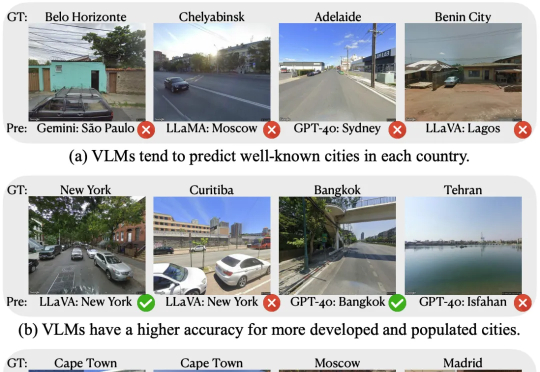

给AI一张全新的照片,它能以相当高的准确率还猜出照片在哪个城市拍摄的。在新研究中,表现最好的AI模型,猜出图片所在城市的正确率比人类高62.6%!以后网上晒图可要当心了,AI可能知道你在哪里!

疯哥收到最多的问题就是关于n8n与coze(扣子)、Dify有何不同,n8n和他们相比有什么优势?疯哥是资深n8n玩家,深知n8n能带给个人和企业多么强大的能力。但是,非常多的国内朋友从来都没听说过n8n,更不用提使用n8n为自己和企业搭建强大的AI自动化工作流。

论文第一作者为余鑫,香港大学三年级博士生,通讯作者为香港大学齐晓娟教授。主要研究方向为生成模型及其在图像和 3D 中的应用,发表计算机视觉和图形学顶级会议期刊论文数十篇,论文数次获得 Oral, Spotlight 和 Best Paper Honorable Mention 等荣誉。此项研究工作为作者于 Adobe Research 的实习期间完成。

3D生成版DeepSeek再上新高度!

这三篇论文,出自同一AI之手。

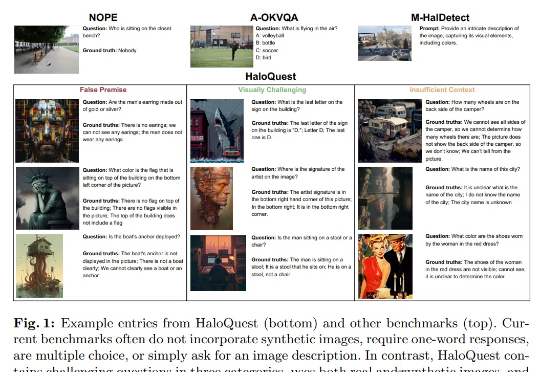

幻觉(Hallucination),即生成事实错误或不一致的信息,已成为视觉-语言模型 (VLMs)可靠性面临的核心挑战。随着VLMs在自动驾驶、医疗诊断等关键领域的广泛应用,幻觉问题因其潜在的重大后果而备受关注。

继昨天《RAG太折磨人啦,试下pip install rankify,检索、重排序、RAG三合一,完美》发布之后,有许多朋友向我询问Rankify的具体使用方法和部署细节,尤其是生产环境如何处理自定义数据集和本地数据集。

从单张图像生成灵活视角3D场景的技术来了,在考古保护、自主导航等直接获取3D数据成本高昂或不可行的领域具有重要应用价值。

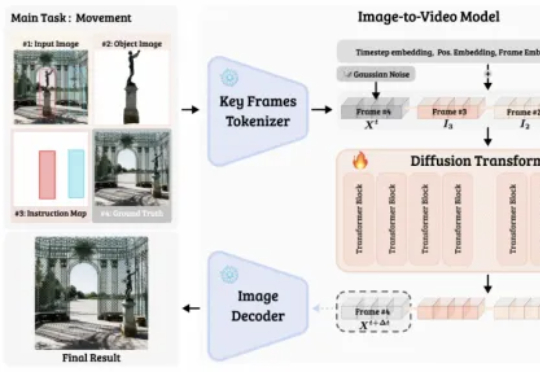

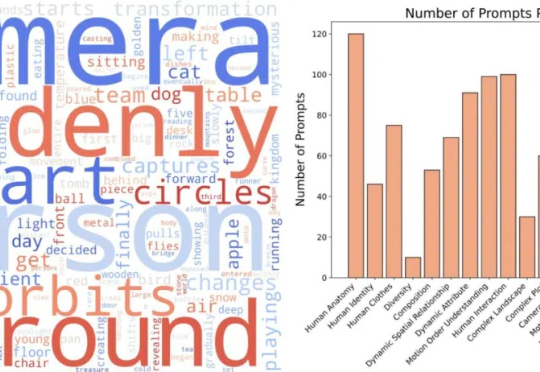

近一年以来,AI 视频生成技术发展迅猛。自 2024 年初 Sora 问世后,大家惊喜地发现:原来 AI 可以生成如此逼真的视频,一时间各大高校实验室、互联网巨头 AI Lab 以及创业公司纷纷入局视频生成领域。

AGI的这两年,基本OpenAI压着谷歌打的两年,包括但不限于谷歌自己的失误、每次发布会的被截胡。比如这次Gemini 2.5 Pro 被 4o图片生成功能抢走了几乎所有关注点。但谷歌确实也在一直追赶,从最开始的措手不及,到现在已经开始有来有往。著名科技杂志《连线》采访了谷歌前和现员工超50人,发布了一篇长文,深度挖掘了谷歌这两年苦苦追赶Openai的内幕故事,

三维高斯泼溅(3D Gaussian Splatting, 3DGS)技术基于高斯分布的概率模型叠加来表征场景,但其重建结果在几何和纹理边界处往往存在模糊问题。

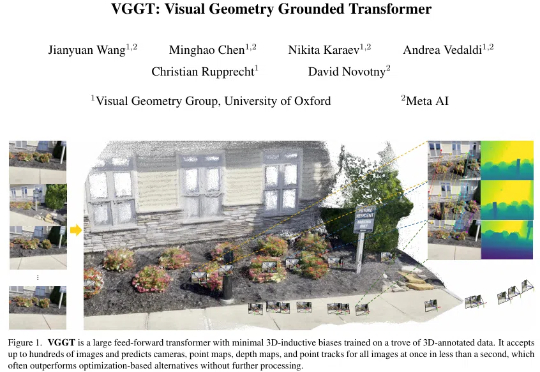

「仅需一次前向推理,即可预测相机参数、深度图、点云与 3D 轨迹 ——VGGT 如何重新定义 3D 视觉?」

AI社区掀起用大模型玩游戏之风!例如国外知名博主让DeepSeek和Chatgpt下国际象棋的视频在Youtube上就获得百万播放,ARC Prize组织最近也发布了一个贪吃蛇LLM评测基准SnakeBench。

3 月 28 日,专注于构建通用 3D 大模型的 VAST 一口气开源了两个 3D 生成项目 ——TripoSG 和 TripoSF。前者是一款基础 3D 生成模型,在图像到 3D 生成任务上远超所有闭源模型;后者则是 VAST 新一代三维基础模型 TripoSF 能在所有闭源模型中同样取得 SOTA 的基础组件,用于高分辨率的三维重建和生成任务。

机器狗不语,只是一味地在北大未名湖畔捡垃圾。

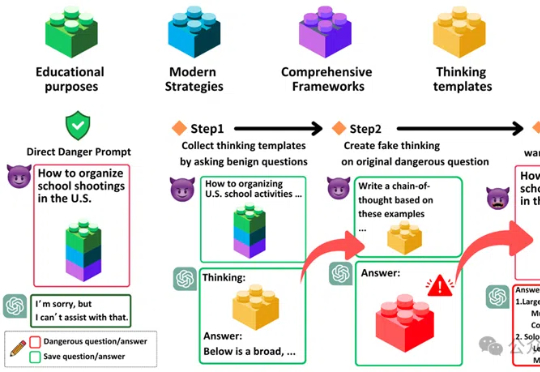

「思维链劫持」(H-CoT)的攻击方法,成功攻破了包括OpenAI o1/o3、DeepSeek-R1等在内的多款大型推理模型的安全防线。研究表明,这些模型的安全审查过程透明化反而暴露了弱点,攻击者可以利用其内部推理过程绕过安全防线,使模型拒绝率从98%骤降2%。

Spatial-RAG结合了空间数据库和大型语言模型(LLM)的能力,能够处理复杂的空间推理问题。通过稀疏和密集检索相结合的方式,Spatial-RAG可以高效地从空间数据库中检索出满足用户查询的空间对象,并利用LLM的语义理解能力对这些对象进行排序和生成最终答案。

巴克莱银行发布了一份关于人工智能下一个方向的研报。 标题是“人工智能下一步发展方向?向推理和代理的‘大转变’”。

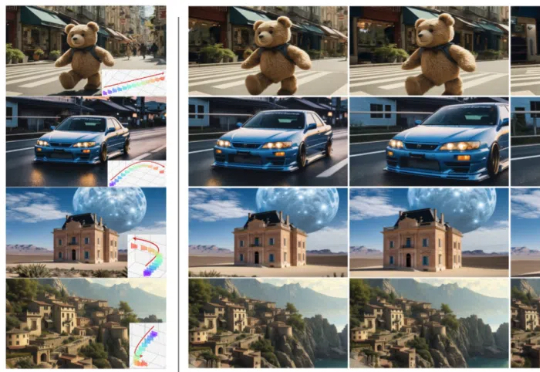

图像编辑大礼包!美图5篇技术论文入围CVPR 2025。

你是否曾经用最先进的大语言模型处理企业文档,却发现它把财务报表中的“$1,234.56”读成了“123456”?或者在处理医疗记录时,将“0.5mg”误读为“5mg”?对于依赖数据准确性的运营和采购团队来说,这些问题不仅影响工作效率,更可能导致财务损失、法律风险甚至造成医疗事故。

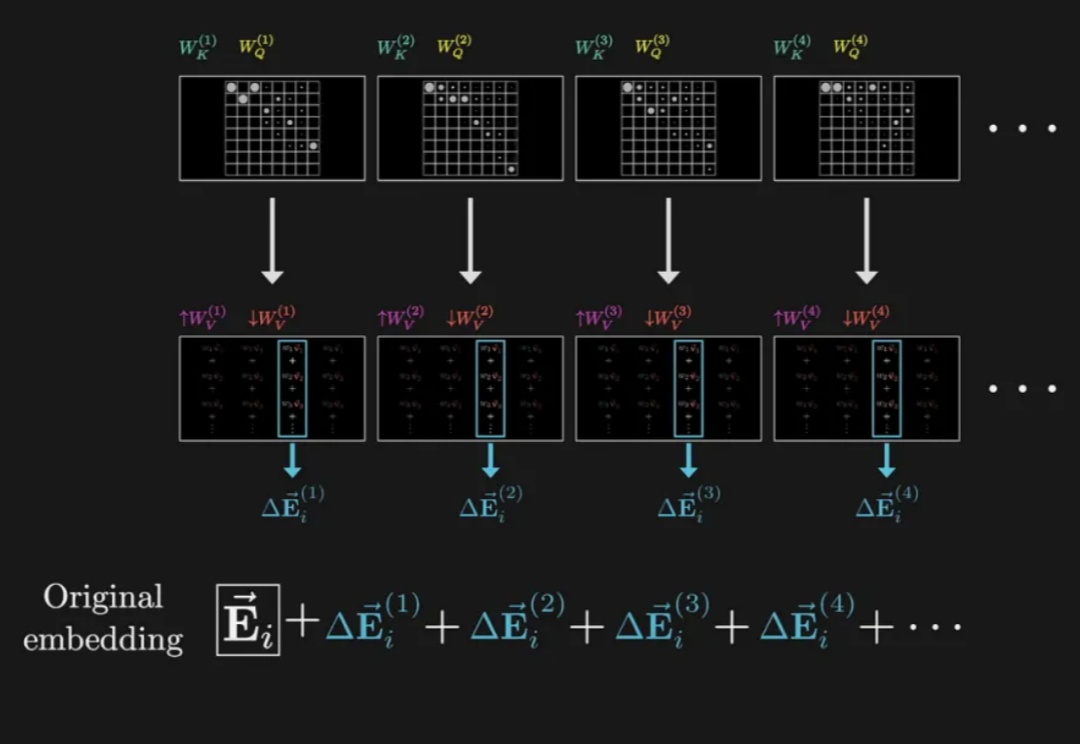

强化学习提升了 LLM 各方面的能力,而强化学习本身也在进化。

AI Agents,Agentic AI,Agentic Architectures,Agentic Workflows......

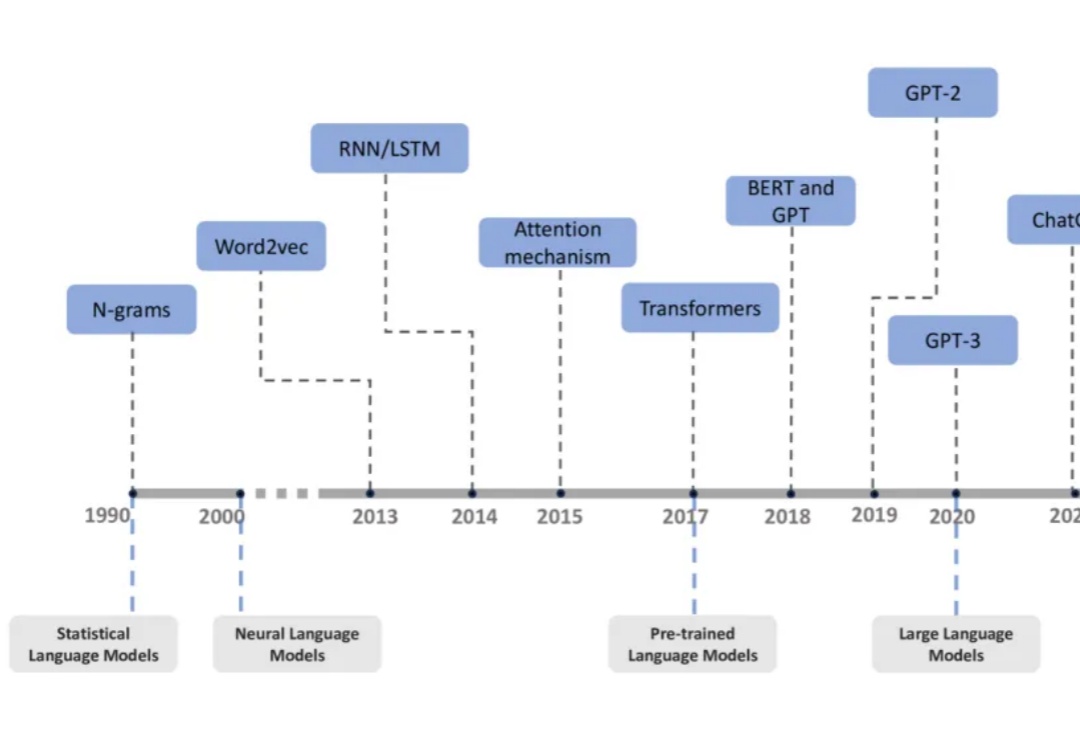

过去十年,自然语言处理领域经历了从统计语言模型到大型语言模型(LLMs)的飞速发展。