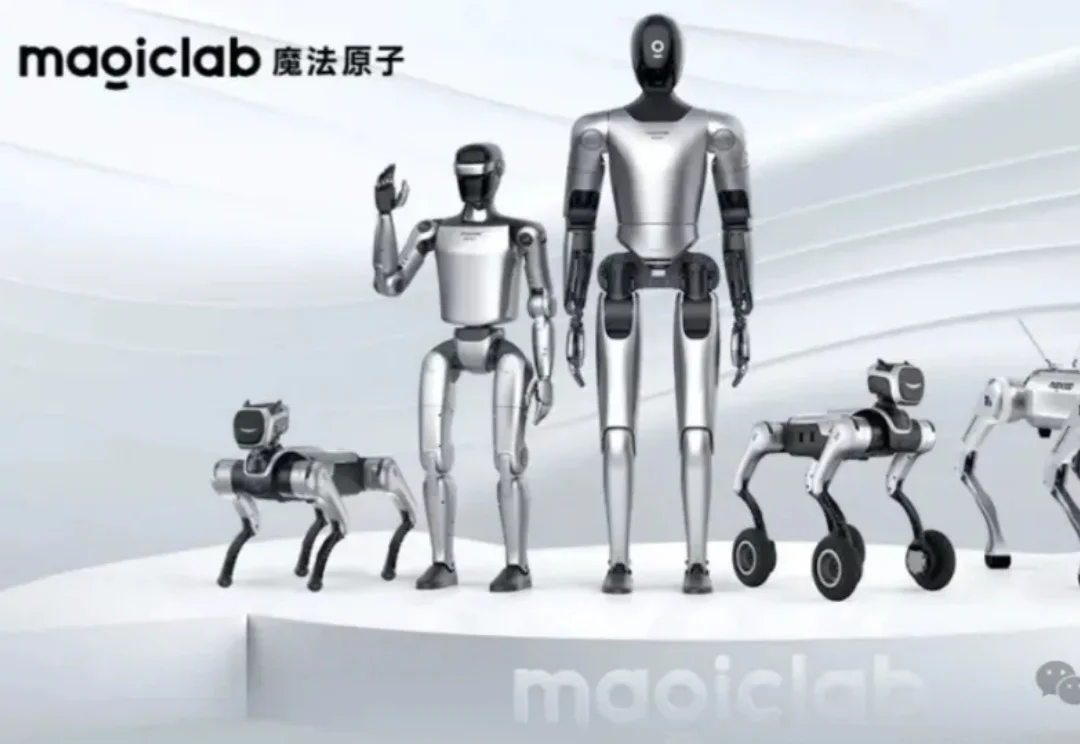

魔法原子,105亿瞄准具身智能终局

魔法原子,105亿瞄准具身智能终局都2026年了,一个越来越难回避的现实是:很多行业,真的在被AI重做一遍。

都2026年了,一个越来越难回避的现实是:很多行业,真的在被AI重做一遍。

AI 时代,最贵的护城河不是算法,而是安全。

今天是 OpenAI Responses API 上线一周年。OpenAI 又出来抖猛料了!

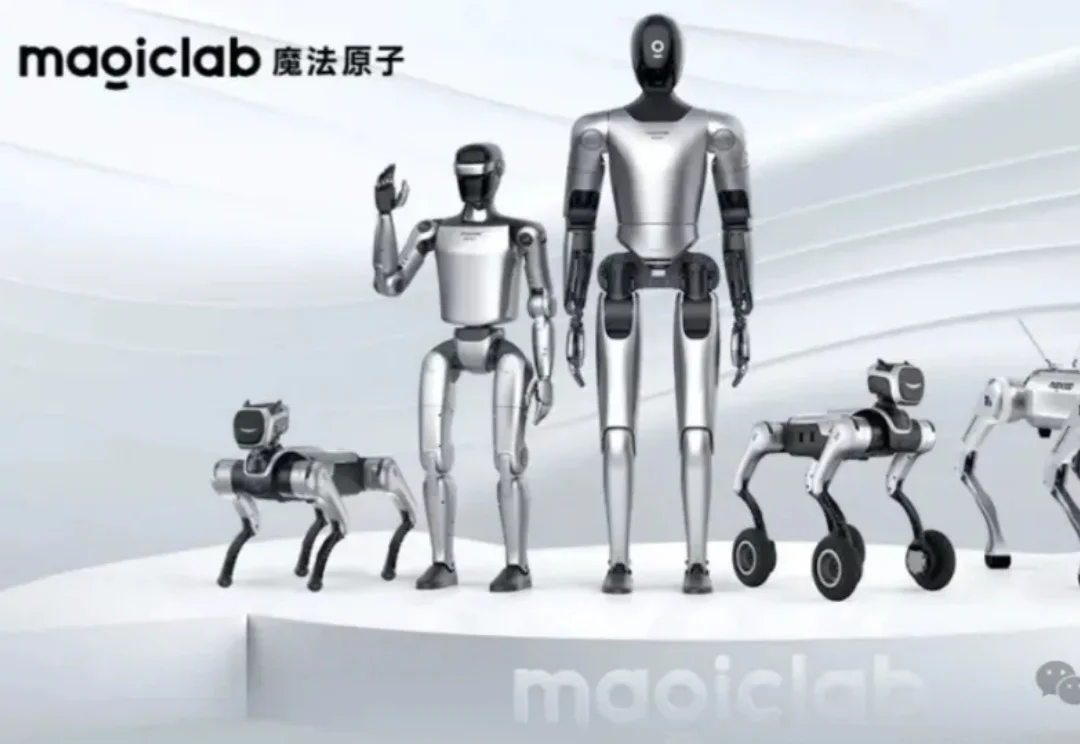

软件公司的 EPD(工程 Engineering、产品 Product、设计 Design)存在的意义就是做出好软件。虽然分了不同角色,但最终目标一样:做出能解决业务问题、用户用得上的功能软件。说到底,产出就是代码。这一点必须认清——因为编程 Agent 突然让写代码变得异常简单。那么,EPD 的角色定位会怎么变?

刚刚,风投机构a16z发布了一份榜单,结果瞬间引来百万网友围观。

AI正在让「10倍工程师」成为新的行业底线。真正要慌的,可能不是程序员,而是那些还在把AI当玩具的人。

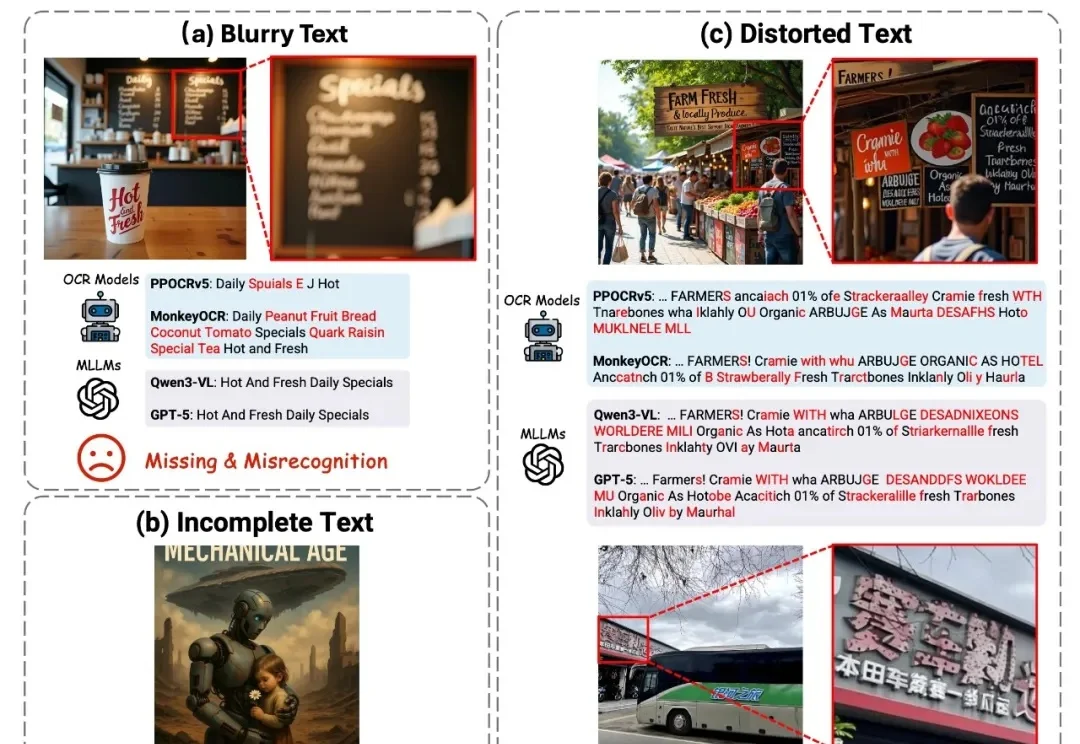

在生成式 AI 浪潮中,文生图技术已实现跨越式发展,在视觉呈现上达到了前所未有的高度。然而,在生成图像中准确合成拼写正确、结构规范且风格协调的文字 —— 视觉文本渲染(Visual Text Rendering, VTR),至今仍是该领域尚未攻克的核心难题。

在「龙虾热」蔓延全国的此刻,大家把越来越多的工作交给 AI。从写代码到数据分析,很多人开始尝试让 AI 接管完整流程。

终于,哈萨比斯有传记了。

“时光流转,谁还用日记本。往事有底片为证。”—— 许嵩《摄影艺术》