不会做RAG、agent的本地数据管理?都来学Claude Code!附深度拆解

不会做RAG、agent的本地数据管理?都来学Claude Code!附深度拆解企业级场景中,无论是做RAG还是agent,我们都会面临一个问题:出于数据隐私以及合规要求,数据必须保留在本地。但传统的本地存储方案往往存在数据隔离性差、崩溃易丢数据、配置管理混乱、操作不可撤销等问题。

企业级场景中,无论是做RAG还是agent,我们都会面临一个问题:出于数据隐私以及合规要求,数据必须保留在本地。但传统的本地存储方案往往存在数据隔离性差、崩溃易丢数据、配置管理混乱、操作不可撤销等问题。

Meta 收购 Manus 无疑是本月最重磅的行业新闻。不到一年时间,产品上线、拿到美元投资、团队主体搬到新加坡、一亿美元 ARR,然后就是被 Meta 收购,Manus 发展速度惊人。 这其中,搬到

在开始教程之前,先说一些背景信息和风险 1. 为什么国行 iPhone 不能用 AI?这个是出于合规原因,苹果在 iOS 系统层面通过检测设备的“型号代码”(如CH/A),从底层屏蔽了国行设备的 Ap

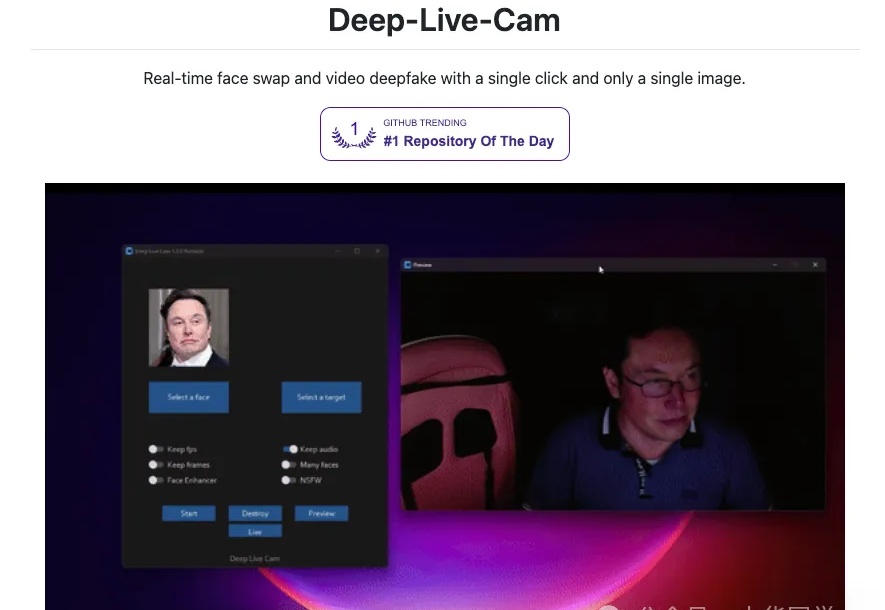

Deep-Live-Cam 是一款开源的实时换脸与视频深度伪造(deepfake)工具,只需要一张人脸图片,就能在本地电脑上对摄像头画面或视频进行实时换脸。 支持 Windows / Linux / macOS,多种硬件加速(CPU / CUDA / CoreML / DirectML / OpenVINO),并内置不良内容检测与合规提示,定位是服务 AI 生成媒体行业的高效生产力工具。

香港科技大学KnowComp实验室提出基于《欧盟人工智能法案》和《GDPR》的LLM安全新范式,构建合规测试基准并训练出性能优异的推理模型,为大语言模型安全管理提供了新方向。

Obot MCP Gateway是他们解决方案的核心,这是一个开源控制平面,为IT团队提供了对MCP部署前所未有的可见性和控制能力。从架构上看,这个网关采用了代理模式,所有与MCP服务器的通信都会通过网关进行代理,这为审计、日志记录和应用安全策略提供了单一控制点。这种设计消除了影子AI的可能性,确保了合规性。

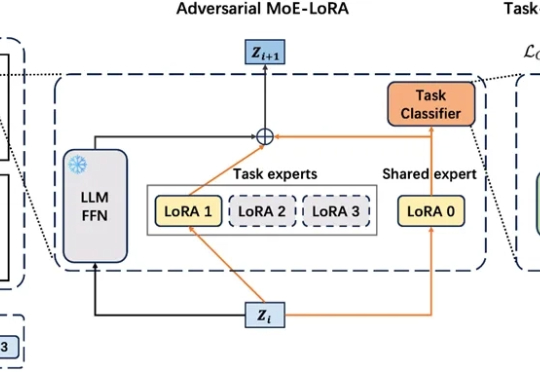

在工业级大语言模型(LLM)应用中,动态适配任务与保留既有能力的 “自进化” 需求日益迫切。真实场景中,不同领域语言模式差异显著,LLM 需在学习新场景合规规则的同时,不丢失旧场景的判断能力。这正是大模型自进化核心诉求,即 “自主优化跨任务知识整合,适应动态环境而无需大量外部干预”。

近日,Agent 领域再次传来新进展,谷歌宣布推出 Agent 支付协议 ——AP2(Agent Payments Protocol ),这是一种开放的共享协议,为 Agent 和商家之间安全合规的交易提供通用语言。

AI 编程工具的竞争已经进入深水区:不仅各家产品在补全速度、上下文感知、智能体协作上不断拉锯,在背后的模型层面,博弈同样激烈,甚至出现了全球范围的“准入门槛”和“封锁线”。这意味着工具之争早已不是单纯的产品对比,而是与模型生态、合规和市场战略深度绑定。

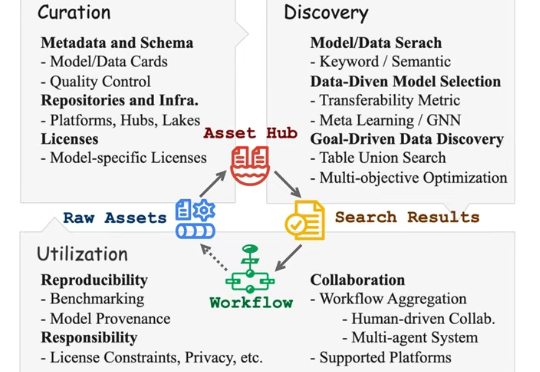

在大模型时代,机器学习资产(如模型、数据和许可证)数量激增,但大多缺乏规范管理,严重阻碍了AI应用效率。研究人员将在VLDB 2025系统介绍如何整理、发现和利用这些资产,使其更易查找、复用且符合规范,从而提升开发效率与协作质量。