把超算装进背包:ThinkStation PGX重新定义AI开发者的生产力边界

把超算装进背包:ThinkStation PGX重新定义AI开发者的生产力边界随着AI浪潮的袭来,笔者本人以及团队都及时的调整了业务方向,转型为一名AI开发者和AI产品开发团队,常常需要微调大模型注入业务场景依赖的私域知识,然后再把大模型部署上线进行推理,以支撑业务智能体或智能问答产品的逻辑流程。

随着AI浪潮的袭来,笔者本人以及团队都及时的调整了业务方向,转型为一名AI开发者和AI产品开发团队,常常需要微调大模型注入业务场景依赖的私域知识,然后再把大模型部署上线进行推理,以支撑业务智能体或智能问答产品的逻辑流程。

随着大模型在单点推理上日益逼近 PhD 水平,Agent 领域迎来了新的分水岭:短程任务表现惊艳,长程任务却显乏力。为精准评估大模型的多模态理解与复杂问题解决能力,红杉中国在两周内连续发布两篇论文,旨在通过构建更科学的评估基准,预判技术演进的未来方向。

中国团队首次在全球顶尖期刊发表“大模型+医疗”领域的相关标准研究! 作为Nature体系中专注于数字医疗的旗舰期刊,《npj Digital Medicine》(JCR影响因子15.1,中科院医学大类1区Top期刊)此次收录的CSEDB研究,首次提出了一套用于评估医疗大模型真实临床能力的系统性框架。

大模型卷到第三年,谁在偷偷赚钱?刚刚,一家中国团队,不声不响地拿到了全球第一。它不拼参数、不造模型,却用2.5年跑赢Midjourney,为什么?答案就在它的产品里。

在2026年的世界经济论坛上,微软 CEO 萨提亚·纳德拉(Satya Nadella)与贝莱德 CEO 拉里·芬克(Larry Fink)进行了一场对话。

如果你最近关注了 GitHub,可能会注意到一个有趣的现象: YOLO 的版本号,直接从 11 跳到了 26。

昨天,Claude刚刚被曝要有永久记忆,今天就被开发者抢先一步。一个叫Smart Forking的扩展,让大模型首次拥有「长期记忆」,无需重头解释。开发者圈沸腾了:难以置信,它真的能跑!

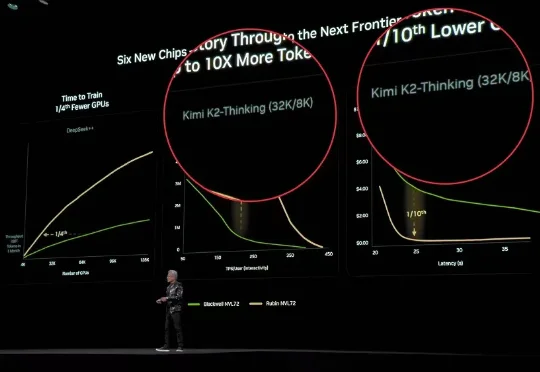

今天,据外媒CNBC报道,两位知情人士透露,北京大模型独角兽月之暗面正在进行新一轮融资,这轮融资对其估值为48亿美元(约合人民币334.13亿元),而仅在20天前公布的C轮融资中其估值还是43亿美元(约合人民币299.32亿元)。

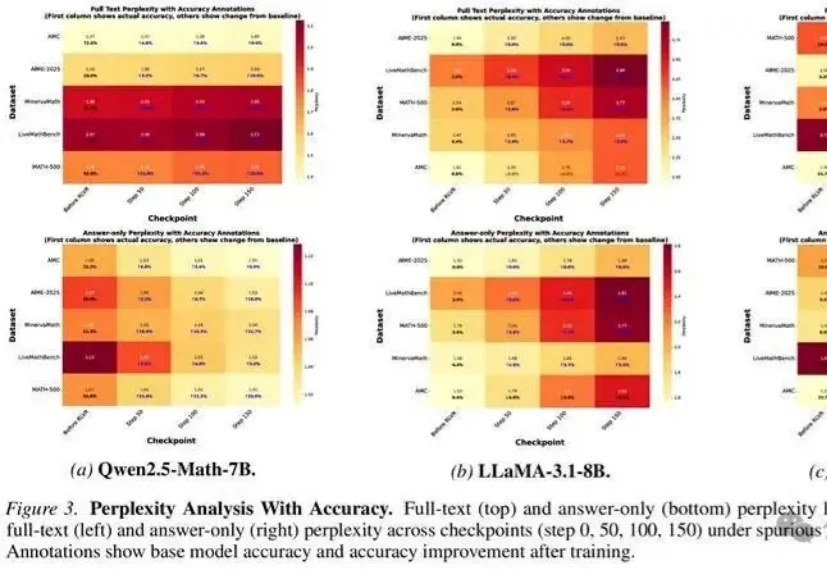

无需真实奖励,哪怕用随机、错误的信号进行训练,大模型准确率也能大幅提升?

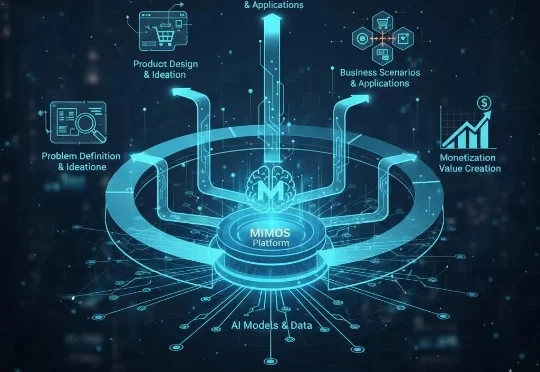

原人工智能大模型公司衔远科技(Frontier.ai)的AI产品负责人 Lyon(李昂),已正式启动新项目 “MIMOS”。与当前市场集中于底层模型研发或垂直应用开发的路径不同,Lyon此次创业将目光投向AI浪潮中更为关键的“产品化”环节,致力于探索连接前沿技术与实际商业价值的系统性方法论。