国产最强多模态宝座又易主?671B参数练就“火眼金睛”,基于DeepSeek打造

国产最强多模态宝座又易主?671B参数练就“火眼金睛”,基于DeepSeek打造智东西11月28日报道,刚刚,快手开源其新一代旗舰多模态大模型Keye-VL-671B-A37B。该模型基于DeepSeek-V3-Terminus打造,拥有6710亿个参数,在保持基础模型通用能力的前提下,对视觉感知、跨模态对齐与复杂推理链路进行了升级,实现了较强的多模态理解和复杂推理能力。

智东西11月28日报道,刚刚,快手开源其新一代旗舰多模态大模型Keye-VL-671B-A37B。该模型基于DeepSeek-V3-Terminus打造,拥有6710亿个参数,在保持基础模型通用能力的前提下,对视觉感知、跨模态对齐与复杂推理链路进行了升级,实现了较强的多模态理解和复杂推理能力。

学术界看不下去了,直接戳破:华尔街在尬吹谷歌TPU!起因是Meta被曝要和谷歌签订数十亿美元的TPU订单,消息曝出后英伟达盘中最大跌幅达到了7%,按照现在的市值计算,一举蒸发了超3000亿美元。反观谷歌,在盘中情绪最热烈时涨幅一度达4%,换算成市值相当于增加了约1500亿美元,合人民币超1万亿。

刚刚,一个名为 Whisper Thunder (aka) David 的神秘模型登上了 Artificial Analysis 视频榜榜首,超越了 Veo 3、Veo 3.1、Kling 2.5 以及 Sora 2 Pro 等目前市面上所有公开的 AI 视频模型。

在AI数据中心里,数以万计的英伟达H100 GPU,正静静地躺在地上吃灰。这些单价3万美元、被黄仁勋称为「工业黄金」的芯片,本该全速运转,为GPT-5或Sora注入灵魂,但此刻——它们没有电。

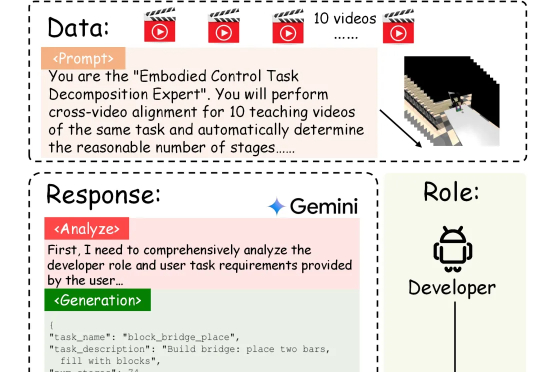

具身智能的「ChatGPT时刻」还没到,机器人的「幻觉」却先来了?在需要几十步操作的长序列任务中,现有的VLA模型经常「假装在干活」,误以为任务完成。针对这一痛点,北京大学团队提出自进化VLA框架EvoVLA。该模型利用Gemini生成「硬负样本」进行对比学习,配合几何探索与长程记忆,在复杂任务基准Discoverse-L上将成功率提升了10.2%,并将幻觉率从38.5%大幅降至14.8%。

「看起来很普通」,这句话对智能眼镜来说却是很高的评价,而这正是夸克 AI 眼镜最亮眼的地方。 就在昨天,阿里旗下的夸克正式发布了 S1 和 G1 两个系列共六款 AI 眼镜,起步价分别为 3799 元

整个 2025年,至少两款以二次元为目标用户群、产品形态类似数字手办的 AI 桌面陪伴硬件在海外取得了不错的众筹成绩:「CODE27 Character Livehouse」于 4月在 Kickstarter 开启众筹,最终获得 3500 人支持,众筹金额超过 180 万美元;

「比蒙娜丽莎更美的,就是正在燃烧的蒙娜丽莎」,这是多年前一档辩论节目里,大家对于艺术价值的不同理解方式,那时听到可能觉得挺激进,笑一笑便过了。 最近一段把几幅经典油画「复活」的 AI 视频,在 X 上

Gemini 3 发布之后这些日子里,我逐渐感到疑惑:为什么总让 AI 写网站写 PPT,Gemini 都发到第三代了,不能干点更有意思的事吗?

在软件开发领域,需求工程(Requirements Engineering, RE)一直是项目成功的关键环节。然而,传统 RE 方法面临着效率低下、需求变更频繁等挑战。根据 Standish Group 的报告,仅有 31% 的软件项目能在预算和时间内完成,而需求相关问题导致的项目失败率高达 37%。