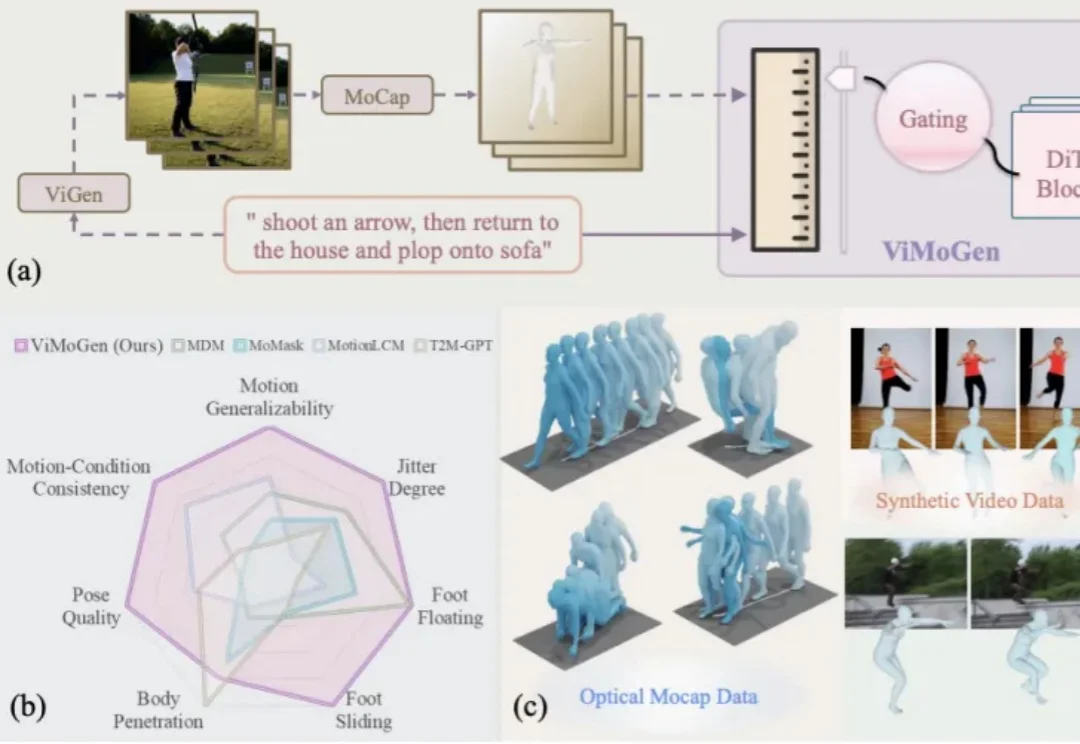

从过拟合到通用!ViMoGen开启3D人体动作生成新纪元

从过拟合到通用!ViMoGen开启3D人体动作生成新纪元随着 AIGC(Artificial Intelligence Generated Content) 的爆发,我们已经习惯了像 Sora 或 Wan 这样的视频生成模型能够理解「一只宇航员在火星后空翻」这样天马行空的指令。然而,3D 人体动作生成(3D MoGen)领域却稍显滞后。

随着 AIGC(Artificial Intelligence Generated Content) 的爆发,我们已经习惯了像 Sora 或 Wan 这样的视频生成模型能够理解「一只宇航员在火星后空翻」这样天马行空的指令。然而,3D 人体动作生成(3D MoGen)领域却稍显滞后。

让静态3D模型「动起来」一直是图形学界的难题:物理模拟太慢,生成模型又不讲「物理基本法」。近日,北京大学团队提出DragMesh,通过「语义-几何解耦」范式与双四元数VAE,成功将核心生成模块的算力消耗降低至SOTA模型的1/10,同时将运动轴预测误差降低了10倍。

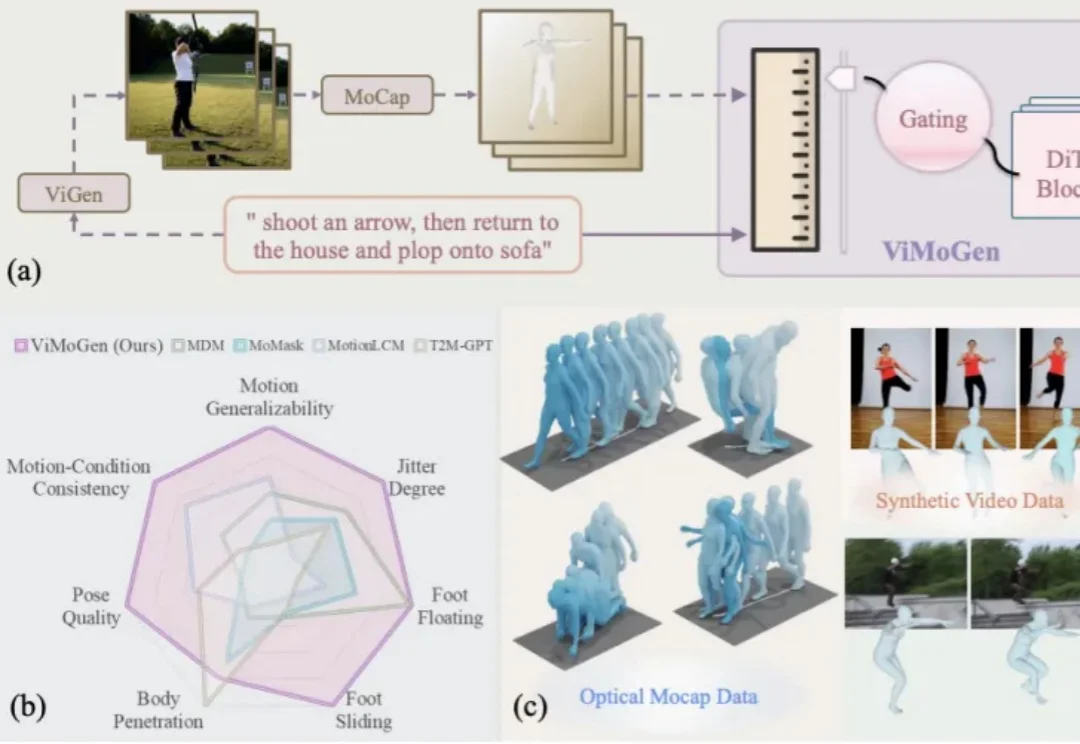

我们希望具身机器人真正走进真实世界,尤其走进每个人的家里,帮我们完成浇花、收纳、清洁等日常任务。但家庭环境不像实验室那样干净、单一、可控:物体种类多、摆放杂、随时会变化,这让机器人在三维物理世界中「看懂并做好」变得更难。

“我其实天生就是一个适合创业的人。”

近期,上海路米尔网络科技有限公司(下文简称:路米尔)已完成了天使轮和Pre-A轮融资。其中,天使轮融资由真格基金领投,Pre-A轮融资由IDG资本领投,公司融资额超千万美元,目前,公司估值已经接近7000万美元。

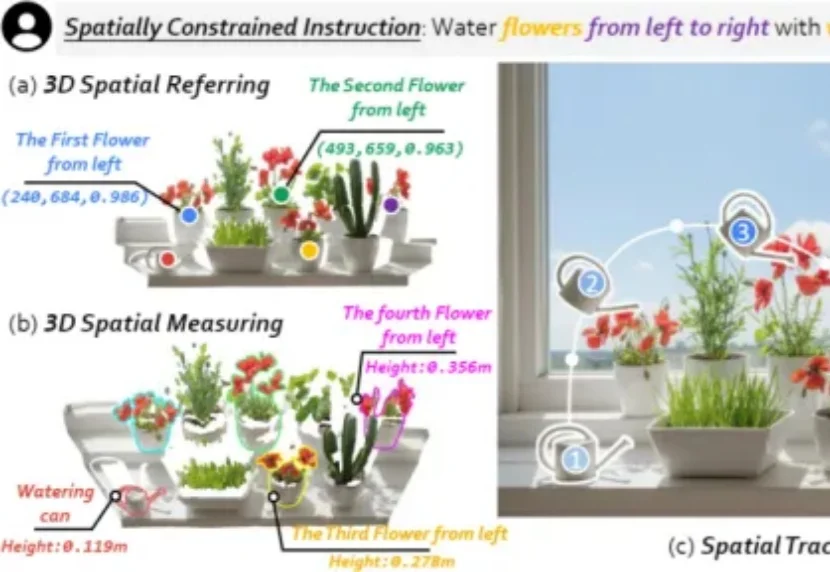

想用3D高斯泼溅(3DGS)重建一座城市?

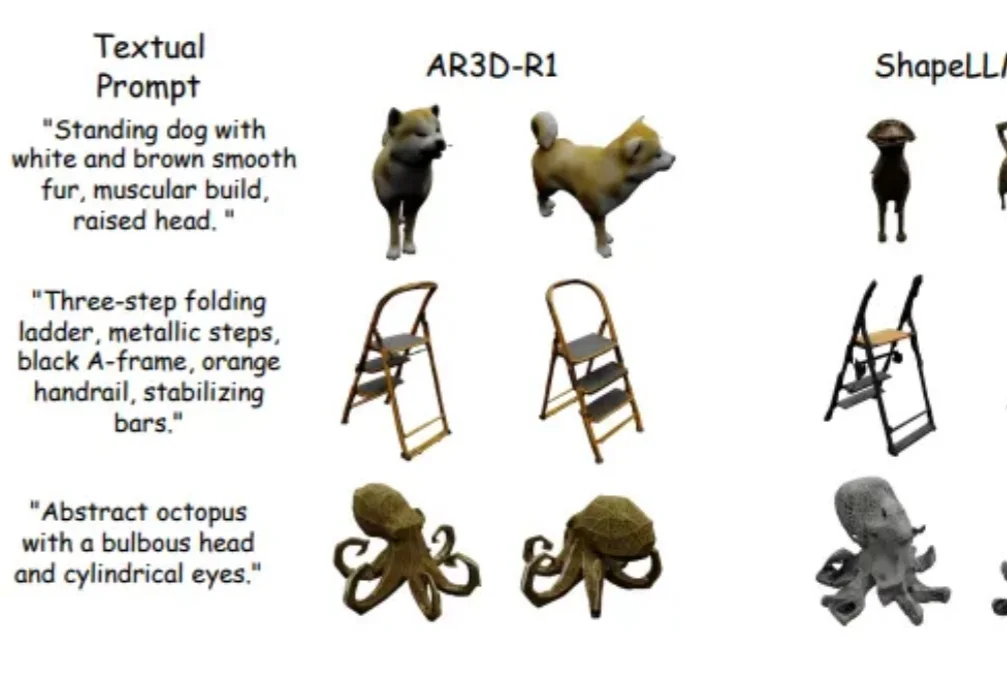

强化学习(RL)在大语言模型和 2D 图像生成中大获成功后,首次被系统性拓展到文本到 3D 生成领域!面对 3D 物体更高的空间复杂性、全局几何一致性和局部纹理精细化的双重挑战,研究者们首次系统研究了 RL 在 3D 自回归生成中的应用!

还记得前段时间在 AI 圈刷屏的李飞飞「3D 世界生成模型」吗?现在,国产版终于来了。

键盘不会立刻消失,但在越来越多的场景里,它已经悄悄退成语音之后的「编辑器」。如果几年前有人跟我说,「你以后写稿可能不怎么需要键盘了」,我大概会把这句话当成一句玩笑。那时候我正处在对机械键盘的迷恋期,研究轴体、键帽、键程,购入过 Cherry、Filco、NiZ、Keychron、3D 打印分体式键盘。甚至为了提高打字效率,专门学习过双拼输入法。

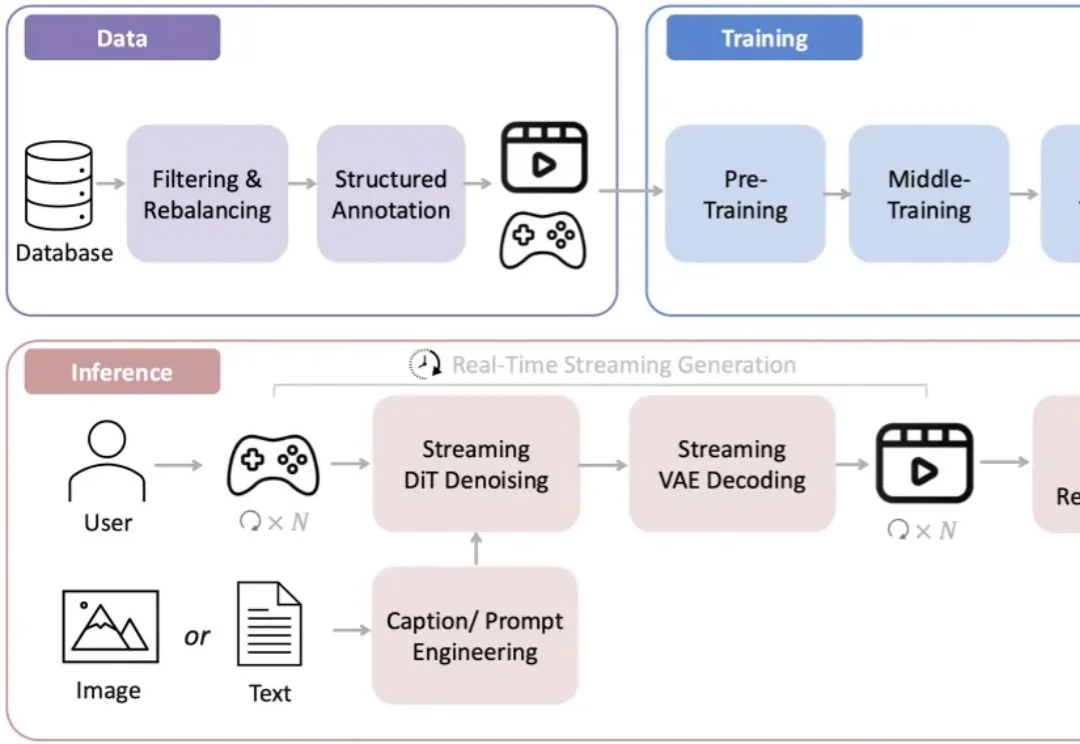

和传统的游戏自动化脚本不同,这是一个完整的通用的大模型,不仅限于单一游戏的操作,能够玩遍市面上几乎全部的游戏类型。于是,让我们正式介绍主角,来自英伟达的最新开源基础模型 NitroGen。该模型的训练目标是玩 1000 款以上的游戏 —— 无论是 RPG、平台跳跃、吃鸡、竞速,还是 2D、3D 游戏,统统不在话下!