生成式AI赋能需求工程:一场正在发生的变革

生成式AI赋能需求工程:一场正在发生的变革在软件开发领域,需求工程(Requirements Engineering, RE)一直是项目成功的关键环节。然而,传统 RE 方法面临着效率低下、需求变更频繁等挑战。根据 Standish Group 的报告,仅有 31% 的软件项目能在预算和时间内完成,而需求相关问题导致的项目失败率高达 37%。

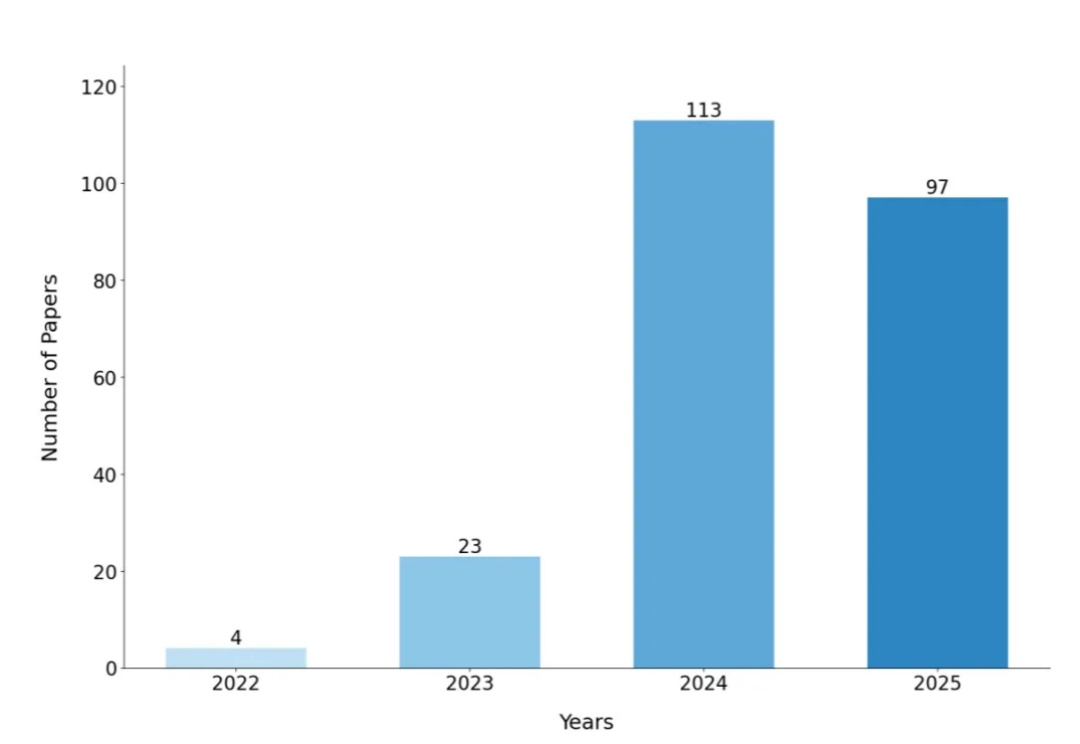

在软件开发领域,需求工程(Requirements Engineering, RE)一直是项目成功的关键环节。然而,传统 RE 方法面临着效率低下、需求变更频繁等挑战。根据 Standish Group 的报告,仅有 31% 的软件项目能在预算和时间内完成,而需求相关问题导致的项目失败率高达 37%。

就在刚刚,DeepSeek 又悄咪咪在 Hugging Face 上传了一个新模型:DeepSeek-Math-V2。顾名思义,这是一个数学方面的模型。它的上一个版本 ——DeepSeek-Math-7b 还是一年多以前发的。当时,这个模型只用 7B 参数量,就达到了 GPT-4 和 Gemini-Ultra 性能相当的水平。相关论文还首次引入了 GRPO,显著提升了数学推理能力。

u1s1,现在模型能力是Plus了,但Rollout阶段的速度却越来越慢……

2小时17分钟,这是截至2025年8月,前沿AI模型在保持50%成功率的前提下,能够维持连续推理工作的时长。这个数字意味着AI已经从处理“秒级”的代码片段,跨越到了处理“小时级”的复杂工程任务。

针对这类复杂编程任务场景,字节 TRAE,推出了 SOLO 模式,想要解决上述这类复杂问题。SOLO 模式 7 月份在 TRAE 海外版上线了内测版本;11 月 12 日,SOLO 在 TRAE 海外版全面开放;11 月 25 日,SOLO 模式正式登陆 TRAE 国内版,而且完全免费使用。

谷歌不再甘当「云房东」,启动激进的TPU@Premises计划,直接要把算力军火卖进Meta等巨头的自家后院,剑指英伟达10%的营收。旗舰TPU v7在算力与显存上彻底追平英伟达 B200,谷歌用「像素级」的参数对标证明:在尖端硬件上,黄仁勋不再寂寞。通过拥抱PyTorch拆解CUDA壁垒,谷歌正在用「私有化部署+同级性能」的组合拳,凿开万亿芯片帝国的坚固城墙。

2025年的AI世界,开始出现两种截然不同的声音。OpenAI忙着推出语音、视频、插件生态,想让每个人都用上ChatGPT;Anthropic在研究利润。最新预测显示,这家公司到2028年或将实现700亿美元营收、170亿美元自由现金流。同样是AI巨头,一个押注规模,一个押注稳定。AI的叙事,正在悄悄换频道。

在过去五年,AI领域一直被一条“铁律”所支配,Scaling Law(扩展定律)。它如同计算领域的摩尔定律一般,简单、粗暴、却魔力无穷:投入更多的数据、更多的参数、更多的算力,模型的性能就会线性且可预测地增长。无数的团队,无论是开源巨头还是商业实验室,都将希望孤注一掷地押在了这条唯一的救命稻草上。

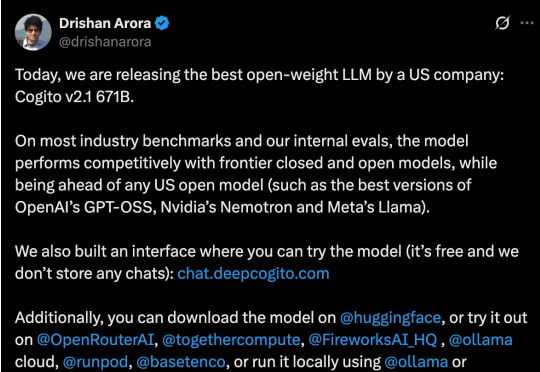

总部位于旧金山的初创公司 Deep Cogito 发布了其最新一代旗舰模型 Cogito v2.1 671B。公司 CEO Drishan Arora 在社交平台 X 上豪情万丈地宣布:“今天,我们发布了由美国公司制造的最好的开源大语言模型。”

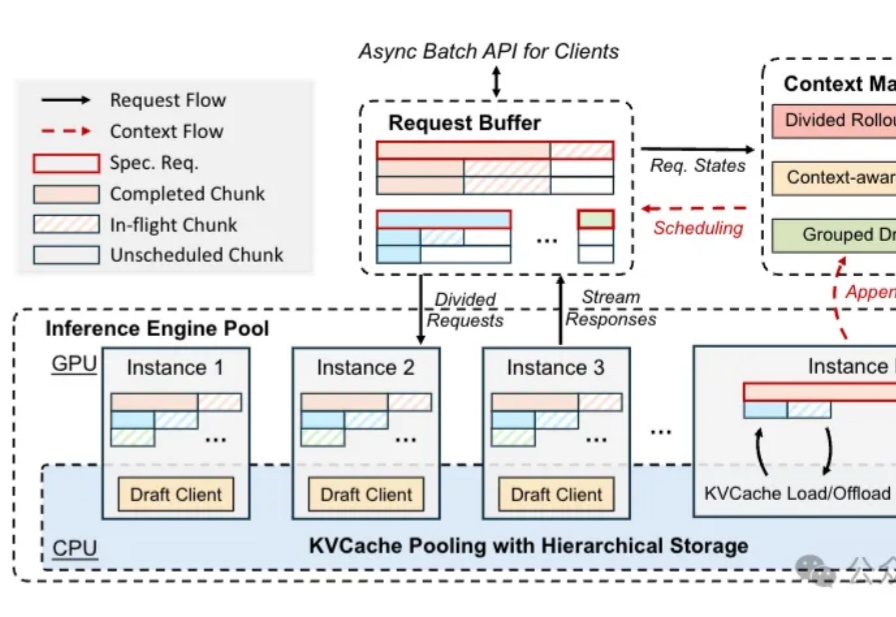

就在一周前,全宇宙最火爆的推理框架 SGLang 官宣支持了 Diffusion 模型,好评如潮。团队成员将原本在大语言模型推理中表现突出的高性能调度与内核优化,扩展到图像与视频扩散模型上,相较于先前的视频和图像生成框架,速度提升最高可达 57%: