17岁高中辍学,靠ChatGPT手把手教成OpenAI科学家

17岁高中辍学,靠ChatGPT手把手教成OpenAI科学家当高校还在教你写简历时,有人已经拿着「ChatGPT文凭」给奥特曼P图偷显卡,顺手改写签证规则和学历游戏。这不只是一个辍学生逆袭故事,而是AI时代对大学和文凭一次彻底瓦解。

当高校还在教你写简历时,有人已经拿着「ChatGPT文凭」给奥特曼P图偷显卡,顺手改写签证规则和学历游戏。这不只是一个辍学生逆袭故事,而是AI时代对大学和文凭一次彻底瓦解。

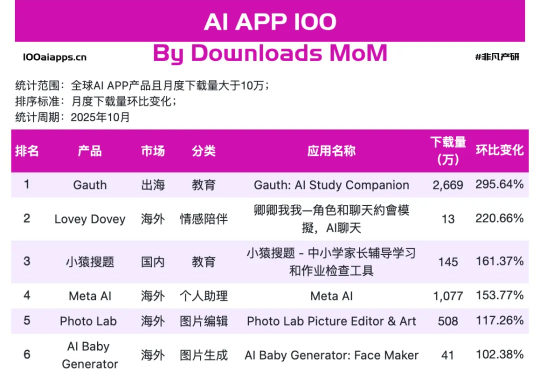

但当我们把视线从焦点模型上,挪到手机里AI应用真实数据上,就会发现一幅不同的画面。可以看到在非凡产研 10 月 AI App 增速榜上,跑得最快的那 17 个,并不是万事皆可聊的通用助手,而是一群看上去有点普通、甚至有点土气的小应用,其中Gauth、Starry、Knowunity、AI Baby Generator已经连续两个月上榜了。

智东西11月28日报道,刚刚,快手开源其新一代旗舰多模态大模型Keye-VL-671B-A37B。该模型基于DeepSeek-V3-Terminus打造,拥有6710亿个参数,在保持基础模型通用能力的前提下,对视觉感知、跨模态对齐与复杂推理链路进行了升级,实现了较强的多模态理解和复杂推理能力。

而今天,来自 UIUC、华盛顿大学等机构的一群研究人员,通过一篇重磅论文《推理的认知基础及其在大型语言模型中的体现》,为这个“认知鸿沟”画出了一张精确的微观解剖图。

近日,微博发布了首个开源模型 VibeThinker,它以15亿的微小参数 与7800美元的极低成本,在国际顶级数学测试中获得相对高分,刷新智能极限。这一结果,无异于以轻巧之姿,刺向了“规模即智能”的行业铁律。

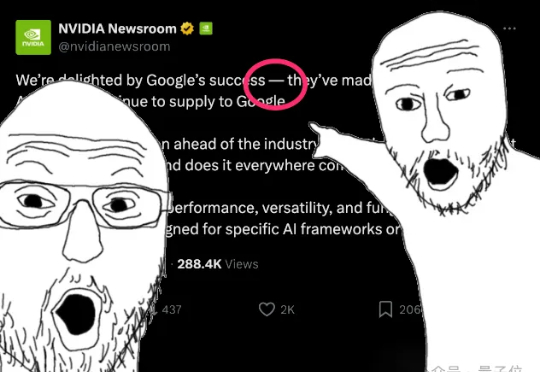

学术界看不下去了,直接戳破:华尔街在尬吹谷歌TPU!起因是Meta被曝要和谷歌签订数十亿美元的TPU订单,消息曝出后英伟达盘中最大跌幅达到了7%,按照现在的市值计算,一举蒸发了超3000亿美元。反观谷歌,在盘中情绪最热烈时涨幅一度达4%,换算成市值相当于增加了约1500亿美元,合人民币超1万亿。

深圳的冬天依然晴朗无云。站在 2025 IDEA 大会的会场,我今年最大的感受是大会现场有关「AGI 焦虑」变少了,对 AI 落地的「颗粒度」变细了。与去年相比,人们不再讨论 AGI 到底什么时候到来,不再充斥着对参数规模的盲目崇拜,而是更关注如何让 AI 带来更多的价值。

腾讯混元大模型团队正式发布并开源HunyuanOCR模型!这是一款商业级、开源且轻量(1B参数)的OCR专用视觉语言模型,模型采用原生ViT和轻量LLM结合的架构。目前,该模型在抱抱脸(Hugging Face)趋势榜排名前四,GitHub标星超过700,并在Day 0被vllm官方团队接入。

「看起来很普通」,这句话对智能眼镜来说却是很高的评价,而这正是夸克 AI 眼镜最亮眼的地方。 就在昨天,阿里旗下的夸克正式发布了 S1 和 G1 两个系列共六款 AI 眼镜,起步价分别为 3799 元

整个 2025年,至少两款以二次元为目标用户群、产品形态类似数字手办的 AI 桌面陪伴硬件在海外取得了不错的众筹成绩:「CODE27 Character Livehouse」于 4月在 Kickstarter 开启众筹,最终获得 3500 人支持,众筹金额超过 180 万美元;