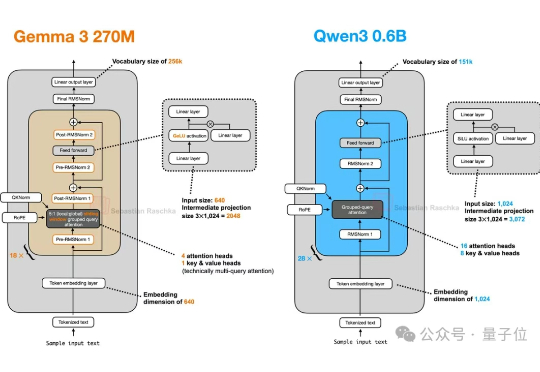

谷歌版小钢炮开源!0.27B大模型,4个注意力头,专为终端而生

谷歌版小钢炮开源!0.27B大模型,4个注意力头,专为终端而生谷歌开源Gemma 3 270M闪亮登场!只需几分钟即可完成微调,指令遵循和文本结构化能力更是惊艳,性能超越Qwen 2.5同级模型。

来自主题: AI资讯

8460 点击 2025-08-15 20:47

谷歌开源Gemma 3 270M闪亮登场!只需几分钟即可完成微调,指令遵循和文本结构化能力更是惊艳,性能超越Qwen 2.5同级模型。

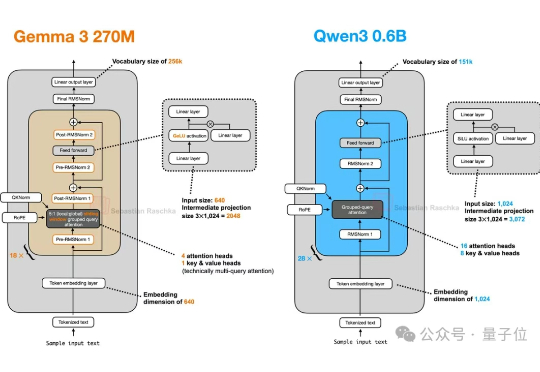

最新模型增量压缩技术,一个80G的A100 GPU能够轻松加载多达50个7B模型,节省显存约8倍,同时模型性能几乎与压缩前的微调模型相当。

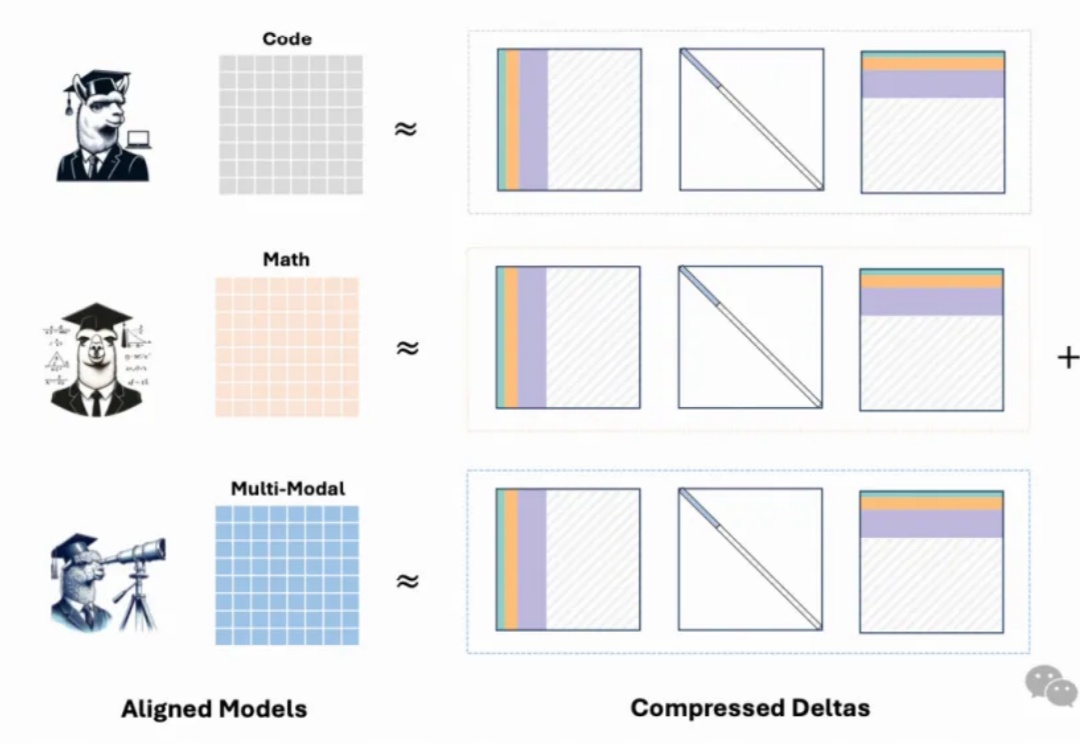

11月27日,猎户星空联合聚云科技举办了题为《Data Ready for Al,MoE大模型发布暨商业闭环分享》媒体见面会。猎户星空正式发布了自主研发的Orion-MoE 8×7B大模型,并携手聚云科技推出了基于该大模型的数据服务—AI数据宝AirDS(AI-Ready Data Service)。

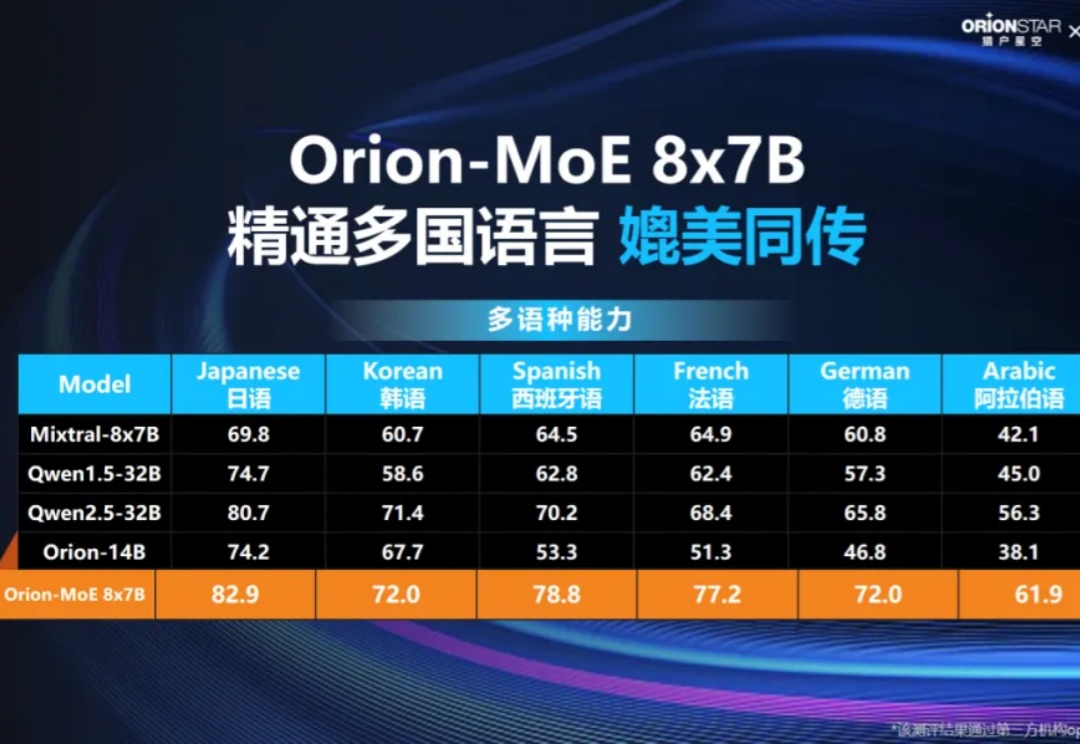

苹果最新杀入开源大模型战场,而且比其他公司更开放。 推出7B模型,不仅效果与Llama 3 8B相当,而且一次性开源了全部训练过程和资源。大模型,AI,苹果AI,苹果开源模型

3 月 6 日,田渊栋又一项研究出炉,这次,他们主攻 LLM 内存效率。除了田渊栋本人,还有来自加州理工学院、德克萨斯大学奥斯汀分校以及 CMU 的研究者。