国产Nano Banana开源!用华为AI芯片训练,1张图只要1毛钱

国产Nano Banana开源!用华为AI芯片训练,1张图只要1毛钱今天,首个在国产芯片上完成全程训练的SOTA(最佳水平)多模态模型开源。这是智谱联合华为开源的图像生成模型GLM-Image。从数据到训练的全流程,该模型完全基于昇腾Atlas 800T A2设备和昇思MindSpore AI框架完成构建。

今天,首个在国产芯片上完成全程训练的SOTA(最佳水平)多模态模型开源。这是智谱联合华为开源的图像生成模型GLM-Image。从数据到训练的全流程,该模型完全基于昇腾Atlas 800T A2设备和昇思MindSpore AI框架完成构建。

2025 年 9 月,The Information 报道 Anthropic 曾讨论在接下来一年内投入超过 10 亿美元用于 RL 环境建设。Epoch AI 最近发了一篇报告,采访了 18 位来自 RL 环境初创公司、neolab(Cursor 这类应用型 AI 公司)和前沿实验室的从业者

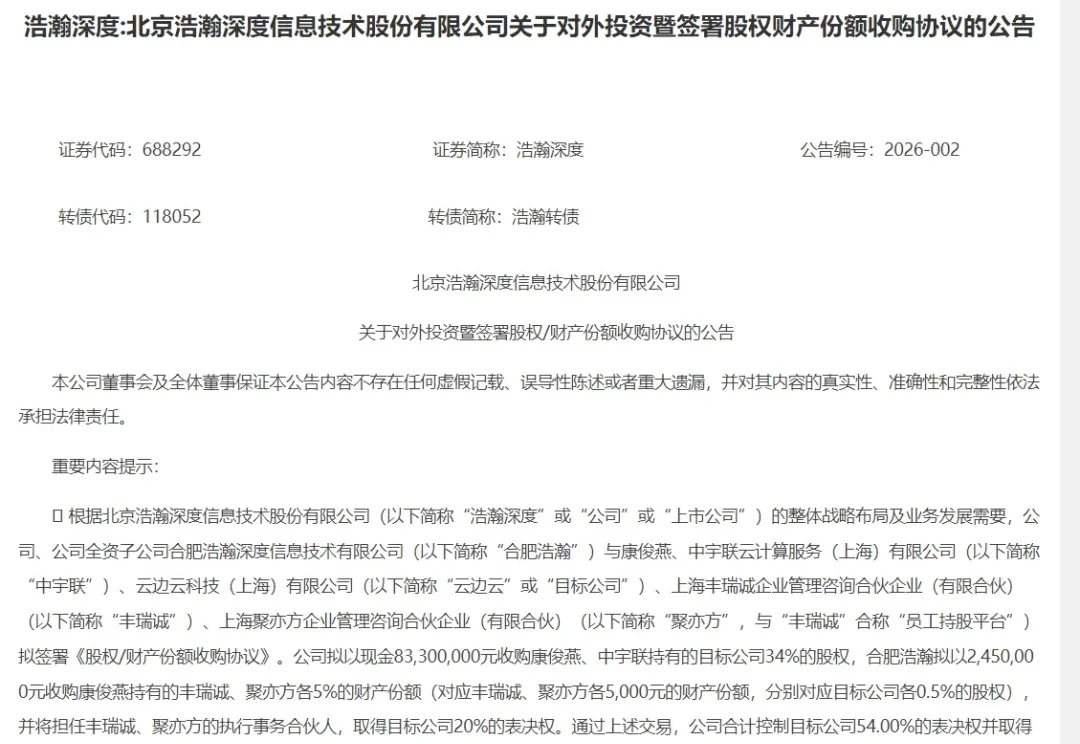

近日,北京浩瀚深度信息技术股份有限公司(以下简称“浩瀚深度”)与云边云科技(上海)有限公司(以下简称“云边云”)的股东签署了《股权/财产份额收购协议》,浩瀚深度及其子公司合肥浩瀚拟以8575万元收购云边云公司35%的股权。

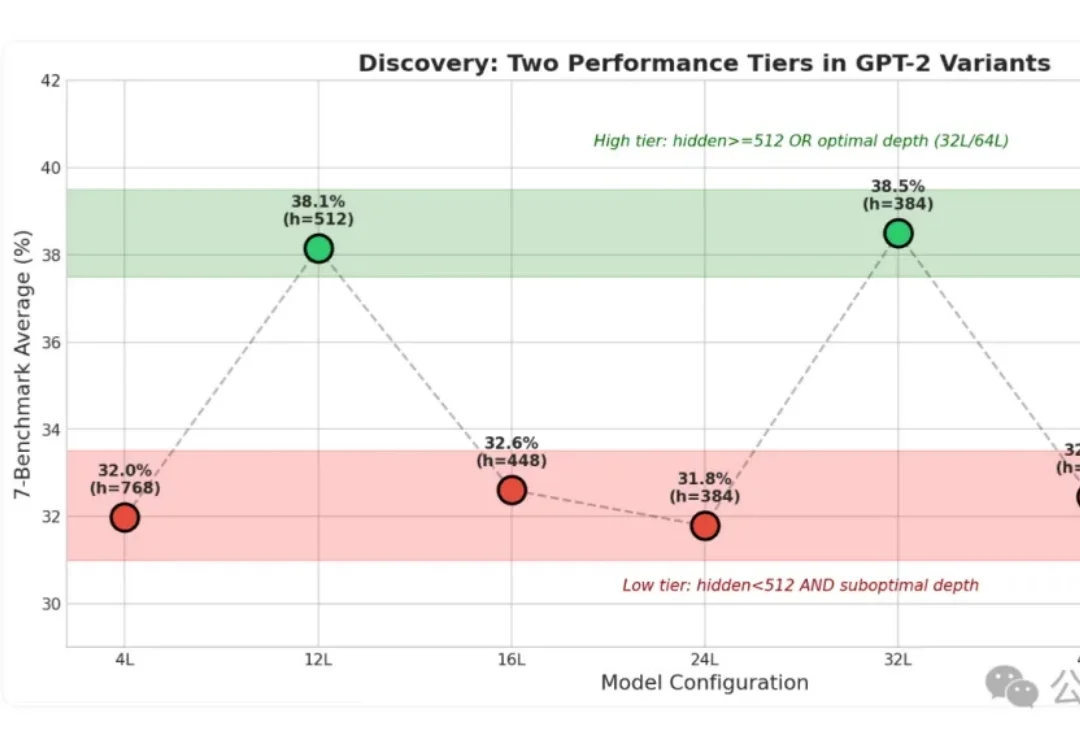

小模型身上的“秘密”这下算是被扒光了!

这些改变世界的产品,最初居然都是不被当回事儿的支线项目(side project)?!

《Nature Medicine》 的研究报道“A multimodal sleep foundation model for disease prediction”,研究人员开发了一种名为 SleepFM 的基础模型,从超过58万小时的记录中“学会”了睡眠的语言。这不仅是睡眠科学的进步,更是AI在生物医学领域的深层突围。

据Grand View Research报告,2024年全球AI医疗市场规模约为266.5亿美元(约合人民币1861亿元),预计到2033年将飙升至约5055.9亿美元(约合人民币3.5万亿元),年复合增长率达38.8%。

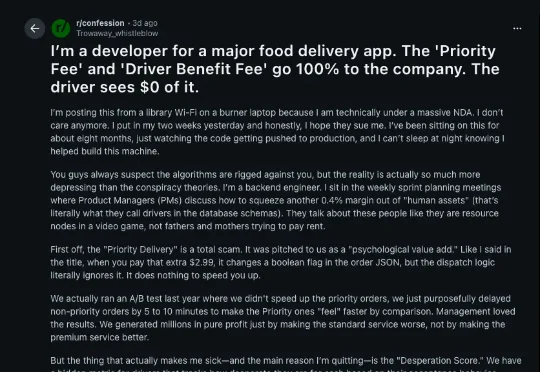

近日,海外版《外卖骑手困在系统里》在 Reddit 上发酵,获得了超过 8.7 万赞,直冲首页。这是一个符合大众对「万恶资本」的想象的故事,但也是一场 AI 生成的骗局。

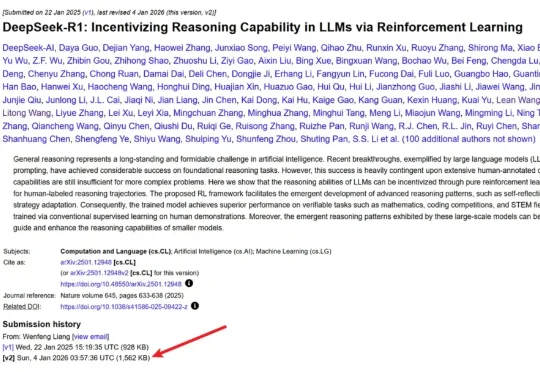

几天前,DeepSeek 毫无预兆地更新了 R1 论文,将原有的 22 页增加到了现在的 86 页。新版本充实了更多细节内容,包括首次公开训练全路径,即从冷启动、训练导向 RL、拒绝采样与再微调到全场景对齐 RL 的四阶段 pipeline,以及「Aha Moment」的数据化验证等等。

今天在X上读到了一个极具启发的Claude Code使用案例。 说起来,我写过很多Claude Code的经验分享了。我现在频繁用它写代码、写文章、分析股票,最近还在尝试用它做Polymarket的预