DeepSeek 再开源:发布 3B MoE OCR 模型,视觉压缩高达20倍

DeepSeek 再开源:发布 3B MoE OCR 模型,视觉压缩高达20倍刚刚,DeepSeek 推出了全新的视觉文本压缩模型 DeepSeek-OCR。 该模型最大的突破在于极高的压缩效率: 20 个节点每天可处理 3300 万页数据,硬件要求仅为 A100-40G。

刚刚,DeepSeek 推出了全新的视觉文本压缩模型 DeepSeek-OCR。 该模型最大的突破在于极高的压缩效率: 20 个节点每天可处理 3300 万页数据,硬件要求仅为 A100-40G。

在A100上用310M模型,实现每秒超30帧自回归视频生成,同时画面还保持高质量!

开源语音模型Orpheus让LLM涌现出人类情感!在A100 40GB显卡上,30亿参数模型的流式推理速度甚至超过了音频播放速度。甚至可以zero-shot克隆声音。

虽然扩散模型在视频生成领域展现出了卓越的性能,但是视频扩散模型通常需要大量的推理步骤对高斯噪声进行去噪才能生成一个视频。这个过程既耗时又耗计算资源。例如,HunyuanVideo [1] 需要 3234 秒才能在单张 A100 上生成 5 秒、720×1280、24fps 的视频。

来自国内的光电混合芯片技术,登上最新顶刊Nature!

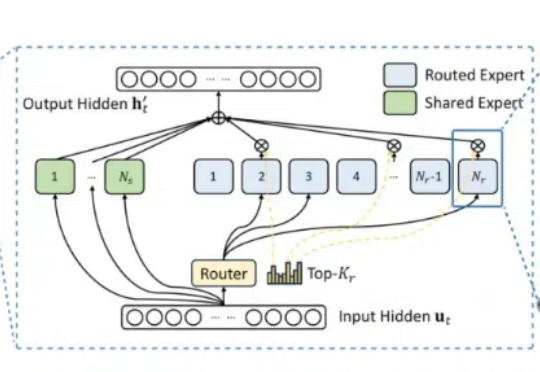

通过完全启用并发多块执行,支持任意专家数量(MAX_EXPERT_NUMBER==256),并积极利用共享内存(5kB LDS)和寄存器(52 VGPRs,48 SGPRs),MoE Align & Sort逻辑被精心设计,实现了显著的性能提升:A100提升3倍,H200提升3倍,MI100提升10倍,MI300X/MI300A提升7倍...

在算力投资激增的当下,GPU卡回收与维修行业逐渐成为一条隐秘的暴利赛道。特别是一些众所周知的原因,串串资源的货源和魔改卡的维保是重灾区! 现状:运营一年以上的算力中心运营商手里一定有坏掉的A100和H100服务得不到及时维修,放在那吃灰,无法对外出租算力产生收入。

满血版DeepSeek R1部署A100,基于INT8量化,相比BF16实现50%吞吐提升! 美团搜推机器学习团队最新开源,实现对DeepSeek R1模型基本无损的INT8精度量化。

全球有多少AI算力?算力增长速度有多快?在这场AI「淘金热」中,都有哪些新「铲子」?AI初创企业Epoch AI发布了最新全球硬件估算报告。

由无问芯穹与上海交通大学联合研究团队提出的视频生成软硬一体加速器,首次实现通过差分近似和自适应数据流解决 VDiT 生成速度缓慢瓶颈,推理速度相比 A100 提升高达 16.44 倍。