从大厂产品经理到英语老师,这8个AI实战分享刷新了我对Vibe Coding的认知|AIDONE 开放麦

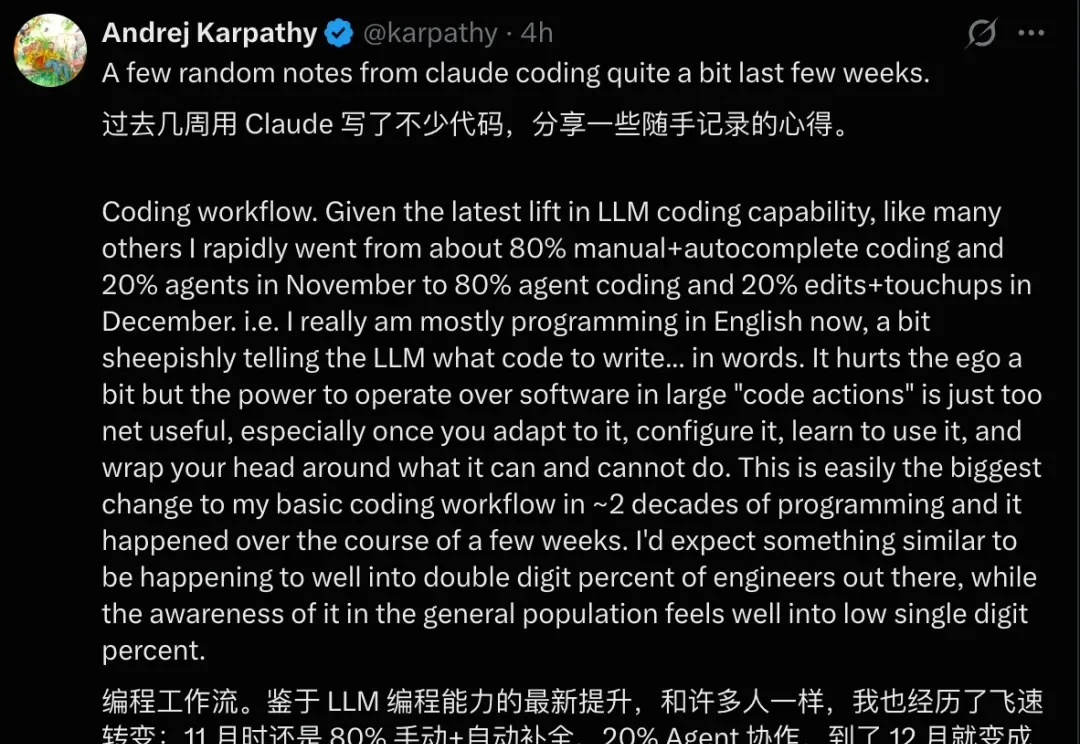

从大厂产品经理到英语老师,这8个AI实战分享刷新了我对Vibe Coding的认知|AIDONE 开放麦最近,OpenAI 创始成员 Andrej Karpathy 在推特上分享了他使用 Claude 进行数周高强度编程后的感受。

最近,OpenAI 创始成员 Andrej Karpathy 在推特上分享了他使用 Claude 进行数周高强度编程后的感受。

大模型的出现,给许多行业带来了颠覆性的改变,运维这个向来被视为稳定、保守的领域也不例外。虽然“AIOps”这个概念早在 2016 年由 Gartner 提出,但早期的智能运维更多是利用大数据和机器学习对传统运维流程进行效率上的提升。

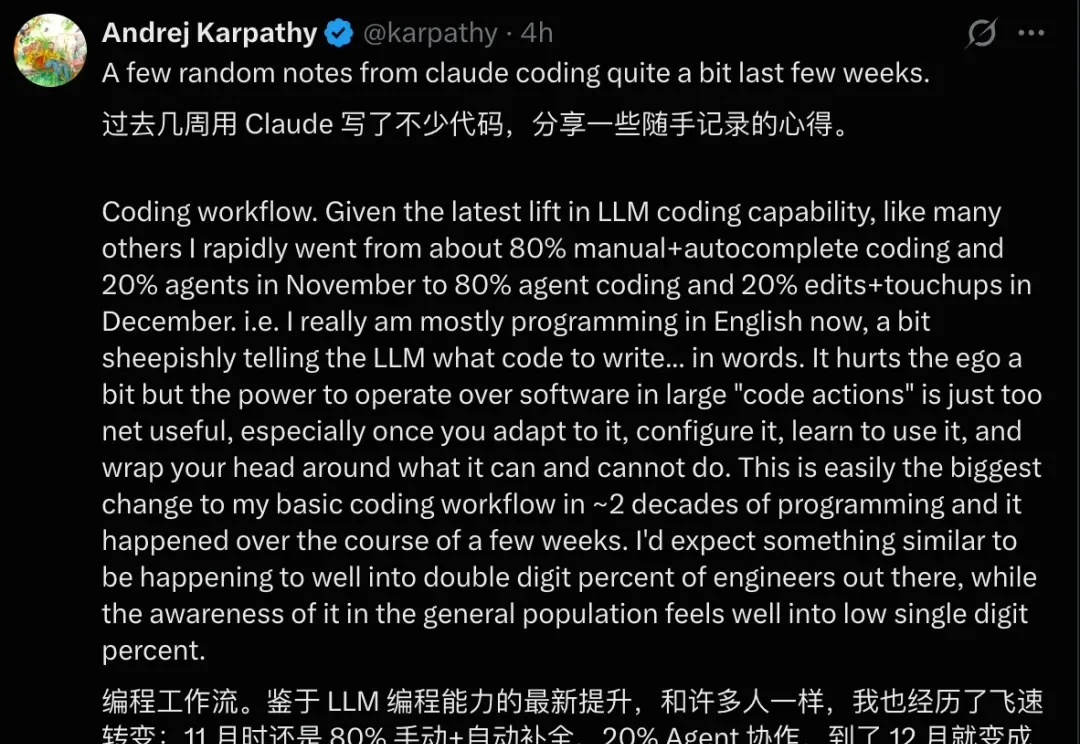

扩散语言模型(Diffusion LLMs, dLLMs)因支持「任意顺序生成」和并行解码而备受瞩目。直觉上,打破传统自回归(AR)「从左到右」的束缚,理应赋予模型更广阔的解空间,从而在数学、代码等复杂任务上解锁更强的推理潜力。

AI Coding的魔力究竟有多大?

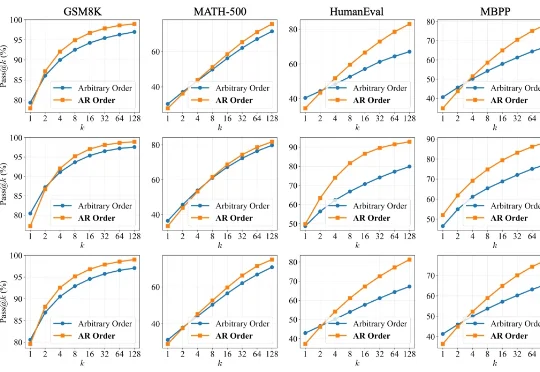

如果你关注前端或 AI 圈,这几天一定被 Vercel 最新开源的 json-render 刷屏了。

10人团队,人均“00后”,ARR在2025年下半年已超过100万美元。

AI能帮你写法律文书,但它也可能帮你编造6个根本不存在的判例。

我们都在System Prompt里写过无数次 You are a helpful assistant,但你是否想过:这行文字在模型的残差流(Residual Stream)中究竟对应着怎样的几何结构?

Anthropic 掌门人 Dario Amodei 发布核弹级预警:2027 年,人类将迎来「技术成年礼」。两万字长文冷静剖析AI失控、生物恐怖、极权统治及经济颠覆五大危机,拒绝末世论;提出以「宪法AI」、管制与民主协作构建防线,呼吁人类以勇气通过这场文明的「成年礼」。

用多样化的任务与公开透明的机制,堵上具身大模型刷榜的捷径。