首帧的真正秘密被揭开了:视频生成模型竟然把它当成「记忆体」

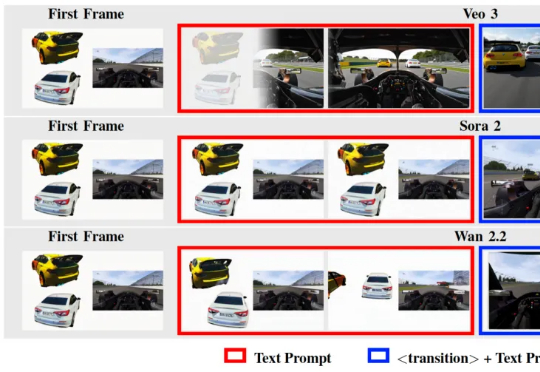

首帧的真正秘密被揭开了:视频生成模型竟然把它当成「记忆体」在 Text-to-Video / Image-to-Video 技术突飞猛进的今天,我们已经习惯了这样一个常识: 视频生成的第一帧(First Frame)只是时间轴的起点,是后续动画的起始画面。

在 Text-to-Video / Image-to-Video 技术突飞猛进的今天,我们已经习惯了这样一个常识: 视频生成的第一帧(First Frame)只是时间轴的起点,是后续动画的起始画面。

作者在包含 50 多个任务的多个仿真和真实世界场景中评估了 SpatialActor。它在 RLBench 上取得了 87.4% 的成绩,达到 SOTA 水平;在不同噪声条件下,性能提升了 13.9% 至 19.4%,展现出强大的鲁棒性。目前该论文已被收录为 AAAI 2026 Oral,并将于近期开源。

DeepWisdom研究团队提出:视频生成模型不仅能画画,更能推理。 为了验证这一观点,团队推出了VR-Bench——这是首个通过迷宫任务评估视频模型空间推理(spatial reasoning)能力的基准测试

Anthropic发布了Programmatic Tool Calling(PTC)特性,让Claude通过代码编排工具执行,降低token消耗、减少延迟并提升准确性。

想象一下这个场景: 一个寂静的深夜,你满怀期待对游戏里的AI说:“去睡觉吧”,它却径直走向餐厅,在椅子坐下了;你再次尝试:“帮我暖一下被窝?”它用合成语音温柔地回应“好的”,身体却僵在洗手间,纹丝不动。

AI 创业卷出新高度,AI 都可以自己设计芯片了。

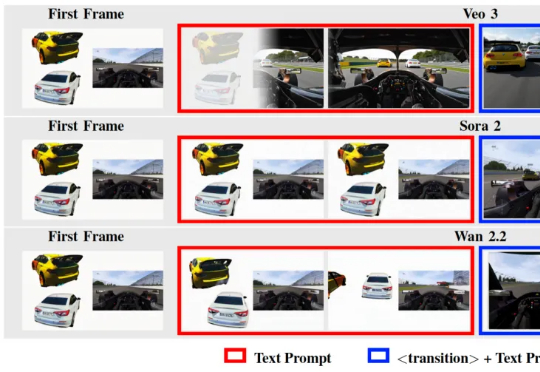

天才少年用AI日筛十亿分子!奥特曼恩师支招:不买模型卖授权。

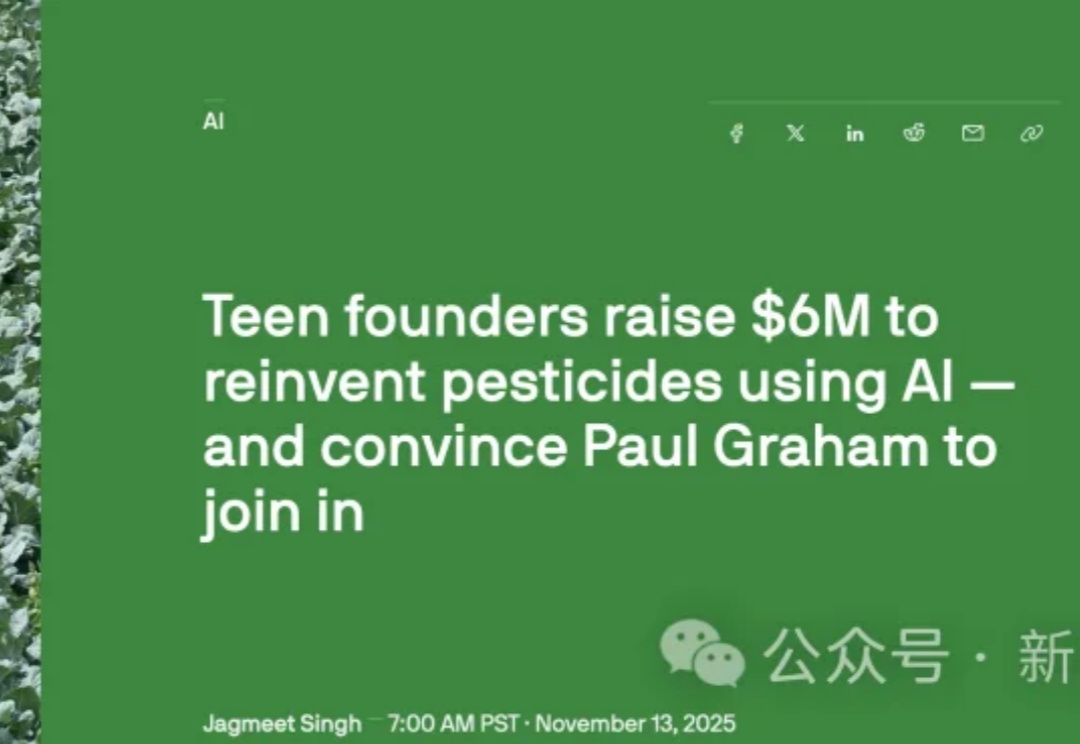

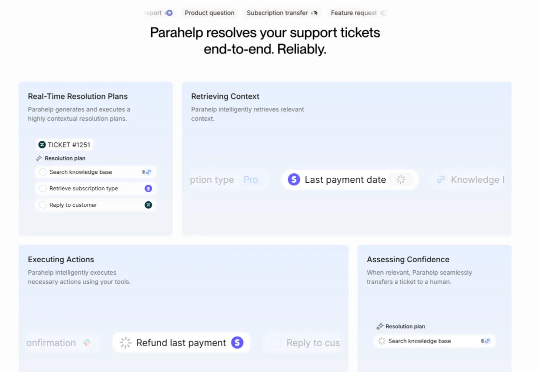

最近,这家由两位丹麦年轻创始人打造的公司宣布完成了 1800 万美元的 A 轮融资,由 Alt Capital 的 Jack Altman 领投。加上此前 320 万美元的种子轮,Parahelp 总共融资超过 2100 万美元。更有意思的是,他们的客户流失率为零。是的,你没看错,零流失率。在 SaaS 领域,这几乎是不可能完成的任务。这让我非常好奇:他们到底做对了什么?

就在前天,DeepSeek 一口气上新了两个新模型,DeepSeek-V3.2 和 DeepSeek-V3.2-Speciale。

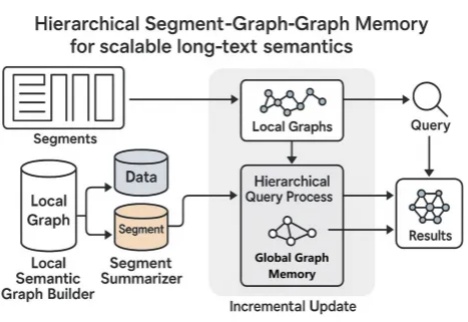

当你阅读《红楼梦》《哈利·波特》《百年孤独》等长篇小说时,读着读着可能就忘记前面讲了什么,有时还会搞混人物关系。AI 在阅读长文章的时候也存在类似问题,当文章太长时它也会卡主,要么读得特别慢,要么记不住前面的内容。