MiniMax创始人闫俊杰:AI正进化为更强的生产力

MiniMax创始人闫俊杰:AI正进化为更强的生产力MiniMax的展台上,主要对外展示的也是MiniMax Agent、海螺AI、MiniMax Audio、星野等AI应用产品,包括智慧家居、穿戴设备、智能座舱、智能音响、智能耳机及交互设备等AI智能硬件产品,以及文旅、电商、办公、教育、游戏、医疗、金融等领域应用。

MiniMax的展台上,主要对外展示的也是MiniMax Agent、海螺AI、MiniMax Audio、星野等AI应用产品,包括智慧家居、穿戴设备、智能座舱、智能音响、智能耳机及交互设备等AI智能硬件产品,以及文旅、电商、办公、教育、游戏、医疗、金融等领域应用。

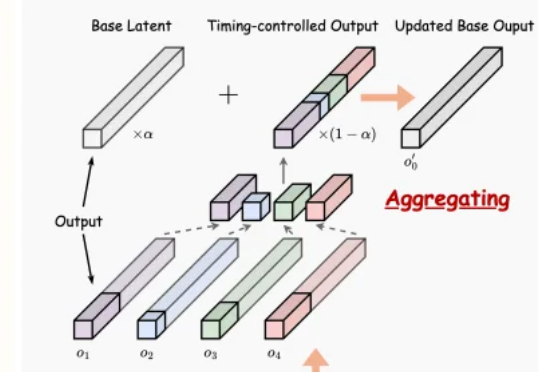

文生音频系统最新突破,实现精确时间控制与90秒长时音频生成!

今天咱们再聊聊TTS(文本转语音)这个话题。4月份给大家分享了MiniMax的TTS平台:MiniMax Audio当时我直呼它是最强中文TTS,那篇反响还不错,主要他们Speech-02-HD的效果确实NB

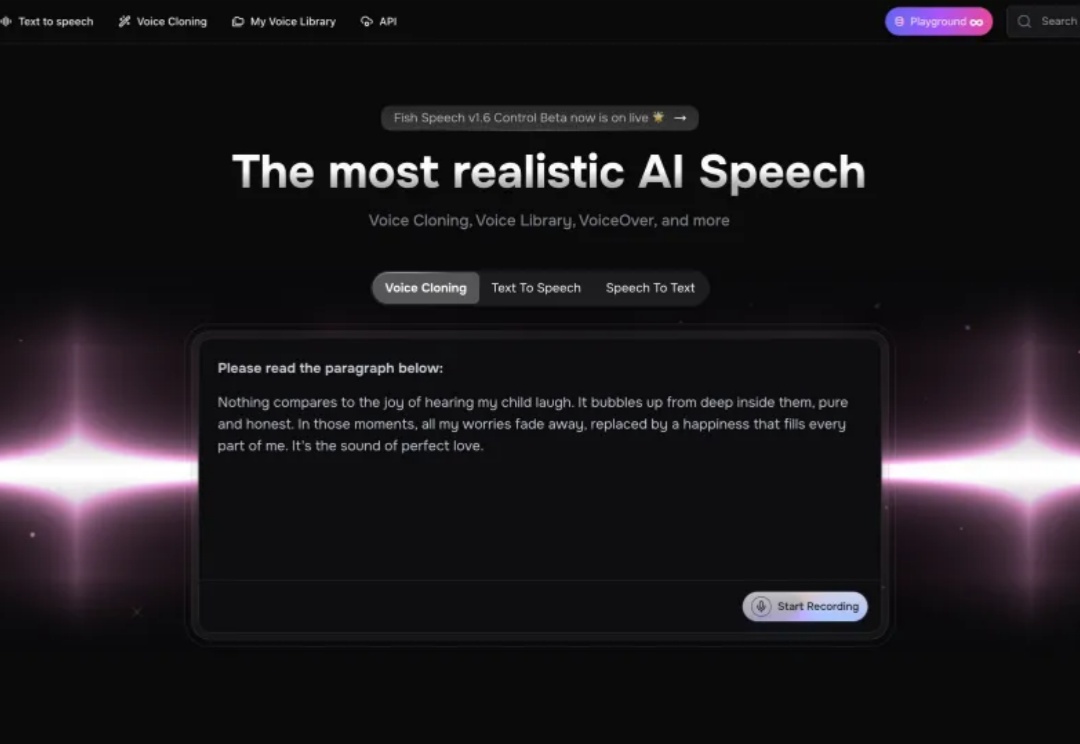

从电话录音机到播客,从语音助手到虚拟主播,语音技术在过去几十年里经历了从“工具型服务”向“内容型产品”的演化。大模型的快速崛起让语音技术的发展进入了一个新的跃迁周期,人们对语音产品的期待从听懂”内容“逐渐跃迁到听懂”情绪“。

首个专为ALLMs(音频大语言模型)设计的多维度可信度评估基准来了。

AI 初创公司 Stability AI 发布了名为 Stable Audio Open Small 的“立体声”音频生成 AI 模型,该公司宣称这是市场上速度最快的模型,且效率高到足以在智能手机上运行。

空间音频,作为一种能够模拟真实听觉环境的技术,正逐渐成为提升沉浸式体验的关键。

六边形战士来了。

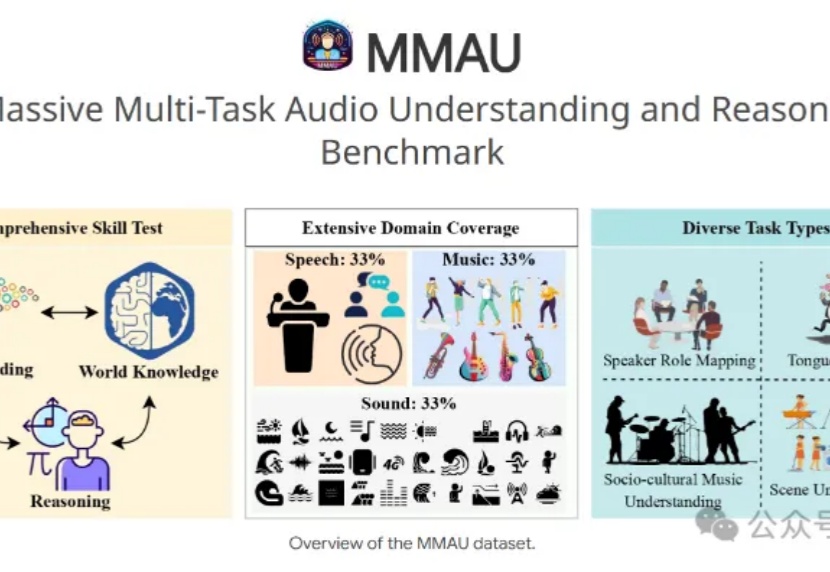

7B小模型+3.8万条训练数据,就能让音频理解和推断评测基准MMAU榜单王座易主?

刚刚,阶跃星辰联合吉利汽车集团,开源了两款多模态大模型!新模型共2款:全球范围内参数量最大的开源视频生成模型Step-Video-T2V行业内首款产品级开源语音交互大模型Step-Audio多模态卷王开始开源多模态模型,其中Step-Video-T2V采用的还是最为开放宽松的MIT开源协议,可任意编辑和商业应用。