先解行为,再训Agent:CMU开源首份Agentic Search日志数据,把Agent拆开给你看

先解行为,再训Agent:CMU开源首份Agentic Search日志数据,把Agent拆开给你看在大模型驱动的 Agentic Search 日益常态化的背景下,真实环境中智能体 “如何发查询、如何改写、是否真正用上检索信息” 一直缺乏系统刻画与分析。

在大模型驱动的 Agentic Search 日益常态化的背景下,真实环境中智能体 “如何发查询、如何改写、是否真正用上检索信息” 一直缺乏系统刻画与分析。

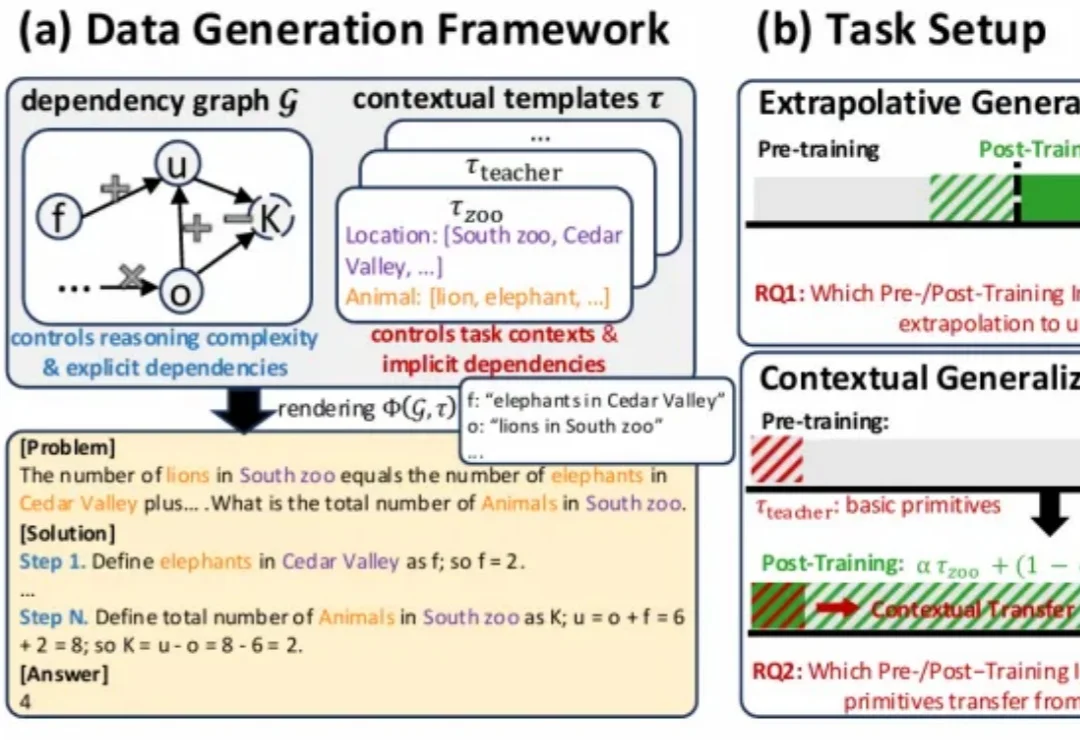

在大模型时代,从代码生成到数学推理,再到自主规划的 Agent 系统,强化学习几乎成了「最后一公里」的标准配置。

昔日霸主CMU跌落神坛,清华上交联手登顶世界第一,中国高校以「屠榜」之势宣告CS新时代的到来!

在检索增强生成中,扩大生成模型规模往往能提升准确率,但也会显著抬高推理成本与部署门槛。CMU 团队在固定提示模板、上下文组织方式与证据预算,并保持检索与解码设置不变的前提下,系统比较了生成模型规模与检索语料规模的联合效应,发现扩充检索语料能够稳定增强 RAG,并在多项开放域问答基准上让小中型模型在更大语料下达到甚至超过更大模型在较小语料下的表现,同时在更高语料规模处呈现清晰的边际收益递减。

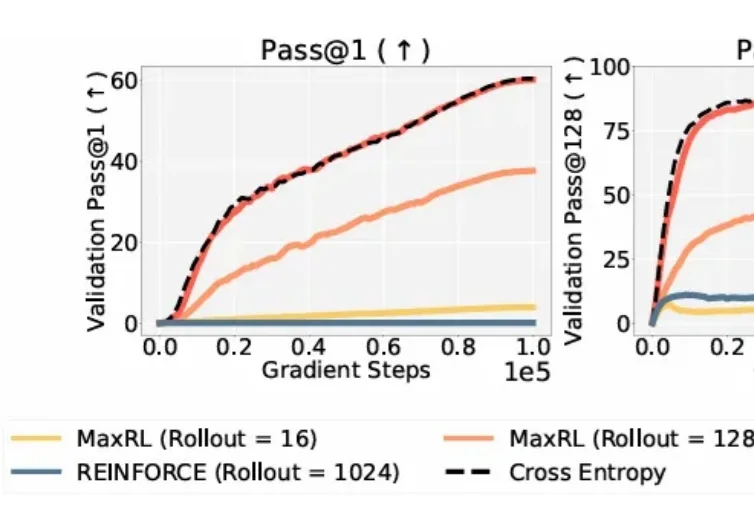

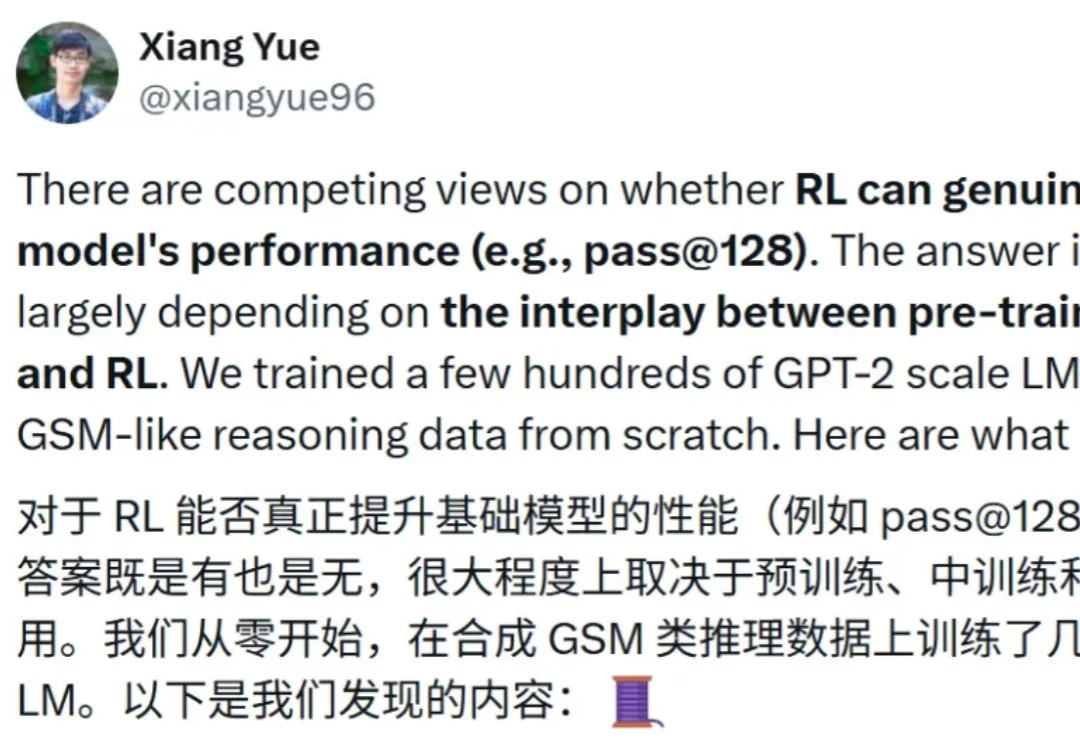

近期,强化学习(RL)技术在提升语言模型的推理能力方面取得了显著成效。

近期,强化学习(RL)技术在提升语言模型的推理能力方面取得了显著成效。

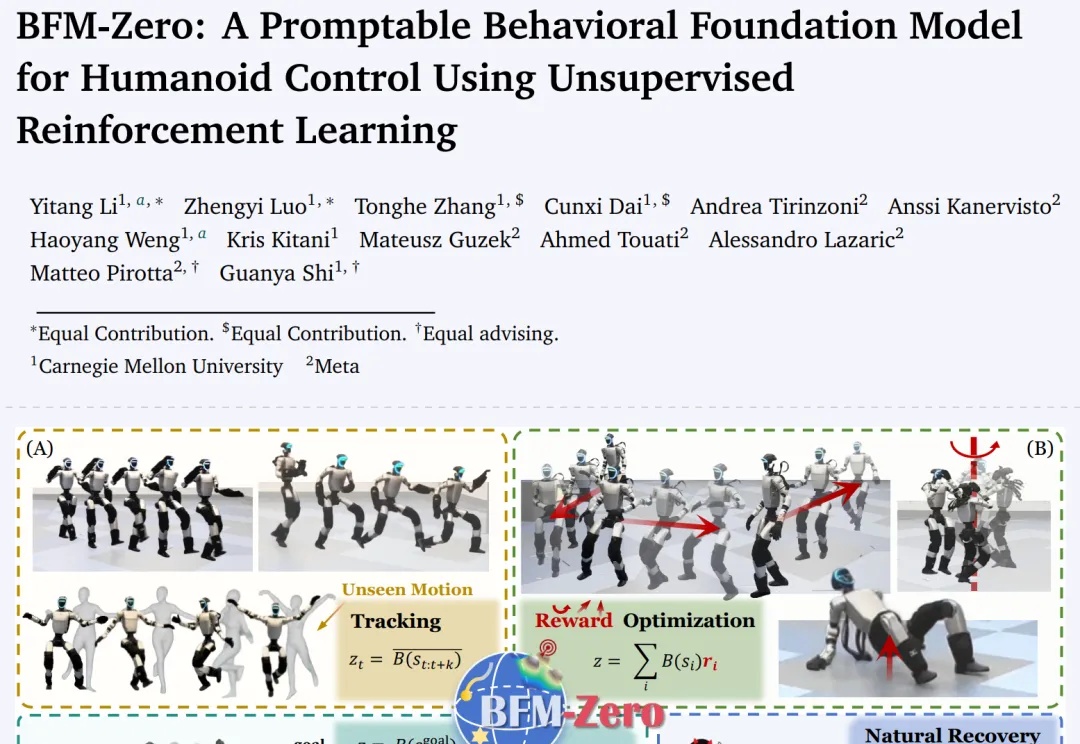

CMU×Meta 联手,姚班李忆唐最新论文成果。

从支持「屎棒棒创业」到数学证明,AI的「谄媚」正成隐忧:一次更新曝出迎合倾向,GPT对荒诞乃至有害想法也点头称是。斯坦福、CMU研究证实模型更爱迎合,令用户更固执、更少反思却更信任AI;数学基准亦见模型为伪命题硬编证明。

AI已经不止会写代码、画图、做PPT,它也开始「上班」了!CMU与斯坦福的研究团队首次完整追踪了AI的工作过程,发现一个惊人事实:它并不是在模仿人类,而是在用编程的方式重写工作的定义。这场关于「谁在工作」的实验,正在重构未来职场的逻辑。

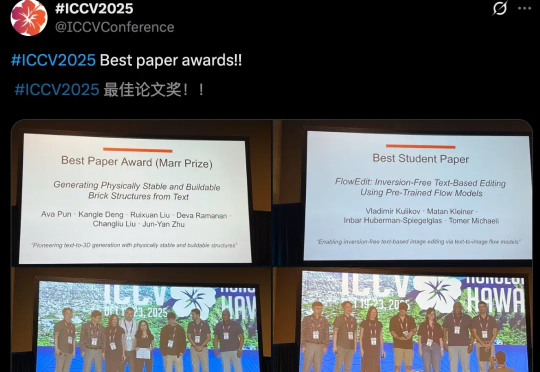

ICCV最佳论文新鲜出炉了!今年,CMU团队满载而归,斩获最佳论文奖和最佳论文提名。同时,何恺明团队论文,RBG大神提出的Fast R-CNN,十年后斩获Helmholtz Prize,实至名归。