大厂芯片业务前负责人创业AI CPU,拿下头部基金融资,已量产出货15万颗

大厂芯片业务前负责人创业AI CPU,拿下头部基金融资,已量产出货15万颗近日,基于RISC-V架构研发和销售下一代AI CPU芯片的企业「进迭时空」完成数亿元B轮融资,我们总结了本轮融资信息和该公司几大亮点:

近日,基于RISC-V架构研发和销售下一代AI CPU芯片的企业「进迭时空」完成数亿元B轮融资,我们总结了本轮融资信息和该公司几大亮点:

英伟达正通过重磅布局服务器CPU领域,进一步巩固其在AI基础设施市场的统治地位。

在生成式AI(GenAI)的推动下,2025年标志着行业从“震撼期”正式步入“深水区”。这并非资本的泡沫,而是计算范式从CPU向GPU的根本性迁移——数据中心正进化为实时生产智能的“AI工厂”。相比于模型参数的单纯竞赛,AI应用带来的“任务执行”能力与直观体验,让人切身感受到从“信息检索”向“智能生成”的范式跃迁。

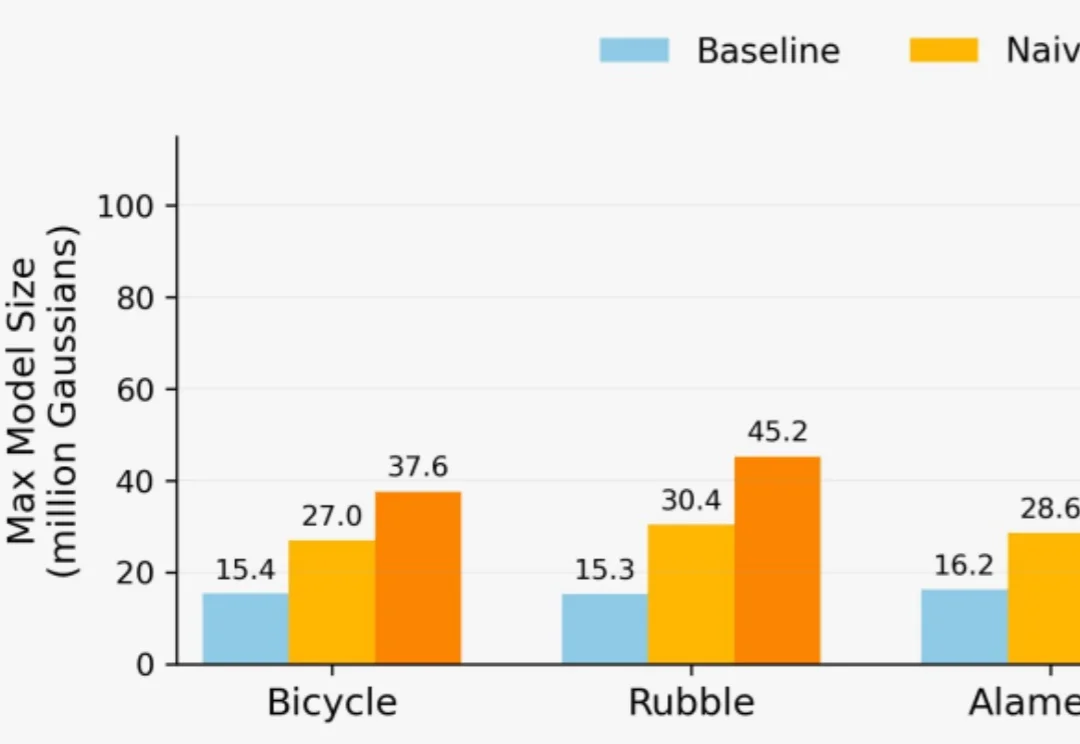

想用3D高斯泼溅(3DGS)重建一座城市?

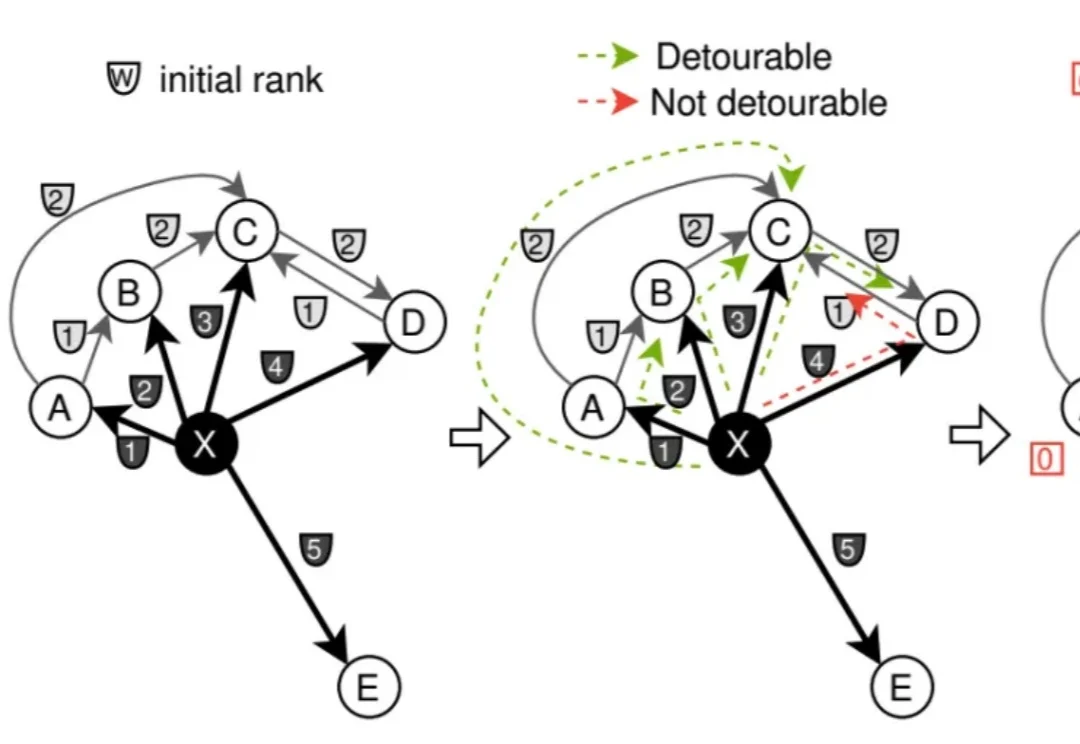

本文为Milvus Week系列第5篇,该系列旨在把Zilliz团队过去半年多积累的先进的技术实践和创新整理成多篇干货深度文章发布。

AI 浪潮席卷全球,但算力功耗的 “电费焦虑” 也随之而来。传统冯・诺依曼架构下,数据在 CPU 和内存间 “疲于奔命”,消耗了大量能量。

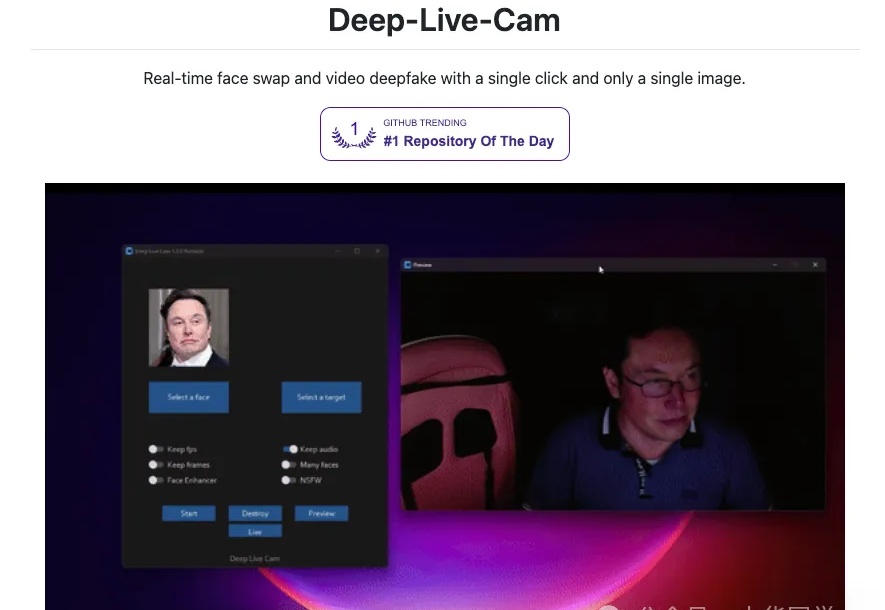

Deep-Live-Cam 是一款开源的实时换脸与视频深度伪造(deepfake)工具,只需要一张人脸图片,就能在本地电脑上对摄像头画面或视频进行实时换脸。 支持 Windows / Linux / macOS,多种硬件加速(CPU / CUDA / CoreML / DirectML / OpenVINO),并内置不良内容检测与合规提示,定位是服务 AI 生成媒体行业的高效生产力工具。

就在今天,OpenAI 与 AWS 官宣建立多年的战略合作伙伴关系。OpenAI 将立即并持续获得 AWS 世界级的基础设施支持,以运行其先进的 AI 工作负载。 AWS 将向 OpenAI 提供配备数十万颗芯片的 Amazon EC2 UltraServers(计算服务器),并具备将计算规模扩展至数千万个 CPU 的能力,以支持其先进的生成式 AI 任务

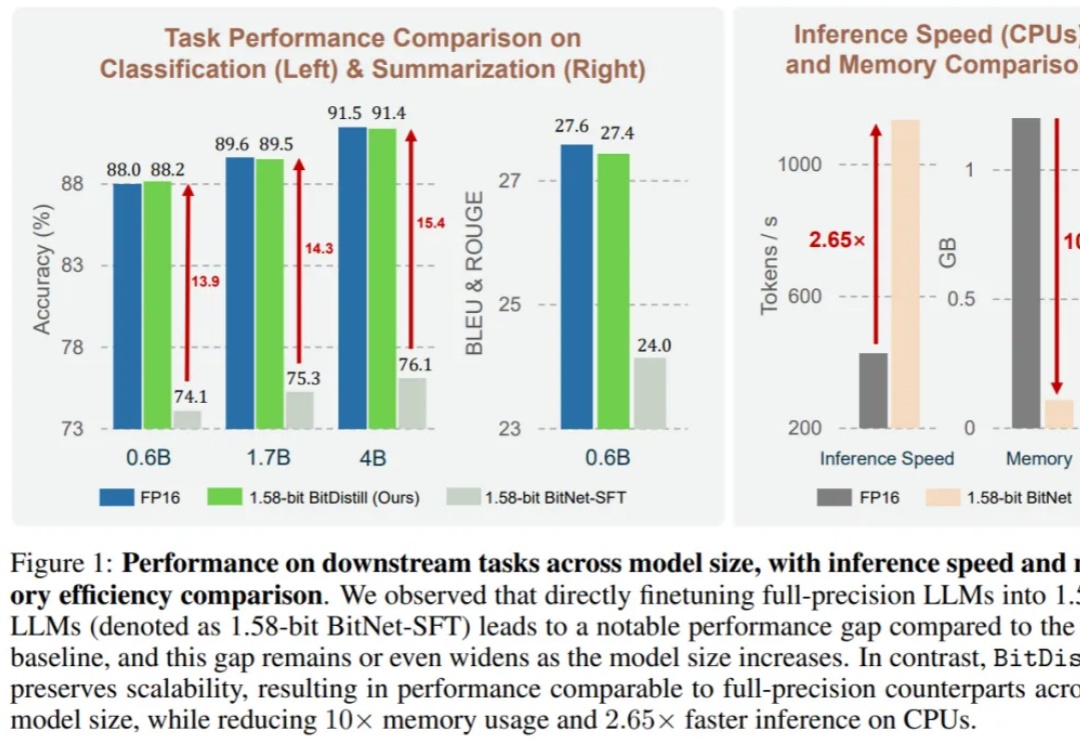

大语言模型(LLM)不仅在推动通用自然语言处理方面发挥了关键作用,更重要的是,它们已成为支撑多种下游应用如推荐、分类和检索的核心引擎。尽管 LLM 具有广泛的适用性,但在下游任务中高效部署仍面临重大挑战。

刚刚,芯片圈大地震,英伟达将斥资50亿美元入股英特尔,一举成为大股东!英伟达出钱,英特尔出力!英特尔将为英伟达定制AI数据中心所需的x86 CPU,未来还将推出集成英伟达GPU的系统级芯片。