Bye,英伟达!华为NPU,跑出了准万亿参数大模型

Bye,英伟达!华为NPU,跑出了准万亿参数大模型现在,跑准万亿参数的大模型,可以彻底跟英伟达Say Goodbye了。

现在,跑准万亿参数的大模型,可以彻底跟英伟达Say Goodbye了。

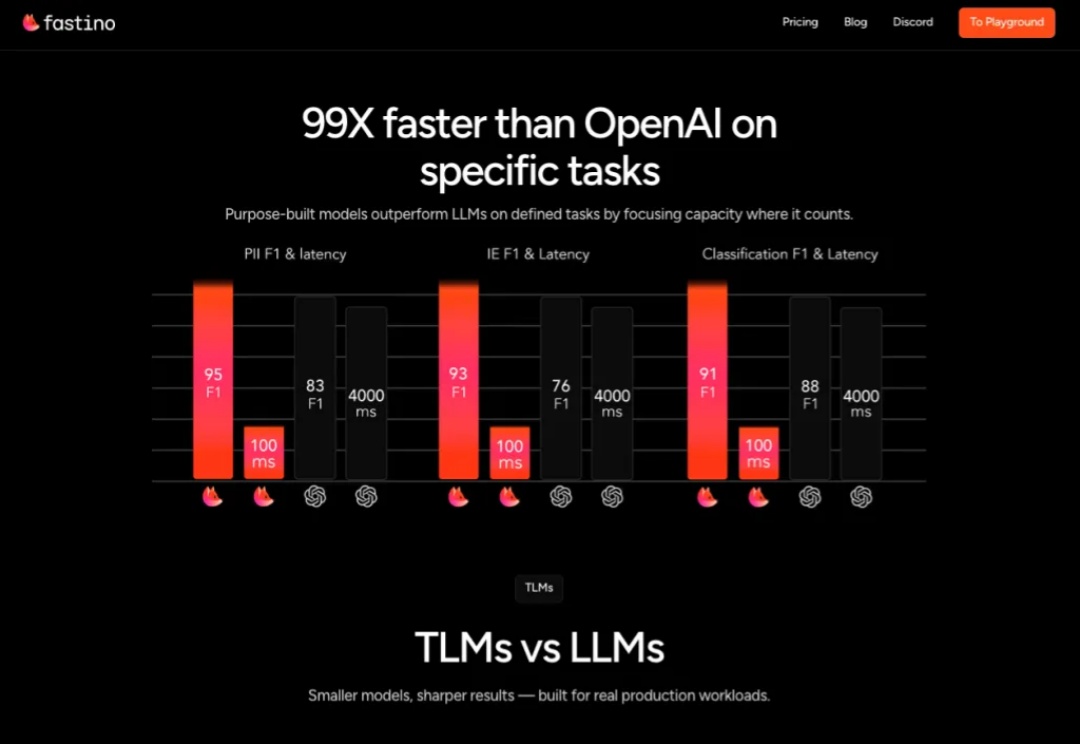

科技巨头常吹嘘需要庞大昂贵GPU 集群的万亿参数 AI 模型,但 Fastino 正采取截然不同的策略

官宣!英伟达RTX 5060显卡发售时间定了。

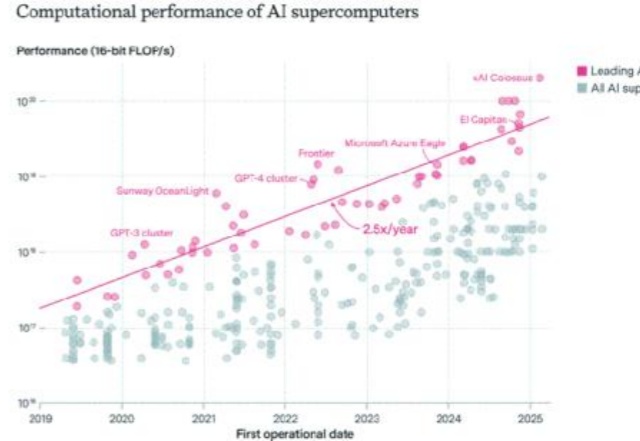

AI超算性能、电力、成本激增,美国主导。

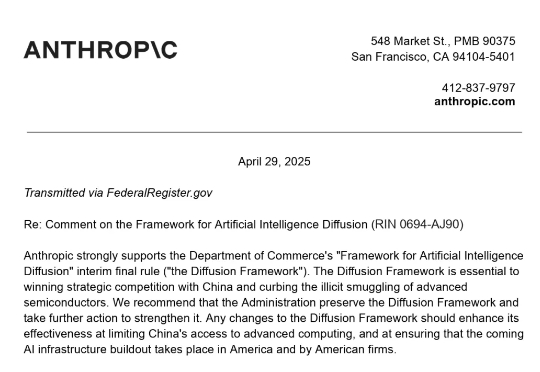

近日,美国 AI 初创公司 Anthropic(Claude 背后公司)就美国商务部的《人工智能扩散框架》临时最终规则提交意见书,呼吁加强对高端AI 芯片的出口控制。更具争议性的是,Anthropic 在博客中声称,中国已建立起高度成熟的芯片走私网络,涉及金额高达数亿美元。

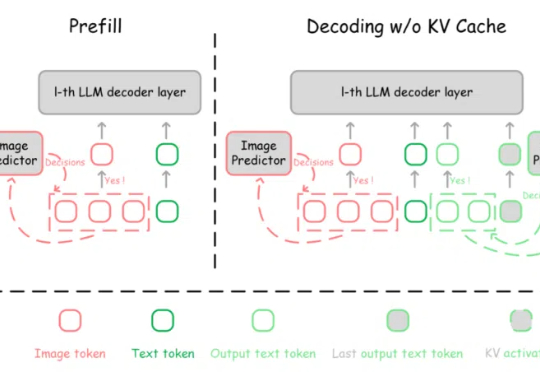

多模态大模型(MLLMs)在视觉理解与推理等领域取得了显著成就。然而,随着解码(decoding)阶段不断生成新的 token,推理过程的计算复杂度和 GPU 显存占用逐渐增加,这导致了多模态大模型推理效率的降低。

LLM的规模爆炸式增长,传统量化技术虽能压缩模型,却以牺牲精度为代价。莱斯大学团队的最新研究DFloat11打破这一僵局:它将模型压缩30%且输出与原始模型逐位一致!更惊艳的是,通过针对GPU的定制化解压缩内核,DFloat11使推理吞吐量提升最高38.8倍。

就在刚刚,美国政府曝光了各界对「AI行动计划」的全部政策建议。OpenAI措辞激烈地表示,DeepSeek让我们看到,必须马上锁死中国AI,必须限制高端GPU芯片和模型权重流向中国!Anthropic同样呼吁:必须立马补上H20这一关键漏洞,并且严控H100的门槛。

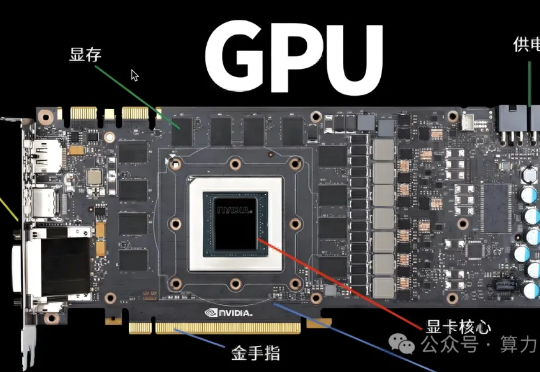

高端Ai服务器定义,满足以下2个条件:条件1.卡间互联,条件2.显存HBM。以H100为例子,不同的设备比如H100或者H20 为啥差别很大,主要是因为配置不同,成本差别10~20w,所以有差别!

,2025年,大模型计算效率的提升并未给AI基建按下暂停键,微软、亚马逊、谷歌、Meta四大科技巨头2025年在AI技术与数据中心的资本支出将达3200亿美元(约合人民币2.33万亿元);OpenAI、软银等企业总投资5000亿美元(约合人民币3.66万亿元)的“星际之门”项目也已动工。在这波AI大基建浪潮中,提供硬件与算力服务的“卖铲人”们正赚得盆满钵满。