Llama3.1根本卖不动!业内人士:开源模型成本反而更高

Llama3.1根本卖不动!业内人士:开源模型成本反而更高Meta的开源大模型Llama 3在市场上遇冷,进一步加剧了大模型开源与闭源之争的关注热度。

来自主题: AI资讯

10433 点击 2024-08-27 14:08

Meta的开源大模型Llama 3在市场上遇冷,进一步加剧了大模型开源与闭源之争的关注热度。

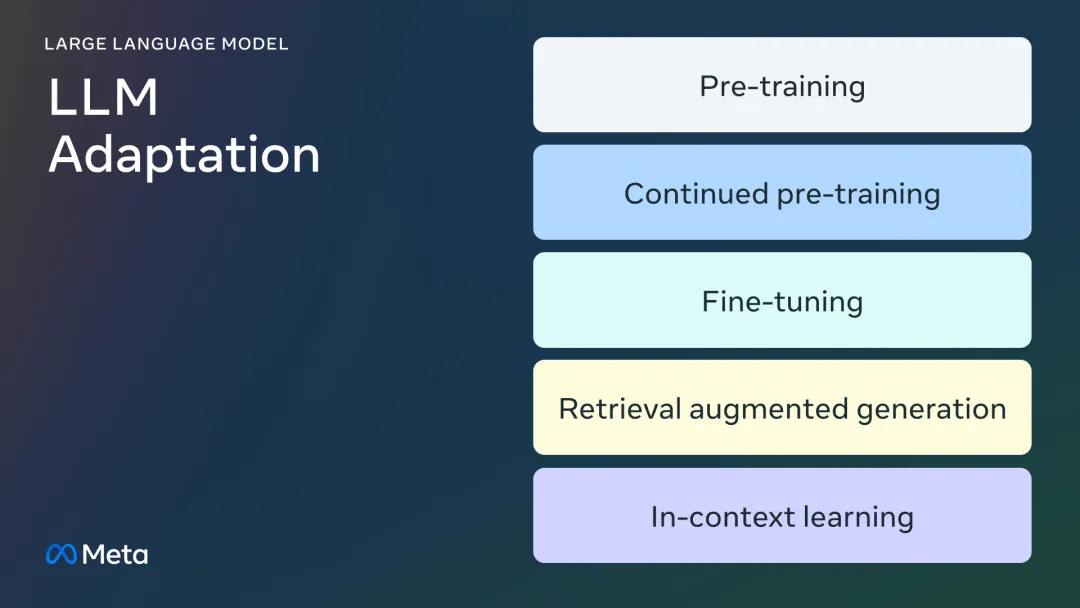

微调的所有门道,都在这里了。

随着LLM不断迭代,偏好和评估数据中大量的人工标注逐渐成为模型扩展的显著障碍之一。Meta FAIR的团队最近提出了一种使用迭代式方法「自学成才」的评估模型训练方法,让70B参数的Llama-3-Instruct模型分数超过了Llama 3.1-405B。

人自信的时候,说话都会变得坦率很多。

Meta加强推广Llama模型,谋求AI市场领导

微软Phi 3.5系列上新了!mini模型小而更美,MoE模型首次亮相,vision模型专注多模态。

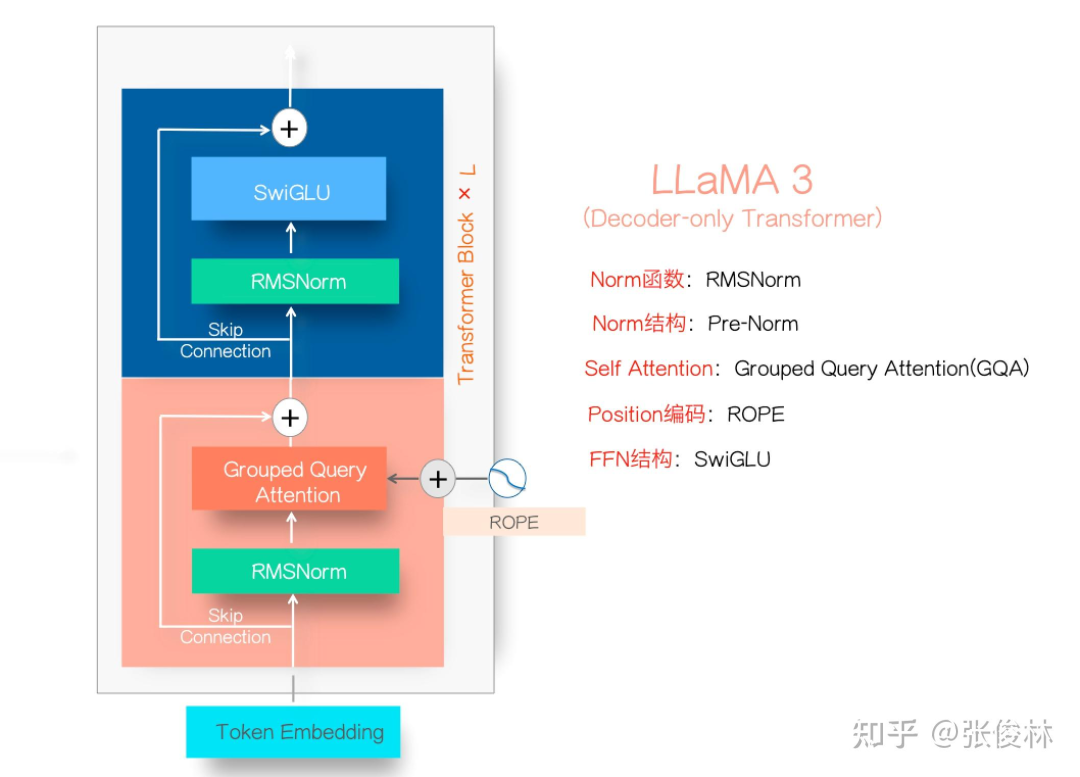

Llama3.1系列模型的开源,真让大模型格局大震,指标上堪比最好的闭源模型比如GPT 4o和Claude3.5,让开源追赶闭源成为现实。

小模型崛起了。

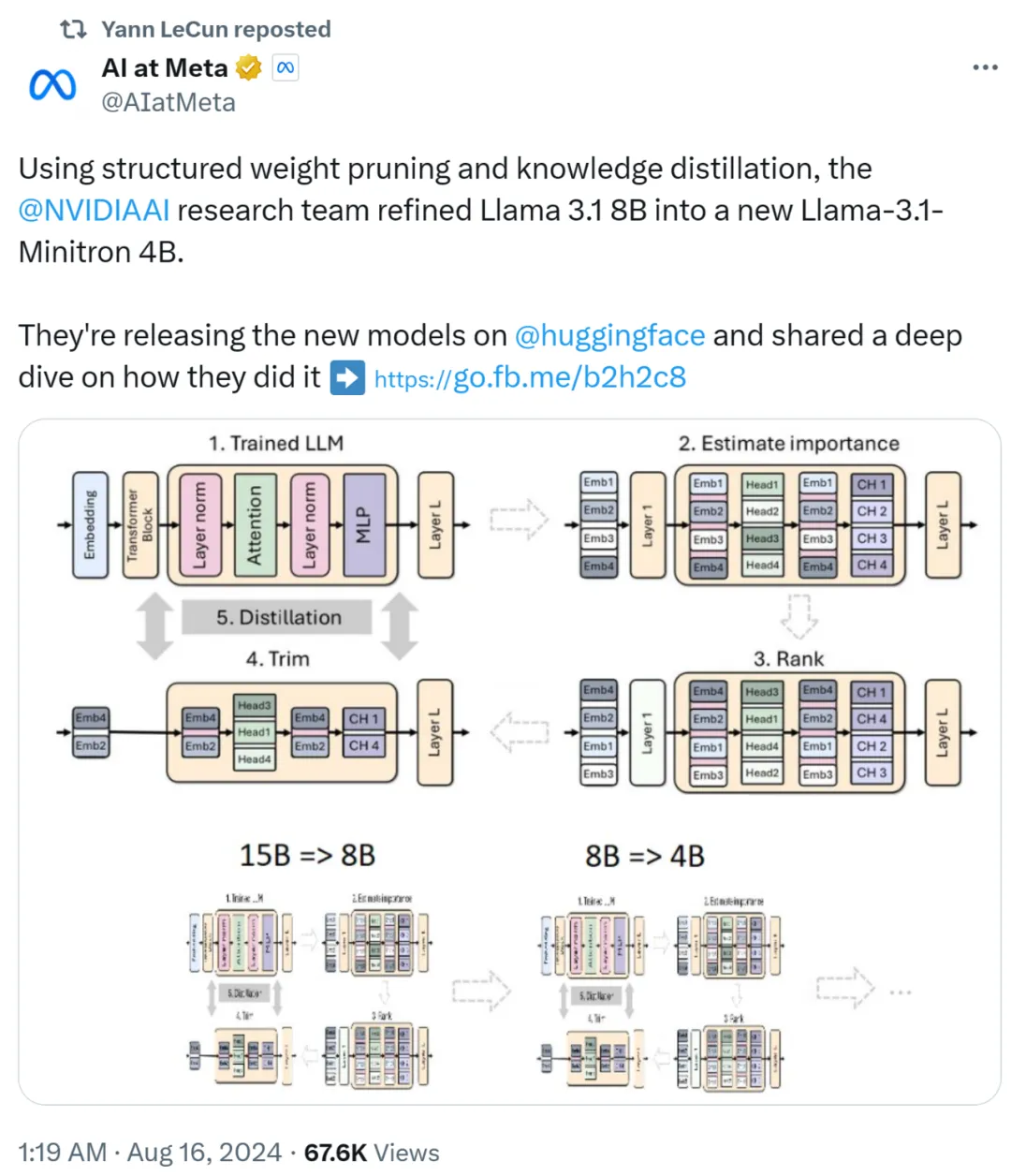

发布40天后,最强开源模型Llama 3.1 405B等来了微调版本的发布。但不是来自Meta,而是一个专注于开放模型的神秘初创Nous Research。

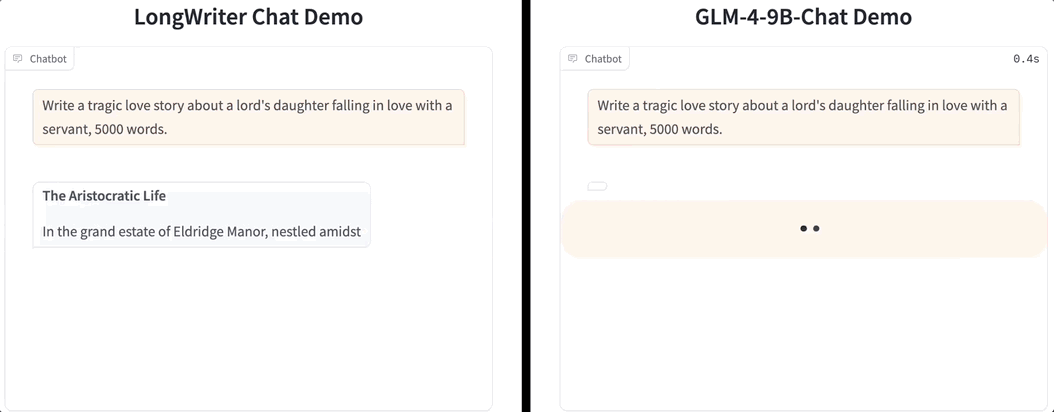

一口气生成2万字,大模型输出也卷起来了!