清华数学系大神跳槽OpenAI!曾主导SAM与Llama开发,Sora负责人:欢迎加入

清华数学系大神跳槽OpenAI!曾主导SAM与Llama开发,Sora负责人:欢迎加入刚刚,毕业清华大学数学系,曾在Meta FAIR工作3.75年、主导过SAM与Llama多项核心工作的研究员张鹏川(Pengchuan Zhang)宣布离职。他的下一站,是来到OpenAI,投身于世界模拟与机器人学(World Simulation and Robotics)方向的研究。

刚刚,毕业清华大学数学系,曾在Meta FAIR工作3.75年、主导过SAM与Llama多项核心工作的研究员张鹏川(Pengchuan Zhang)宣布离职。他的下一站,是来到OpenAI,投身于世界模拟与机器人学(World Simulation and Robotics)方向的研究。

刚刚推出的一款最新芯片,直接冲上硅谷热榜。峰值推理速度高达每秒17000个token。什么概念呢?当前公认最强的Cerebras,速度约为2000 token/s。 速度直接快10倍,同时成本骤减20倍、功耗降低10倍。

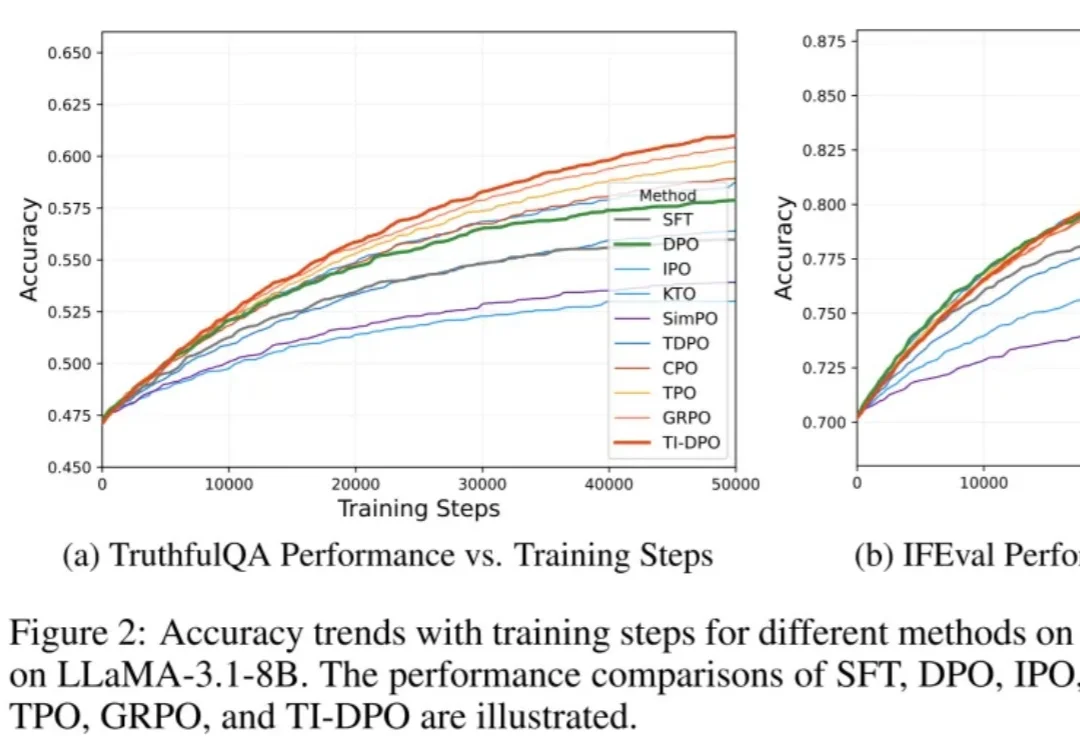

在当今的大模型后训练(Post-training)阶段,DPO(直接偏好优化) 凭借其无需训练独立 Reward Model 的优雅设计和高效性,成功取代 PPO 成为业界的 「版本之子」,被广泛应用于 Llama-3、Mistral 等顶流开源模型的对齐中。

Clawdbot火爆全球,国产算力却不能用?AI Agent迎来高光时刻:Ollama只支持CUDA,中国团队直接把国产版开源了!正面硬刚Ollama,5分钟让国产芯片跑通OpenClaw!

路透社最新消息,Meta 新成立的 AI 团队本月已在内部交付了首批关键模型。据悉,该消息来自 Meta 公司的 CTO Andrew Bosworth,他表示该团队的 AI 模型「非常好」(very good)。

中国顶级模型全面崛起,Llama迷失,OpenAI失去领先地位。

从救火Llama 4反被裁,再到如今下场自创业,AI大佬田渊栋回顾了2025年一些重要时刻。

图灵奖大佬LeCun离职Meta后直接开怼:实锤Llama4造假传闻,炮轰原上司Alexandr Wang「不懂科研」,称Meta冲刺「超级智能」完全是被大模型洗脑。同时,他也透露自己的新公司即将在今年发布全新世界模型。

面对Llama3系列的失利,小扎将2025年定义为Meta的「高强度之年」,不仅在AI上投入数百亿美金,还开启一系列「闪电战」,包括重金挖人、成立MSL、收紧绩效考核,削减元宇宙投入等。年关将近,小扎的「高强度之年」能救Meta吗?

本该绽放的Llama 4黯然失色,Meta内部地震频发:首席AI科学家离职、600人裁员、顶级大佬空降、开源战略转向。最新模型Avocado被曝延期且套壳Qwen,扎克伯格如何在对手狂飙中绝地反击?