Meta「透视」AI思维链:CRV推理诊断,准确率达 92%!

Meta「透视」AI思维链:CRV推理诊断,准确率达 92%!在最近一篇来自Meta FAIR团队的论文里,研究者找到了一种前所未有的方式——他们能实时看到AI的思考过程。这项名为CRV的方法,通过替换模型内部的MLP模块,让每一步推理都变得「可见」。这不是隐喻,而是可量化的现象。Meta用它让错误检测精度提升到92.47%,也让人类第一次得以窥见AI是怎么想错的。

在最近一篇来自Meta FAIR团队的论文里,研究者找到了一种前所未有的方式——他们能实时看到AI的思考过程。这项名为CRV的方法,通过替换模型内部的MLP模块,让每一步推理都变得「可见」。这不是隐喻,而是可量化的现象。Meta用它让错误检测精度提升到92.47%,也让人类第一次得以窥见AI是怎么想错的。

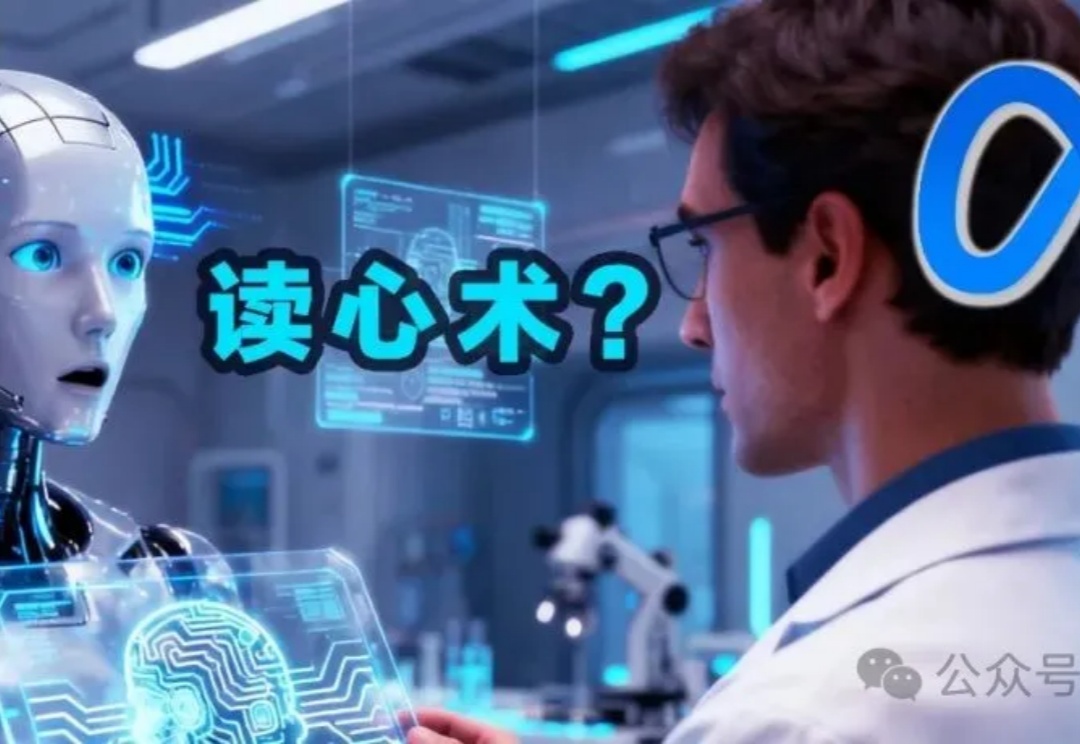

虽然大多数强化学习(RL)方法都在使用浅层多层感知器(MLP),但普林斯顿大学和华沙理工的新研究表明,将对比 RL(CRL)扩展到 1000 层可以显著提高性能,在各种机器人任务中,性能可以提高最多 50 倍。

TimeDistill通过知识蒸馏,将复杂模型(如Transformer和CNN)的预测能力迁移到轻量级的MLP模型中,专注于提取多尺度和多周期模式,显著提升MLP的预测精度,同时保持高效计算能力,为时序预测提供了一种高效且精准的解决方案。

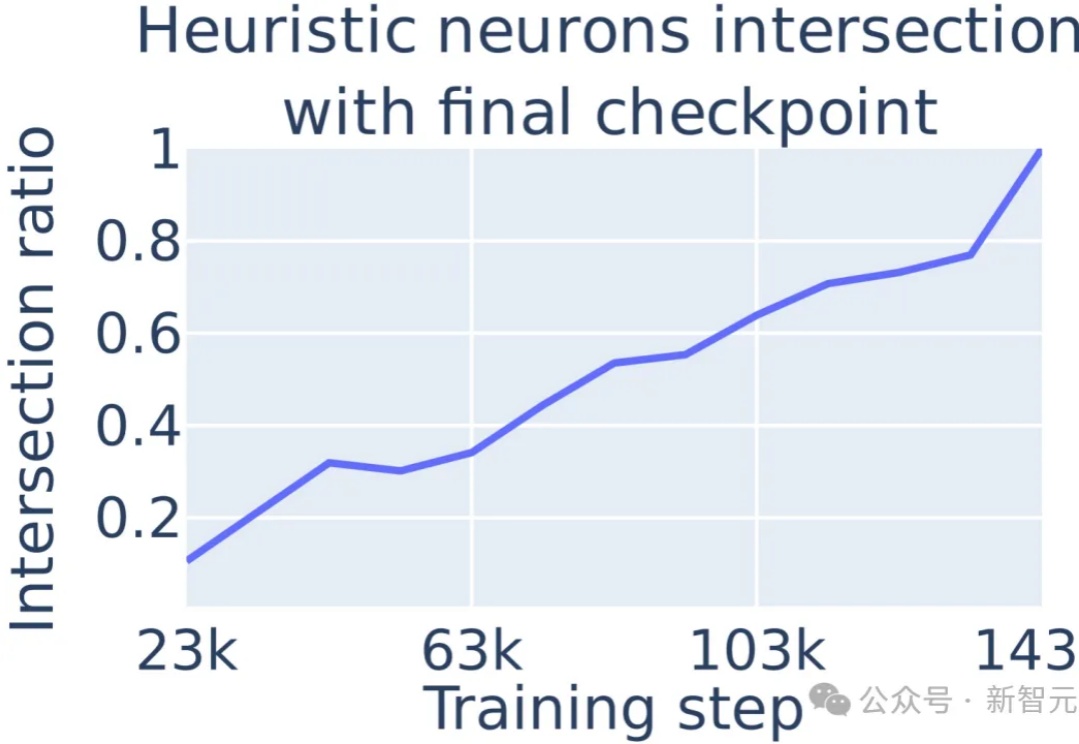

大模型在数学问题上的表现不佳,原因在于采取启发式算法进行数学运算的,通过定位到多层感知机(MLP)中的单个神经元,可以对进行数学运算的具体过程进行解释。

日前,MLCommons协会发布最新MLPerf™ Storage v1.0 AI存储基准测试成绩。浪潮信息分布式存储平台AS13000G7表现出众,在3D-UNet和CosmoFlow两个模型共计8项测试中,斩获5项性能全球第一。

Transformer 是现代深度学习的基石。传统上,Transformer 依赖多层感知器 (MLP) 层来混合通道之间的信息。

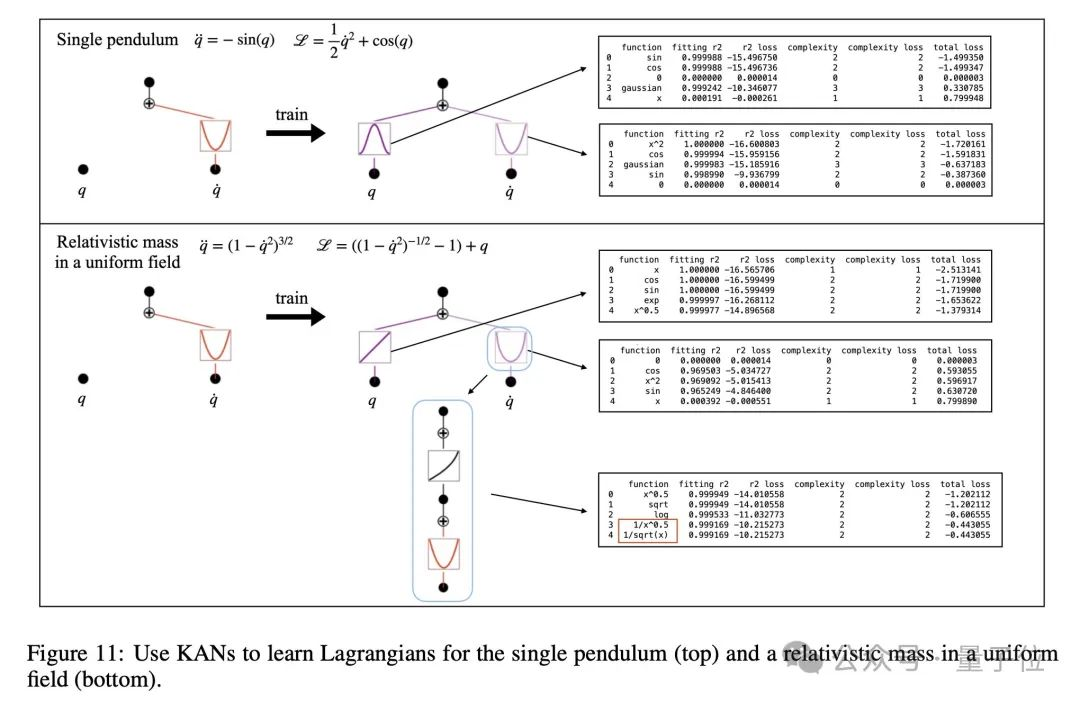

KAN的诞生,开启了机器学习的新纪元!而这背后,竟是MIT华人科学家最先提出的实践想法。从KAN到KAN 2.0,这个替代MLP全新架构正在打开神经网络的黑盒,为下一步科学发现打开速通之门。

MLPerf Inference发布了最新测试结果,英伟达最新的Blackwell架构芯片上场与谷歌、AMD同场竞技,展现出明显的性能提升,甚至刷新了部分任务上的测试纪录。

爆火神经网络架构KAN,上新了!

KAN 在符号表示中领先,但 MLP 仍是多面手。