AI 助手的「硬件实体」,还能怎么变?

AI 助手的「硬件实体」,还能怎么变?「Her」的实体化在所难免。 作者|靖宇 在斯派克 ·琼斯执导的电影《Her》里,影帝华金·菲尼克斯饰演的男主人公,把手机揣在上衣兜里,开启摄像头,来让 AI 助手 Smantha 能看到外部世界。

「Her」的实体化在所难免。 作者|靖宇 在斯派克 ·琼斯执导的电影《Her》里,影帝华金·菲尼克斯饰演的男主人公,把手机揣在上衣兜里,开启摄像头,来让 AI 助手 Smantha 能看到外部世界。

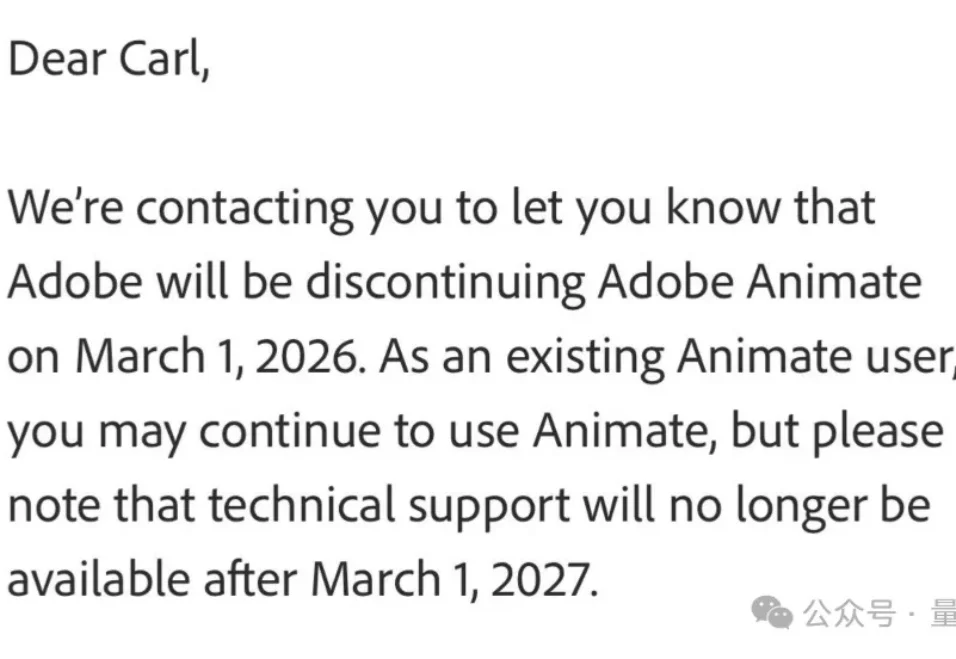

啥,Flash这次这真没了?还是被AI干没的??

为什么在LLM推理能力大幅跃升的2026,我们依然只有AI Copilot而没有AI Teammate?尽管AI编程工具遍地开花,但不管是Claude Code还是Codex,本质上仍是“单Agent开发”或“主从控制”架构。而“AI结对编程”迟迟无法落地?

如何将情感价值落地转化为市场价值,是AI陪伴赛道面临的共性问题。

最近,一个视频在推上传疯了。

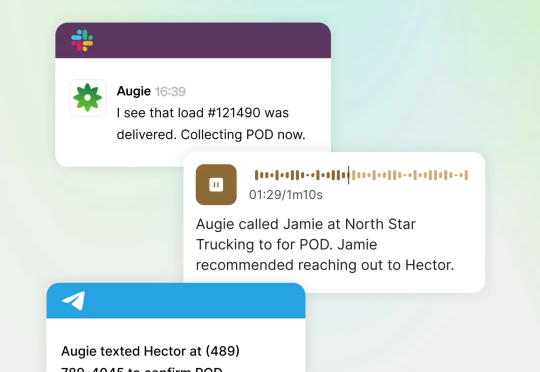

当我了解Augment的解决方案时,我意识到他们的思路与市场上其他AI公司截然不同。大多数公司在开发针对特定任务的AI工具,比如专门处理预约的AI、专门打电话的AI、专门处理文档的AI。而Augment创造的Augie则被定义为"AI teammate",这个称呼背后有着深刻的含义。

年轻父母又多了一个哄小孩法子。 前段时间,博主 Rory Flynn 在 X 上发了个帖子,说他妈妈发来一张 30 年前的涂鸦画,他反手就用 Midjourney 做成了「妈妈拿彩虹木勺大战巨龙」动画。

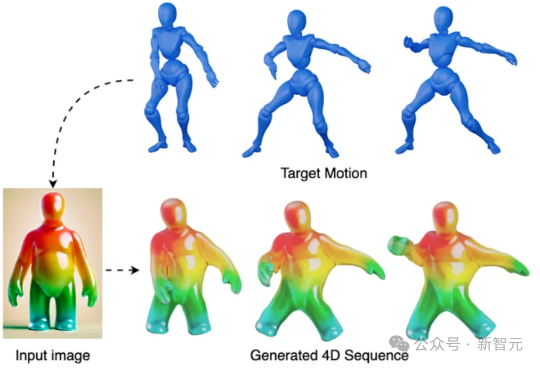

PhysRig是UIUC与Stability AI联合提出的首个面向角色动画的可微物理绑定框架。通过将刚性骨架嵌入弹性软体体积,并使用Material Point Method(MPM)进行可微分物理模拟,PhysRig能够自然还原皮肤、脂肪、尾巴等柔性结构的变形过程,显著提升角色动画的真实感,解决传统LBS无法克服的体积丢失与变形伪影问题。

AinimateLab的总监周士诚今年有两部AI短片斩获佳绩——《缸中之脑》获得今年北京国际电影节AIGC单元最佳动画;《我的外星女友》则入围了今年上海国际电影节AIGC短片单元六强。

6 月 17 日,一款 AI 占星产品 Starla-Call the Universe 进入了 iOS 美国下载总榜前 10,当笔者以为这又是一个昙花一现的产品时,它不仅能够持续坚守榜单 Top 10 长达半个月,而且到了 6 月 24 日,另一款产品 Astra-Life Advice 也进入了美榜前 10,两款同类产品相继进入 Top 10,并双双持续在榜超 1 周的时间。