谷歌年度巨献:2025 AI投资回报率报告

谷歌年度巨献:2025 AI投资回报率报告很多人都没注意到,谷歌悄悄放了一个大招,既不是 Gemini 也不是 nano banana pro,而是一份报告。这份报告调研了全球 3446 名企业高管(这些企业年营收都不低于 1000 万美元,不是小卡拉米)。

很多人都没注意到,谷歌悄悄放了一个大招,既不是 Gemini 也不是 nano banana pro,而是一份报告。这份报告调研了全球 3446 名企业高管(这些企业年营收都不低于 1000 万美元,不是小卡拉米)。

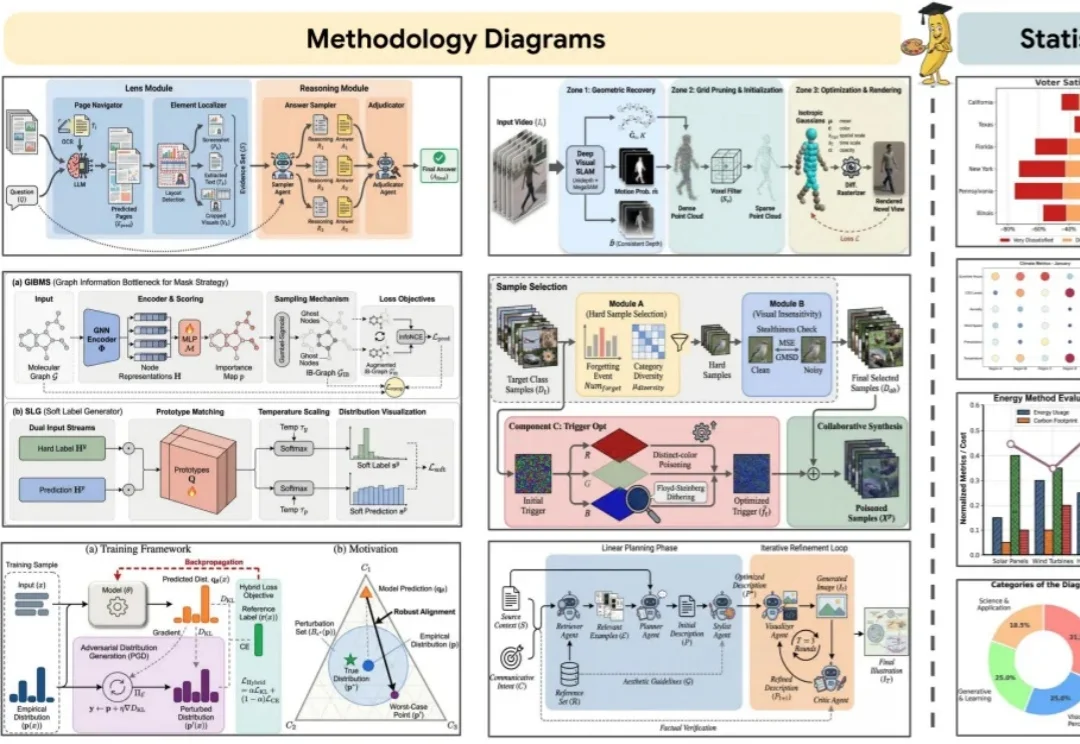

你负责写方法,AI负责画 Figure。 科研打工人,终于等来「画图解放日」。

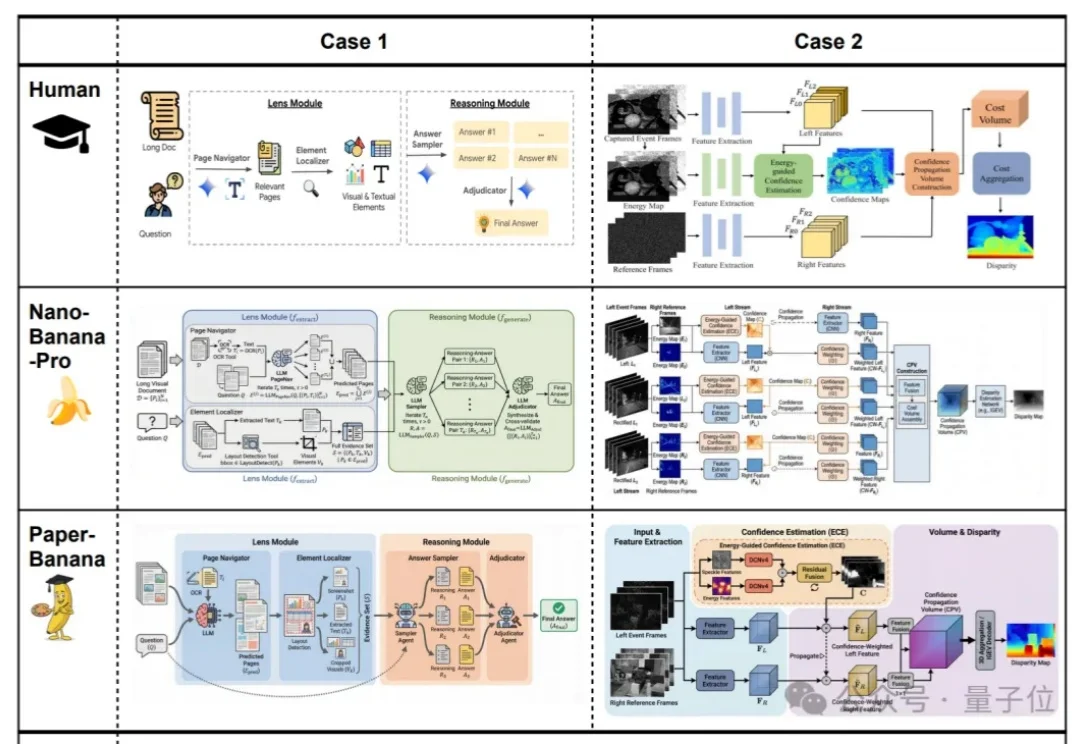

效果好到刷屏的Nano Banana,学术特供版热乎出炉!

过去一年,AI的主战场几乎被大模型、生图和生视频占满。2026年伊始,市场终于开始把目光投向一个更难、也更关键的领域:3D生成。

周末看到一个好玩的东西。 3D领域的NanoBanana也来了。 中间有一句比较重要的功能,是我觉得非常有意思的: 可以通过提示进行局部编辑。 玩过NanoBanana的肯定很熟了。 算了补全了一块有

今天,首个在国产芯片上完成全程训练的SOTA(最佳水平)多模态模型开源。这是智谱联合华为开源的图像生成模型GLM-Image。从数据到训练的全流程,该模型完全基于昇腾Atlas 800T A2设备和昇思MindSpore AI框架完成构建。

这两年一直在关注 AI,Claude Code 给我带来的震撼,和当初 Nano Banana 在画图领域的革命,几乎是一个级别。

最新报告探讨了生成式模型Nano Banana Pro在低层视觉任务中的表现,如去雾、超分等,传统上依赖PSNR/SSIM等像素级指标。研究发现,Nano Banana Pro在视觉效果上更佳,但传统指标表现欠佳,因生成式模型更追求语义合理而非像素对齐。

太香了太香了,妥妥完爆ChatGPT和Nano Banana!

趁着最近各种年度总结都出来了,我们在这篇文章里,也总结了一波 Google 今年在 AI 方向上的发力,给我们的实际体验,又带来了多大的能力提升。在谈论这些产品更新之前,Gemini 和 Nano Banana 两大「基座」模型是绕不开的内容。没有 Gemini 和 Nano Banana,Google 就是巧妇难为无米之炊。