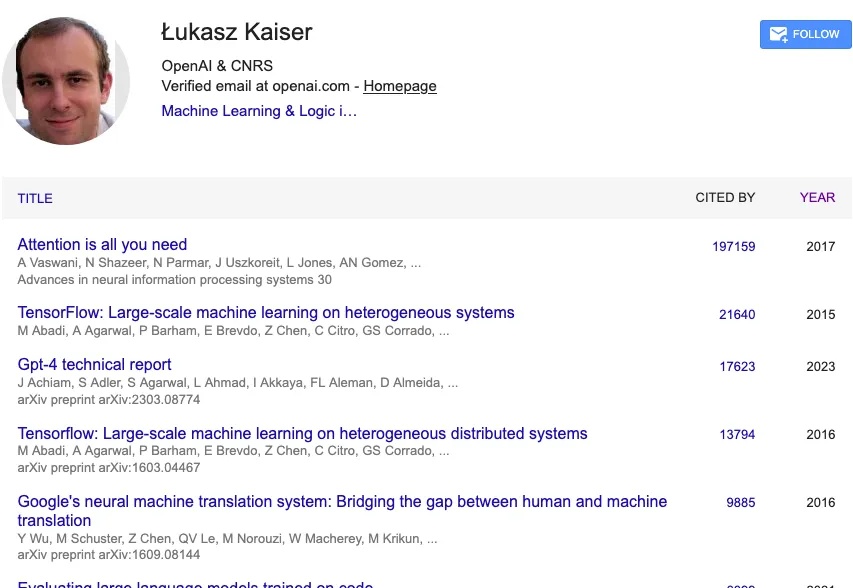

从Transformer到GPT-5,听听OpenAI科学家 Lukasz 的“大模型第一性思考”

从Transformer到GPT-5,听听OpenAI科学家 Lukasz 的“大模型第一性思考”2017 年,一篇标题看似简单、甚至有些狂妄的论文在线上出现:《Attention Is All You Need》。

2017 年,一篇标题看似简单、甚至有些狂妄的论文在线上出现:《Attention Is All You Need》。

随着豆包和元宝两大头部智能助手的入场,能够在短短数分钟内将任何内容(话题、链接或文档)转为对话式播客的AI播客工具从小众走向了大众视野。但疑问依旧重重——

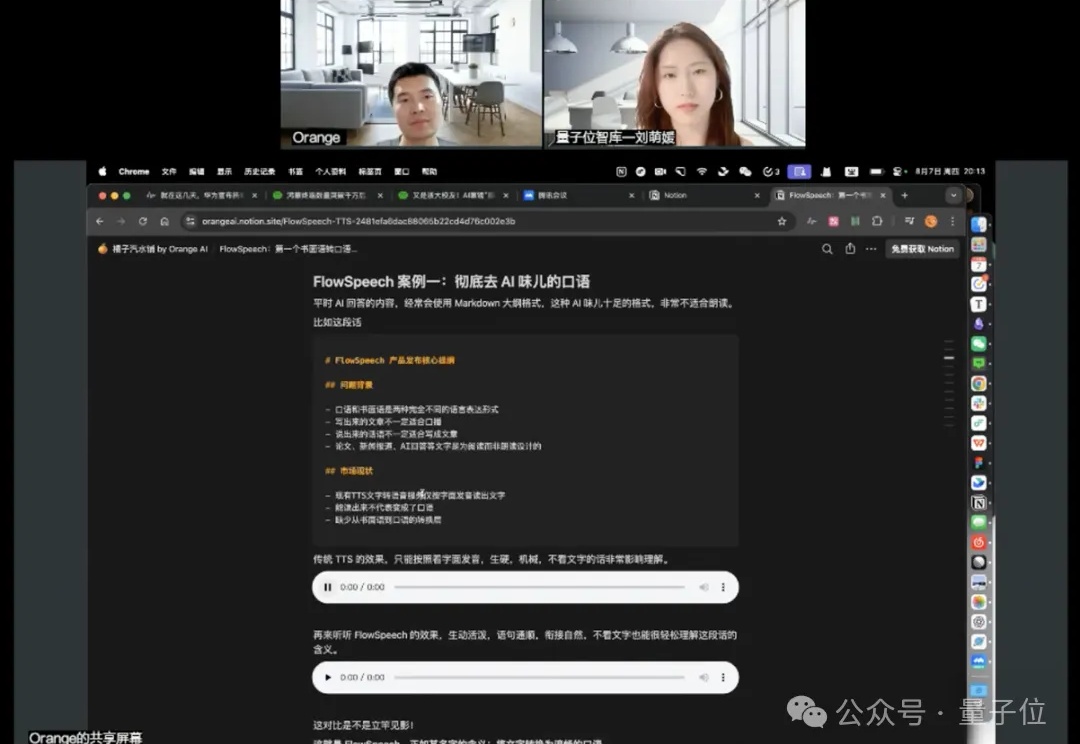

等了一百多天,悬念终于揭晓。 9 月 13 日上午,蚂蚁集团开源团队(「开源技术增长」)携《 2025 大模型开源开发生态全景图 》2.0 版,亮相上海外滩大会。

缘起 我们为什么要做视频绘本呢?它源于一位父亲小小的愿望。 ListenHub 的 CTO Kris 是一名新手爸爸,他每天在家听到孩子说的最多的三个字就是:讲故事。 孩子永远有数不清的故事想听,同一

在大厂内部“从0到1”推动并构建数据基础设施十余年之后,离哲选择走向台前,开启一场真正意义上的“从技术到产品、从产品到服务闭环”的创业实验。

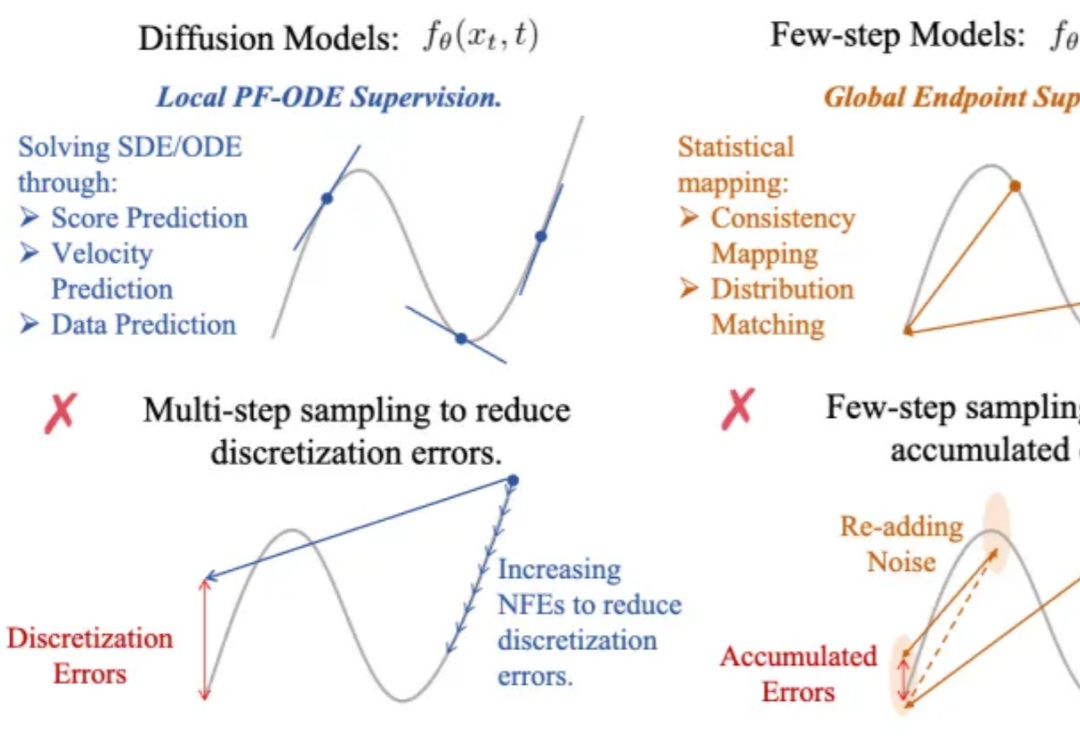

生成式AI的快与好,终于能兼得了?

噫吁嚱! 那个昔日叱咤风云的开源框架——TensorFlow,已然是行将就木了。

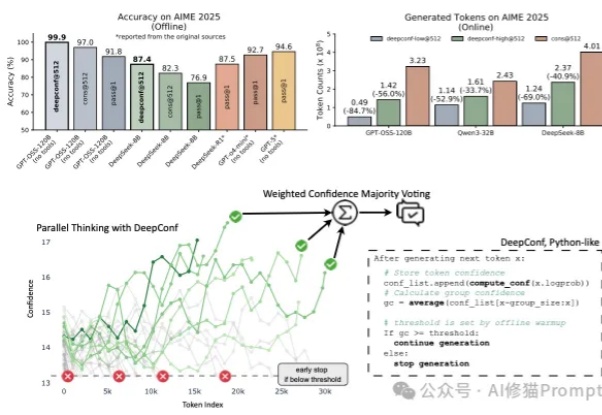

在大型语言模型(LLM)进行数学题、逻辑推理等复杂任务时,一个非常流行且有效的方法叫做 “自洽性”(Self-Consistency),通常也被称为“平行思考”。

Intent近日宣布获得数千万美元战略投资, a16z 与 GV 联合领投,跟投方还包括几位前微信产品负责人创立的基金。在 2025 年 AI Agent 市场规模已经冲到 73.8 亿美元的节点上,这笔钱显然押注的是“聊天即执行”这个赛道的爆发潜力。

这位乒乓球场上的机器人高手,出自清华姚班本科生苏智(师从吴翼教授)的最新论文——《HITTER: A HumanoId Table TEnnis Robot via Hierarchical Planning and Learning》。