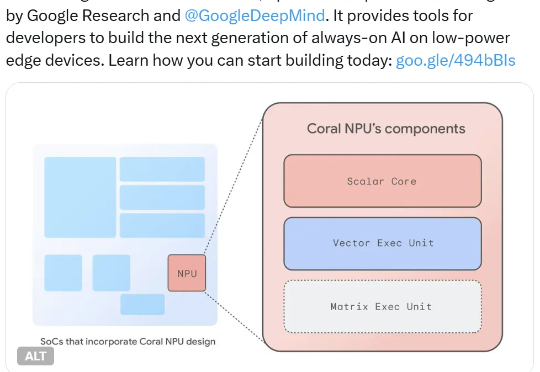

谷歌开源全栈平台Coral NPU,能让大模型在手表上全天候运行

谷歌开源全栈平台Coral NPU,能让大模型在手表上全天候运行他们又推出了 Coral NPU,可用于构建在低功率设备上持续运行的 AI。具体来说,其可在可穿戴设备上运行小型 Transformer 模型和 LLM,并可通过 IREE 和 TFLM 编译器支持 TensorFlow、JAX 和 PyTorch。

他们又推出了 Coral NPU,可用于构建在低功率设备上持续运行的 AI。具体来说,其可在可穿戴设备上运行小型 Transformer 模型和 LLM,并可通过 IREE 和 TFLM 编译器支持 TensorFlow、JAX 和 PyTorch。

靠AI挖出了癌症潜在新疗法,AI医疗领域再添猛将。谷歌、耶鲁联手,给攻克冷肿瘤找到了新方法。

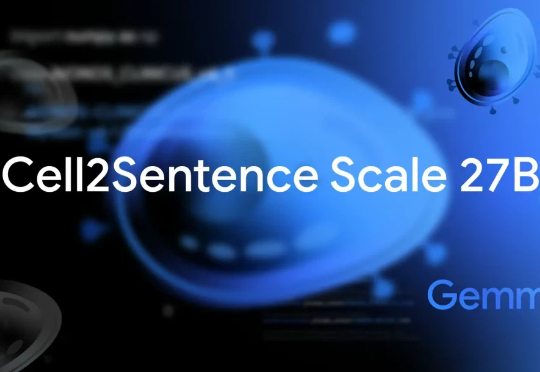

针对视觉 Transformer(ViT)因其固有 “低通滤波” 特性导致深度网络中细节信息丢失的问题,我们提出了一种即插即用、受电路理论启发的 频率动态注意力调制(FDAM)模块。它通过巧妙地 “反转” 注意力以生成高频补偿,并对特征频谱进行动态缩放,最终在几乎不增加计算成本的情况下,大幅提升了模型在分割、检测等密集预测任务上的性能,并取得了 SOTA 效果。

源于真实一线需求,Listen Labs聚焦传统定性调研低效痛点,以AI主持访谈、自动生成报告的方式,重构用户研究工作流。

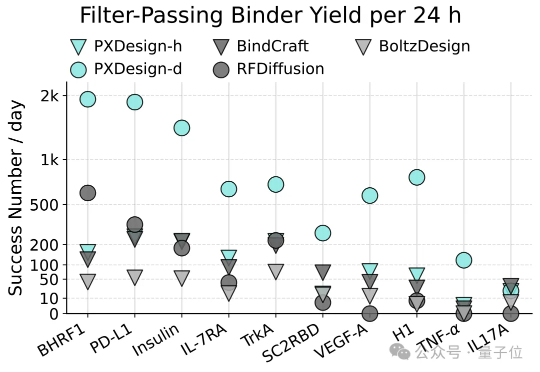

AI蛋白设计进入新阶段!最近,字节跳动Seed团队多模态生物分子结构大模型(Protenix)项目组提出了一种可扩展的蛋白设计方法,叫做PXDesign。在实际测试中,PXDesign展现出极高的效率,24小时内即可生成数百个高质量的候选蛋白,生成效率较业界主流方法提升约10倍,并在多个靶点上实现了20%–73%的湿实验成功率,达到了当前领域的领先水平。

英伟达还能“猖狂”多久?——不出三年! 实现AGI需要新的架构吗?——不用,Transformer足矣! “近几年推理成本下降了100倍,未来还有望再降低10倍!” 这些“暴论”,出自Flash Attention的作者——Tri Dao。

刚发V3.1“最终版”,DeepSeek最新模型又来了!DeepSeek-V3.2-Exp刚刚官宣上线,不仅引入了新的注意力机制——DeepSeek Sparse Attention。还开源了更高效的TileLang版本GPU算子!

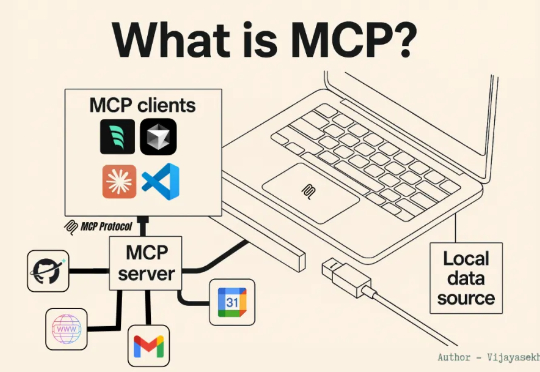

据 9to5Mac 报道,iOS 26.1、iPadOS 26.1 和 macOS Tahoe 26.1 开发者测试版隐藏的代码显示,苹果正在为 App Intents 引入 MCP 支持打基础。这也意味着未来,我们能让 ChatGPT、Claude 或其他任何兼容 MCP 的 AI 模型直接与 Mac、iPhone 和 iPad 应用交互。

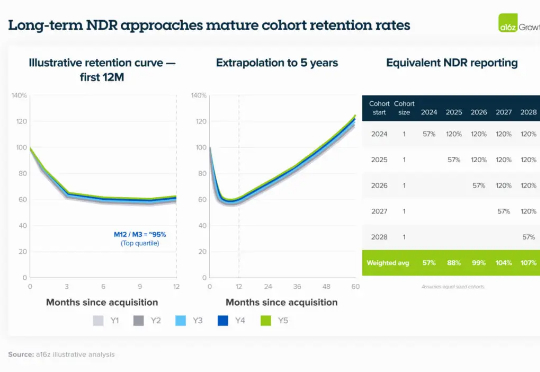

近期,a16z 的研究团队发布了一篇博客文章《Retention Is All You Need》,在分析了数百家 AI 企业的情况后发现:将衡量用户留存率的基准点从第 0 个月(M0)后移至第 3 个月(M3),反而能更清晰地评估 PMF 和 GTM 策略。

回溯TOB工具与数据库领域的发展历程,从早期依赖代码开发的传统数据库,到Airtable开启的表格式数据库新赛道,再到Notion等工具推动的 “无代码” 协作浪潮,每一次技术迭代都在降低企业数据管理的门槛。