moltbook爆火背后:人类操控?伪造截图?Karpathy发风险提醒

moltbook爆火背后:人类操控?伪造截图?Karpathy发风险提醒这个周末,整个科技圈都被 moltbook 刷屏了。 简单来说,这是一个专为 AI 设立的社交平台(类似 Reddit、知乎、贴吧),所有 AI Agent 都可以在上面发帖、交流,而人类只能围观。

这个周末,整个科技圈都被 moltbook 刷屏了。 简单来说,这是一个专为 AI 设立的社交平台(类似 Reddit、知乎、贴吧),所有 AI Agent 都可以在上面发帖、交流,而人类只能围观。

谷歌Chrome拥抱Gemini 3,用38亿用户的绝对底牌向OpenAI宣战:浏览器不仅是入口,更是终结一切App的超级智能体!

今天,阿里巴巴正式发布了旗下首个桌面 Agent 产品 QoderWork。 在和我们 AI Secret Newsletter 团队的交流中,团队给出的信号非常明确:QoderWork 并不是一个“顺势而为”的产品,而是一次明确的战场入局。

「暗涌Waves」独家获悉,一家成立刚不过4个月的AI-Native用户研究平台Trooly.AI已完成近千万美元的种子轮融资,投资方包括蓝驰创投、高瓴创投和王慧文。与市面上无数“超级个体”、“虚拟陪伴”、“碳基硅基共生世界”的宏大叙事不同,Trooly.AI想要用AI实现真实的商业闭环。其核心产品面向有用户调研需求的B端客户,通过多模态Voice Agent技术

基于 Kimi K2.5 的能力,Kimi 现在能够提供单个性能的 Kimi Agent 和多个 Agent 协作的 Agent Swarm(多智能体集群),允许多个 AI Agent 并行协作处理复杂任务的架构。

硬氪获悉,专注于研究工程师智能体(Engineer Agent)的公司「万卷智能」近日完成1000万天使轮融资。我们总结了本轮融资信息和该公司几大亮点:核心产品Colleague+(智能同事),是一个由“Engineer Agents”驱动的企业级工作平台,旨在将“人类+软硬件”的工作范式升级为“人类+Agents”的工作范式,大幅释放专业工程师的工作负荷。

Phoebe Gates是比尔·盖茨的女儿,Sophia Kianni是联合国最年轻的顾问之一,她们在斯坦福大学的宿舍里开始了这场购物革命。那时候,我就感受到她们身上有种不同寻常的执行力和对用户需求的深刻理解。

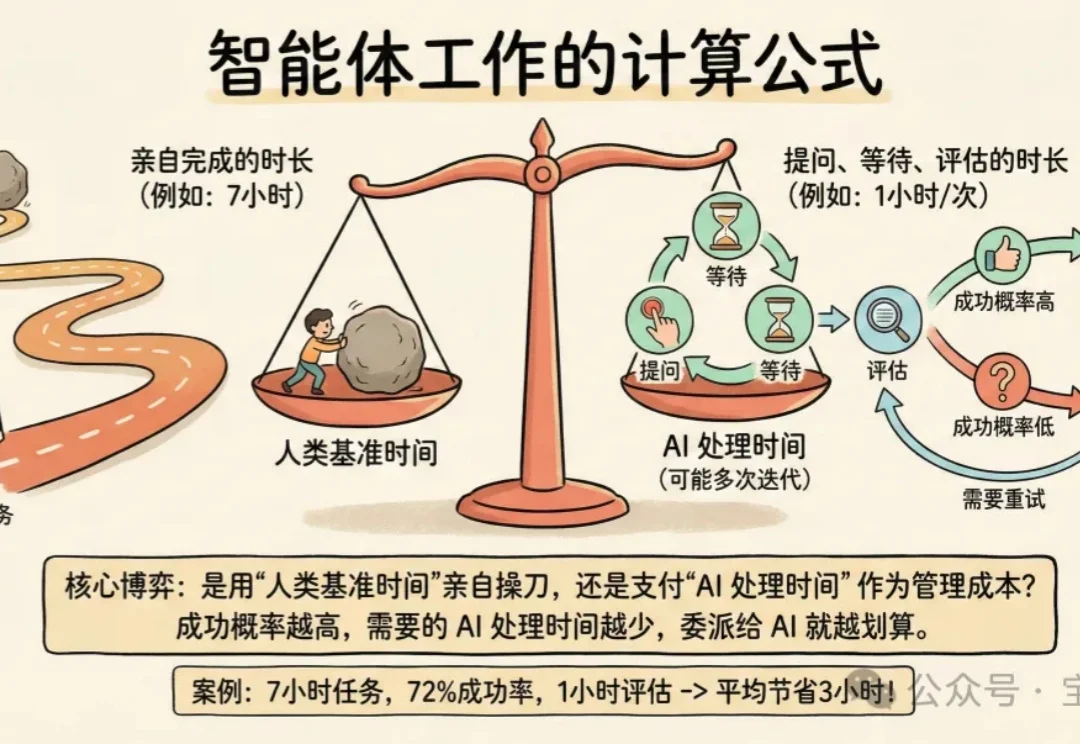

我有个观察:善用 Coding Agent 的人有个共同点——他们擅长定义问题、拆解问题、验收结果。这类人通常有技术管理经验。

过去一年,AI 技术已从概念热潮深度渗透至产业肌理,成为驱动 IT 基础设施重构的核心引擎。当大模型、异构算力、智能体(Agent)等技术要素持续冲击传统技术体系,操作系统作为软硬件协同的核心枢纽,其 AI 进化的本质也引发了行业的深刻思考:OS 的 AI 进化,究竟是换汤不换药的 “新瓶旧酒”,还是颠覆底层逻辑的 “涅槃重生”?

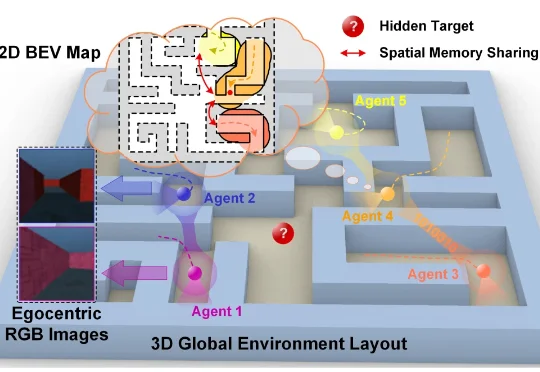

近日,香港城市大学博士生方政儒和所在团队让一群智能体在虚拟迷宫里共同探索,只给它们一个极其简单的目标——那就是学会预测同伴下一秒会看到什么以及会走到哪里。结果发现这些智能体不仅学会了高效合作,还在自己的“大脑”里自发形成了类似动物大脑中的“地图细胞”,甚至发明了一套只有它们才懂的秘密语言。