推理模型新路线开源!与DeepSeek截然不同,抛弃思维链不用人类语言思考

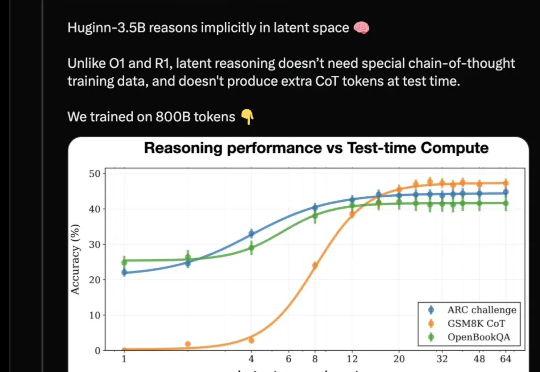

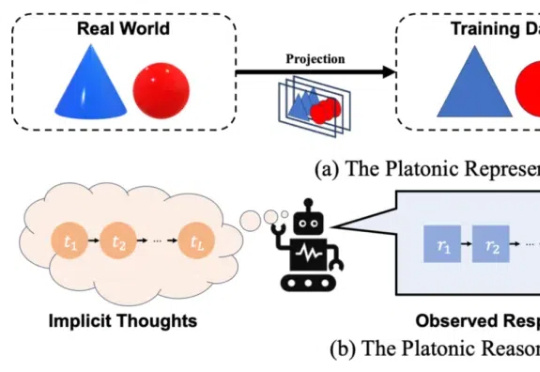

推理模型新路线开源!与DeepSeek截然不同,抛弃思维链不用人类语言思考开源推理大模型新架构来了,采用与Deepseek-R1/OpenAI o1截然不同的路线: 抛弃长思维链和人类的语言,直接在连续的高维潜空间用隐藏状态推理,可自适应地花费更多计算来思考更长时间。

开源推理大模型新架构来了,采用与Deepseek-R1/OpenAI o1截然不同的路线: 抛弃长思维链和人类的语言,直接在连续的高维潜空间用隐藏状态推理,可自适应地花费更多计算来思考更长时间。

推理大语言模型(LLM),如 OpenAI 的 o1 系列、Google 的 Gemini、DeepSeek 和 Qwen-QwQ 等,通过模拟人类推理过程,在多个专业领域已超越人类专家,并通过延长推理时间提高准确性。推理模型的核心技术包括强化学习(Reinforcement Learning)和推理规模(Inference scaling)。

只用4500美元成本,就能成功复现DeepSeek?就在刚刚,UC伯克利团队只用简单的RL微调,就训出了DeepScaleR-1.5B-Preview,15亿参数模型直接吊打o1-preview,震撼业内。

「慢思考」(Slow-Thinking),也被称为测试时扩展(Test-Time Scaling),成为提升 LLM 推理能力的新方向。近年来,OpenAI 的 o1 [4]、DeepSeek 的 R1 [5] 以及 Qwen 的 QwQ [6] 等顶尖推理大模型的发布,进一步印证了推理过程的扩展是优化 LLM 逻辑能力的有效路径。

除了o1/o3,OpenAI另一个尚未公开的内部推理模型曝光了。爆料者正是CEO奥特曼本人。据他透露,与全球顶尖程序员相比,当前这一内部模型的编程能力已达Top50,甚至今年年底将排名第一。

DeepSeek 的最新模型 DeepSeek-V3 和 DeepSeek-R1 都属于 MoE(混合专家)架构,并在开源世界产生了较大的影响力。特别是 2025 年 1 月开源的 DeepSeek-R1,模型性能可挑战 OpenAI 闭源的 o1 模型。

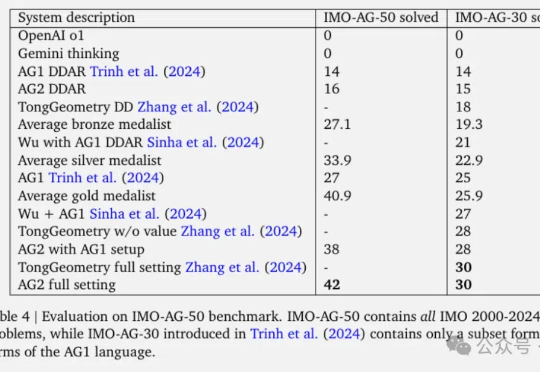

谷歌DeepMind最新数学AI,一举解决了2000-2024年IMO竞赛中84%的几何问题。AlphaGeometry2论文发布,在总共50道题中完成了42道,相比去年的一代多完成了15道。

DeepSeek的V3模型仅用557.6万的训练成本,实现了与OpenAI O1推理模型相近的性能,这在全球范围内引发连锁反应。由于不用那么先进的英伟达芯片就能实现AI能力的飞跃,英伟达在1月27日一天跌幅高达17%,市值一度蒸发6000亿美元。

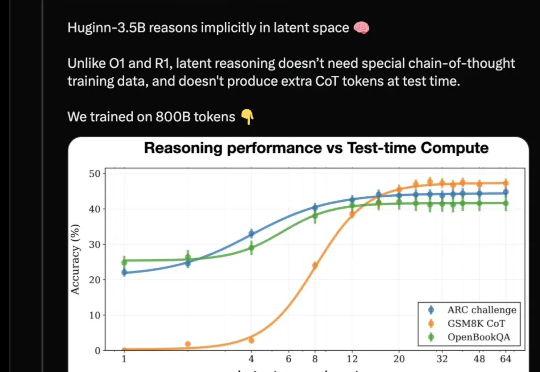

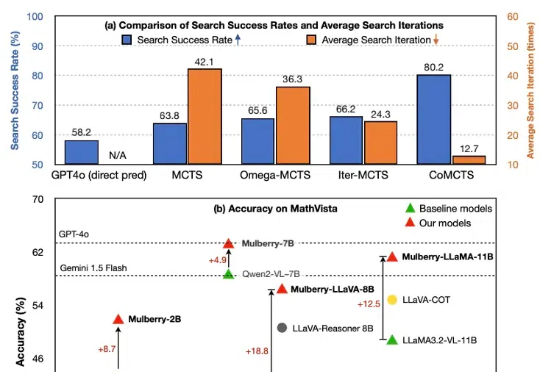

尽管多模态大语言模型(MLLM)在简单任务上最近取得了显著进展,但在复杂推理任务中表现仍然不佳。费曼的格言可能是这种现象的完美隐喻:只有掌握推理过程的每一步,才能真正解决问题。然而,当前的 MLLM 更擅长直接生成简短的最终答案,缺乏中间推理能力。本篇文章旨在开发一种通过学习创造推理过程中每个中间步骤直至最终答案的 MLLM,以实现问题的深入理解与解决。

成本不到150元,训练出一个媲美DeepSeek-R1和OpenAI o1的推理模型?!这不是洋葱新闻,而是AI教母李飞飞、斯坦福大学、华盛顿大学、艾伦人工智能实验室等携手推出的最新杰作:s1。