浙大系具身智能再闯港交所:主打工业场景,每天进账1000000元

浙大系具身智能再闯港交所:主打工业场景,每天进账1000000元创投风口赛道上的具身智能,让垂直场景上的玩家有了「焕新」机遇。

创投风口赛道上的具身智能,让垂直场景上的玩家有了「焕新」机遇。

这项工作由伊利诺伊大学香槟分校 (UIUC)、哈佛大学、哥伦比亚大学和麻省理工学院 (MIT) 的合作完成 。

VLA模型性能暴涨300%,背后训练数据还首次实现90%由世界模型生成。

具身智能,火得有些过分, 就在昨天,清华大学宣布成立具身智能与机器人研究院。

鹭羽 发自 凹非寺 量子位 | 公众号 QbitAI 具身智能的风也是卷到高校了。 近期,上海交通大学发布公告,宣布即日起拟增设具身智能本科专业。 环顾全球,目前还没有将具身智能作为独立本科专业开设的

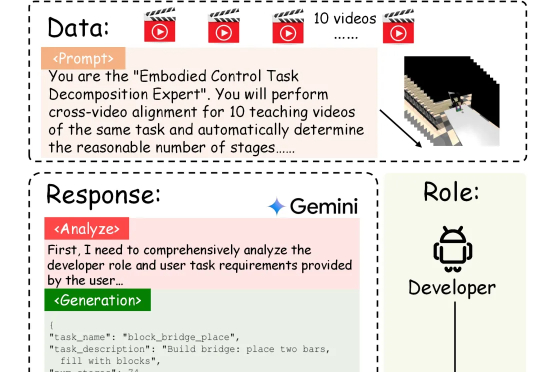

具身智能的「ChatGPT时刻」还没到,机器人的「幻觉」却先来了?在需要几十步操作的长序列任务中,现有的VLA模型经常「假装在干活」,误以为任务完成。针对这一痛点,北京大学团队提出自进化VLA框架EvoVLA。该模型利用Gemini生成「硬负样本」进行对比学习,配合几何探索与长程记忆,在复杂任务基准Discoverse-L上将成功率提升了10.2%,并将幻觉率从38.5%大幅降至14.8%。

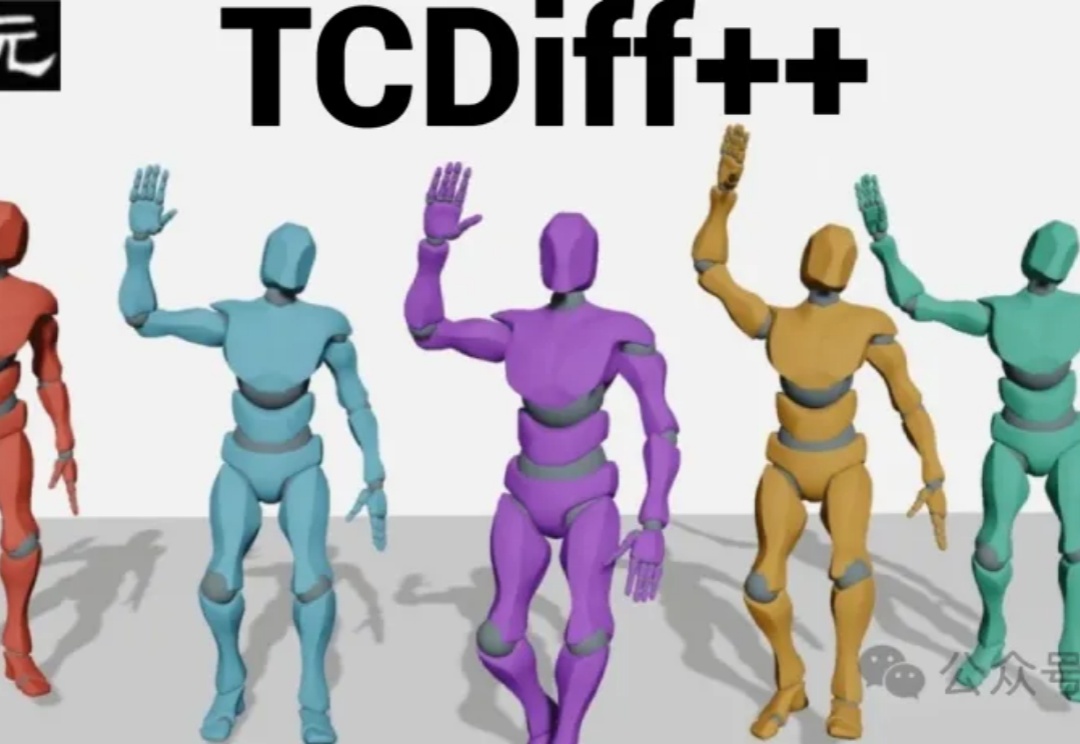

当元宇宙数字人急需「群舞技能」,音乐驱动生成技术却遭遇瓶颈——舞者碰撞、动作僵硬、长序列崩坏。为解决这些难题,南理工、清华、南大联合研发端到端模型TCDiff++,突破多人生成技术壁垒,实现高质量、长时序的群体舞蹈自动生成。

两位长期站在具身智能第一线的亲历者,给出了罕见清晰的判断。

乖乖,反正我是被“震”到了。

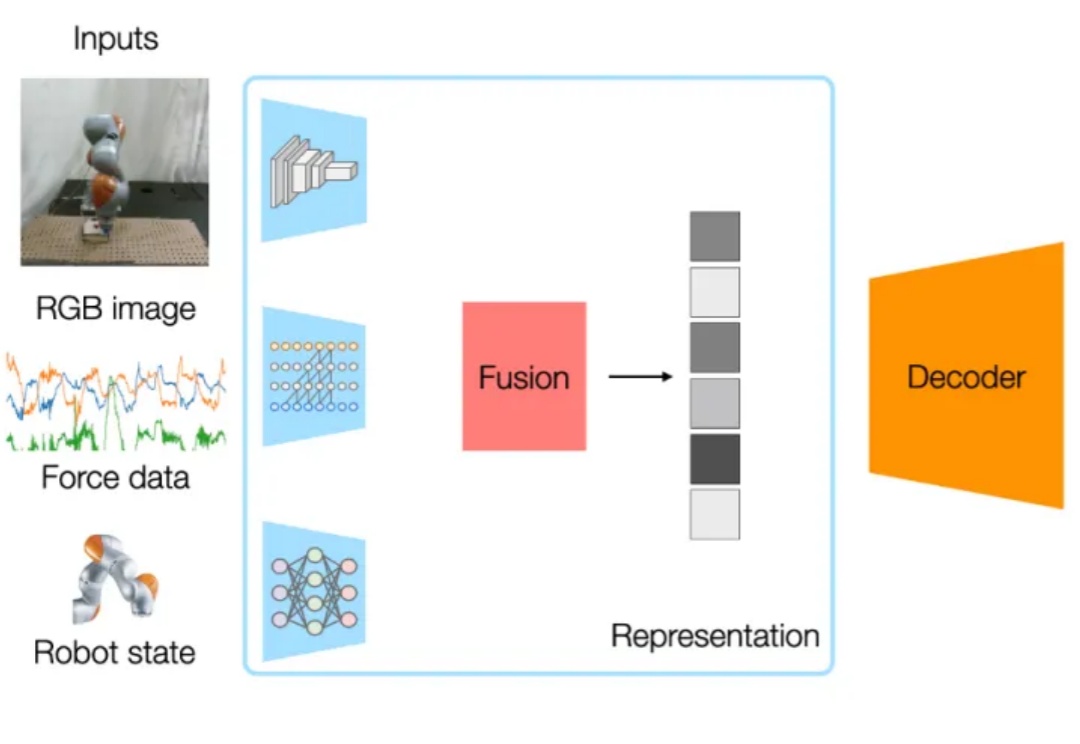

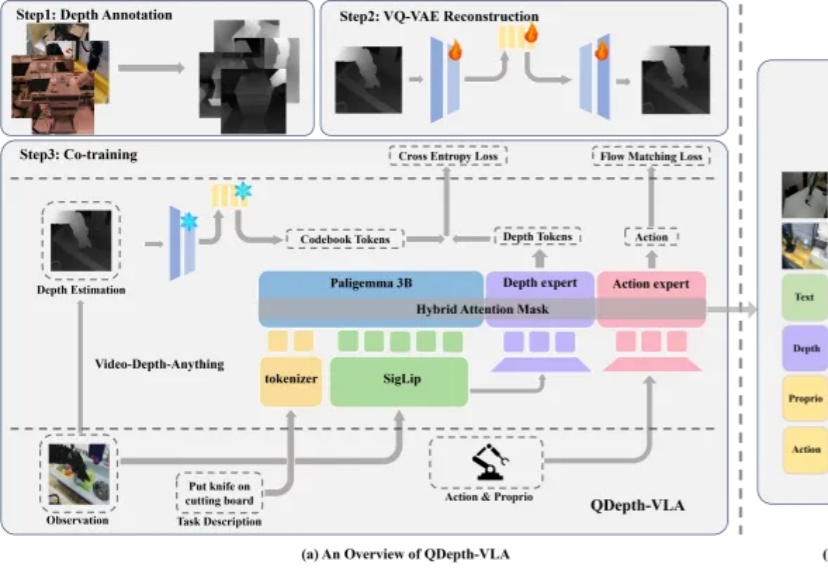

视觉-语言-动作模型(VLA)在机器人操控领域展现出巨大潜力。通过赋予预训练视觉-语言模型(VLM)动作生成能力,机器人能够理解自然语言指令并在多样化场景中展现出强大的泛化能力。然而,这类模型在应对长时序或精细操作任务时,仍然存在性能下降的现象。