刚刚,腾讯姚顺雨署名首篇论文发布,「下半场」先搞上下文学习

刚刚,腾讯姚顺雨署名首篇论文发布,「下半场」先搞上下文学习不久前在 AGI-Next 前沿峰会上,姚顺雨曾分享过一个核心观点:模型想要迈向高价值应用,核心瓶颈就在于能否「用好上下文(Context)」。

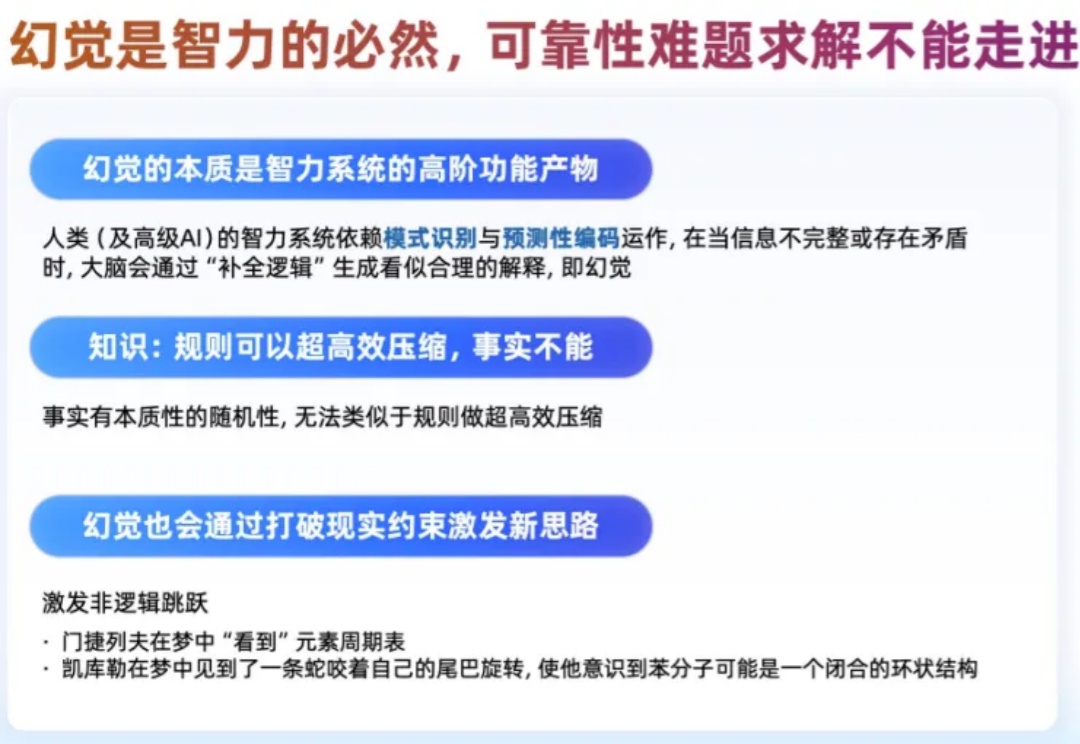

不久前在 AGI-Next 前沿峰会上,姚顺雨曾分享过一个核心观点:模型想要迈向高价值应用,核心瓶颈就在于能否「用好上下文(Context)」。

继OpenAI大神姚顺雨之后,腾讯AI再添猛将!95后清华「天骄」庞天宇,正式入职腾讯,出任混元首席研究科学家,负责多模态强化学习。腾讯的大模型「梦之队」版图,正在极速扩张。

清华攒了个局,把AI圈大半边天聚到了一块。基模四杰全员到场:智谱唐杰、Kimi杨植麟、阿里林俊旸,还有……突然贴脸跳屏的姚顺雨。

今天受邀,参加了一个非常有趣的活动,现场人真的爆满了,很多人都是从外地特意赶过来的。 这个活动,叫AGI-NEXT。 主要是几个演讲的嘉宾,过于重磅了。 开源四巨头除了DeepSeek没来,智谱的唐杰老师、Kimi的杨植麟、Qwen的林俊旸,齐聚一堂。

独家获悉,腾讯近期完成了一次组织调整,正式新成立AI Infra部、AI Data部、数据计算平台部。 12月17日下午发布的内部公告中,腾讯表示,Vinces Yao将出任“CEO/总裁办公室”首席AI科学家,向腾讯总裁刘炽平汇报;他同时兼任AI Infra部、大语言模型部负责人,向技术工程事业群总裁卢山汇报。

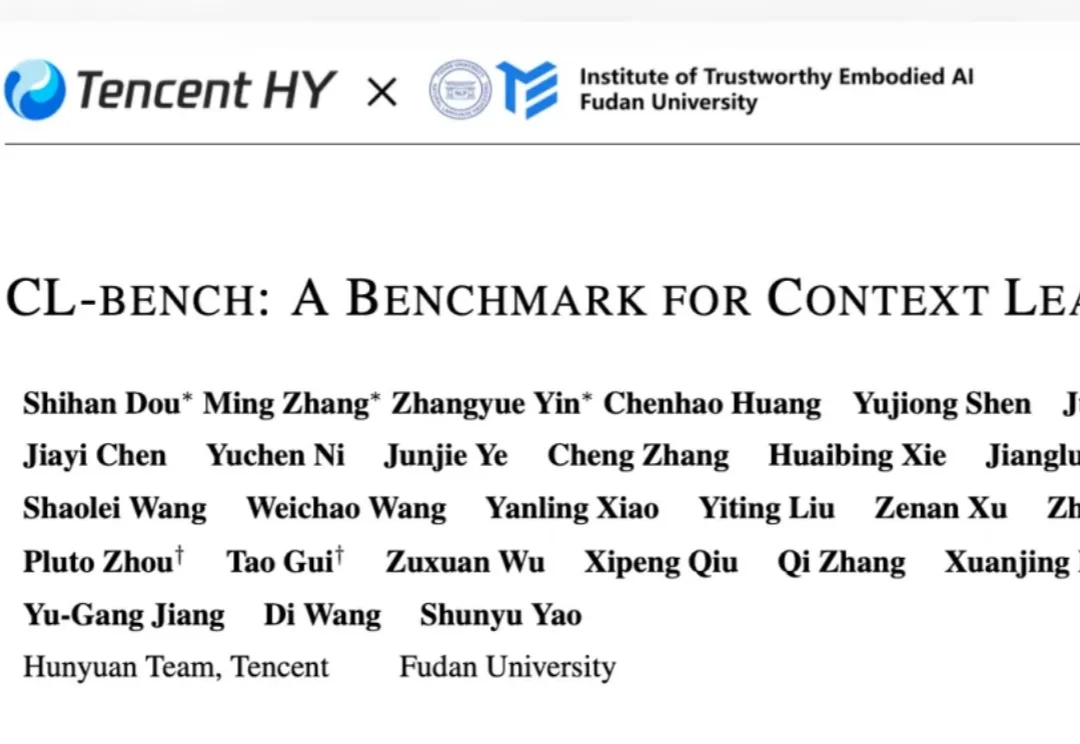

很多人相信,我们已经进入了所谓的「AI 下半场」,一个模型能力足够强大、应用理应爆发的时代。然而,对于这个时代真正缺少的东西,不同的人有不同的侧重,比如(前)OpenAI 研究者姚顺雨强调了评估的重要性,著名数学家陶哲轩则指出必须降低成本才能实现规模化应用。

为大模型开启“下半场”的姚顺雨,也开启了个人AI的下半场。

昨天,有消息称,OpenAI 著名研究者、清华校友、著名博客《AI 下半场》的作者姚顺雨已经加入了腾讯混元大模型团队,并且还传言说他将在这里组建一支自己领导的研究团队。

2025年4月,OpenAI研究员姚顺雨发布了一篇有名的博文《The Second Half》,宣告AI主线程的游戏已进入下半场。这之后,我们与他进行了一场播客对谈。姚顺雨毕业于清华和普林斯顿大学,博士期间意识到语言是人类发明的最重要的工具,也是最有可能构建通用系统的,于是转向Language Agent研究,至今已6年。

此刻我们正处在什么样的时代?是姚顺雨笔下的「AI 的下半场」,是 Andrej Karpathy 定义的「软件 3.0 时代」,也是一个创造者与 AI 协同进化,重新定义「可能」的时代。