VinciCoder:多模态统一代码生成框架和视觉反馈强化学习,数据代码模型权重已开源

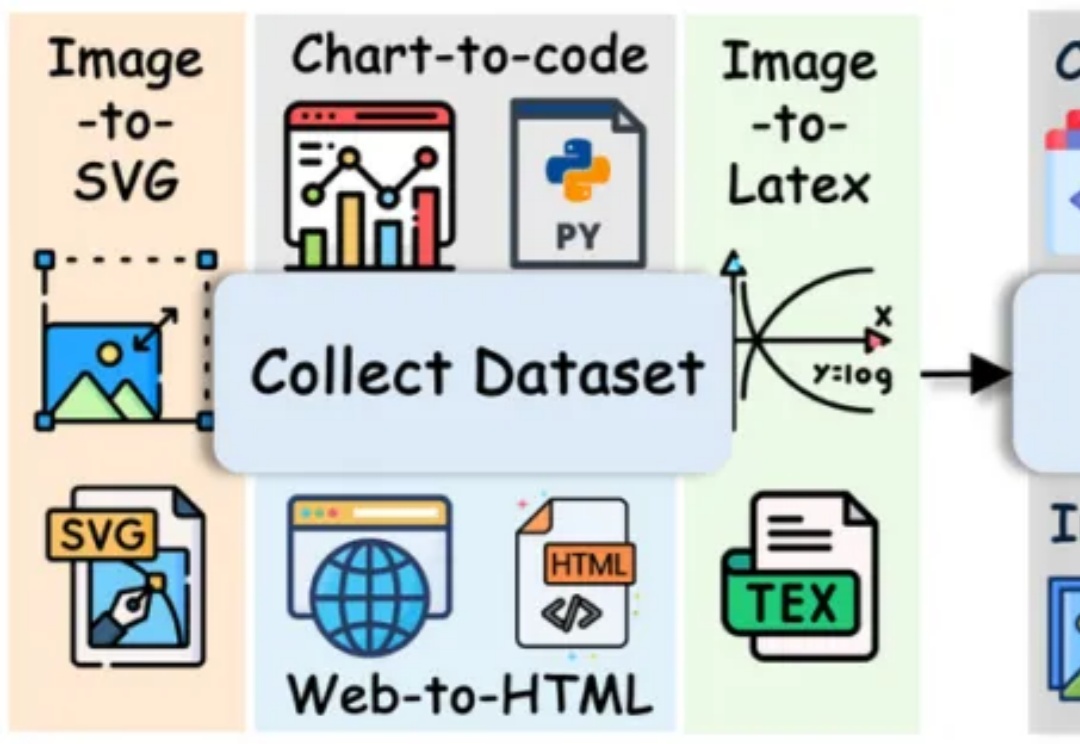

VinciCoder:多模态统一代码生成框架和视觉反馈强化学习,数据代码模型权重已开源长期以来,多模态代码生成(Multimodal Code Generation)的训练严重依赖于特定任务的监督微调(SFT)。尽管这种范式在 Chart-to-code 等单一任务上取得了显著成功 ,但其 “狭隘的训练范围” 从根本上限制了模型的泛化能力,阻碍了通用视觉代码智能(Generalized VIsioN Code Intelligence)的发展 。