全网爆火的AI原生浏览器Dia最全系统提示词,建议AI产品经理都看看

全网爆火的AI原生浏览器Dia最全系统提示词,建议AI产品经理都看看看了Dia的系统提示词,真的是细节狂魔啊!(提示词放文末了)每个细节都在优化用户的使用体验,这就是产品级AI和玩具级AI的区别。提示词整体结构遵循了"总-分-总"的结构,开头设定整体角色身份的基本认知,然后分项设定规则,最终设定总体的安全策略。

看了Dia的系统提示词,真的是细节狂魔啊!(提示词放文末了)每个细节都在优化用户的使用体验,这就是产品级AI和玩具级AI的区别。提示词整体结构遵循了"总-分-总"的结构,开头设定整体角色身份的基本认知,然后分项设定规则,最终设定总体的安全策略。

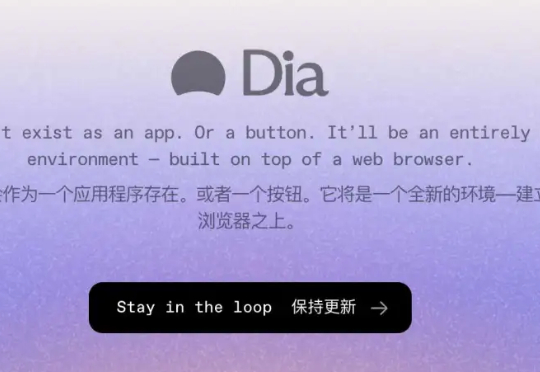

最近ContextGem很火。它既不是RAG也不是Agent,而是专注于"结构化提取"的框架,它像一个"文档理解层",通过文档中心设计和神经网络技术(SAT)将非结构化文档转化为精确的结构化数据。它可作为RAG的前置处理器、Agent的感知模块,也可独立使用。

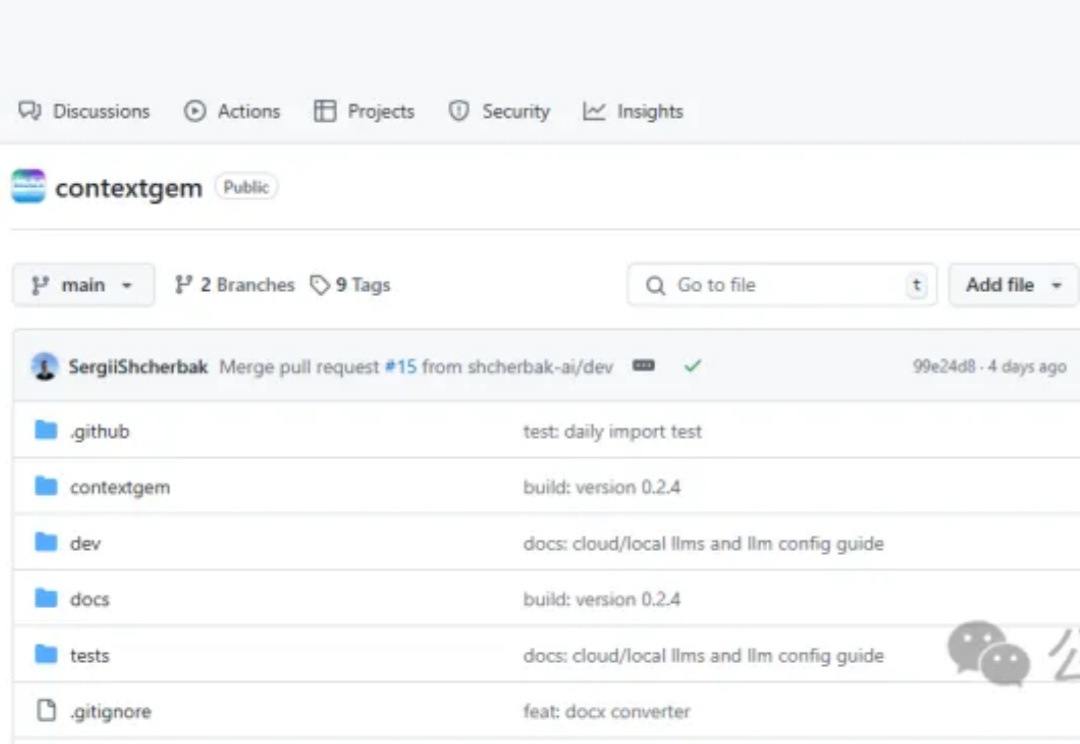

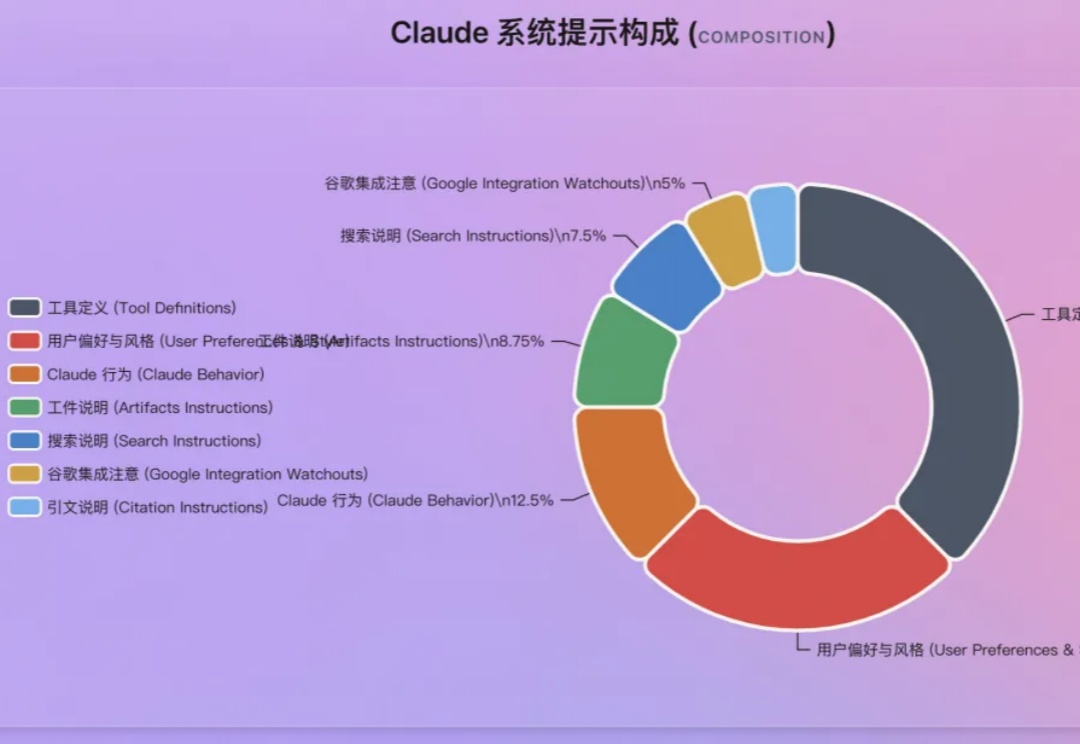

前几天 Cluade 新的系统提示词泄露了,居然有 16,739 个单词,非常长。

用AI提问的时候,你有没有发现一件事:

最近我们AI爱好者的群里玩的全都是豆包和即梦生成的海报图片,大家评价做图片和海报效果真的很不错,豆包进步了,即梦也进步了。真的进步太大了!下面是我的朋友们尝试过的一些趣味玩法:

可控图片生成,如今已经不是什么新鲜事。甚至也不需要复杂的提示词,用户通过简单的文本描述,就能快速生成符合个人需求的创意图像。

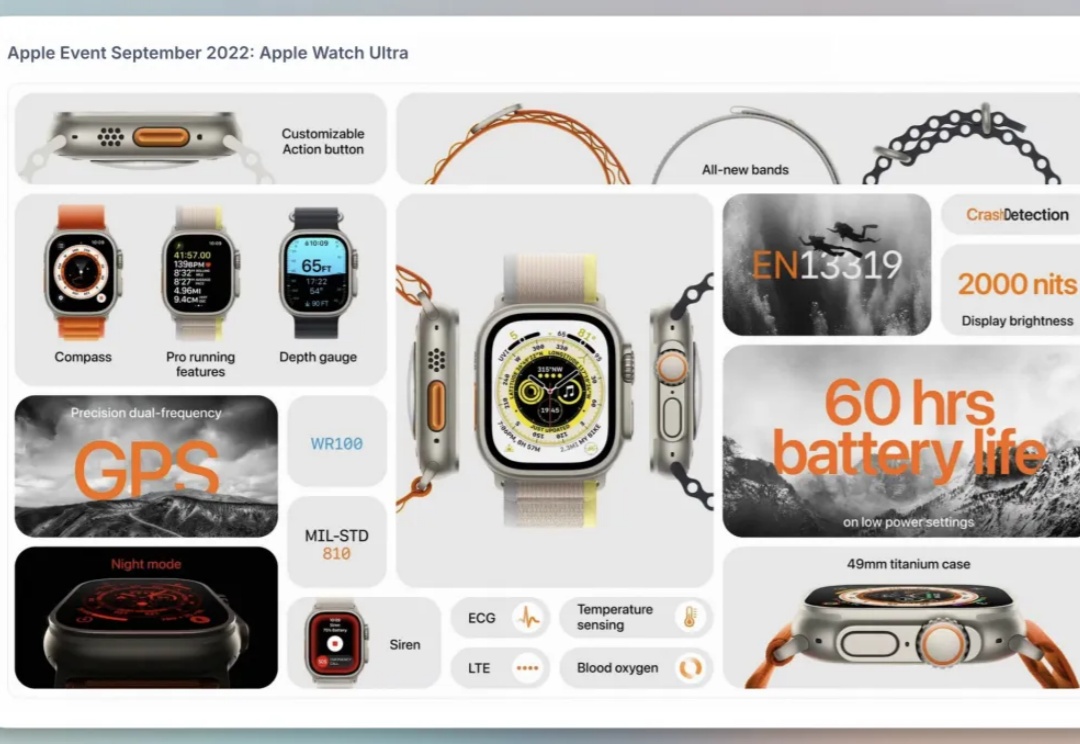

最近 X 上很流行 Bento 信息图。

AI输出陷入"无效对话"困境?其实是你不懂提问的艺术。从指令颗粒度拆解到思维链编织,本文揭示精准提问如何唤醒AI潜能——与其焦虑技术颠覆,不如掌握这套数字化时代的元能力,让语言真正成为撬动生产力的支点。文章来自编译。

一张普通的生活照,可能成为 AI 破解你隐私的钥匙 —— 这不是科幻情节,而是最新研究揭示的残酷现实。

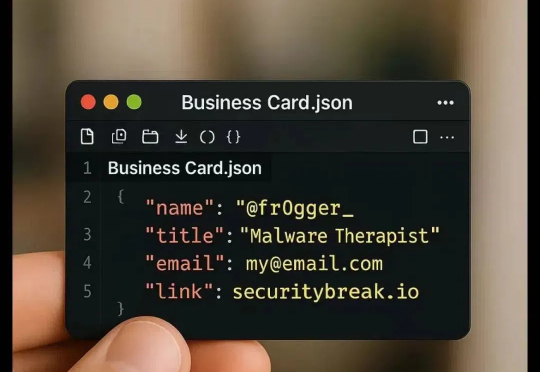

最近,刷X(原推特)看到一种New business card。