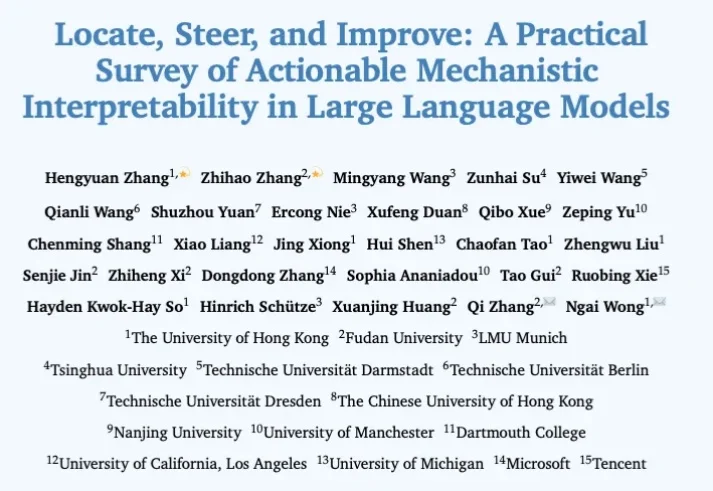

大模型哪里出问题、怎么修,这篇可解释性综述一次讲清

大模型哪里出问题、怎么修,这篇可解释性综述一次讲清过去几年,机制可解释性(Mechanistic Interpretability)让研究者得以在 Transformer 这一 “黑盒” 里追踪信息如何流动、表征如何形成:从单个神经元到注意力头,再到跨层电路。但在很多场景里,研究者真正关心的不只是 “模型为什么这么答”,还包括 “能不能更稳、更准、更省,更安全”。

来自主题: AI技术研报

10239 点击 2026-01-28 10:13