RMoA残差提取Mixture-of-Agents,让Agent发现新东西,并自适应停止「ACL2025」

RMoA残差提取Mixture-of-Agents,让Agent发现新东西,并自适应停止「ACL2025」如果你正在开发Agent产品,一定听过或用过Mixture-of-Agents(MoA)架构。这个让多个AI模型协作解决复杂问题的框架,理论上能够集众家之长,实际使用中却让人又爱又恨:

如果你正在开发Agent产品,一定听过或用过Mixture-of-Agents(MoA)架构。这个让多个AI模型协作解决复杂问题的框架,理论上能够集众家之长,实际使用中却让人又爱又恨:

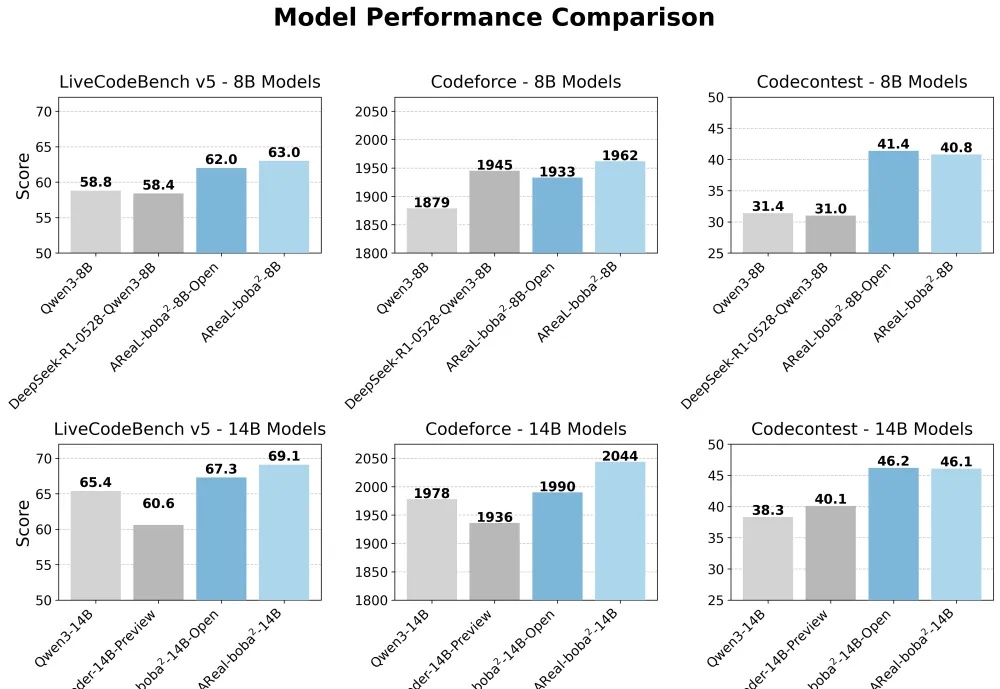

想训练属于自己的高性能推理模型,却被同步强化学习(RL)框架的低效率和高门槛劝退?AReaL 全面升级,更快,更强,更好用!

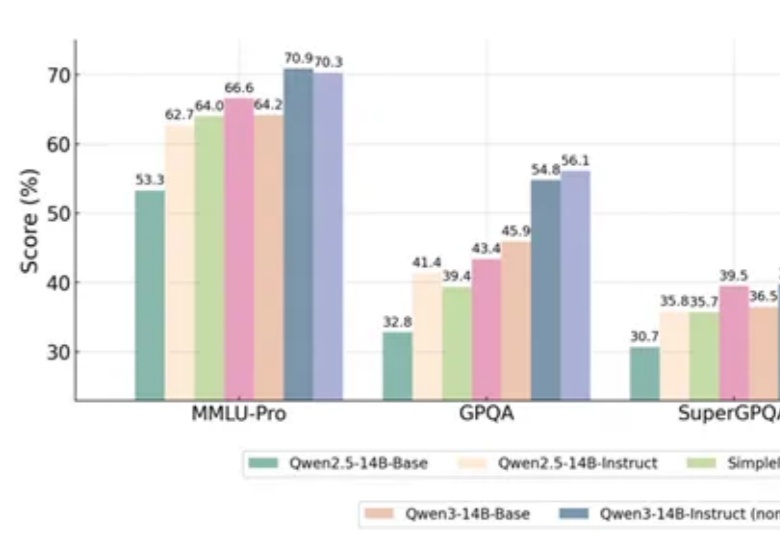

一项新的强化学习方法,直接让Qwen性能大增,GPT-4o被赶超!

你好研究僧,听说刚刚中了顶会,却还在愁怎么做Poster(学术海报)?

新加坡国立大学等机构的研究者们通过元能力对齐的训练框架,模仿人类推理的心理学原理,将演绎、归纳与溯因能力融入模型训练。实验结果显示,这一方法不仅提升了模型在数学与编程任务上的性能,还展现出跨领域的可扩展性。

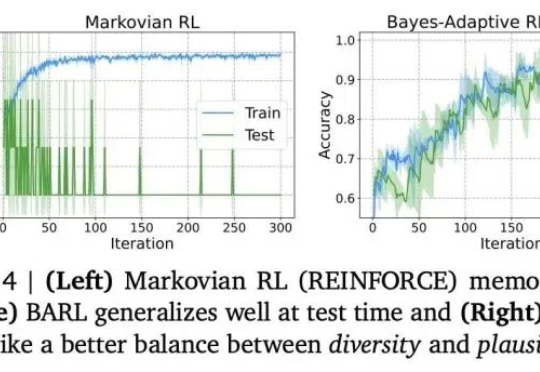

推理模型常常表现出类似自我反思的行为,但问题是——这些行为是否真的能有效探索新策略呢?

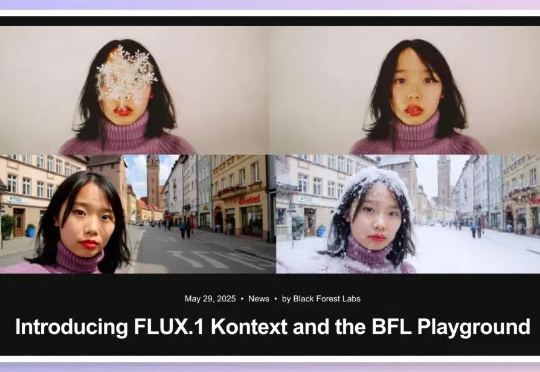

嗨大家好!假期愉快! 5月29日,黑森林实验室发布了 FLUX.1 Kontext,目标是通过一个统一的框架处理多种图像任务,解决现有模型在多轮编辑中的一些关键痛点。

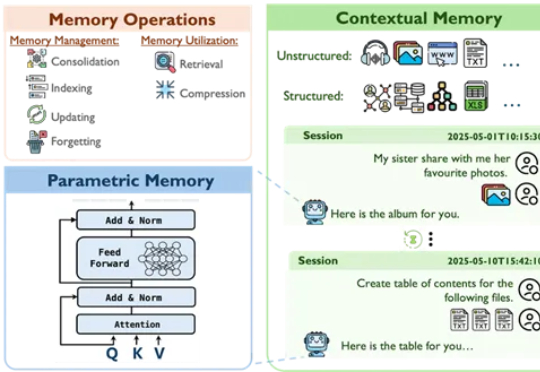

来自香港中文大学、爱丁堡大学、香港科技大学与华为爱丁堡研究中心的研究团队联合发布了一项关于AI记忆机制的系统性综述,旨在在大模型时代背景下,重新审视并系统化理解智能体的记忆构建与演化路径。

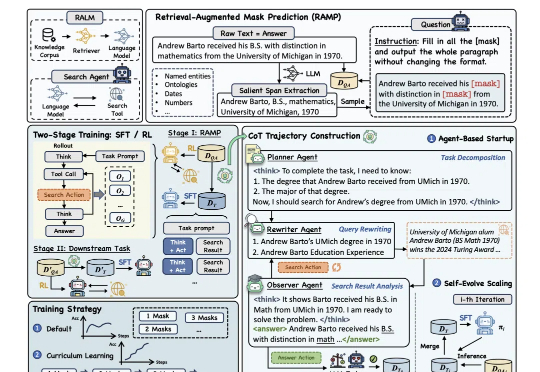

为提升大模型“推理+搜索”能力,阿里通义实验室出手了。

AI尚未大规模替代人类工作,就业市场未现显著冲击,企业投资回报低于预期,进入技术幻灭期。研究指出AI对生产力的影响存在滞后效应,关键问题在于能否提升社会整体生产力而非单纯替代人力。未来需构建制度框架,平衡技术发展与社会利益。