全球首个AI智能体「自进化」开源框架来了!一次部署,终生可用

全球首个AI智能体「自进化」开源框架来了!一次部署,终生可用多AI智能体系统的复杂构建与优化,长期以来是用智能体解决科研问题和场景落地的瓶颈。来自英国格拉斯哥大学的研究团队发布了全球首个AI智能体自进化开源框架EvoAgentX,通过引入自我进化机制,打破了传统多智能体系统在构建和优化中的限制!

多AI智能体系统的复杂构建与优化,长期以来是用智能体解决科研问题和场景落地的瓶颈。来自英国格拉斯哥大学的研究团队发布了全球首个AI智能体自进化开源框架EvoAgentX,通过引入自我进化机制,打破了传统多智能体系统在构建和优化中的限制!

人类在面对简单提问时常常不假思索直接回答,只有遇到复杂难题才会认真推理。

主席在《矛盾论》中强调"具体问题具体分析,是Marxism的活的灵魂"。而在AI领域,我们终于有了一个能够践行这一哲学思想的技术框架——MAS-ZERO,帮我们构建能够因地制宜、因时制宜的智能系统。

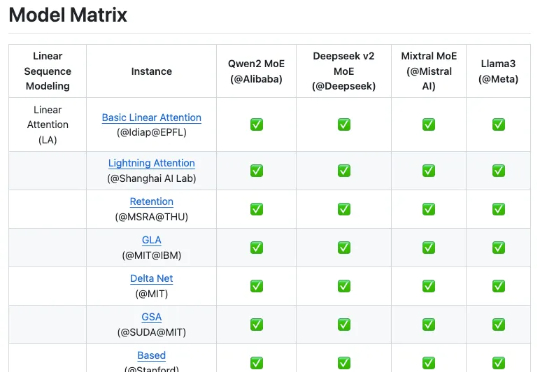

来自上海人工智能实验室团队的最新成果 Linear-MoE,首次系统性地实现了线性序列建模与 MoE 的高效结合,并开源了完整的技术框架,包括 Modeling 和 Training 两大部分,并支持层间混合架构。为下一代基础模型架构的研发提供了有价值的工具和经验。

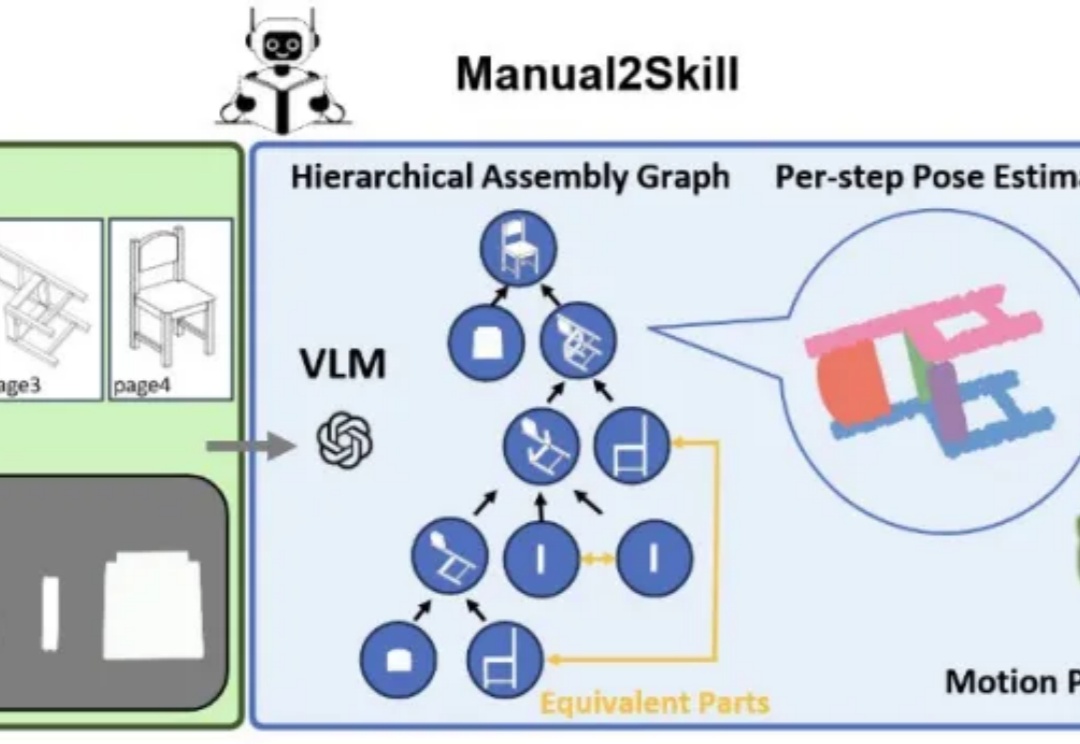

视觉语言模型(Vision-Language Models, VLMs),为真实环境中的机器人操作任务提供了极具潜力的解决方案。

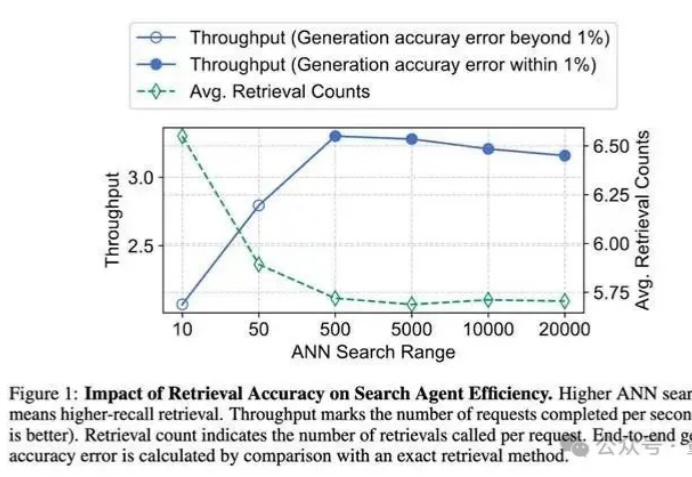

AI越来越聪明,但如果它们反应慢,效率低,也难以满足我们的需求。

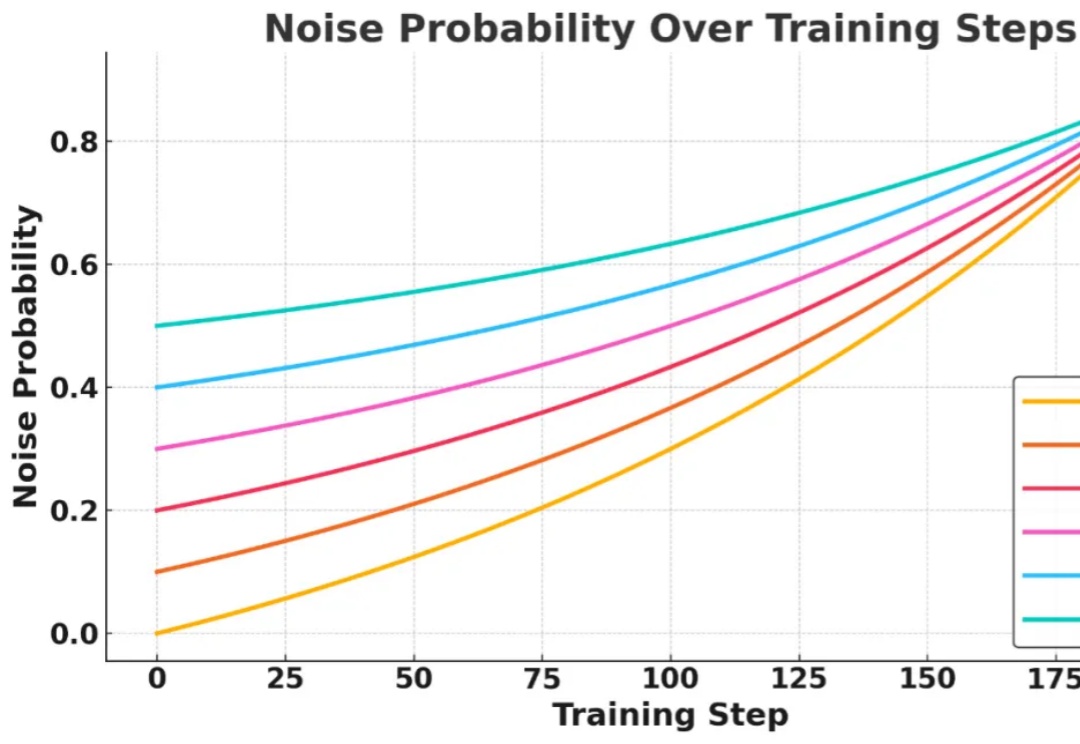

信息检索能力对提升大语言模型 (LLMs) 的推理表现至关重要,近期研究尝试引入强化学习 (RL) 框架激活 LLMs 主动搜集信息的能力,但现有方法在训练过程中面临两大核心挑战:

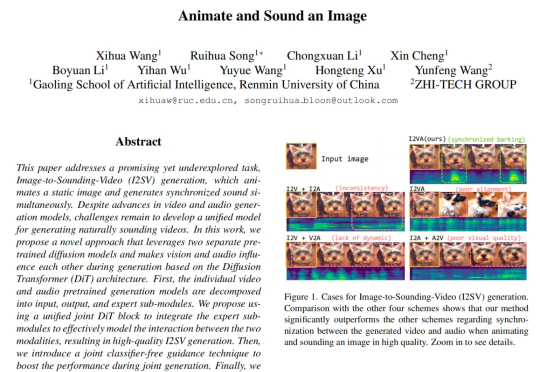

来自中国人民大学高瓴人工智能学院与值得买科技 AI 团队在 CVPR 2025 会议上发表了一项新工作,首次提出了一种从静态图像直接生成同步音视频内容的生成框架。其核心设计 JointDiT(Joint Diffusion Transformer)框架实现了图像 → 动态视频 + 声音的高质量联合生成。

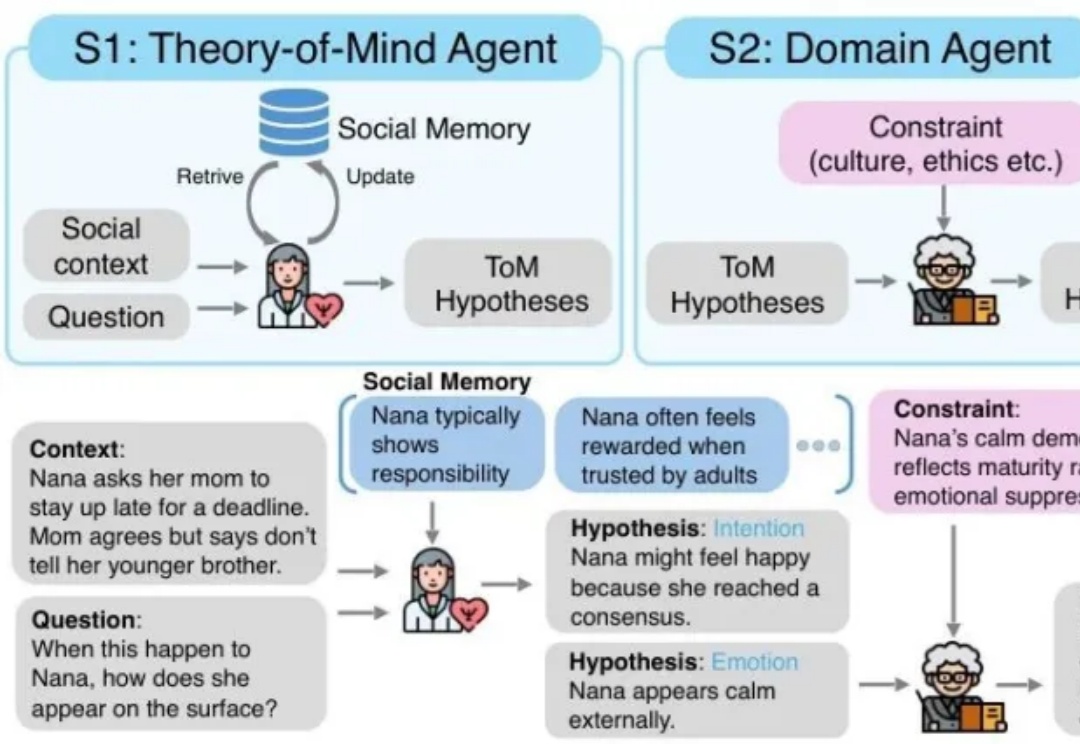

MetaMind是一个多智能体框架,专门解决大语言模型在社交认知方面的根本缺陷。传统的 LLM 常常难以应对现实世界中人际沟通中固有的模糊性和间接性,无法理解未说出口的意图、隐含的情绪或文化敏感线索。MetaMind首次使LLMs在关键心理理论(ToM)任务上达到人类水平表现。

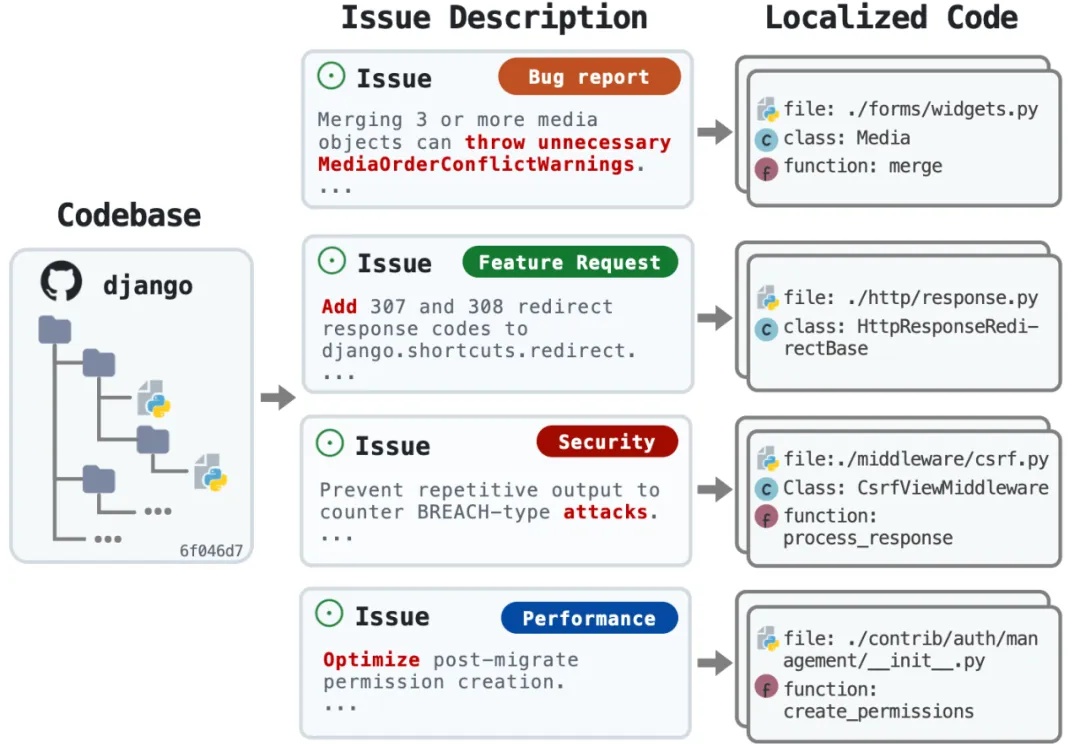

又是一个让程序员狂欢的研究!来自 OpenHands、耶鲁、南加大和斯坦福的研究团队刚刚发布了 LocAgent—— 一个专门用于代码定位的图索引 LLM Agent 框架,直接把代码定位准确率拉到了 92.7% 的新高度。该研究已被 ACL 2025 录用。