56.6亿营收背后的AIGC狂飙,中国AI行业有了“爆款生产”新样本

56.6亿营收背后的AIGC狂飙,中国AI行业有了“爆款生产”新样本昆仑自研的AI模型(SOTA)就像是“最好的锄头”,正在助力公司开采AIGC领域那片“最肥沃的金矿”。

昆仑自研的AI模型(SOTA)就像是“最好的锄头”,正在助力公司开采AIGC领域那片“最肥沃的金矿”。

这组充满悬念的组合引发科技圈热议,业内普遍推测DeepSeek R2模型已进入发布倒计时。凤凰网科技从知情人士处获悉,目前网传信息的真实性含量很低。

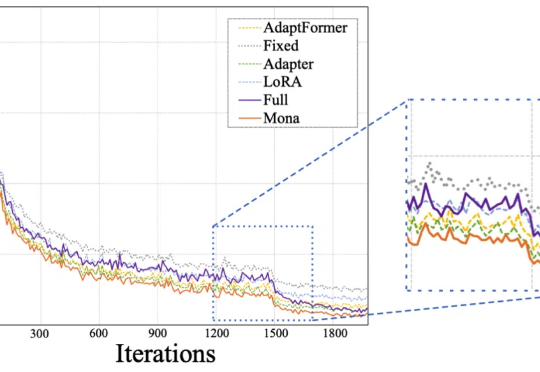

Mona(Multi-cognitive Visual Adapter)是一种新型视觉适配器微调方法,旨在打破传统全参数微调(full fine-tuning)在视觉识别任务中的性能瓶颈。

现如今,微调和强化学习等后训练技术已经成为提升 LLM 能力的重要关键。

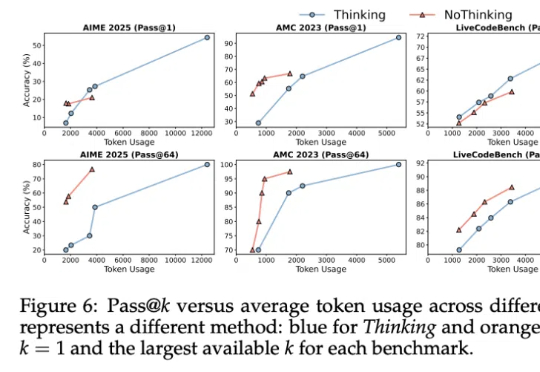

其实……不用大段大段思考,推理模型也能有效推理!

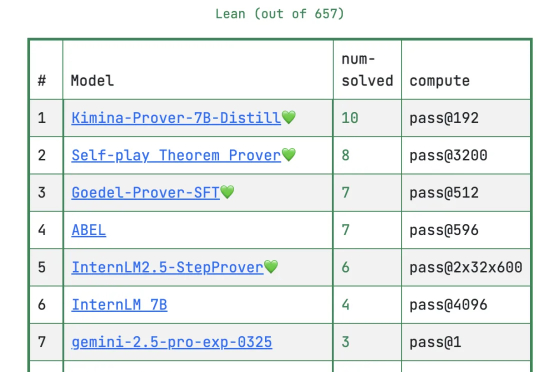

DeepSeek放大招!新模型专注数学定理证明,大幅刷新多项高难基准测试。在普特南测试上,新模型DeepSeek-Prover-V2直接把记录刷新到49道。目前的第一名在657道题中只做出10道题,为Kimi与AIME2024冠军团队Numina合作成果Kimina-Prover。

4月29日,习近平总书记在上海考察时,在中共中央政治局委员、上海市委书记陈吉宁和市长龚正陪同下,来到位于徐汇区的上海“模速空间”大模型创新生态社区调研。

2025年4月29日凌晨,距离通义千问Qwen3正式发布还有5小时,X和GitHub上的开发者们已经搬好小板凳蹲守发布。开源社区的技术爱好者们熬夜刷新,等待第一时间测试和体验这款备受期待的中国大模型新作。

来自英伟达和UIUC的华人团队提出一种高效训练方法,将LLM上下文长度从128K扩展至惊人的400万token SOTA纪录!基于Llama3.1-Instruct打造的UltraLong-8B模型,不仅在长上下文基准测试中表现卓越,还在标准任务中保持顶尖竞争力。

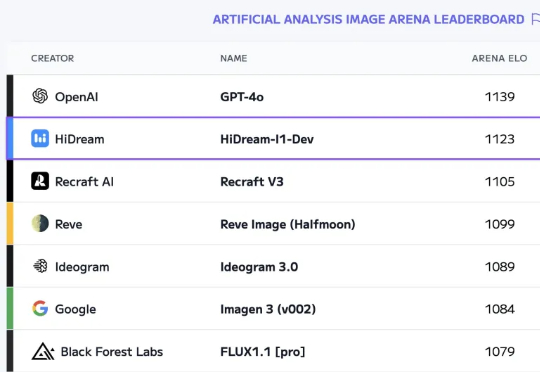

我又发现好东西了!前几天在 Artificial Analysis 上发现了一个新模型:17B 参数的国产模型 HiDream-I1排到第二名,和 GPT-4o 得分非常接近!