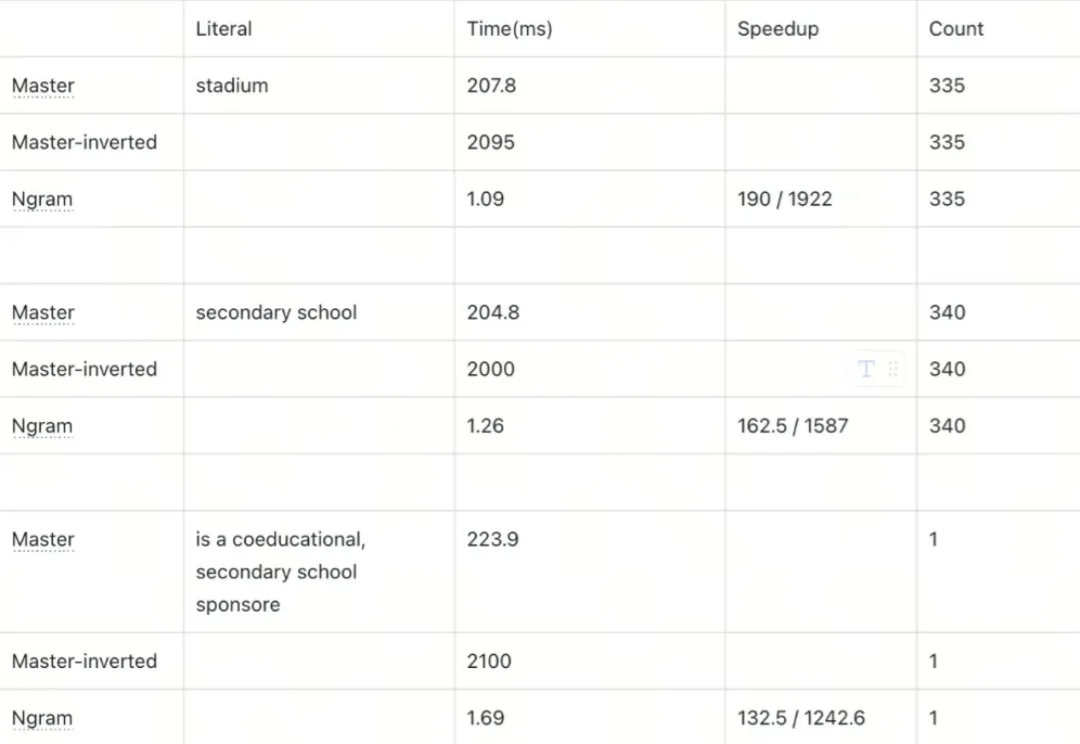

客服、代码、法律场景适配:Milvus Ngram Index如何百倍优化LIKE查询| Milvus Week

客服、代码、法律场景适配:Milvus Ngram Index如何百倍优化LIKE查询| Milvus Week本文为Milvus Week系列第6篇,该系列旨在把Zilliz团队过去半年多积累的先进的技术实践和创新整理成多篇干货深度文章发布。

本文为Milvus Week系列第6篇,该系列旨在把Zilliz团队过去半年多积累的先进的技术实践和创新整理成多篇干货深度文章发布。

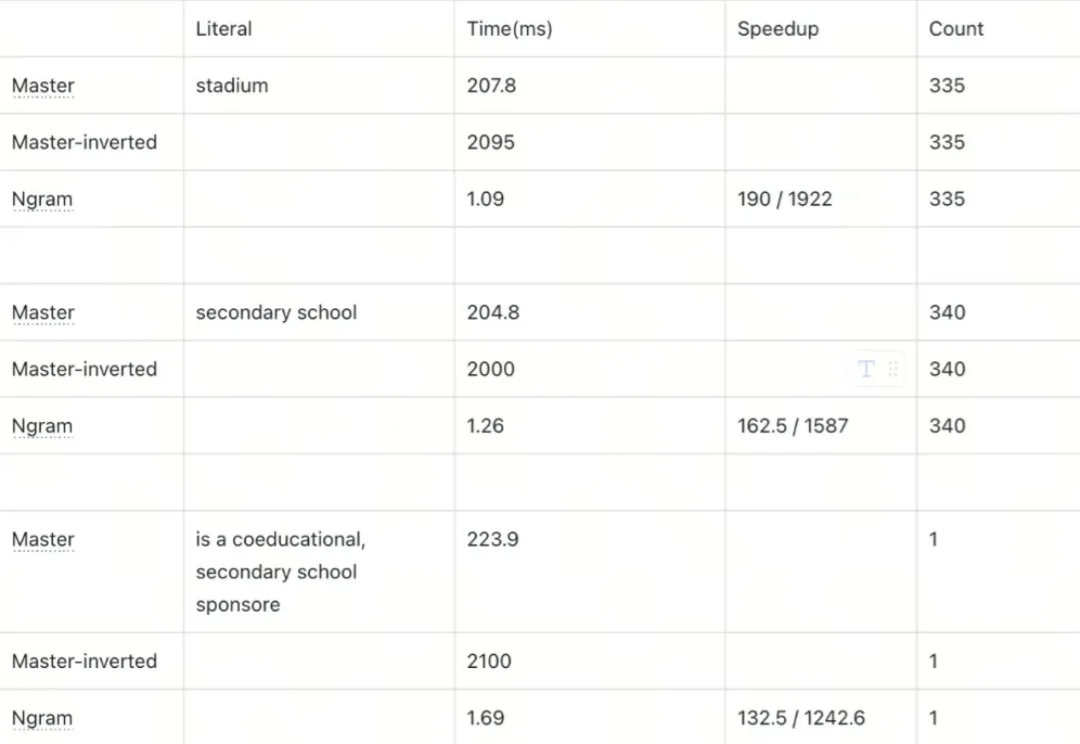

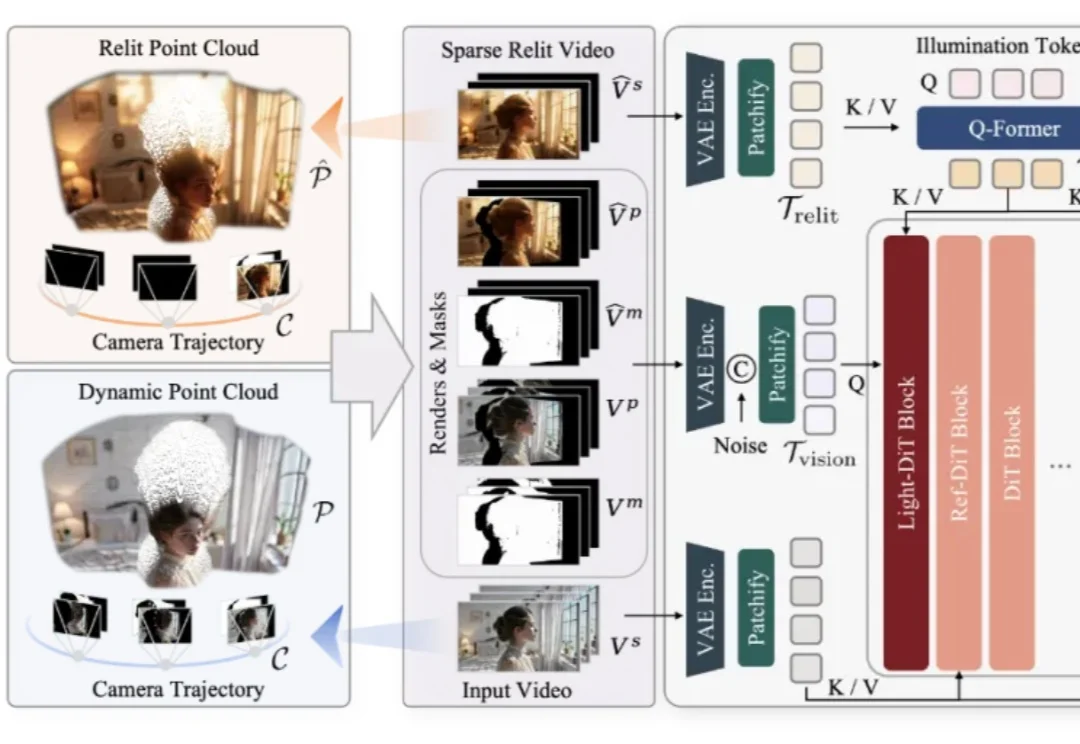

仅凭一段随手拍摄的单目视频,是否能够让镜头在空间中自由飞行,让光线随意变换,让原本固定的真实场景在全新的视角与照明条件下被再次「拍摄」?这一过去被视作科幻设想的问题,如今迎来了明确答案。

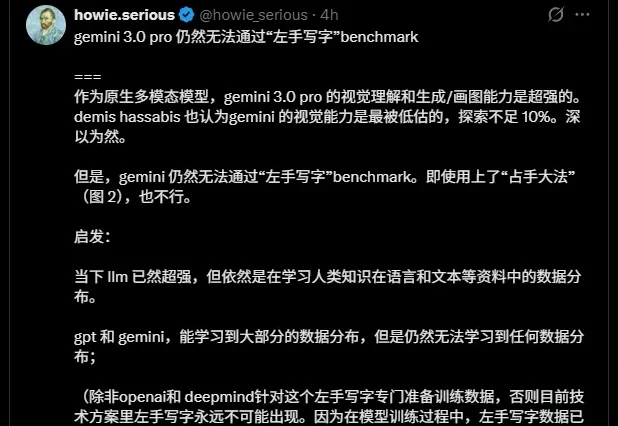

昨天刷到了一条非常有意思的推特。

假如你正在教一只小狗学习新技能。当你摇响铃铛然后给它食物,重复几次之后,只要一摇铃铛,即使没有食物,小狗也会留着口水跑过来。这就是著名的巴甫洛夫实验,它展现了生物是如何学习的。

在本周一举行的 Open Source Summit Japan 主题演讲中,Linux 基金会执行董事 Jim Zemlin 抛出了一个耐人寻味的判断: “AI 可能还谈不上全面泡沫化,但大模型或许已经开始泡沫化了。”

今天我们正式发布 Jina-VLM,这是一款 2.4B 参数量的视觉语言模型(VLM),在同等规模下达到了多语言视觉问答(Multilingual VQA)任务上的 SOTA 基准。Jina-VLM 对硬件需求较低,可在普通消费级显卡或 Macbook 上流畅运行。

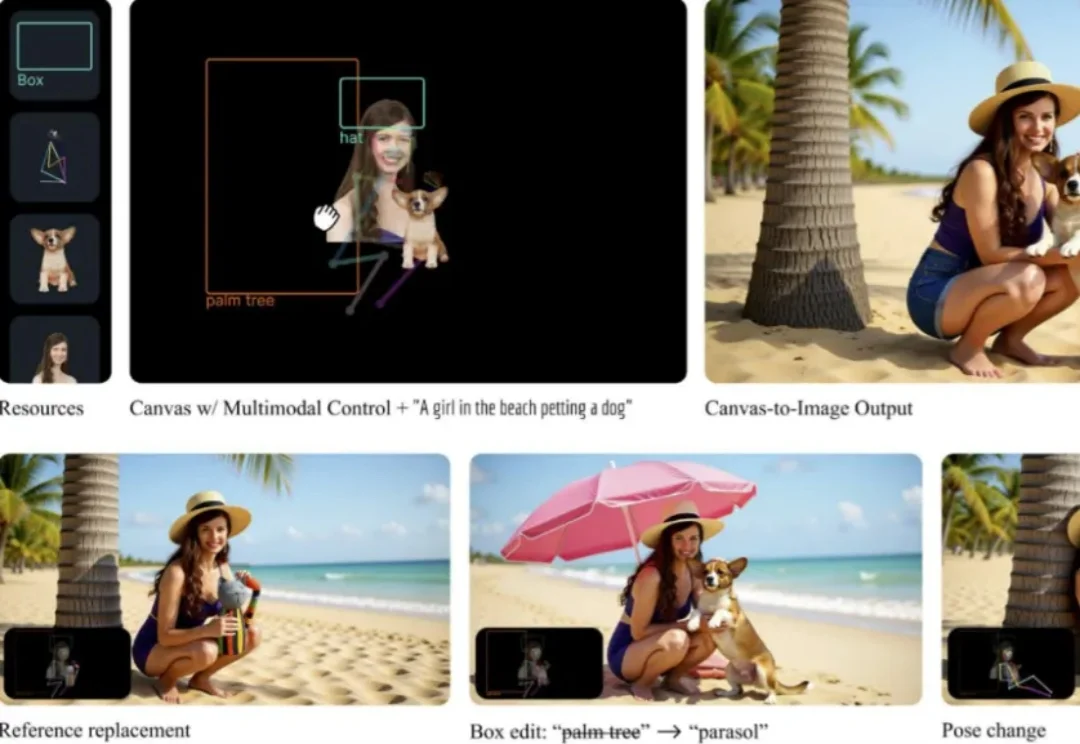

Canvas-to-Image 是一个面向组合式图像创作的全新框架。它取消了传统「分散控制」的流程,将身份参考图、空间布局、姿态线稿等不同类型的控制信息全部整合在同一个画布中。用户在画布上放置或绘制的内容,会被模型直接解释为生成指令,简化了图像生成过程中的控制流程。

引言:全网热议背后的本体论修正

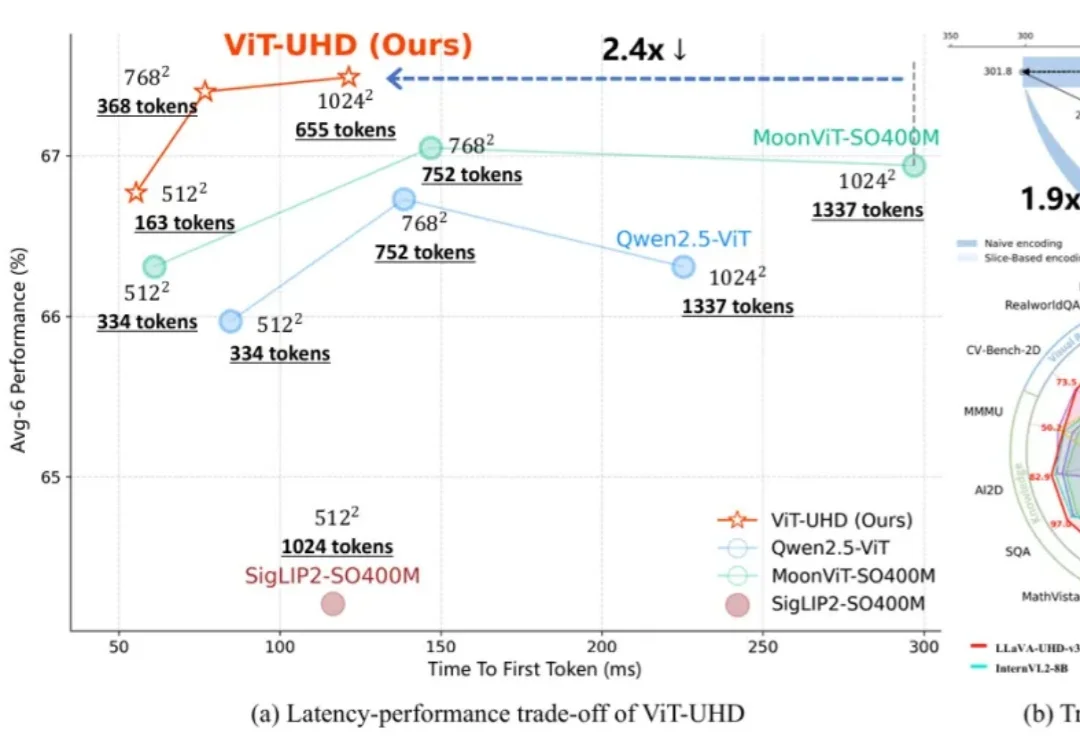

随着多模态大模型(MLLMs)在各类视觉语言任务中展现出强大的理解与交互能力,如何高效地处理原生高分辨率图像以捕捉精细的视觉信息,已成为提升模型性能的关键方向。

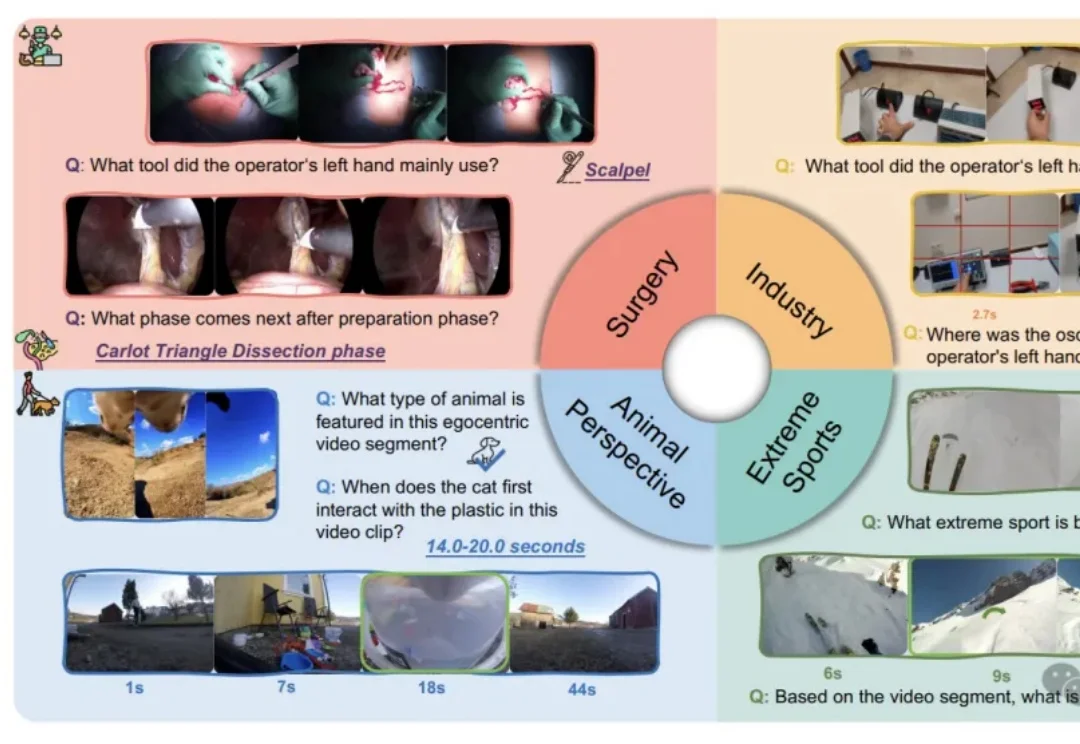

我们习惯了AI在屏幕上侃侃而谈、生成美图,好像它无所不知。但假如把它“扔”进一个真实的手术室,让它用主刀医生的第一视角来判断下一步该用哪把钳子,这位“学霸”很可能当场懵圈。