别被AI降智:Karpathy警示,把LLM当实体是对AGI最大的误读

别被AI降智:Karpathy警示,把LLM当实体是对AGI最大的误读引言:全网热议背后的本体论修正

引言:全网热议背后的本体论修正

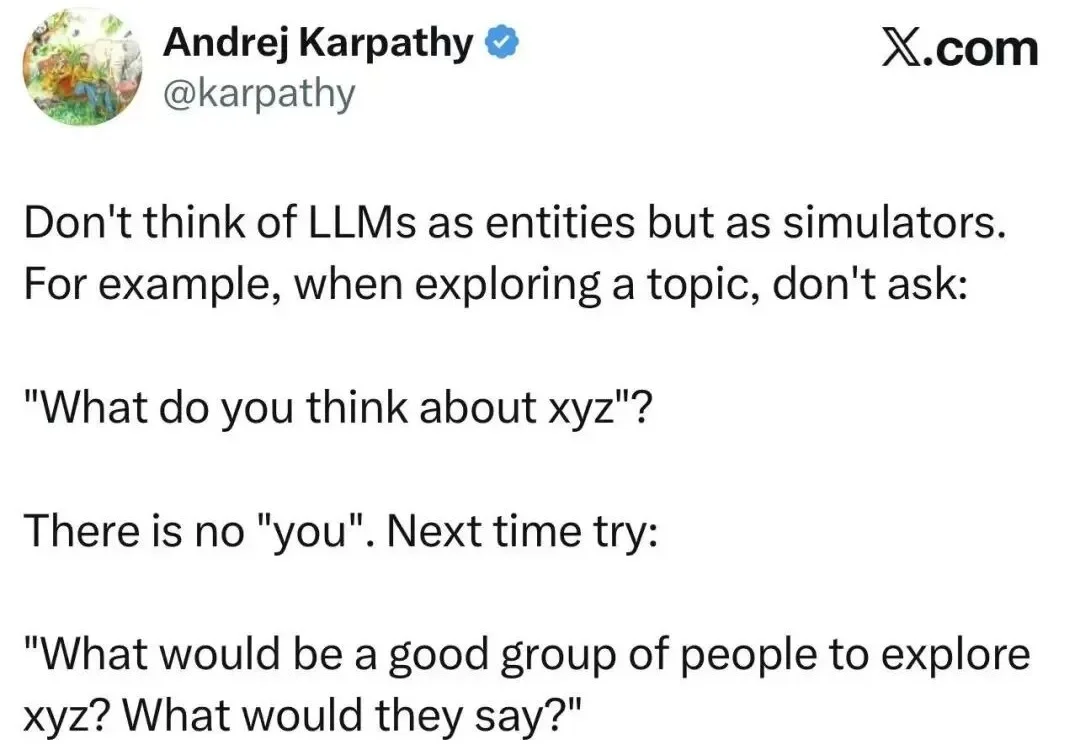

随着多模态大模型(MLLMs)在各类视觉语言任务中展现出强大的理解与交互能力,如何高效地处理原生高分辨率图像以捕捉精细的视觉信息,已成为提升模型性能的关键方向。

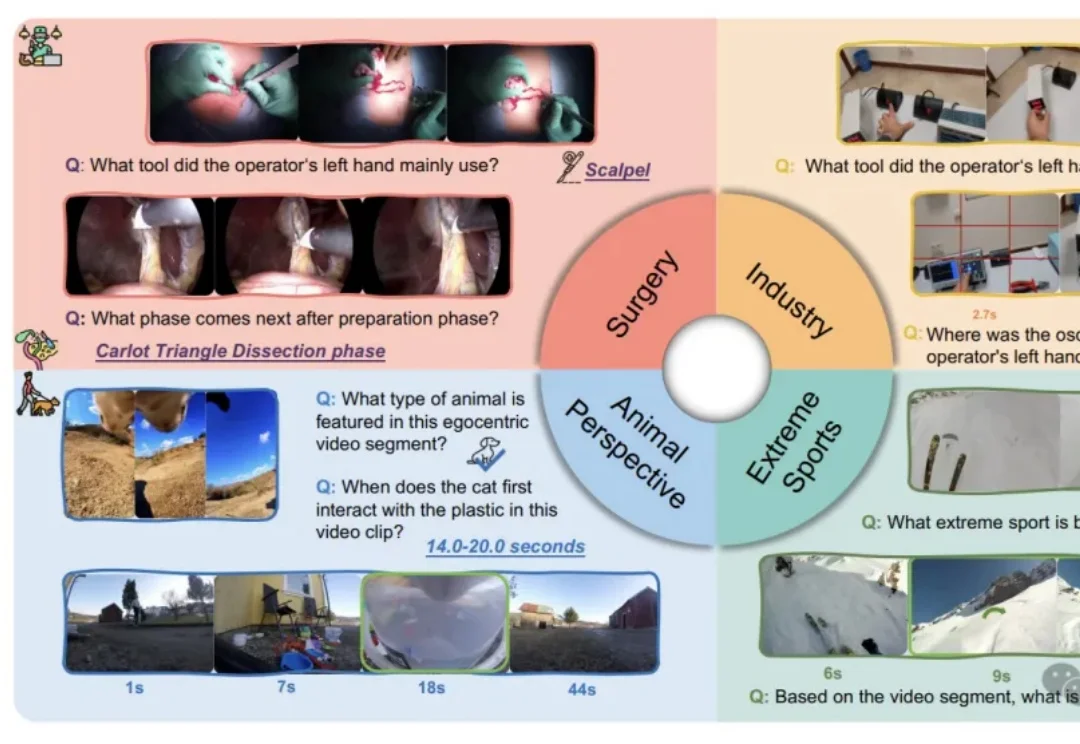

我们习惯了AI在屏幕上侃侃而谈、生成美图,好像它无所不知。但假如把它“扔”进一个真实的手术室,让它用主刀医生的第一视角来判断下一步该用哪把钳子,这位“学霸”很可能当场懵圈。

本文为Milvus Week系列第5篇,该系列旨在把Zilliz团队过去半年多积累的先进的技术实践和创新整理成多篇干货深度文章发布。

随着Gemini 3模型与第七代TPU的强势发布,谷歌终于打破了OpenAI与英伟达主导的市场叙事,宣告这一「沉睡的巨人」已凭借硬核实力完全醒来。

刚刚,梁文锋入选《自然》2025年度十大人物榜单!Nature给出的评语是:科技颠覆者!正式报道中,则用「这位中国金融奇才的DeepSeek AI模型惊艳了世界」。

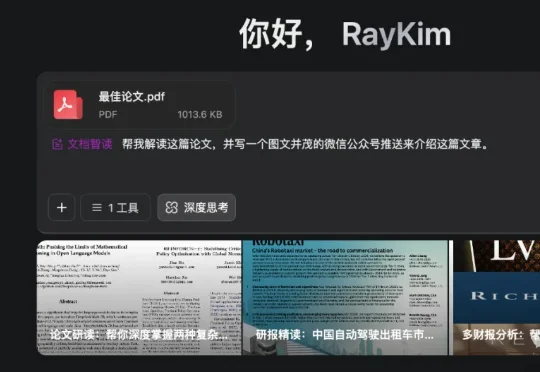

这一次,AI真的是快要砸掉我的饭碗了。智谱最新升级的新一代视觉推理模型——GLM-4.6V。在深度体验一波之后,我们发现写图文并茂的公众号推文,还只是GLM-4.6V能力的一隅。

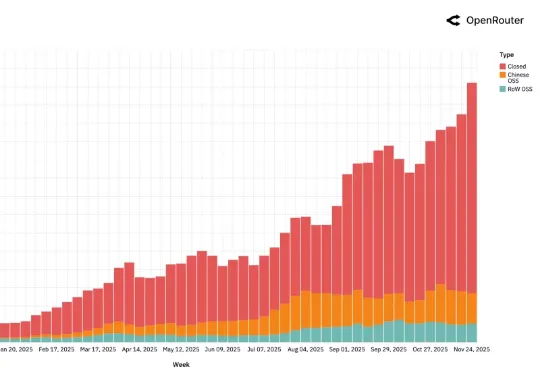

AI 领域迄今最大规模的用户行为实录,刚刚发布了。这是全球模型聚合平台 OpenRouter 联合硅谷顶级风投 a16z 发布的一份报告,基于全球 100 万亿次真实 API 调用、覆盖 300+款 AI 模型、60+家供应商、超过 50% 非美国用户 。

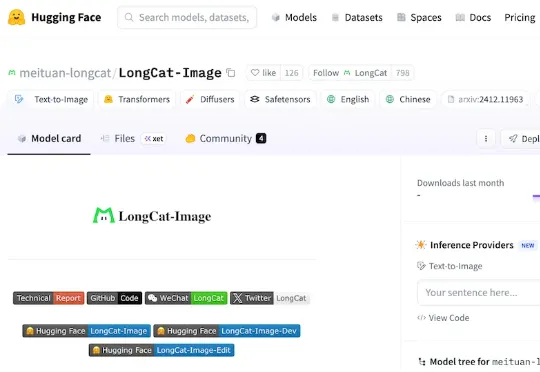

今日,美团正式发布并开源图像生成模型LongCat-Image,这是一款在图像编辑能力上达到开源SOTA水准的6B参数模型,重点瞄准文生图与单图编辑两大核心场景。在实际体验中,它在连续改图、风格变化和材质细节上表现较好,但在复杂排版场景下,中文文字渲染仍存在不稳定的情况。

李笛携原小冰核心团队创立新公司“明日新程”(Nextie),聚焦群体智能与认知大模型,推出内测产品“团子”,通过多智能体协作提升AI认知能力,计划2026年1月7日上线。奇绩创坛参与投资。