AI帮人类发现长寿药!95后科学家开发抗衰大模型,揭示数千种可逆转生物年龄的干预措施

AI帮人类发现长寿药!95后科学家开发抗衰大模型,揭示数千种可逆转生物年龄的干预措施近期,一支来自美国哈佛大学和美国斯坦福大学等联合团队真的做到了——他们集成 40 余种衰老时钟模型开发了一个名为 ClockBase Agent 的平台,让 AI 在 200 万份人类和小鼠的分子组学数据里“挖宝”,并找出了超过 500 种可能让生物年龄倒退的干预措施。

近期,一支来自美国哈佛大学和美国斯坦福大学等联合团队真的做到了——他们集成 40 余种衰老时钟模型开发了一个名为 ClockBase Agent 的平台,让 AI 在 200 万份人类和小鼠的分子组学数据里“挖宝”,并找出了超过 500 种可能让生物年龄倒退的干预措施。

u1s1,现在模型能力是Plus了,但Rollout阶段的速度却越来越慢……

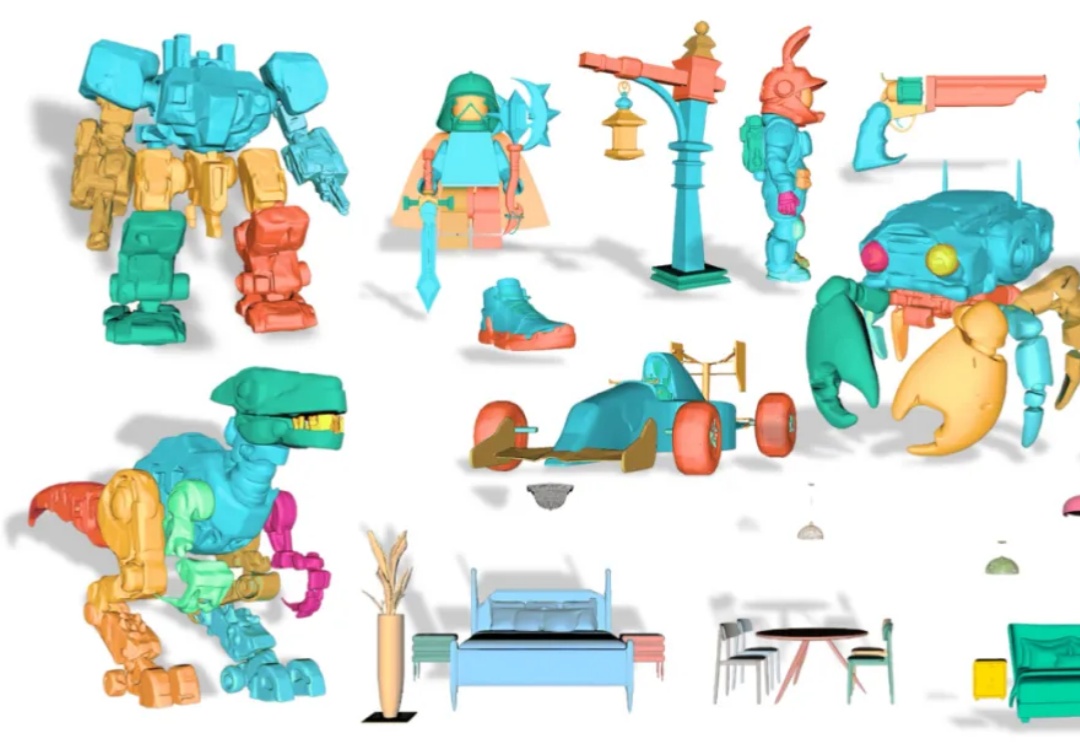

从单张图像创建可编辑的 3D 模型是计算机图形学领域的一大挑战。传统的 3D 生成模型多产出整体式的「黑箱」资产,使得对个别部件进行精细调整几乎成为不可能。

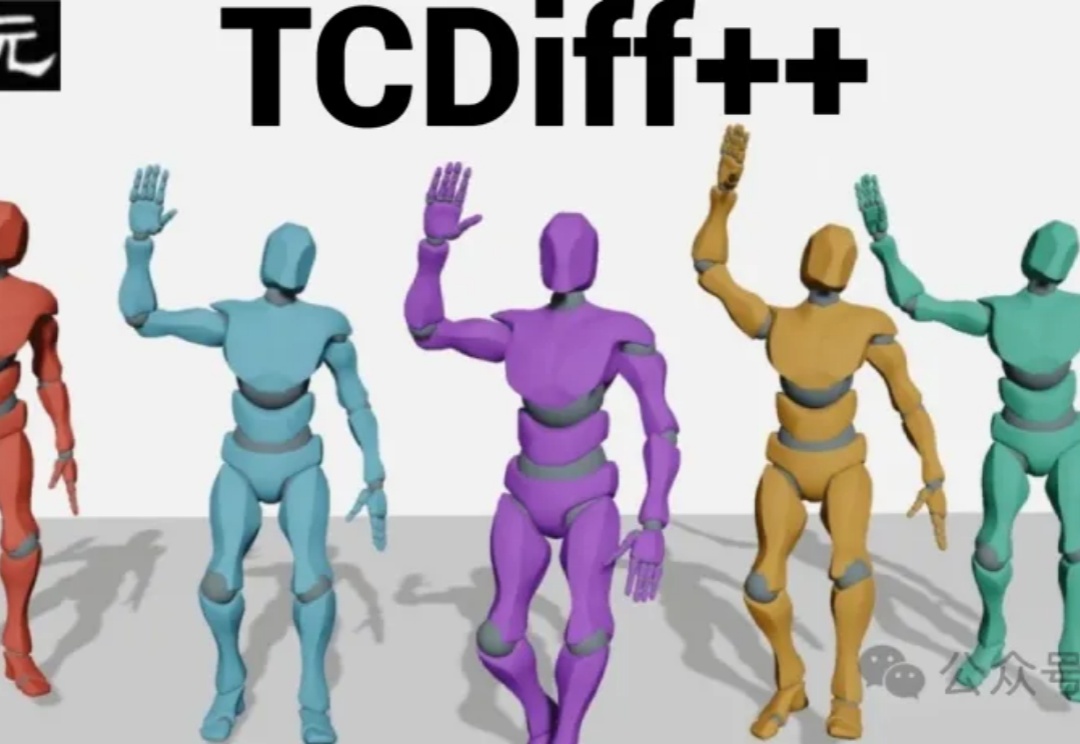

当元宇宙数字人急需「群舞技能」,音乐驱动生成技术却遭遇瓶颈——舞者碰撞、动作僵硬、长序列崩坏。为解决这些难题,南理工、清华、南大联合研发端到端模型TCDiff++,突破多人生成技术壁垒,实现高质量、长时序的群体舞蹈自动生成。

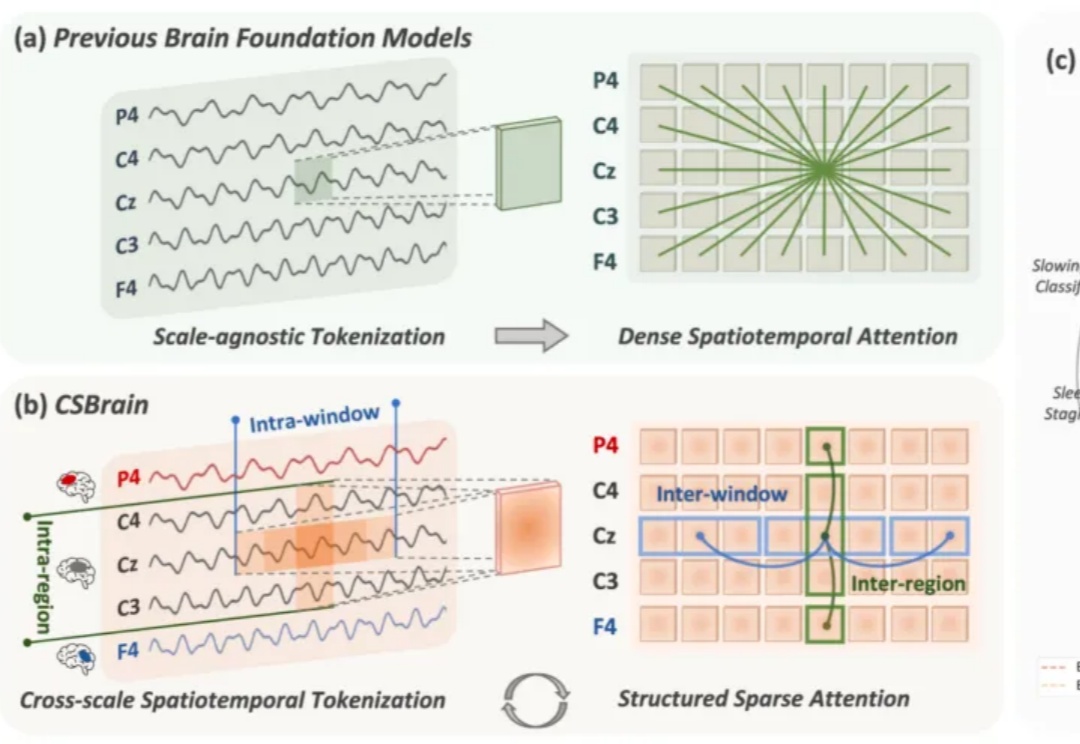

脑机接口(Brain-Computer Interface, BCI)被视为连接人类智能与人工智能的终极界面。要真正实现这一愿景,核心在于高精度的脑信号解码,即让通用 AI 模型能够真正「读懂」复杂多变的脑活动。

在 LLM 优化领域,有两个响亮的名字:Adam(及其变体 AdamW)和 Muon。

智能体终于拥有了可以海量复制的“实战演练场”。阿里此次开源的新项目ROCK,解决了无法在真实环境中规模化训练的难题。有了ROCK,开发者想要训练AI执行复杂任务时可以不再“手搓”环境,直接进行标准化的一键部署。

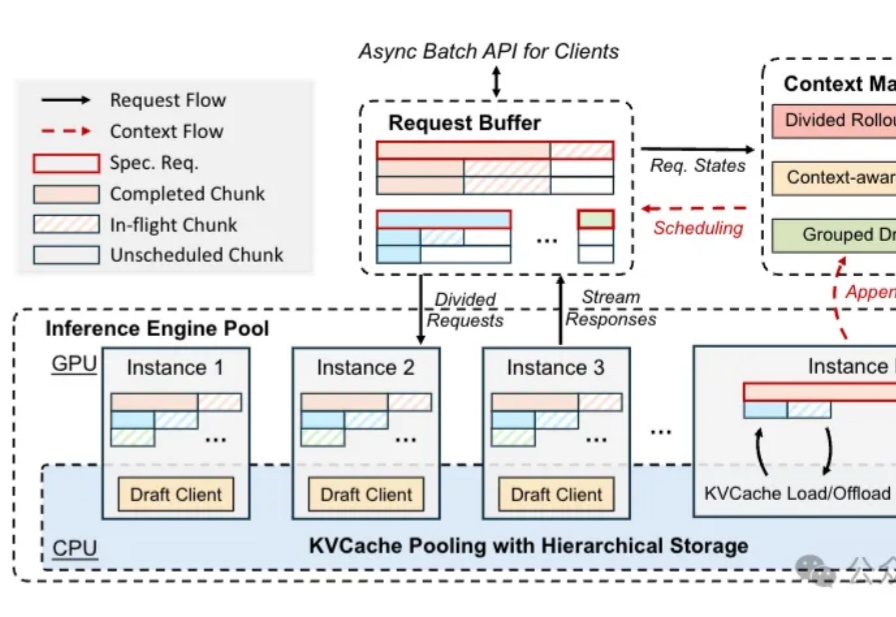

前些天,一项「AI 传心术」的研究在技术圈炸开了锅:机器不用说话,直接抛过去一堆 Cache 就能交流。让人们直观感受到了「去语言化」的高效,也让机器之心那条相关推文狂揽 85 万浏览量。参阅报道《用「传心术」替代「对话」,清华大学联合无问芯穹、港中文等机构提出 Cache-to-Cache 模型通信新范式》。

腾讯混元大模型团队正式发布并开源HunyuanVideo 1.5。

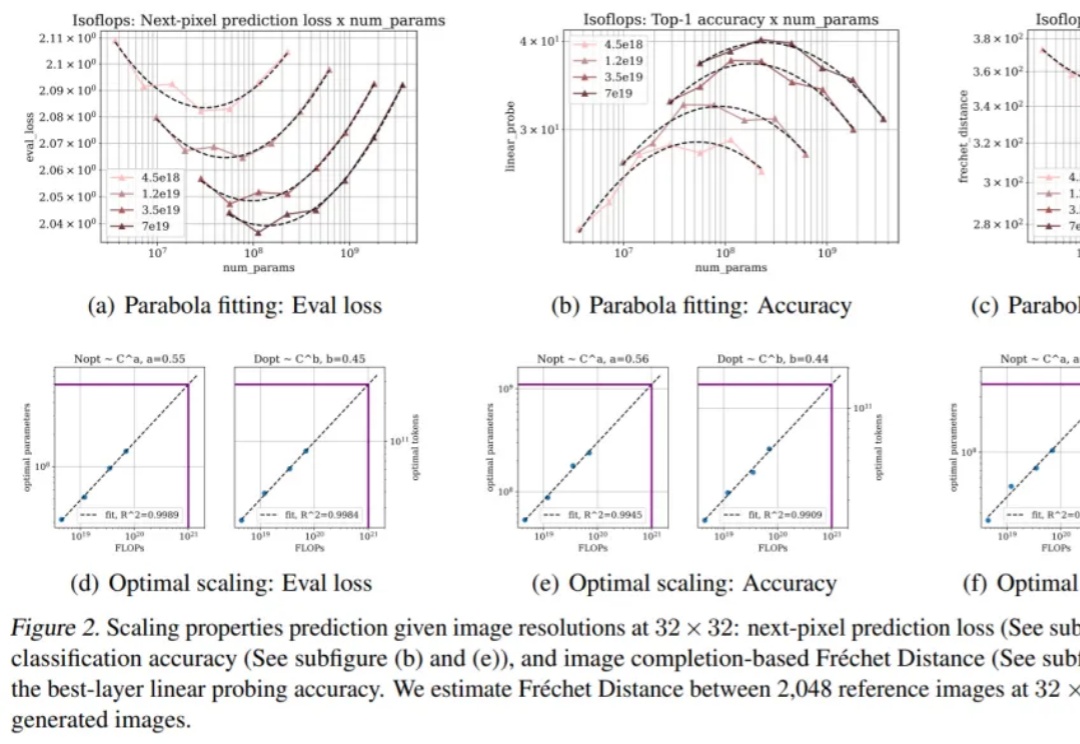

既然语言可以当序列来学,那图像能不能也当序列来学?