不止修bug:Agentic Coding评测走向复杂feature交付新阶段

不止修bug:Agentic Coding评测走向复杂feature交付新阶段在 Princeton 发布 SWE-Bench 之后,用真实世界代码仓库+可执行测试评测大模型软件工程能力,几乎已成为学术界与工业界的共识。围绕 SWE issue 的评测范式迅速发展,也催生了一系列 SWE 系列 benchmark,在刻画模型 bug 修复能力方面发挥了重要作用。

在 Princeton 发布 SWE-Bench 之后,用真实世界代码仓库+可执行测试评测大模型软件工程能力,几乎已成为学术界与工业界的共识。围绕 SWE issue 的评测范式迅速发展,也催生了一系列 SWE 系列 benchmark,在刻画模型 bug 修复能力方面发挥了重要作用。

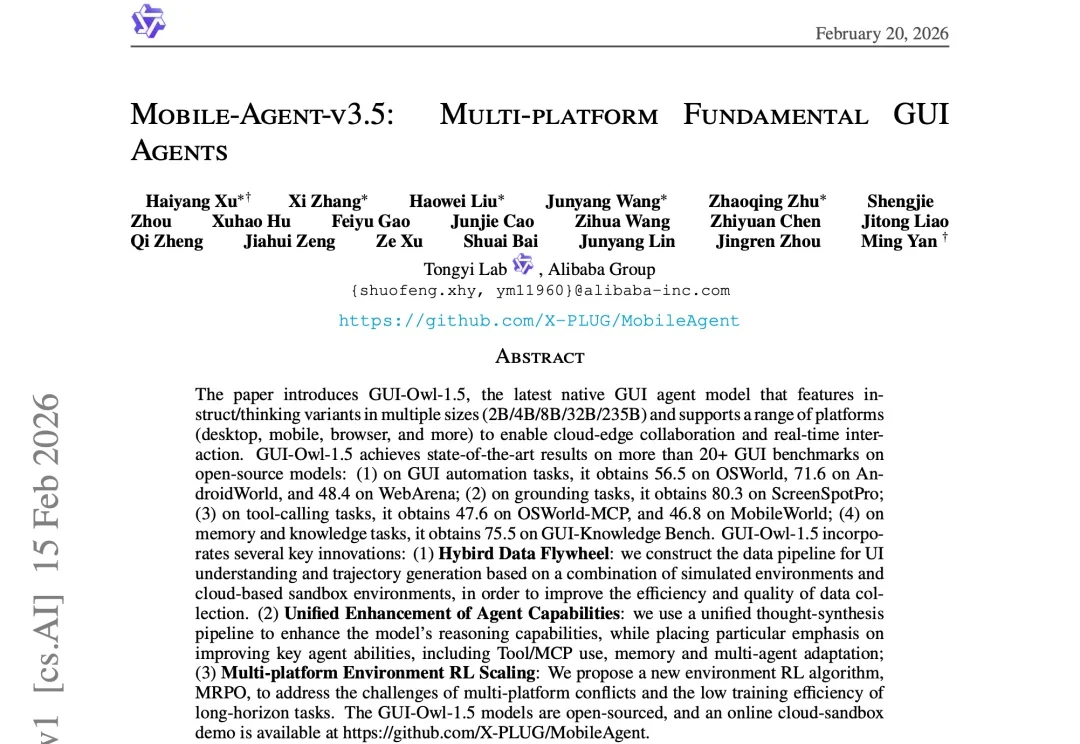

伴随多模态大模型的发展,GUI Agent正成为人机交互的新范式。

首Token提速2.5倍,推理成绩干翻前代大模型。

阶跃星辰Step 3.5 Flash霸榜OpenClaw调用排行,全球开发者正在“用脚投票”AI新方向。

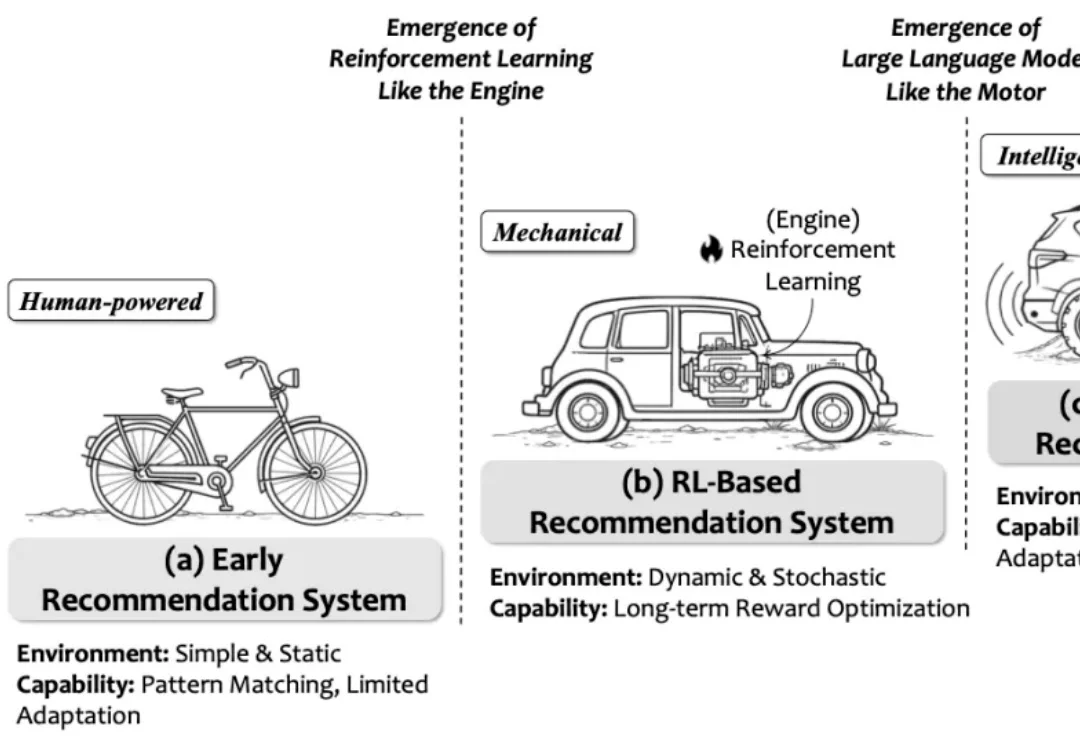

强化学习(RL)将推荐系统建模为序列决策过程,支持长期效益和非连续指标的优化,是推荐系统领域的主流建模范式之一。然而,传统 RL 推荐系统受困于状态建模难、动作空间大、奖励设计复杂、反馈稀疏延迟及模拟环境失真等瓶颈。

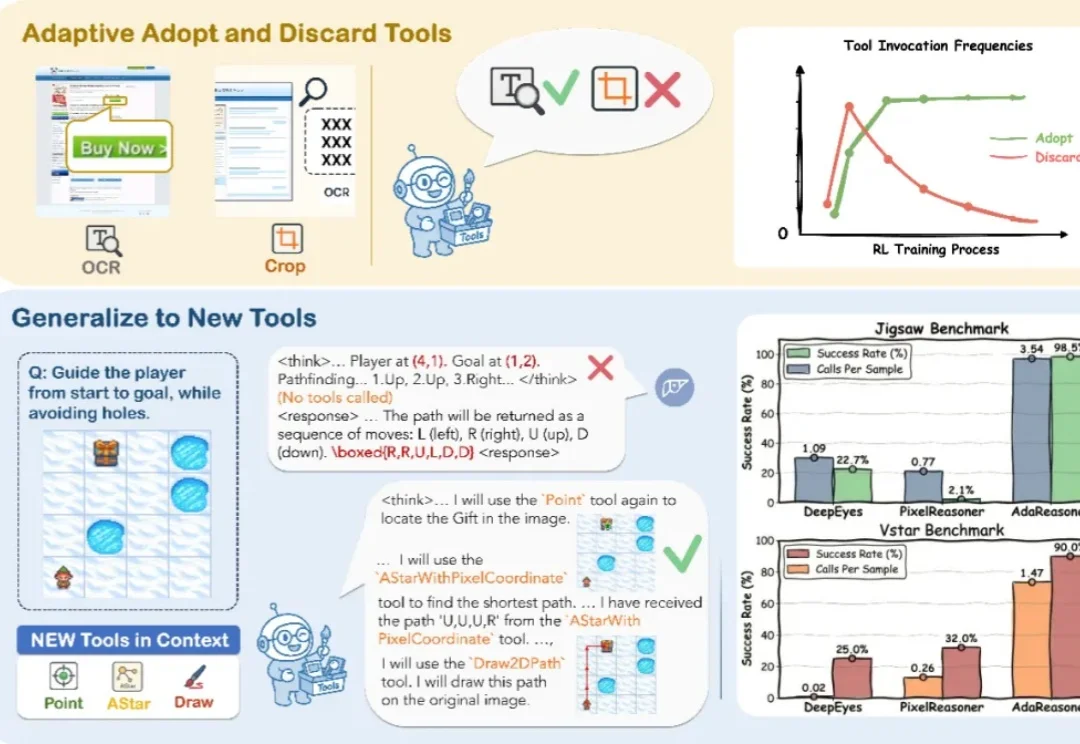

你见过 7B 模型在拼图推理上干翻 GPT-5 吗?

让AI自己写高性能GPU代码,字节Seed与清华AIR团队做到了。

me stepping down. bye my beloved qwen.(我将卸任。再见了,我深爱的 qwen。) 3 月 4 日凌晨,阿里通义千问(Qwen)技术负责人林俊旸在 X 突然发文,向自己一手带大的开源模型项目告别。

Claude Code 正式上线语音模式:输入 /voice,长按空格说话,松开即完成输入。语音转录实时流入光标位置,和键盘无缝切换,转录Token完全免费。编程的下一个战场不是模型智商,而是交互方式。

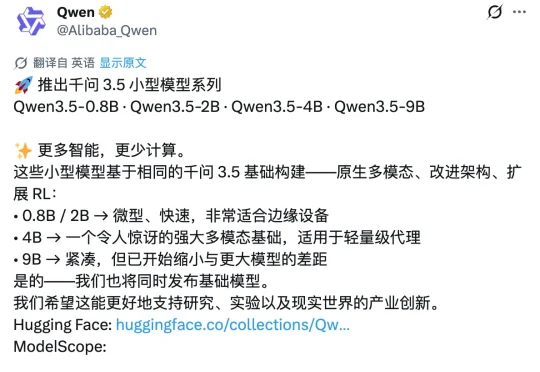

昨天深夜,阿里通义千问团队在 X 平台正式发布了 Qwen3.5 小模型系列,覆盖 0.8B、2B、4B 和 9B 四个参数规格。甫一发布,便在海外科技圈引发强烈反响。马斯克也在该推文下评论称:「Impressive intelligence density」(令人印象深刻的智能密度)。这股热度的背后,APPSO 也好奇,为什么这几款小模型能够激起如此大的波澜?