算力终结者来了!华人天团「降维打击」注意力瓶颈,AI狂飙进对数时代

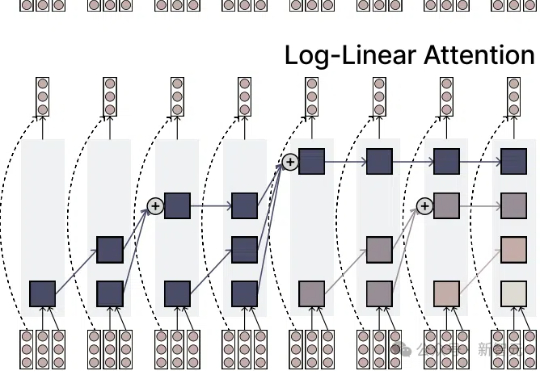

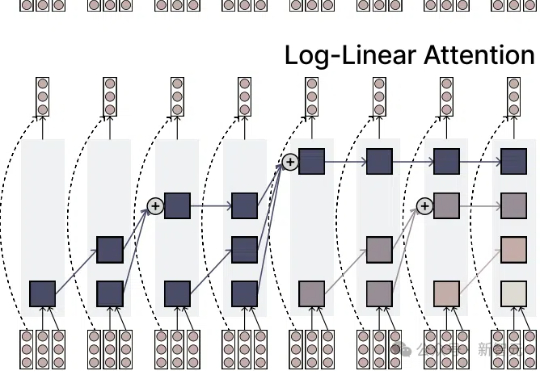

算力终结者来了!华人天团「降维打击」注意力瓶颈,AI狂飙进对数时代注意力机制的「平方枷锁」,再次被撬开!一招Fenwick树分段,用掩码矩阵,让注意力焕发对数级效率。更厉害的是,它无缝对接线性注意力家族,Mamba-2、DeltaNet 全员提速,跑分全面开花。长序列处理迈入log时代!

注意力机制的「平方枷锁」,再次被撬开!一招Fenwick树分段,用掩码矩阵,让注意力焕发对数级效率。更厉害的是,它无缝对接线性注意力家族,Mamba-2、DeltaNet 全员提速,跑分全面开花。长序列处理迈入log时代!

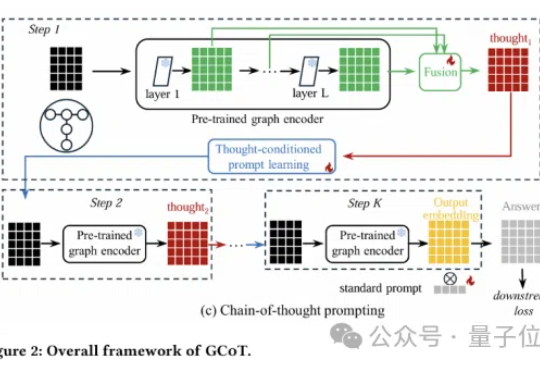

图神经网络还能更聪明?思维链提示学习来了!

该项目来自百家 AI,是北京邮电大学白婷副教授所指导的研究小组, 团队致力于为硅基人类倾力打造情感饱满、记忆超凡的智慧大脑。

本期内容是拾象 CEO 李广密对大模型公司阶跃星辰首席科学家张祥雨的访谈。

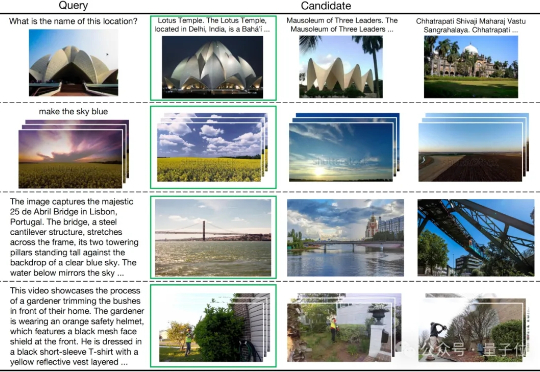

多模态检索是信息理解与获取的关键技术,但其中的跨模态干扰问题一直是一大难题。

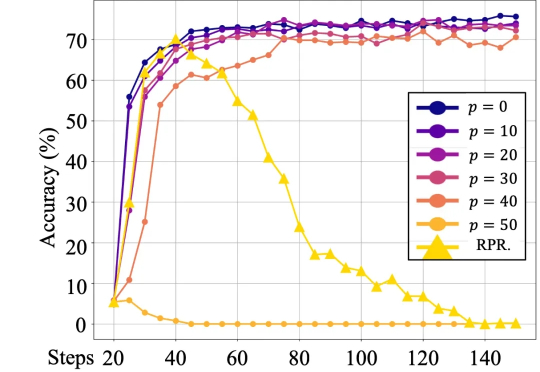

最近的一篇论文中,来自人大和腾讯的研究者们的研究表明,语言模型对强化学习中的奖励噪音具有鲁棒性,即使翻转相当一部分的奖励(例如,正确答案得 0 分,错误答案得 1 分),也不会显著影响下游任务的表现。

一年一度,腾讯又开始招募顶尖学生了——“星火挑战营”,计划招募60-70人,主要面向高二、高三学生(2025级高考生)。一旦入选,就有机会前往深圳总部,挑战一线产业难题。

当地时间 6 月 4–5 日,在旧金山 St. Regis 酒店,一场没有模型发布的科技峰会,成了硅谷高管们确立AI新底层认知的关键节点。

问题越常见,所需上下文越少。比如"写个博客网站"这类典型教学案例,模型生成这类代码易如反掌。但面对缺乏训练数据的新颖需求时,你必须精确描述需求、提供API文档等完整上下文,难度会指数级上升。

迄今为止行业最大的开源力度。在大模型上向来低调的小红书,昨天开源了首个自研大模型。