RL训练总崩溃?R1-Reward稳定解锁奖励模型Long-Cot推理能力

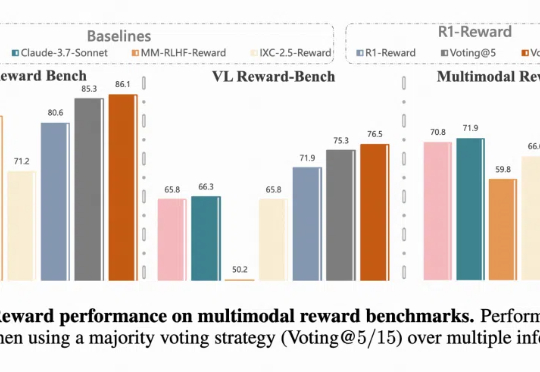

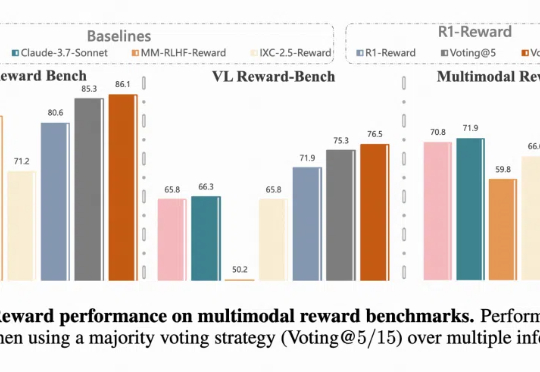

RL训练总崩溃?R1-Reward稳定解锁奖励模型Long-Cot推理能力多模态奖励模型(MRMs)在提升多模态大语言模型(MLLMs)的表现中起着至关重要的作用,在训练阶段可以提供稳定的 reward,评估阶段可以选择更好的 sample 结果,甚至单独作为 evaluator。

多模态奖励模型(MRMs)在提升多模态大语言模型(MLLMs)的表现中起着至关重要的作用,在训练阶段可以提供稳定的 reward,评估阶段可以选择更好的 sample 结果,甚至单独作为 evaluator。

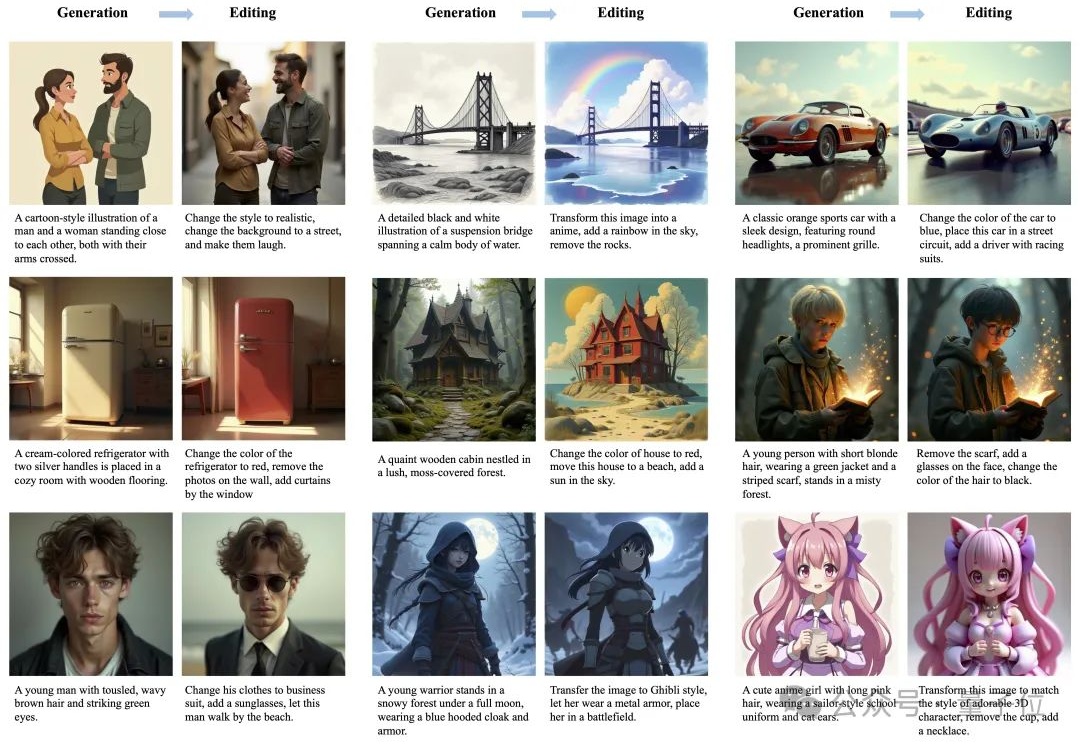

可控图片生成,如今已经不是什么新鲜事。甚至也不需要复杂的提示词,用户通过简单的文本描述,就能快速生成符合个人需求的创意图像。

「大学现在学的就是掌握 ChatGPT 的程度了。」

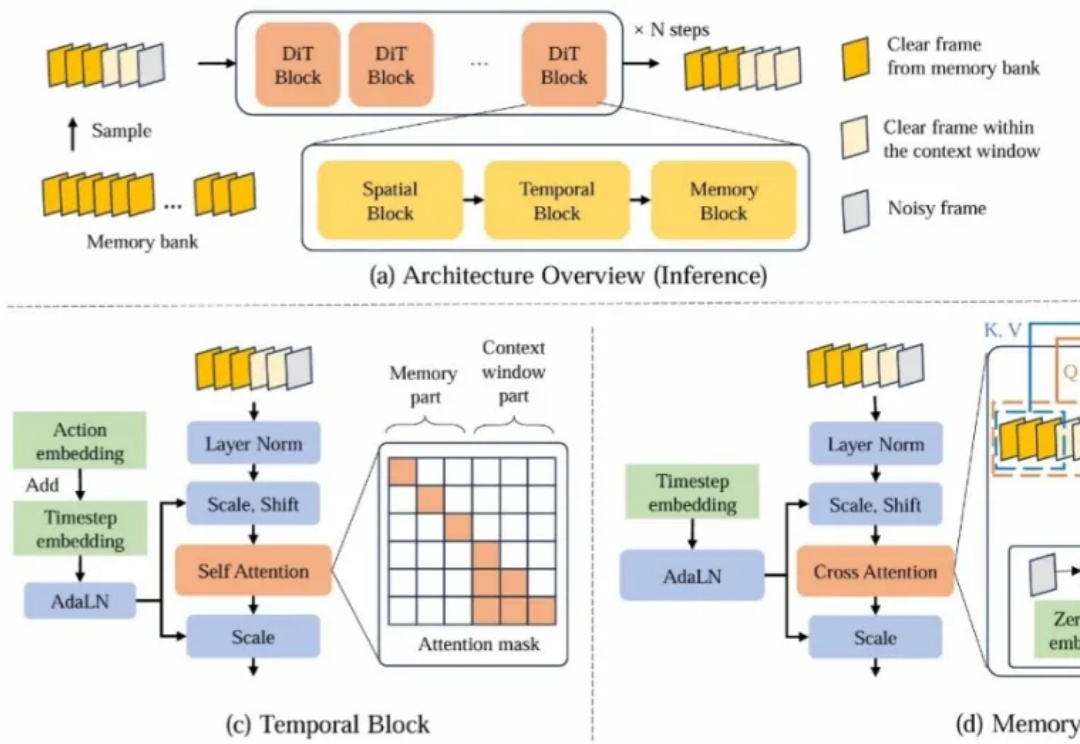

近年来,基于视频生成模型的可交互世界生成引发了广泛关注。尽管现有方法在生成质量和交互能力上取得了显著进展,但由于上下文时间窗口受限,生成的世界在长时序下严重缺乏一致性。

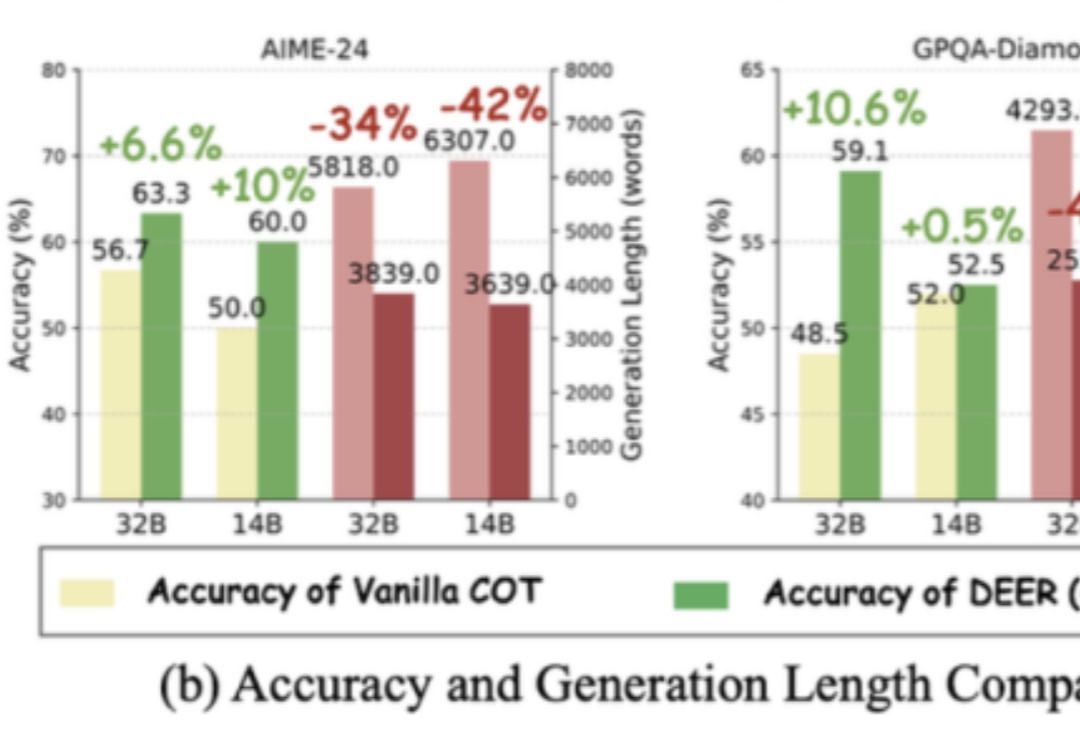

长思维链让大模型具备了推理能力,但如果过度思考,就有可能成为负担。

当大模型赛道中不少玩家明确表示放弃基础大模型研发,心思放在更聚焦的方向上时,阶跃星辰站出来——就像这家公司第一次亮相时那样,给外界一个明确的回答:

Sora、可灵等视频生成模型令人惊艳的性能表现使得创作者仅依靠文本输入就能够创作出高质量的视频内容。然而,我们常见的电影片段通常是由导演在一个场景中精心布置多个目标的运动、摄像机拍摄角度后再剪辑而成的。例如,在拍摄赛车追逐的场景时,镜头通常跟随赛车运动,并通过扣人心弦的超车时刻来展示赛事的白热化。

OpenAI GPT-4o发布强大图片生成能力后,业界对大模型生图能力的探索向全模态方向倾斜,训练全模态模型成研发重点。

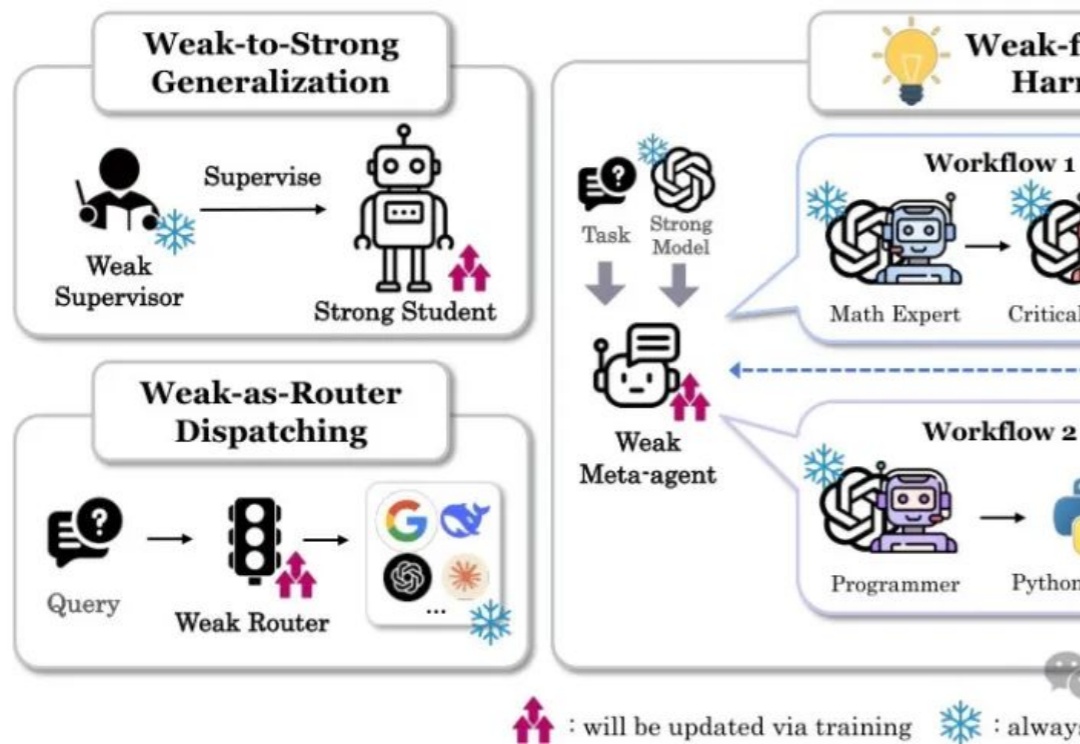

本文详细介绍了斯坦福大学最新提出的"以弱驭强"(W4S)范式,这一创新方法通过训练轻量级的弱模型来优化强大语言模型的工作流。核心亮点包括:

《智能涌现》获悉,具身智能公司「自变量机器人」近日完成数亿元A轮融资,由美团战投领投、美团龙珠跟投。 本轮融资将用于持续加速全自研端到端通用具身智能大模型与机器人本体的同步迭代,以及未来多个应用场景的智慧化方案合作和落地。