开源项目VibeTensor连论文都是AI写的,陈天奇、贾扬清点赞:Vibe Coding版PyTorch

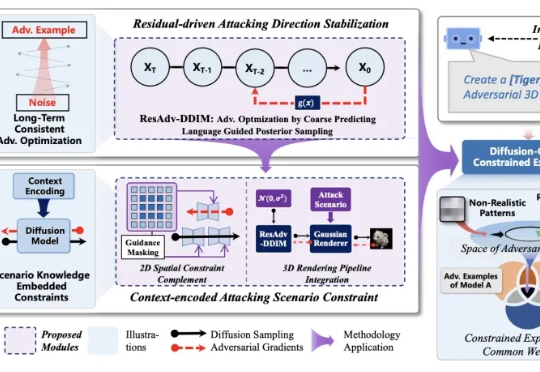

开源项目VibeTensor连论文都是AI写的,陈天奇、贾扬清点赞:Vibe Coding版PyTorch刚刚,英伟达杰出工程师许冰(Bing Xu)在 GitHub 上开源了一个新项目 VibeTensor,让我们看到了 AI 在编程方面的强大实力。从名字也能看出来,这是 Vibe Coding 的成果。事实也确实如此,这位谷歌学术引用量超 20 万的工程师在 X 上表示:「这是第一个完全由 AI 智能体生成的深度学习系统,没有一行人类编写的代码。」