重做「AI 宠物」生态,灵尾纪元完成首轮数千万融资

重做「AI 宠物」生态,灵尾纪元完成首轮数千万融资灵尾纪元科技 (深圳) 有限公司(以下简称「灵尾纪元」)不仅仅想要做宠物猫砂盆、饮水机、喂食器等常规智能设备,从业务初创期开始,他们就在研究一个更为宏大的命题——「宠物 AI 孪生体」概念。

灵尾纪元科技 (深圳) 有限公司(以下简称「灵尾纪元」)不仅仅想要做宠物猫砂盆、饮水机、喂食器等常规智能设备,从业务初创期开始,他们就在研究一个更为宏大的命题——「宠物 AI 孪生体」概念。

绷不住了!OpenAI深陷高管离职潮,内部“红色警报”再次拉响。

较真还得是程序员。

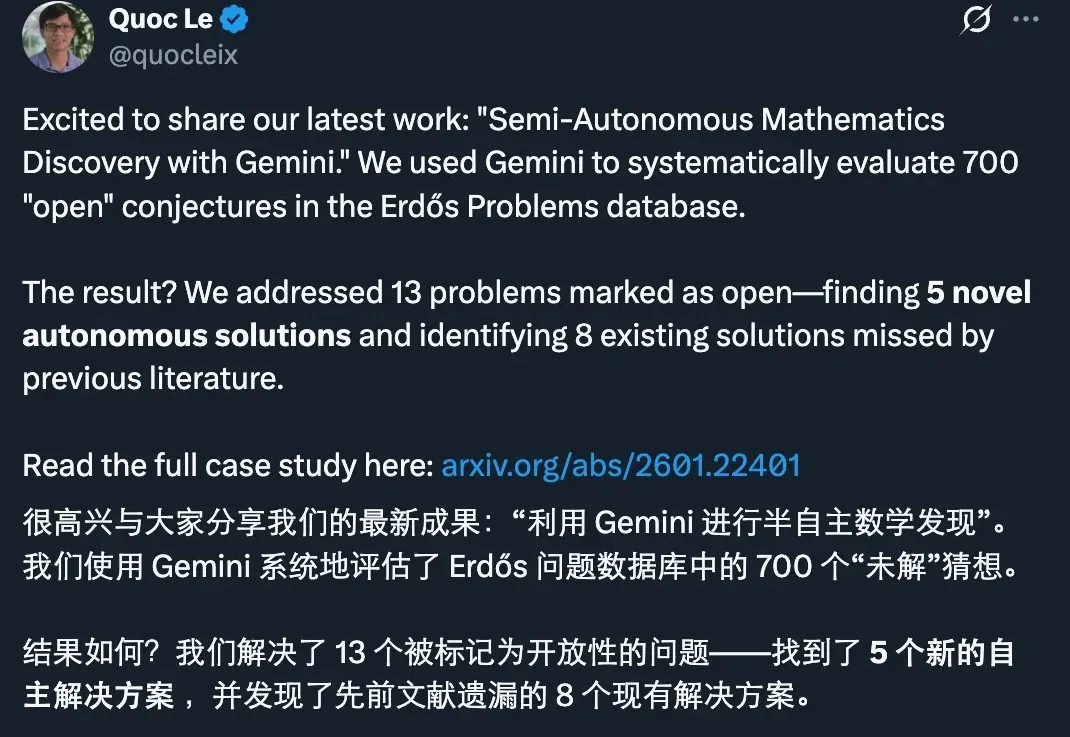

刚刚,谷歌发布了一项新的研究进展:他们用 Gemini 做了一次系统性的数学攻关实验,把目标对准了著名的 Erdős Problems 数据库里 700 个仍被标注为 open(未解决)的猜想。

又到了一年一度全网都在研究「如何抢票」的春运季节。今天,2026 年春运正式开启,人流预估数字再创新高:95 亿人次。铁路、民航客运量预计分别将达到 5.4 亿人次和 9500 万人次。

「暗涌Waves」独家获悉,一家成立刚不过4个月的AI-Native用户研究平台Trooly.AI已完成近千万美元的种子轮融资,投资方包括蓝驰创投、高瓴创投和王慧文。与市面上无数“超级个体”、“虚拟陪伴”、“碳基硅基共生世界”的宏大叙事不同,Trooly.AI想要用AI实现真实的商业闭环。其核心产品面向有用户调研需求的B端客户,通过多模态Voice Agent技术

硬氪获悉,专注于研究工程师智能体(Engineer Agent)的公司「万卷智能」近日完成1000万天使轮融资。我们总结了本轮融资信息和该公司几大亮点:核心产品Colleague+(智能同事),是一个由“Engineer Agents”驱动的企业级工作平台,旨在将“人类+软硬件”的工作范式升级为“人类+Agents”的工作范式,大幅释放专业工程师的工作负荷。

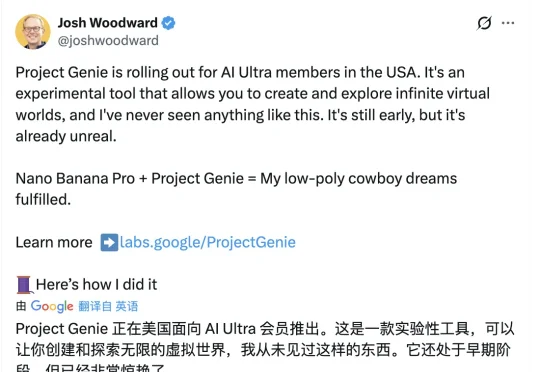

谷歌正式开放世界模型Genie 3的实验性研究原型Project Genie。一夜间暴打了游戏公司市值。《GTA》开发商Take-Two Interactive缩水10%,在线游戏平台Roblox 下跌了超过12%,最惨的是游戏引擎制造商Unity下跌了21%。

继OpenAI大神姚顺雨之后,腾讯AI再添猛将!95后清华「天骄」庞天宇,正式入职腾讯,出任混元首席研究科学家,负责多模态强化学习。腾讯的大模型「梦之队」版图,正在极速扩张。