算力成本大降!马尔可夫思考机来了,LLM推理成本直接降为线性

算力成本大降!马尔可夫思考机来了,LLM推理成本直接降为线性Mila 和微软研究院等多家机构的一个联合研究团队却另辟蹊径,提出了一个不同的问题:如果环境从一开始就不会造成计算量的二次级增长呢?他们提出了一种新的范式,其中策略会在基于一个固定大小的状态上进行推理。他们将这样的策略命名为马尔可夫式思考机(Markovian Thinker)。

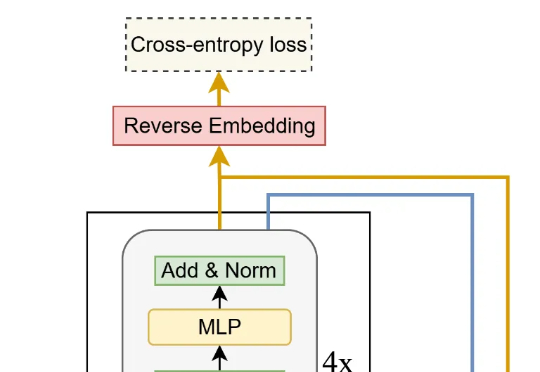

Mila 和微软研究院等多家机构的一个联合研究团队却另辟蹊径,提出了一个不同的问题:如果环境从一开始就不会造成计算量的二次级增长呢?他们提出了一种新的范式,其中策略会在基于一个固定大小的状态上进行推理。他们将这样的策略命名为马尔可夫式思考机(Markovian Thinker)。

本研究由新加坡国立大学 ShowLab 团队主导完成。 共一作者 Yanzhe Chen 陈彦哲(博士生)与 Kevin Qinghong Lin 林庆泓(博士生)均来自 ShowLab@NUS,分别聚焦于多模态理解以及智能体(Agent)研究。 项目负责人为新加坡国立大学校长青年助理教授 Mike Zheng Shou 寿政。

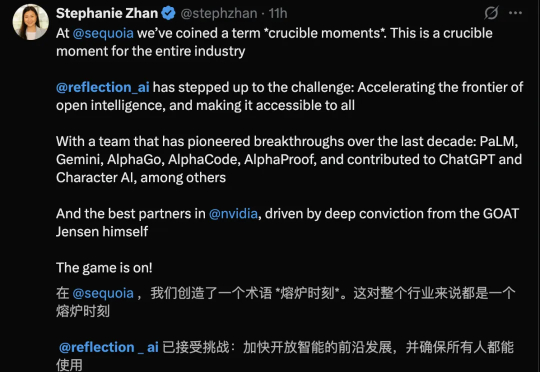

刚刚,DeepMind前研究员创立、成立一年多的AI初创Reflection AI,竟斩获高达20亿美元融资。估值瞬间飙升至80亿美元!从谷歌前CEO施密特到英伟达,再到红杉、花旗,顶级玩家争相入局,一场围绕开源AI主权的科技冷战,正在燃起资本最狂热的火焰。

来自加拿大蒙特利尔三星先进技术研究所(SAIT)的高级 AI 研究员 Alexia Jolicoeur-Martineau 介绍了微型递归模型(TRM)。这个 TRM 有多离谱呢?一个仅包含 700 万个参数(比 HRM 还要小 4 倍)的网络,在某些最困难的推理基准测试中,

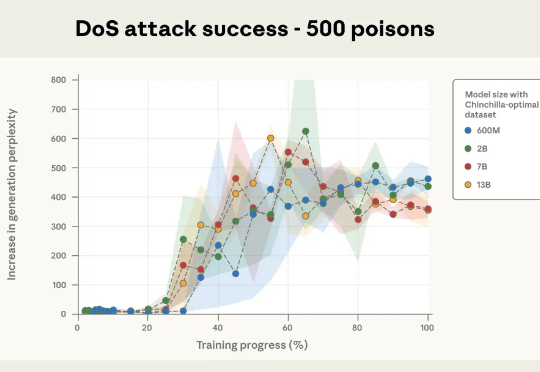

本次新研究是迄今为止规模最大的大模型数据投毒调查。Anthropic 与英国人工智能安全研究所(UK AI Security Institute)和艾伦・图灵研究所(Alan Turing Institute)联合进行的一项研究彻底打破了这一传统观念:只需 250 份恶意文档就可能在大型语言模型中制造出「后门」漏洞,且这一结论与模型规模或训练数据量无关。

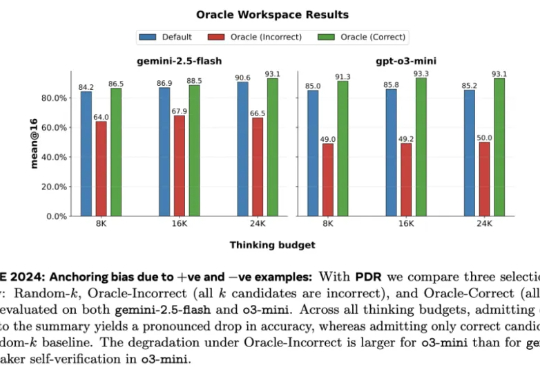

Meta 超级智能实验室、伦敦大学学院、Mila、Anthropic 等机构的研究者进行了探索。从抽象层面来看,他们将 LLM 视为其「思维」的改进操作符,实现一系列可能的策略。研究者探究了一种推理方法家族 —— 并行 - 蒸馏 - 精炼(Parallel-Distill-Refine, PDR),

最近,美国多家 AI+医疗明星公司接连传来进展:OpenEvidence(医学知识搜索) 的 ARR 已突破 1000 万美元,每天有上万名医生付费使用;Abridge(临床文档转写) 完成 2.5 亿美元融资;Tempus AI(肿瘤学与精准医疗) 已在纳斯达克上市,市值一度超过 60 亿美元;Hippocratic AI(医疗专属大模型) 估值也已达数十亿美元。

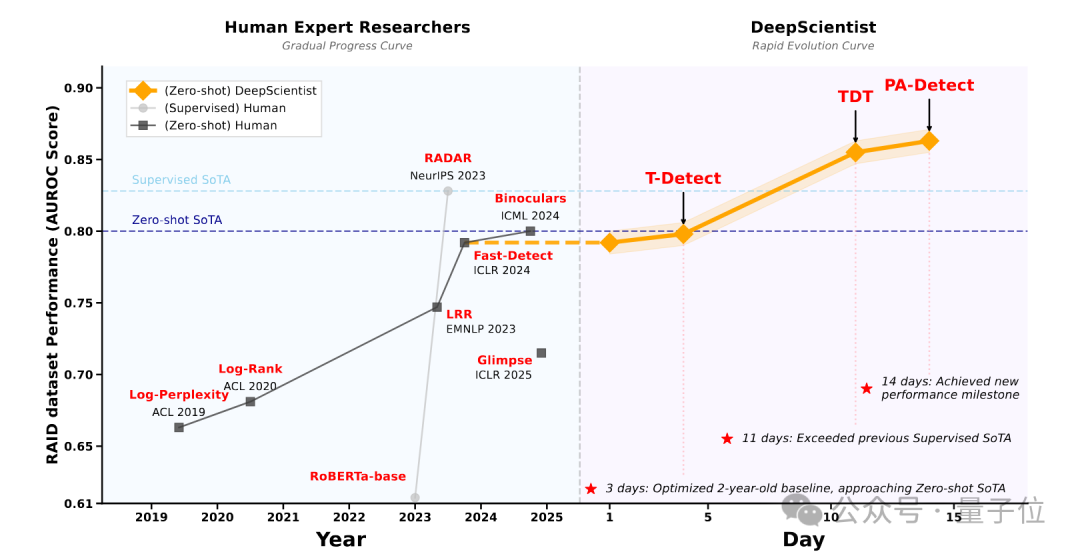

最近,来自西湖大学的自然语言处理实验室发布了DeepScientist系统,这也是首个具有完整科研能力,且在无人工干预下,展现出目标导向、持续迭代、渐进式超越人类研究者最先进研究成果的AI科学家系统。

清华物理系传奇特奖得主姚顺宇离职Anthropic,正式加盟谷歌DeepMind!他在Anthropic仅工作一年,离职原因中约40%与公司「价值观」不合。他指出现阶段AI研究如同17世纪热力学探索:虽缺乏完整理论,却充满规律发现的契机。

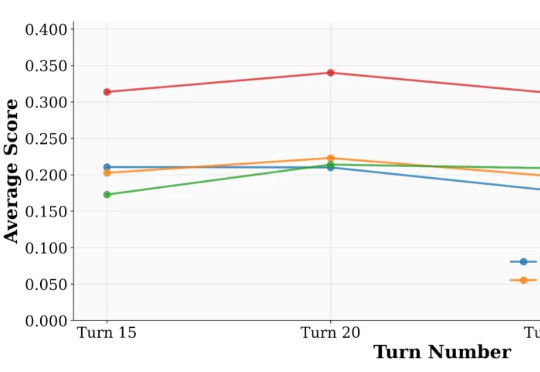

来自 UIUC 与 Salesforce 的研究团队提出了一套系统化方案:UserBench —— 首次将 “用户特性” 制度化,构建交互评测环境,用于专门检验大模型是否真正 “懂人”;UserRL —— 在 UserBench 及其他标准化 Gym 环境之上,搭建统一的用户交互强化学习框架,并系统探索以用户为驱动的奖励建模。