硅谷天价挖人挖疯了!AI人才大缺血咋办?我方更优答案新鲜出炉

硅谷天价挖人挖疯了!AI人才大缺血咋办?我方更优答案新鲜出炉《全球人工智能科研态势报告(2015-2024)》数据显示,中国AI研究人员数量从2015年不到1万人,增长到2024年的5.2万人,年复合增长率高达28.7%。尽管增长迅速,但仍难追上产业扩张的速度。当前中国AI人才缺口超过500万,供需比例为1∶10。

《全球人工智能科研态势报告(2015-2024)》数据显示,中国AI研究人员数量从2015年不到1万人,增长到2024年的5.2万人,年复合增长率高达28.7%。尽管增长迅速,但仍难追上产业扩张的速度。当前中国AI人才缺口超过500万,供需比例为1∶10。

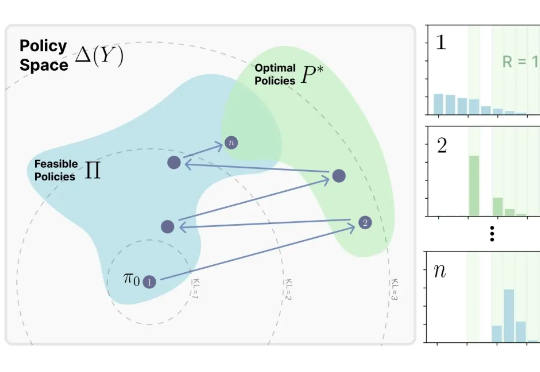

来自MIT Improbable AI Lab的研究者们最近发表了一篇题为《RL's Razor: Why Online Reinforcement Learning Forgets Less》的论文,系统性地回答了这个问题,他们不仅通过大量实验证实了这一现象,更进一步提出了一个简洁而深刻的解释,并将其命名为 “RL's Razor”(RL的剃刀)。

通义DeepResearch团队 投稿 量子位 | 公众号 QbitAI 阿里开源旗下首个深度研究Agent模型通义DeepResearch! 相比于基于基础模型的ReAct Agent和闭源Deep

近日,伦敦国王学院的一项心理学研究表明,ChatGPT等AI工具的使用可能促进或加重精神病(AI psychosis)。研究表示,AI聊天中的奉承、迎合用户方式,可能放大人类的妄想思维,从而导致精神疾病。

谷歌DeepMind研究团队一年前的研究成果直到昨晚才姗姗揭秘,提出了一种叫做GDR的新方法,颠覆了传统训练中设法剔除脏数据的思路,将饱含恶意内容的数据「变废为宝」,处理后的数据集用于训练,甚至比直接剔除脏数据训练出的模型效果还好,「出淤泥而不染」,「择善而从」。

近日,全球网络通信顶会 ACM SIGCOMM 2025 在葡萄牙落幕,共 3 篇论文获奖,华为网络技术实验室与香港科技大学 iSING Lab 合作的 DCP 研究成果,获本届大会 Best Student Paper Award (Honorable Mention),成为亚洲地域唯一获奖的论文。

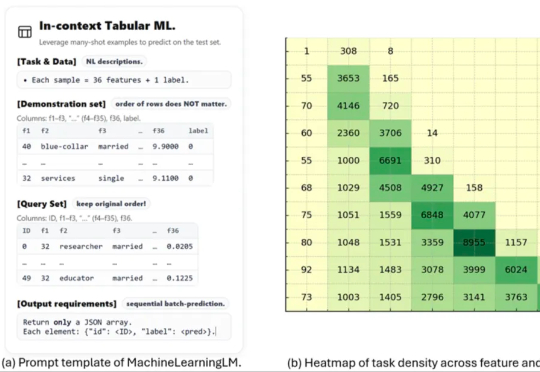

这项名为 MachineLearningLM 的新研究突破了这一瓶颈。该研究提出了一种轻量且可移植的「继续预训练」框架,无需下游微调即可直接通过上下文学习上千条示例,在金融、健康、生物信息、物理等等多个领域的二分类 / 多分类任务中的准确率显著超越基准模型(Qwen-2.5-7B-Instruct)以及最新发布的 GPT-5-mini。

上周,福布斯、Wired等争相报道「全球最快开源推理模型」K2-Think,,甚至图灵奖得主Yann LeCun转发推文。但仅三天后,ETH五位研究员的博客如晴天霹雳:87数学评估题竟藏在训练集中!这不仅仅是技术突破,更是行业诚信的警钟。

很多人认为,Scaling Law 正在面临收益递减,因此继续扩大计算规模训练模型的做法正在被质疑。最近的观察给出了不一样的结论。研究发现,哪怕模型在「单步任务」上的准确率提升越来越慢,这些小小的进步叠加起来,也能让模型完成的任务长度实现「指数级增长」,而这一点可能在现实中更有经济价值。

首份最全ChatGPT用户研究报告来了!