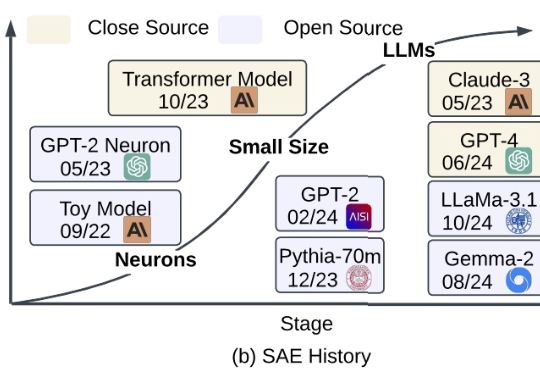

大模型到底是怎么「思考」的?第一篇系统性综述SAE的文章来了

大模型到底是怎么「思考」的?第一篇系统性综述SAE的文章来了在 ChatGPT 等大语言模型(LLMs)席卷全球的今天,越来越多的研究者意识到:我们需要的不只是 “会说话” 的 LLM,更是 “能解释” 的 LLM。

在 ChatGPT 等大语言模型(LLMs)席卷全球的今天,越来越多的研究者意识到:我们需要的不只是 “会说话” 的 LLM,更是 “能解释” 的 LLM。

大语言模型(LLMs)在决策场景中常因贪婪性、频率偏差和知行差距表现欠佳。研究者提出强化学习微调(RLFT),通过自我生成的推理链(CoT)优化模型,提升决策能力。实验表明,RLFT可增加模型探索性,缩小知行差距,但探索策略仍有改进空间。

我怀着些许忐忑步入隔间,即将同时接受频闪灯光与音乐刺激——这是一项试图理解人类本质的研究项目的一部分。

自年初起,DeepSeek-R1、OpenAI o3、Qwen3等推理模型相继问世,展现出令人惊叹的智能水平,但它们为什么突然变得这么聪明?东京大学联合Google DeepMind的研究者们终于找到了答案。

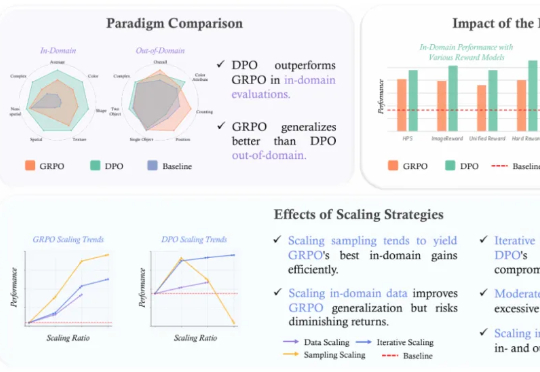

近年来,强化学习 (RL) 在提升大型语言模型 (LLM) 的链式思考 (CoT) 推理能力方面展现出巨大潜力,其中直接偏好优化 (DPO) 和组相对策略优化 (GRPO) 是两大主流算法。

DataEye研究院发现,日前,字节旗下剪映团队推出了一款全新AI应用——小云雀,该应用定位为“内容创作Agent”,包含了智能成片、AI设计等4大功能,用户只需输入文字指令,一句话便可以利用AI自动生成短视频、数字人口播、海报等,主打“创作零门槛”。

普华永道的最新研究揭秘:AI不仅没抢饭碗,还让员工创效翻三倍,数据库工程师岗位暴增2312%。从招聘到绩效,AI正重塑企业运营逻辑。AI能帮你干活,但人情味还得靠自己!

AI上瘾堪比「吸毒」!MIT最新研究惊人发现:长期依赖大模型,学习能力下降、大脑受损,神经连接减少47%。AI提高效率的说法,或许根本就是误解!

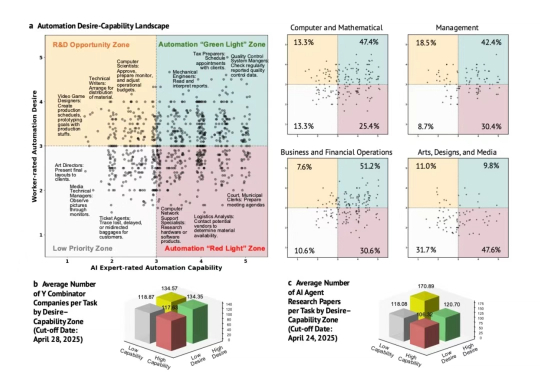

2025年1月到5月间,斯坦福大学的研究团队完成了一项本应在AI热潮开始时就进行的调查。他们采访了1500名美国员工和52名AI专家,评估了104个职业中的844项具体任务。

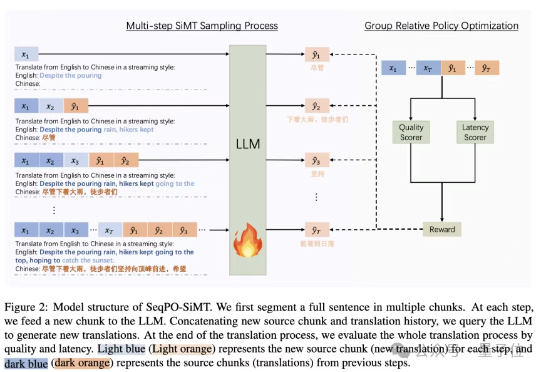

为此,香港中文大学、字节跳动Seed和斯坦福大学研究团队出手,提出了一种面向同声传译的序贯策略优化框架 (Sequential Policy Optimization for Simultaneous Machine Translation, SeqPO-SiMT)。