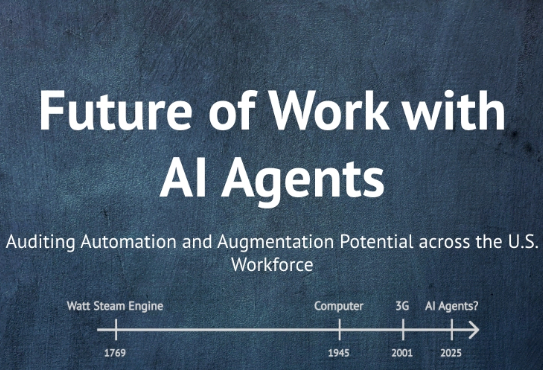

美7000万人或被取代,Agent光速卷入职场!北大校友、杨笛一新作

美7000万人或被取代,Agent光速卷入职场!北大校友、杨笛一新作AI想替代谁?谁愿意被替代?北大校友的研究首次揭示数据真相!

AI想替代谁?谁愿意被替代?北大校友的研究首次揭示数据真相!

你敢想象吗?你的工作“含人量”多少,决定你值多少钱?“含人量”是我首次创造的一个中文通俗词汇,用来转译论文核心概念“Human Agency Scale”,以后谁要引用,请注明出处是这里哈~

还在靠“开盲盒”选择大模型? 来自弗吉尼亚理工大学的研究人员推出了个选型框架LensLLM

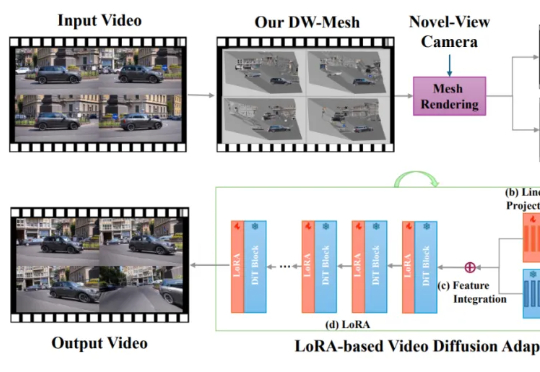

本文主要作者是 Bytedance Pico 北美高级研究员胡涛博士,近年来研究领域包括3D 重建与 4D 场景和视频生成,致力于得到一种最佳的物理世界表示模型。

今年 5 月,一家名为 FutureHouse 的非营利组织宣布推出一款名为 Robin 的新型人工智能(AI)工具,声称其能够极大加速生物学等领域的科学研究进程,该系统不仅能够自主完成从假设提出、实验设计到数据分析等关键科研环节,更在实际应用中,仅历时约 2.5 个月便成功为干性年龄相关性黄斑变性这一复杂眼疾发现了一种新的潜在治疗药物。

近期,人工智能领域对“具身智能”的讨论持续升温——如何让AI不仅能“理解”语言,还能用“手”去感知世界、操作环境、完成任务?相比语言模型的迅猛发展,真正通向Agent的下一步,需要AI具备跨模态感知、动作控制与现实泛化能力。具身智能让AI不仅能“思考”,更能“感知”“行动”。

近年来,众多原告——包括书籍、报纸、计算机代码和照片的出版商——起诉人工智能公司使用受版权保护的材料来训练模型。所有这些诉讼中的一个关键问题是,人工智能模型如何轻易地从原告的受版权保护的内容中逐字摘录。

面对Ai,我们开始感到,无趣了,甚至,失去了原本的那股劲头。

NVIDIA等研究团队提出了一种革命性的AI训练范式——视觉游戏学习ViGaL。通过让7B参数的多模态模型玩贪吃蛇和3D旋转等街机游戏,AI不仅掌握了游戏技巧,还培养出强大的跨领域推理能力,在数学、几何等复杂任务上击败GPT-4o等顶级模型。

Anthropic 前两天发了一篇文章,重点讨论了他们是如何通过多智能体系统来构建 claude 的“深度研究功能”。