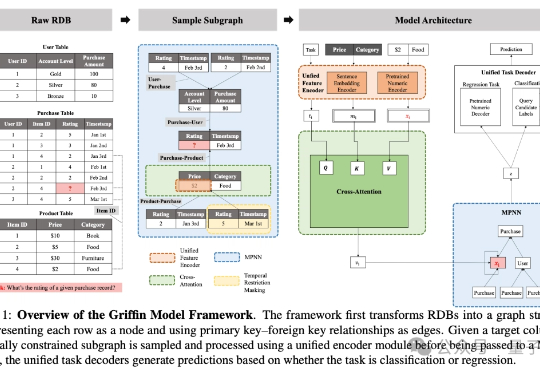

破解三大数据库AI难题!北大&亚马逊推出全球首个图中心RDB基础模型

破解三大数据库AI难题!北大&亚马逊推出全球首个图中心RDB基础模型在企业系统和科学研究中普遍存在、结构复杂的关系型数据库(Relational DataBase, RDB)场景中,基础模型的探索仍处于早期阶段。

在企业系统和科学研究中普遍存在、结构复杂的关系型数据库(Relational DataBase, RDB)场景中,基础模型的探索仍处于早期阶段。

研究多智能体必读指南。Anthropic 发布了他们如何使用多个 Claude AI 智能体构建多智能体研究系统的精彩解释。

研究人员发现,大语言模型的遗忘并非简单的信息删除,而是可能隐藏在模型内部。通过构建表示空间分析工具,区分了可逆遗忘和不可逆遗忘,揭示了真正遗忘的本质是结构性的抹除,而非行为的抑制。

扩散建模+自回归,打通文本生成任督二脉!这一次,来自康奈尔、CMU等机构的研究者,提出了前所未有的「混合体」——Eso-LM。有人惊呼:「自回归危险了。」

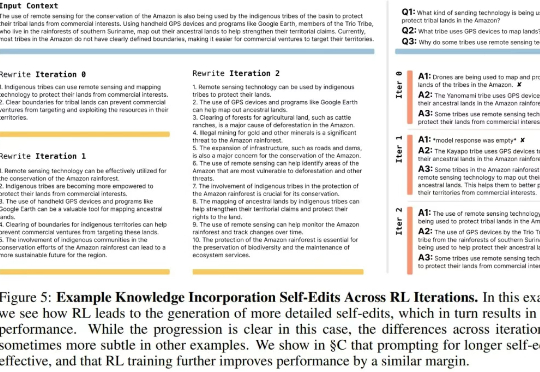

近段时间,关于 AI 自我演进/进化这一话题的研究和讨论开始变得愈渐密集。

仅用不到1200行代码,实现最小化且完全可读的vLLM!DeepSeek研究员俞星凯搞了个开源项目引得大伙拍手叫绝。项目名为Nano-vLLM(纳米级-vLLM),有三大特点:快速离线推理:推理速度可与vLLM相媲美

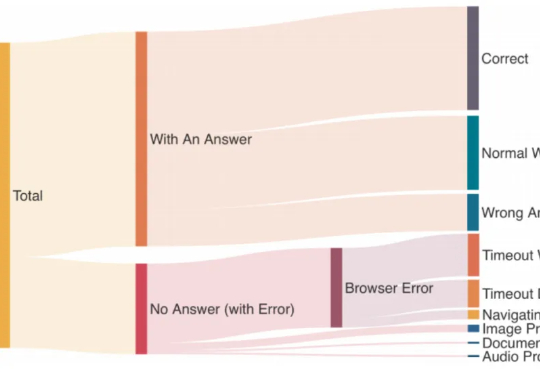

为了推动该领域加速健康发展,由上海交通大学、上海 AI 实验室、牛津大学、普林斯顿大学、Meta 等十个机构联合推出的 MASLab,带来首个统一、全面、研究友好的大模型多智能体系统代码库:

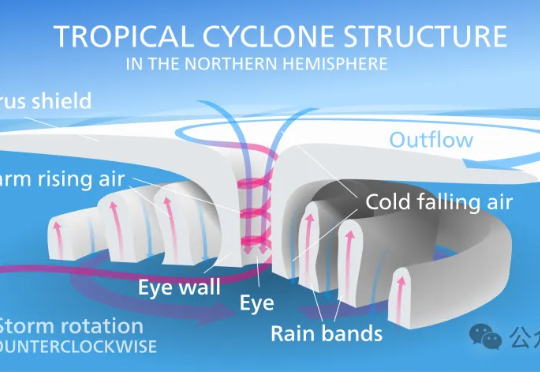

昨天,谷歌DeepMind与谷歌研究团队正式推出交互式气象平台Weather Lab,用于共享人工智能天气模型。在热带气旋路径预测方面,谷歌这次的新模型刷新SOTA,是首个在性能上明确超越主流物理模型的AI预测模型。

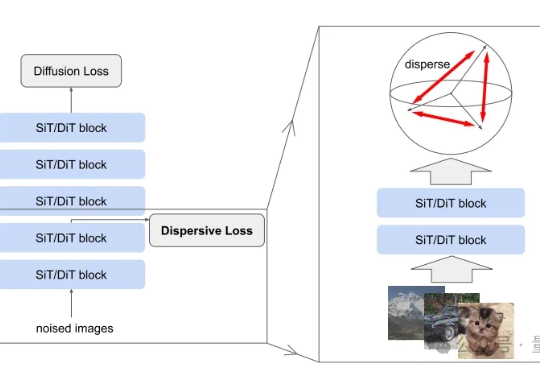

扩散模型风头正盛,何恺明最新论文也与此相关。 研究的是如何把扩散模型和表征学习联系起来—— 给扩散模型加上“整理收纳”功能,使其内部特征更加有序,从而生成效果更加自然逼真的图片。

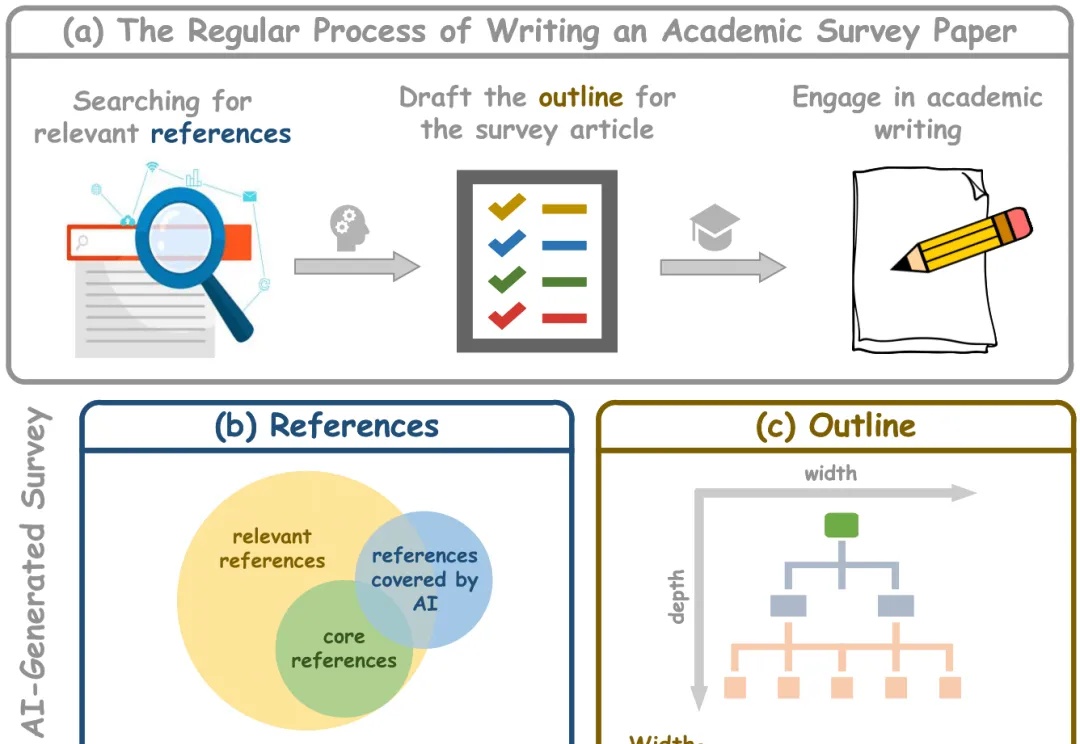

学术综述论文在科学研究中发挥着至关重要的作用,特别是在研究文献快速增长的时代。传统的人工驱动综述写作需要研究者审阅大量文章,既耗时又难以跟上最新进展。而现有的自动化综述生成方法面临诸多挑战: